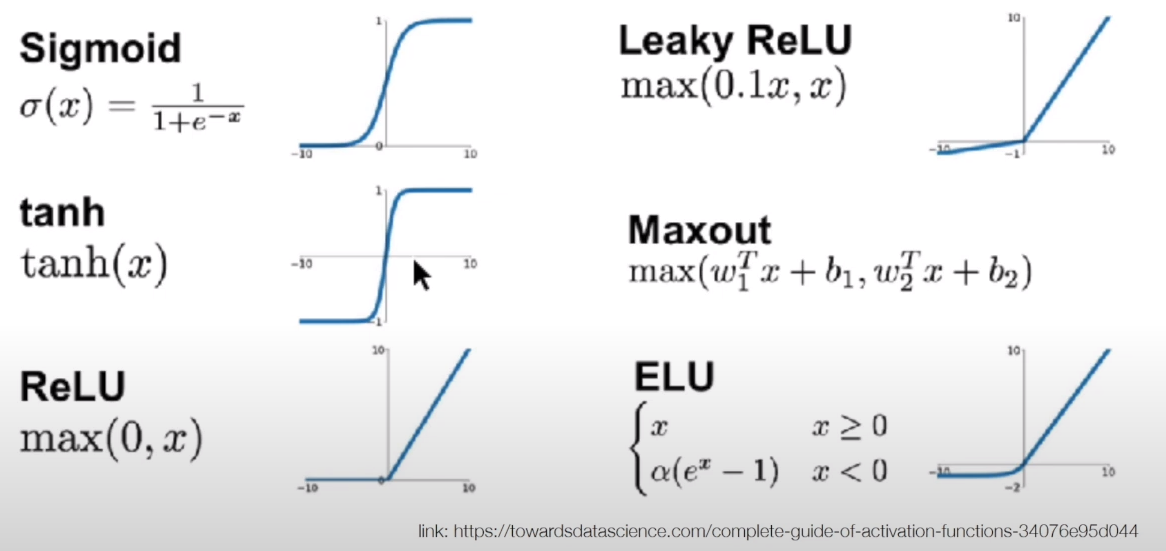

- Activation Function

- Sigmoid vs ReLu

- 인간의 신경망을 생각해보면, 뉴런과 뉴런 사이에 정보가 전달이 될 때 정보의 재해석이 되면서 전달됨

- 우리가 만든 기본적인 인공신경망은 가중치를 곱해서 더하는 선형 결합 형태임

- 실제 인간의 신경망과는 차이가 있기에, non - linear로 바꿔주기 위해 활성화 함수를 사용함

- Activation function : 이전 layer의 노드값이 다음 layer로 넘어갈 때 활용되는 함수

- 활성화 함수를 많이 알수록 tuning 시 유리

- Loss function은 주로 convex(볼록함)한데, linear일 때는 볼록함이 유지 but, 활성화함수로 인해 선형성이 깨지기에 수렴성과 수렴 속도에는 영향을 준다.

Sigmoid

- 함수값이 0과 1사이에 있음

- 미분 가능

- 주로 classification의 output에 사용됨

- back propagation 시 gradient가 사라지는 문제

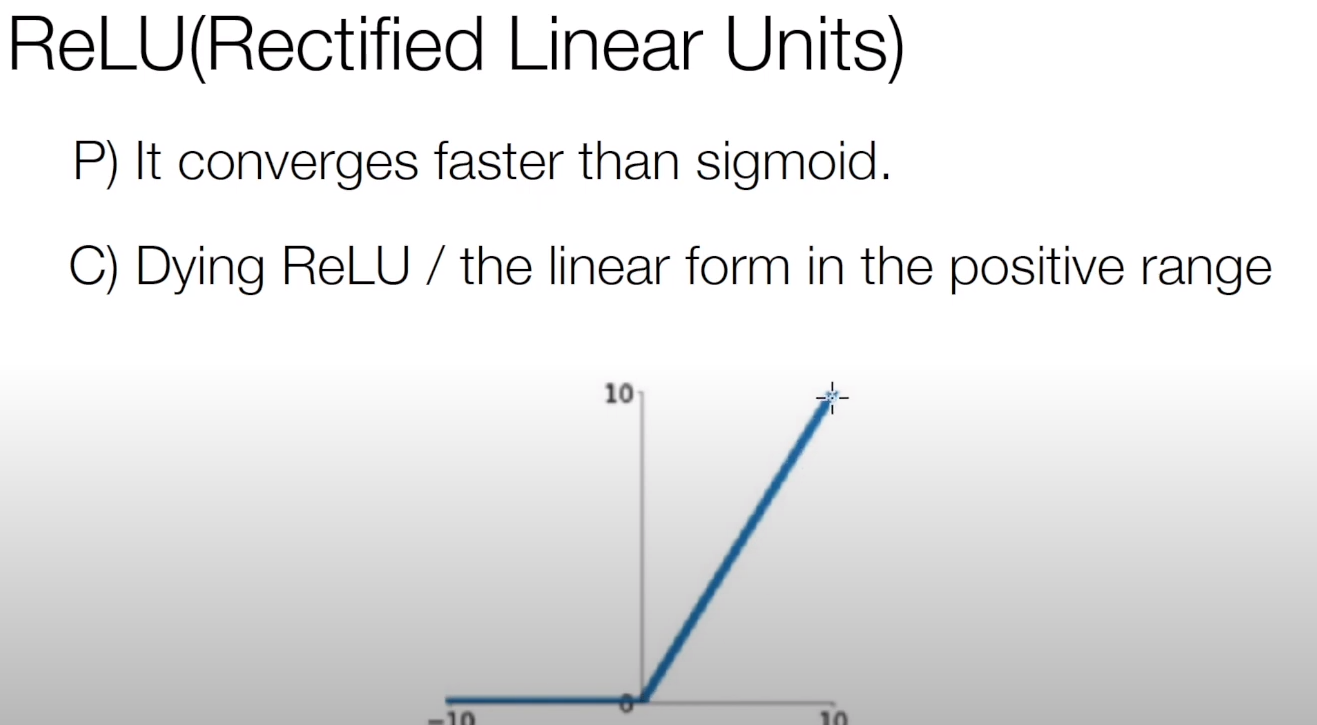

Relu

- 이미지는 0 ~255로 이루어진 data이기에 이미지 처리에 유리

- loss function의 comvex함이 유지 (어느정도 선형성을 지니고 있음)