Bias 와 Variance간의 Tradeoff

-

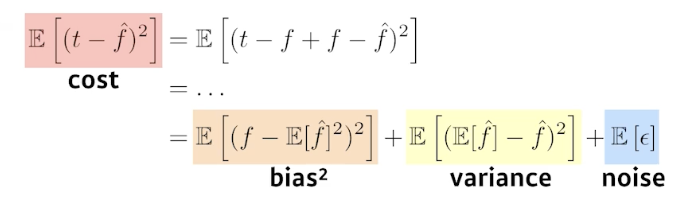

cost를 minimize한다는 것은 bias와 variance와 noise를 minimize한다는 것과 같다. 따라서 bias를 줄이게되면 variance가 높아지게 되고 variance를 줄이게되면 bias가 높아지게 된다. 따라서 근본적으로 학습데이터에 noise가 껴있을 경우 bias와 variance를 둘 다 줄일 수 없다는 것을 알 수 있다.

-

기계 학습 모델을 훈련할 때, 모델의 복잡도와 데이터의 양에 따라 Bias와 Variance 사이에 Tradeoff 관계가 존재한다.

-

Bias는 모델이 가정한 가설과 실제 데이터 사이의 차이를 나타내는 개념이다. 즉, 모델이 지나치게 단순하거나 한 가지 가설만을 고수하면 발생하는 오차를 의미한다. 이는 모델이 과소적합(underfitting)되는 상황이며, 모델이 데이터에서 잘못된 패턴을 학습하게 된다.

-

반면, Variance는 모델의 복잡도가 증가할수록 모델이 학습 데이터에서 발생한 노이즈까지 학습하게 되는 문제를 나타낸다. 이는 모델이 과대적합(overfitting)되는 상황이며, 모델이 학습 데이터에 대해서는 높은 정확도를 보이지만 새로운 데이터에 대해서는 성능이 떨어지게 된다.

-

따라서, 모델의 복잡도를 적절하게 조절하여 Bias와 Variance 사이에 적절한 Tradeoff 관계를 유지해야 한다. 이를 위해 일반적으로 Cross-validation 기법을 사용하여 모델의 일반화 성능을 평가하고, 모델의 복잡도를 조절하는 하이퍼파라미터를 최적화한다. 이를 통해 적절한 모델을 선택하고, 과소적합과 과대적합 문제를 최소화하여 더 좋은 예측 성능을 달성할 수 있다.

결론 : 적당한 수준의 bias와 variance를 만들기 위하여 적정한 수준에서 모델의 학습을 종료 시켜야 한다.