Object Detection의 성능 평가

정확도 평가 - mAP

성능 평가 - FPS, Flops

정확도 평가

mAP(mean Average Precision)란?

- 각 클래스 당 AP의 평균으로, object detection결과에 대한 model의 성능을 판별하는데, mAP를 사용한다.

mAP를 알기 위해 선행되어야 할 개념

- Confusion matrix

- Precision & Recall

- PR curve

- AP (Average Precision)

- IOU (Intersection Over Union)

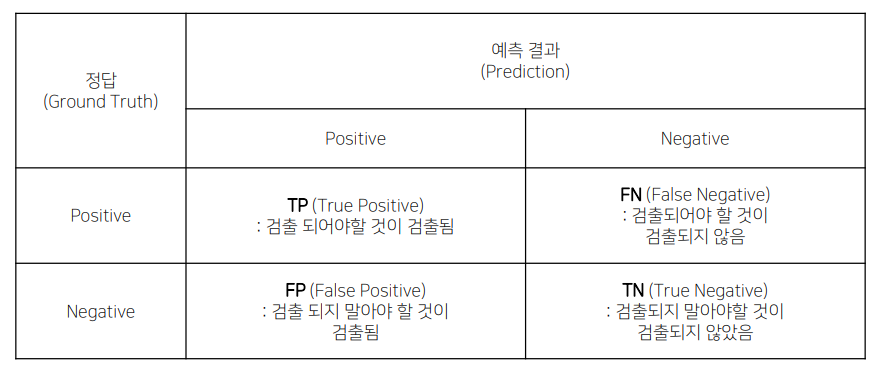

Confusion matrix

- TP : 있는걸 있다고 예측 (Positive라고 예측했는데 예측이 맞음)

- FP : 없는걸 있다고 예측 (Positive라고 예측했는데 예측이 틀림)

- FN : 있는걸 예측하지 못함 (Negative라고 예측했는데 예측이 틀림)

- TN : 없는걸 예측하지 않음 (Negative라고 예측했는데 예측이 맞음)

Precision & Recall

-

Precision(정밀도) : 모델이 양성 클래스라고 예측한 샘플 중에서 실제 양성 클래스인 샘플의 비율

-> 매우 확실할 때만 사물이 존재한다고 판단하면 precision(정밀도)이 올라가고 Recall(재현율)은 떨어짐

-

Recall(재현율) : 실제 양성 클래스인 샘플 중에서 모델이 양성 클래스라고 예측한샘플의 비율

-> 모든 영역에 대해 전부 사물이 존재한다고 판단해버리면 Recall(재현율)은 올라가지만 Precision(정밀도)은 떨어짐

-

ex) 15개의 번호판 중에서 10개의 번호판이 검출 되었고, 10개중 7개가 제대로 검출되고 3개는 잘못 검출 되었을 경우

-- precision(정밀도) =

- recall(재현율) =

Confidence Score

- 특정 바운딩 박스안에 있는 객체가 어떤 물체의 클래스일 확률과 IoU값을 곱한 값

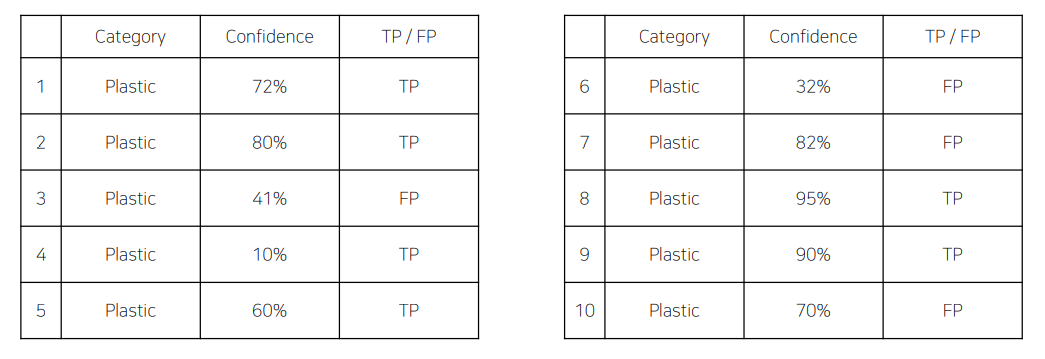

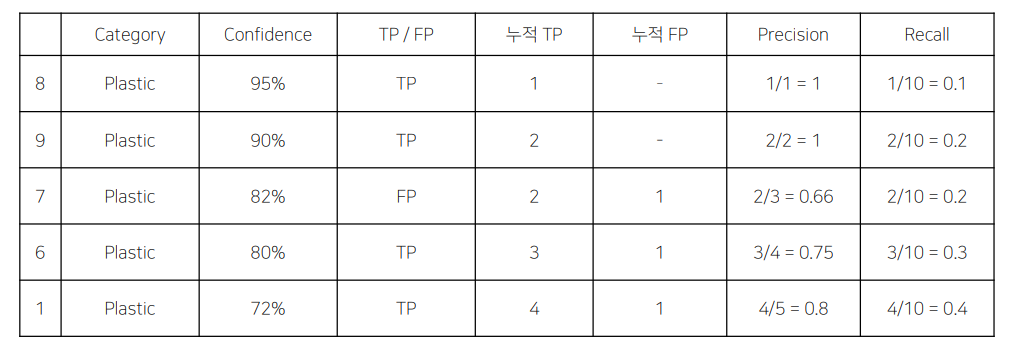

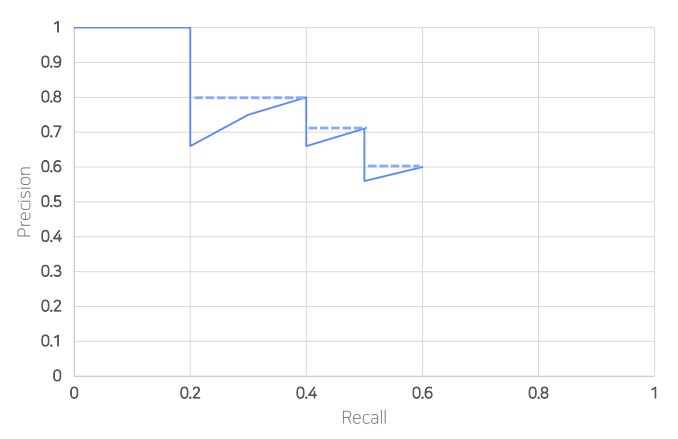

PR Curve

- 총 10개의 예측을 했을 때 맞게한 예측인지 틀린 예측인지 TP/FP에 대한 정보와 몇 퍼센트의 확신을 가지고 예측을 했는지(confidence)에 대한 정보

- confidence score를 기준으로 내림차순으로 정리하면 누적 TP와 누적 FP를 계산 할 수 있다. 이때, Precision과 Recall을 누적 TP와 누적 FP로 계산한다.

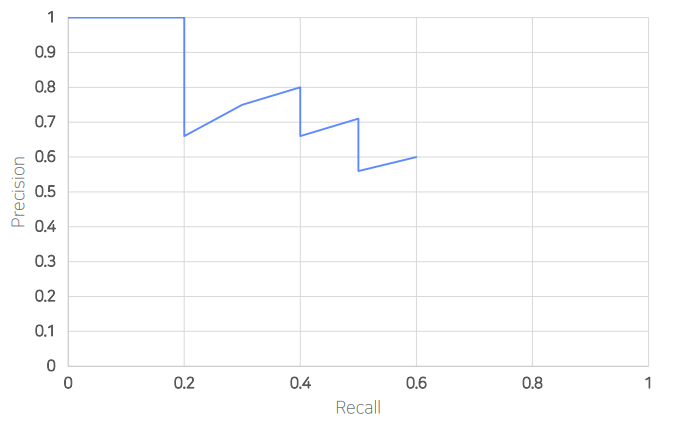

- 계산한 Precision과 Recall을 그래프로 나타내면 위와 같다.

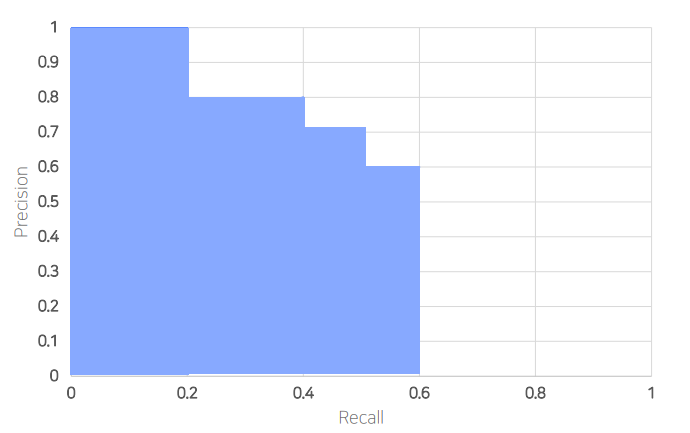

AP(Average Precision)

- 위와 같이 선을 그어 채우고, 아래 면적을 계산하면 AP이다.

- precision과 recall은 반비례 관계를 가지므로 Average Precision으로 성능을 평가한다. PR 그래프에서 그래프 선의 아래쪽 면적을 계산한 것이고, AP가 높으면 알고리즘이 우수하다는 뜻이다.

mAP(mean Average Precision)

- 종이박스, 플리스틱 등 여러가지 class에 대해서 나온 각각의 AP값을 평균 낸 것.

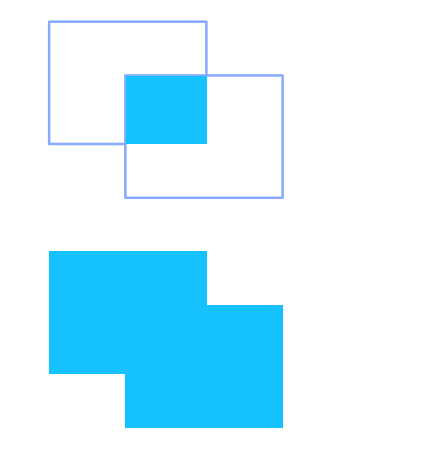

IOU(Interest Over Union)

- 두 영역의 overlap을 측정하는 기준을 제공

- 이 수치가 높을 수록 두 영역이 잘 정합 되었다고 함.

속도 평가

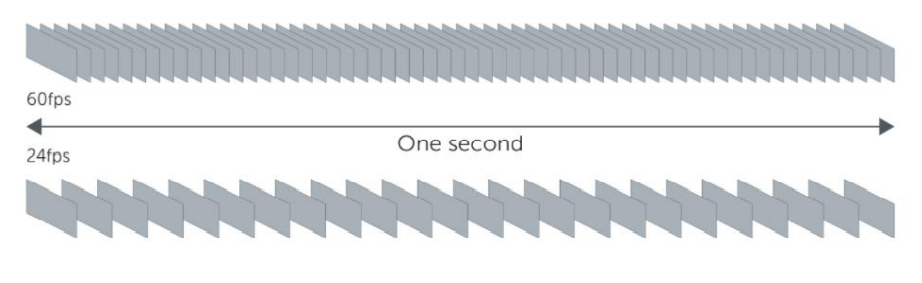

FPS(Frames Per Second)

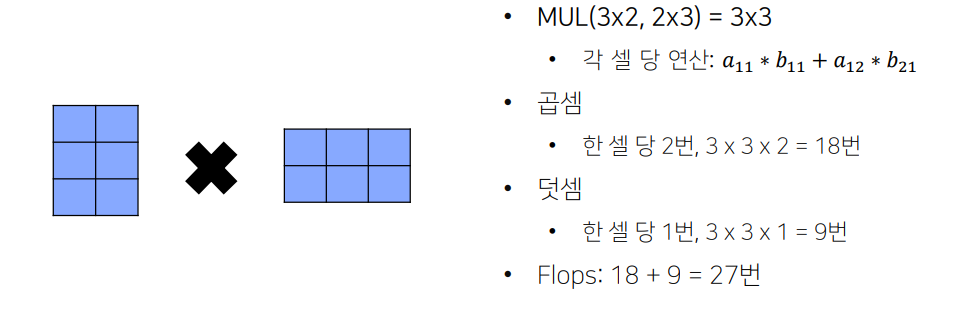

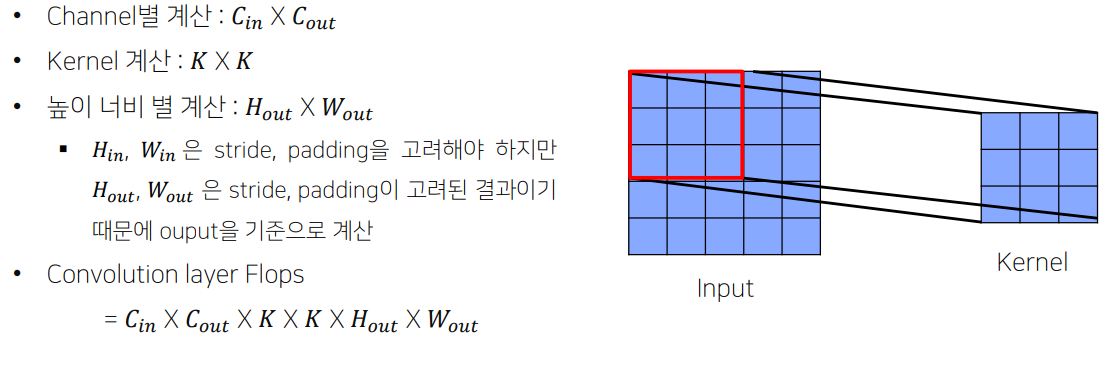

Flops(Floating Point Operations)

- 모델이 얼마나 빠르게 동작하는지 측정하는 metric

- 연산량 횟수(곱하기, 더하기, 빼기 등)