depth는 깊어지는데 parameter는 줄어들고, 성능은 점점 올라가는 convolutional neural network들의 발전에 대해서 알아보자.

ILSVRC

- ImageNet Large-Scale Visual Recognition Challenge 대회

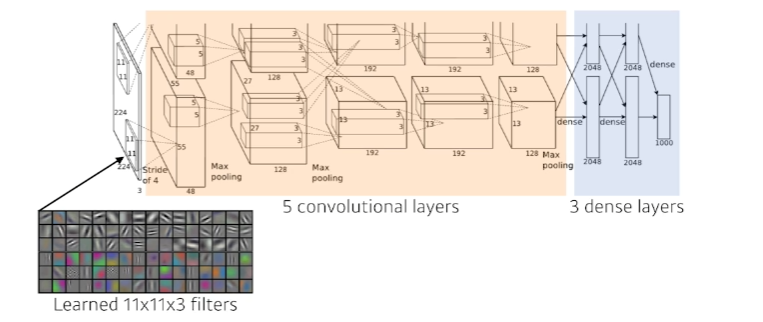

AlexNet

Key ideas

- ReLU 사용

- GPU implementation(2 GPUs)

- Local response normalization, Overlapping pooling

- Data augmentation

- Dropout

ReLU Activation

- vanishing gradient(기울기 소실) 문제를 해결했다.

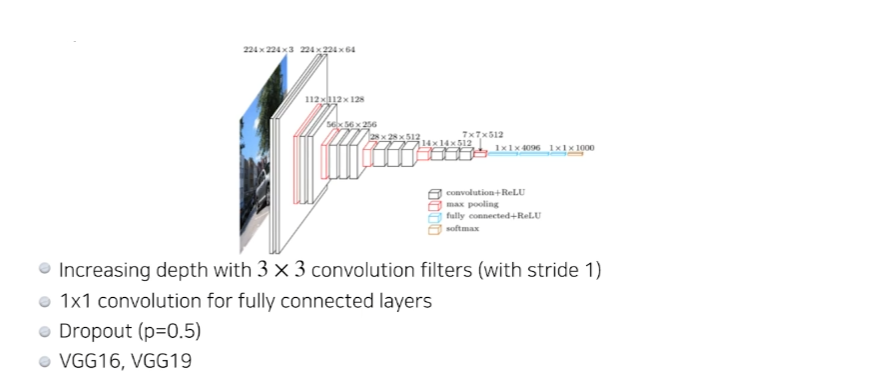

VGGNet

why convolution?

- 하나를 활용 하는 것 보다 을 두 개 활용하는 것이 parameter 수를 훨씬 더 줄일 수 있다.

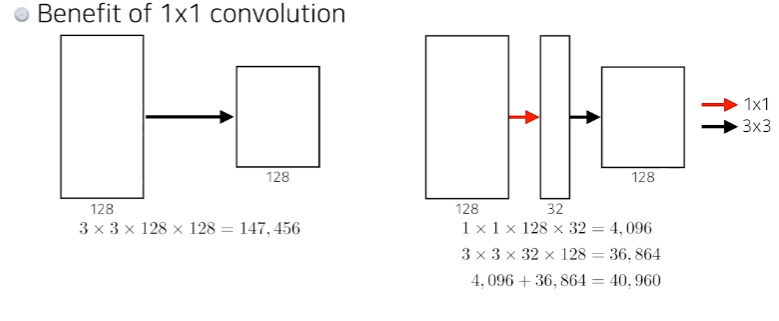

GoogLeNet

-

convolution을 중간에 잘 활용해서 중간에 parameter를 줄이는 것이 핵심

-

incepton block : 하나의 입력이 들어왔을 때 여러개로 퍼졌다가 하나로 다시 합쳐지는것. 하기전에 이 들어가고, 을 하기전에 이 들어간다.

convolution이 parameter를 줄이는 이유

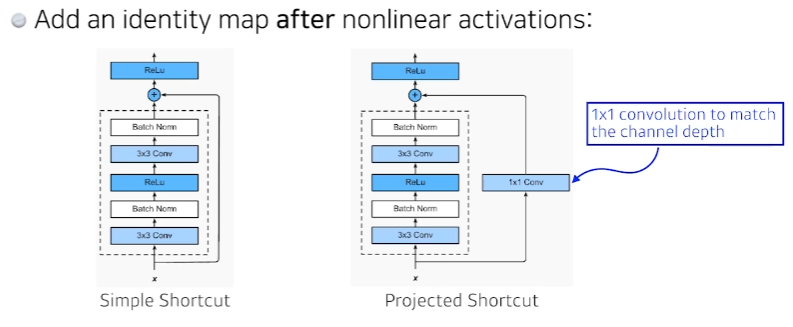

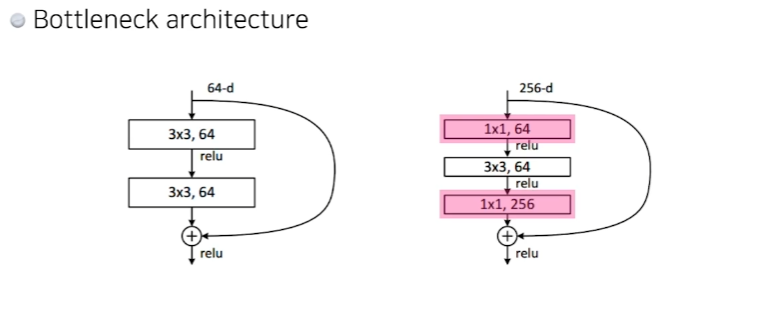

ResNet

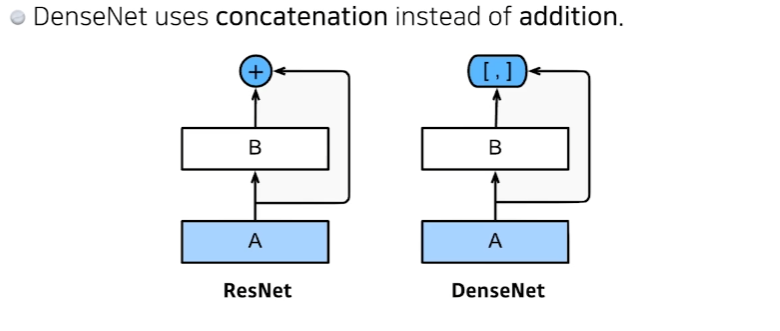

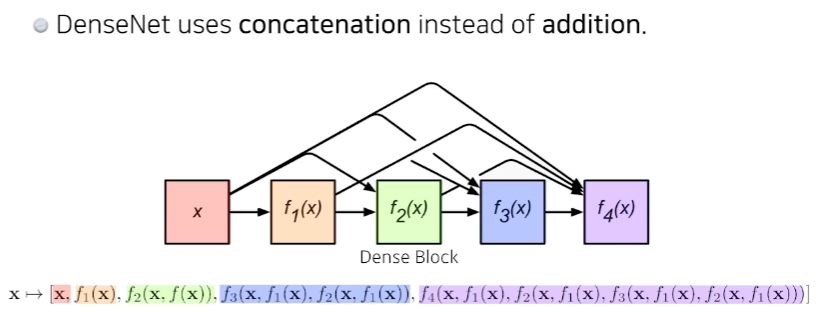

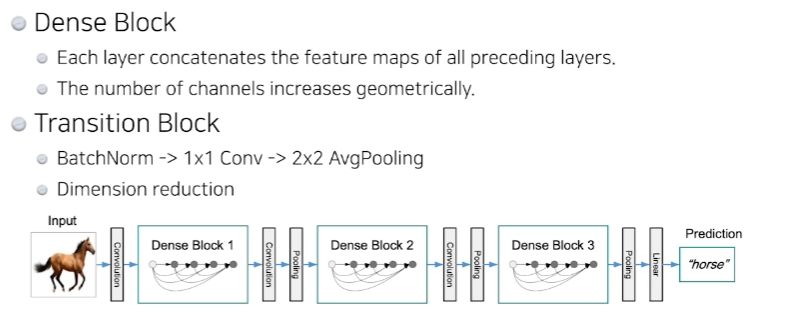

DenseNet

- 중간에 한번씩 convolution을 넣어줌으로써 채널이 너무 커지는것을 막는다.