OverFeat: Integrated Recognition, Localization and Detection using Convolutional Networks

Language translation

OverFeat: Integrated Recognition, Localization and Detection using Convolutional Networks

Abstract

우리는 분류, 지역화 및 탐지를 위해 컨볼루션 네트워크를 사용하기 위한 통합 프레임워크를 제시한다. 우리는 멀티스케일 및 슬라이딩 윈도우 접근 방식이 ConvNet 내에서 어떻게 효율적으로 구현될 수 있는지를 보여준다.

또한 객체 경계를 예측하는 방법을 학습하여 지역화에 대한 새로운 딥 러닝 접근법을 소개한다. 그런 다음 탐지 신뢰도를 높이기 위해 경계 상자를 억제하지 않고 누적한다.

우리는 단일 공유 네트워크를 사용하여 서로 다른 작업을 동시에 학습할 수 있음을 보여준다.

이 통합 프레임워크는 ImageNet Large Scale Visual Recognition Challenge 2013(ILSVRC 2013)의 현지화 작업의 우승자로 탐지 및 분류 작업에 대한 매우 경쟁력 있는 결과를 얻었다. 경쟁 후 작업에서는 탐지 작업을 위한 새로운 최첨단 기술을 확립한다.

마지막으로, 우리는 OverFeat라고 불리는 최고의 모델에서 특징 추출기를 출시한다.

1. Introduction

이미지에서 지배 객체의 범주를 인식하는 것은 객체가 손으로 쓴 문자[16], 집 번호[24], 질감 없는 완구[18], 트래픽 기호[3, 26], Caltech-101 데이터 세트[14]의 객체인지 여부에 관계없이 여러 해 동안 컨볼루션 네트워크(ConvNets)[17]가 적용된 작업이다.

ImageNet 데이터 세트[15].

Caltech-101과 같은 소규모 데이터 세트에 대한 ConvNet의 정확성은 괜찮지만 기록을 깨지는 못했다. 그러나 ConvNet은 더 큰 데이터 세트의 출현으로 1000 카테고리 ImageNet과 같은 데이터 세트의 최첨단 기술을 크게 발전시킬 수 있게 되었다[5].

이러한 많은 작업에 대한 ConvNet의 주요 이점은 전체 시스템이 원시 픽셀에서 최종 범주에 이르기까지 종단 간 훈련되어 적절한 피처 추출기를 수동으로 설계해야 하는 요구 사항을 완화한다는 것이다.

가장 큰 단점은 라벨링된 훈련 샘플에 대한 그들의 탐욕이다.

본 논문의 요점은 이미지에서 물체를 동시에 분류, 위치 및 감지하기 위해 컨볼루션 네트워크를 훈련시키면 모든 작업의 분류 정확도와 탐지 및 지역화 정확도를 향상시킬 수 있음을 보여주는 것이다.

이 논문은 단일 ConvNet으로 객체 감지, 인식 및 지역화에 대한 새로운 통합 접근법을 제안한다.

우리는 또한 예측된 경계 상자를 축적하여 지역화와 탐지를 위한 새로운 방법을 소개한다.

우리는 많은 현지화 예측을 결합함으로써 배경 샘플에 대한 훈련 없이 탐지를 수행할 수 있으며 시간이 많이 걸리고 복잡한 부트스트래핑 훈련 패스를 피할 수 있음을 제안한다.

배경에 대한 교육을 받지 않으면 네트워크는 높은 정확도를 위해 긍정적인 클래스에만 집중할 수 있습니다.

실험은 ImageNet ILSVRC 2012 및 2013 데이터 세트에 대해 수행되며 ILSVRC 2013 현지화 및 탐지 작업에 대한 최신 결과를 확립한다.

ImageNet 분류 데이터 세트의 이미지는 이미지의 많은 부분을 채우는 대략적으로 중심적인 개체를 포함하도록 주로 선택되지만, 관심 있는 개체는 때때로 이미지 내에서 크기와 위치가 크게 다르다.

이 문제를 해결하기 위한 첫 번째 아이디어는 ConvNet을 이미지의 여러 위치에 슬라이딩 윈도우 방식으로, 그리고 여러 배율 위에 적용하는 것입니다. 그러나 이러한 경우에도 많은 보기 창은 개체(개의 머리)에서 완벽하게 식별 가능한 부분을 포함할 수 있지만 전체 개체나 개체의 중심은 포함할 수 없다. 이는 분류는 괜찮지만 현지화 및 탐지는 불량으로 이어진다.

따라서, 두 번째 아이디어는 시스템을 훈련시켜 각 창에 대한 범주에 대한 분포를 생성할 뿐만 아니라 창에 상대적인 객체를 포함하는 경계 상자의 위치와 크기에 대한 예측을 생성하는 것이다. 세 번째 아이디어는 각 범주별로 각 위치와 크기에 대한 증거를 축적하는 것입니다.

많은 저자들은 다중 문자 문자열[20], 얼굴[30] 및 손[22]에 대해 1990년대 초로 거슬러 올라가 여러 척도에 대한 슬라이딩 윈도우를 가진 탐지 및 로컬라이제이션에 ConvNet을 사용할 것을 제안했다.

보다 최근에 ConvNets는 자연 이미지[4], 얼굴 감지[8, 23] 및 보행자 감지[25]에서 텍스트 탐지에 대한 최첨단 성능을 제공하는 것으로 나타났다.

몇몇 저자들은 또한 ConvNets가 뷰잉 윈도우에 상대적인 위치나 객체의 포즈와 같이 위치할 객체의 인스턴스화 매개 변수를 직접 예측하도록 훈련시킬 것을 제안했다.

예를 들어 Osadchy 등이 있습니다. [23] 동시 얼굴 감지 및 자세 추정을 위한 ConvNet에 대해 설명한다.

표면은 9차원 출력 공간에서 3D 매니폴드로 표시됩니다.

매니폴드 위 위치는 포즈(피치, 요 및 롤)를 나타냅니다.

훈련 이미지가 얼굴일 때 네트워크는 알려진 포즈의 위치에서 매니폴드에 점을 생성하도록 훈련됩니다.

이미지가 면이 아닌 경우 출력이 매니폴드로부터 밀려납니다. 테스트 시 매니폴드까지의 거리는 이미지에 면이 포함되어 있는지 여부를 나타내고 매니폴드에서 가장 가까운 지점의 위치는 포즈를 나타냅니다.

테일러 외 [27, 28] ConvNet을 사용하여 인체 자세를 유도하기 위해 신체 부위(손, 머리 등)의 위치를 추정한다.

이들은 메트릭 학습 기준을 사용하여 네트워크를 훈련시켜 신체 포즈 매니폴드에서 포인트를 생성한다. 힌튼 외. 또한 인식 프로세스의 일부로 특징의 명시적 인스턴스화 매개 변수를 계산하도록 네트워크를 훈련시킬 것을 제안했다 [12].

다른 저자들은 ConvNet 기반 분할을 통해 객체 위치 지정을 수행할 것을 제안했다.

가장 간단한 접근 방식은 ConvNet이 보기 창의 중앙 픽셀(또는 볼륨 이미지의 경우 복셀)을 영역 간 경계로 분류하도록 훈련하는 것으로 구성된다 [13].

그러나 영역을 분류해야 하는 경우 의미 분할을 수행하는 것이 바람직하다.

주요 아이디어는 ConvNet을 훈련시켜 창을 의사 결정 컨텍스트로 사용하여 뷰잉 창의 중앙 픽셀을 해당 개체의 범주로 분류하는 것이다.

적용 범위는 생물학적 이미지 분석[21]에서 모바일 로봇의 장애물 태그 지정[10] 및 사진 태그 지정[7]까지이다.

이 접근법의 장점은 경계 등고선이 직사각형일 필요가 없고 영역이 잘 둘러싸인 객체가 될 필요가 없다는 것이다.

단점은 훈련을 위해 밀도가 높은 픽셀 레벨 라벨이 필요하다는 것이다.

이러한 분할 전처리 또는 객체 제안 단계는 최근 전통적인 컴퓨터 비전에서는 위치, 규모 및 가로 세로 비율의 검색 공간을 줄이기 위한 인기를 얻고 있습니다 [19, 2, 6, 29].

따라서 비싼 분류 방법을 검색 공간의 최적 위치에 적용할 수 있으므로 인식 정확도가 높아진다.

또한 [29, 1]은 이러한 방법이 가능성이 없는 개체 영역을 대폭 줄임으로써 정확성을 향상시켜 잠재적인 잘못된 긍정을 감소시킨다는 것을 제안한다.

그러나 우리의 조밀한 슬라이딩 윈도우 방법은 ILSVRC13 탐지 데이터 세트에서 객체 제안 방법을 능가할 수 있다.

크리셰프스키 외 [15] 최근 대규모 ConvNet을 사용하여 인상적인 분류 성능을 보여주었다.

작가들은 또한 ImageNet 2012 대회에 참가하여 분류와 로를 모두 수상했습니다.

본 논문에서 우리는 ImageNet 2013 경기에서 사용하는 것과 일치하는 방식으로 로컬라이제이션 및 탐지라는 용어를 사용한다.

즉, 유일한 차이점은 사용된 평가 기준이며 둘 다 이미지의 각 개체에 대한 경계 상자를 예측하는 것이다.

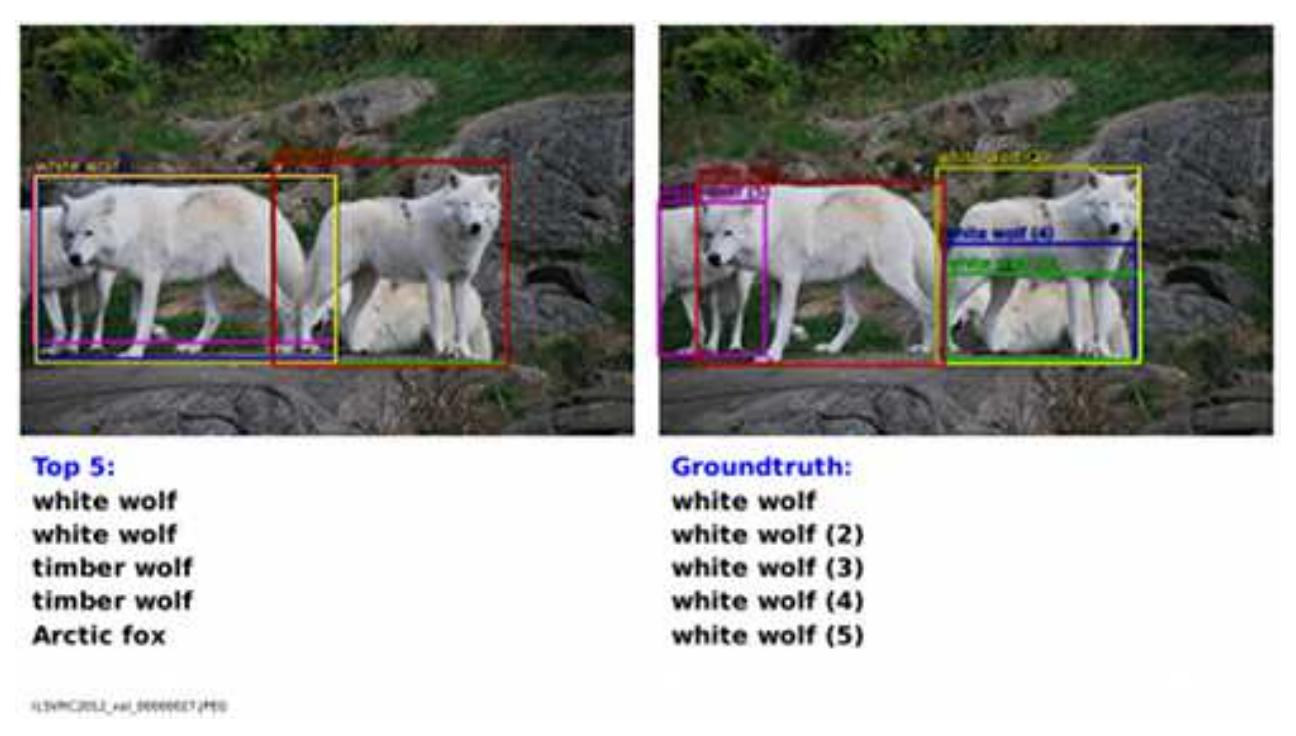

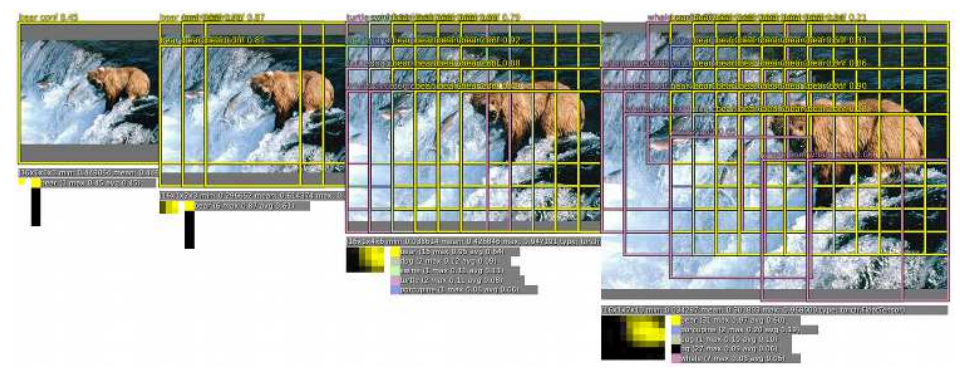

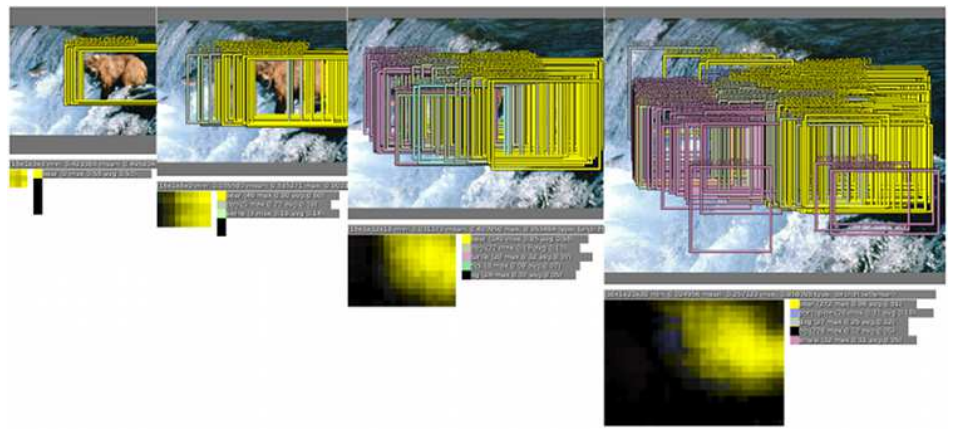

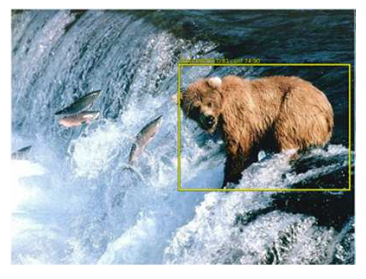

그림 1: 위치 파악(위) 및 탐지 작업(아래) 왼쪽 이미지에는 (신뢰도를 낮추어 정렬된) 우리의 예측이 포함되어 있고 오른쪽 이미지에는 실제 사실 레이블이 표시된다.

탐지 이미지(아래쪽)는 탐지 데이터 세트의 높은 난이도를 나타내며, 이는 많은 작은 개체를 포함할 수 있는 반면 분류 및 위치 지정 이미지에는 일반적으로 하나의 큰 개체가 포함될 수 있다.

2. Vision Tasks

본 논문에서는 (i) 분류, (ii) 현지화 및 (iii) 감지라는 세 가지 컴퓨터 비전 작업을 난이도의 순서로 탐구한다. 각 작업은 다음 작업의 하위 작업입니다.

모든 작업은 단일 프레임워크와 공유 기능 학습 기반을 사용하여 해결되지만, 다음 절에서 별도로 설명할 것이다.

논문을 통해 2013 ImageNet Large Scale Visual Recognition Challenge(ILSVRC 2013)에 대한 결과를 보고한다.

이 과제의 분류 작업에서 각 이미지에는 이미지의 주 객체에 해당하는 단일 레이블이 할당됩니다.

5개의 추측이 정답을 찾을 수 있습니다(이미지에는 레이블이 없는 개체가 여러 개 포함될 수 있기 때문입니다).

위치 지정 작업은 이미지당 5개의 추측이 허용된다는 점에서 유사하지만, 또한 예측 객체에 대한 경계 상자는 각 추측과 함께 반환되어야 한다.

올바른 것으로 간주하려면 예측 상자가 최소 50% 이상 지상 실측과 일치해야 하며(교차보다 결합의 PASCAL 기준을 사용), 올바른 클래스로 라벨이 부착되어야 한다(즉, 각 예측은 함께 연결된 레이블 및 경계 상자임).

탐지 작업은 각 이미지에 개체 수가 있을 수 있다는 점에서 로컬라이제이션과 다르며(제로 포함), 잘못된 긍정은 평균 평균 정밀도(mAP) 측정으로 인해 불이익을 받는다.

로컬라이제이션 작업은 분류와 탐지 사이의 편리한 중간 단계이며, 탐지 관련 과제(배경 클래스 학습 등)와 독립적으로 로컬라이제이션 방법을 평가할 수 있다.

그림 1에서, 우리는 현지화/탐지 예측뿐만 아니라 해당 실측을 가진 이미지의 예를 보여준다.

분류와 로컬라이제이션은 동일한 데이터 세트를 공유하지만, 탐지에는 개체를 더 작게 만들 수 있는 추가 데이터도 있습니다.

탐지 데이터에는 특정 개체가 없는 이미지 집합도 포함됩니다. 이것은 부트스트래핑에 사용될 수 있지만, 우리는 이 작업에서 그것을 이용하지 않았다.

3. Classification

우리의 분류 아키텍처는 Krizhevsky 등의 최고의 ILSVRC12 아키텍처와 유사하다. [15].

그러나 우리는 네트워크 설계와 추론 단계를 개선한다.

시간 제약 때문에 크리제프스키 모델의 훈련 특징 중 일부는 탐색되지 않았으므로 우리의 결과는 훨씬 더 개선될 수 있을 것으로 기대한다.

이러한 사항은 향후 작업 섹션 6에서 논의됩니다.

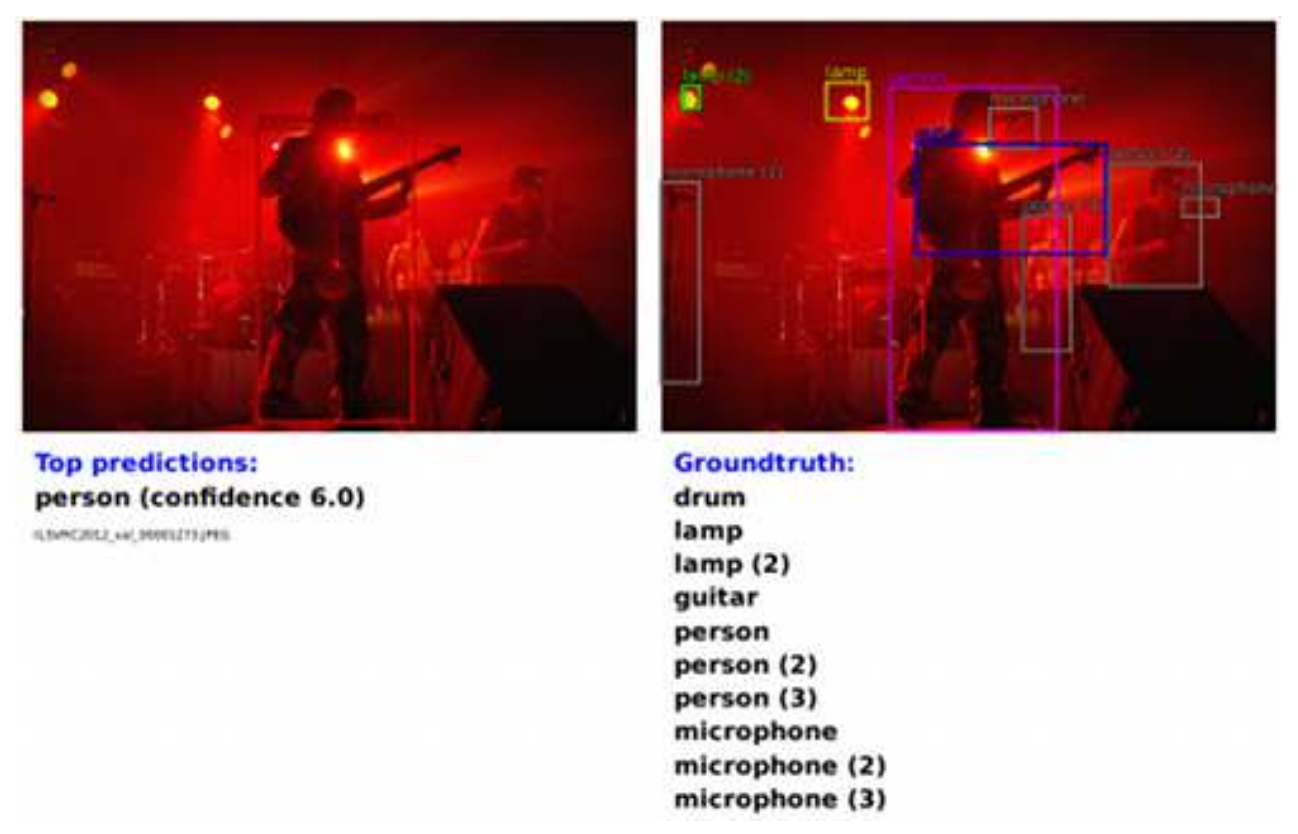

그림 2: 레이어 1(위) 및 레이어 2 필터(아래)

3.1 Model Design and Training

우리는 ImageNet 2012 교육 세트(120만 개의 이미지 및 C = 1000 클래스)에서 네트워크를 교육한다[5].

우리 모델은 Krizhevsky 등이 제안한 것과 동일한 고정 입력 크기 접근법을 사용한다.

[15] 훈련 중이지만 다음 절에 설명된 대로 분류를 위해 멀티스케일로 전환합니다.

각 영상은 다운샘플링되어 가장 작은 치수가 256픽셀이 됩니다.

그런 다음 221x221 픽셀 크기의 5개의 랜덤 크롭(및 수평 플립)을 추출하여 128 크기의 미니 배치로 네트워크에 제시한다.

네트워크의 가중치는 (α, α) = (0, 1 × 10-2)로 임의로 초기화됩니다.

그런 다음 그것들은 0.6의 운동량 항과 1 × 10-5의 β2 무게 붕괴를 동반하는 확률적 경사 하강에 의해 업데이트된다.

학습 속도는 처음에는 5 × 10-2이며 (30, 50, 60, 70, 80) epec 이후 0.5의 비율로 감소된다.

0.5의 비율로 DropOut [11]은 분류기에서 완전히 연결된 계층(6번째 및 7번째)에 사용됩니다.

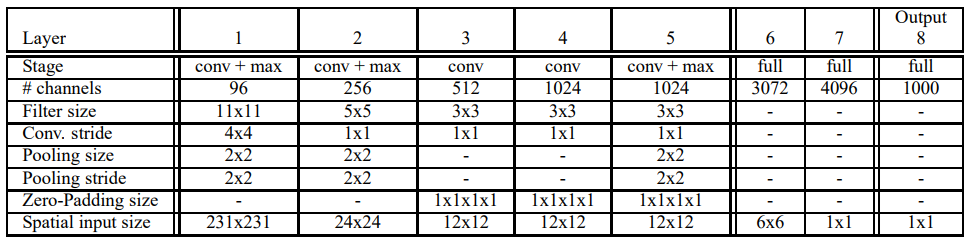

우리는 표 1과 3에 아키텍처 크기를 자세히 설명한다.

훈련 중에 우리는 이 아키텍처를 공간 출력을 생성하는 추론 단계와 반대로 비공간(크기 1x1의 출력 맵)으로 처리한다는 점에 유의한다.

1-5층은 크리제프스키 외와 유사하다. [15], 정류("relu") 비선형성과 최대 풀링을 사용하지만 다음과 같은 차이가 있다.

(i) 대조 정규화는 사용되지 않는다.

(ii) 풀링 영역은 비분할이며

(iii) 우리의 모델은 더 작은 보폭(4개 대신 2개) 덕분에 더 큰 1단 및 2단 피쳐 맵을 가지고 있다.

보폭이 클수록 속도에는 유리하지만 정확도는 떨어진다.

표 1: 빠른 모델을 위한 아키텍처 세부 사항

형상 맵의 공간 크기는 추론 단계에서 달라지는 입력 이미지 크기에 따라 달라진다(부록의 표 5 참조).

여기서는 훈련 공간 크기를 보여 줍니다. 레이어 5는 최상위 컨볼루션 레이어이다.

후속 레이어는 완전히 연결되며 시험 시간에 슬라이딩 윈도우 방식으로 적용된다.

완전히 연결된 레이어는 공간 설정에서 1x1 컨볼루션으로 볼 수도 있다.

정확한 모델을 위한 유사한 크기는 부록에서 확인할 수 있다.

그림 2에서, 우리는 처음 두 개의 컨볼루션 레이어의 필터 계수를 보여준다.

첫 번째 레이어 필터는 방향 가장자리, 패턴 및 블럽을 캡처합니다. 두 번째 레이어에서 필터는 다양한 형태를 가지고 있으며, 일부는 확산되며, 다른 것들은 강한 선 구조 또는 방향 에지를 가지고 있다.

3.2 Feature Extractor

본 논문에서는 컴퓨터 비전 연구를 위한 강력한 기능을 제공하기 위해 "OverFeat" 1이라는 피처 추출기를 출시한다. 빠르고 정확한 두 가지 모델이 제공됩니다.

각 아키텍처는 표 1과 3에 설명되어 있습니다.

또한 매개변수 및 연결 측면에서 표 4의 크기를 비교한다.

정확한 모델은 빠른 모델보다 정확하지만(표 2의 16.39%에 비해 14.18% 분류 오류) 거의

두 배의 연결이 필요하다.

7개의 정확한 모델로 구성된 위원회를 사용하면 그림 4와 같이 13.6%의 분류 오류가 발생한다.

3.3 Multi-Scale Classification

[15]에서, 다중 뷰 투표는 성과를 높이기 위해 사용된다.

고정 10 뷰 세트(4코너와 중심, 수평 플립 포함)는 평균화된다.

그러나 이 접근 방식은 이미지의 많은 영역을 무시할 수 있으며 보기가 겹칠 때 계산적으로 중복된다.

또한, ConvNet이 최적의 신뢰도로 대응하는 척도가 아닐 수 있는 단일 척도로만 적용됩니다.

대신, 우리는 각 위치와 여러 규모로 네트워크를 조밀하게 실행하여 전체 이미지를 탐색한다.

슬라이딩 윈도우 접근 방식은 특정 유형의 모델에 대해 계산적으로 금지될 수 있지만 ConvNet의 경우 본질적으로 효율적이다(섹션 3.5 참조).

이 접근 방식은 투표에 대해 훨씬 더 많은 뷰를 산출하여, 효율성을 유지하면서 견고성을 높인다.

임의의 크기의 이미지에서 ConvNet을 합성한 결과는 각 스케일에서 C차원 벡터의 공간 맵이다.

그러나 위에서 설명한 네트워크의 총 하위 샘플링 비율은 2x3x2x3 또는 36입니다.

따라서 이 아키텍처는 조밀하게 적용될 때 각 축을 따라 입력 차원에 36픽셀마다 분류 벡터를 생성할 수 있다.

이렇게 거친 출력 분포는 네트워크 창이 이미지의 개체와 잘 정렬되지 않기 때문에 10-뷰 체계에 비해 성능이 저하됩니다.

네트워크 창과 개체가 더 잘 정렬될수록 네트워크 응답의 신뢰도가 더 높아집니다.

이 문제를 피하기 위해, 우리는 Guusti 등이 도입한 것과 유사한 접근법을 취한다. [9]를 누르고 모든 오프셋에 마지막 서브샘플링 작업을 적용합니다.

이는 이 계층에서 분해능 손실을 제거하여 x36 대신 x12의 총 하위 샘플링 비율을 산출한다.

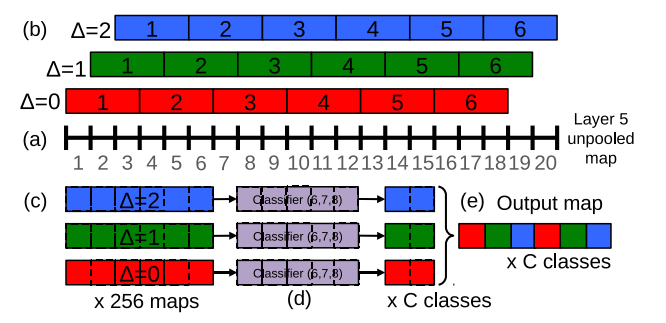

이제 분해능 증강이 수행되는 방법을 자세히 설명한다.

우리는 6개의 입력 척도를 사용하여 풀링되지 않은 계층 5 맵을 다양한 해상도로 만든다

(자세한 내용은 표 5 참조).

그런 다음, 이것들은 풀링되어 다음 절차를 사용하여 분류기에 제시됩니다. 그림으로 표시한다. 3:

(a) 단일 이미지의 경우, 주어진 규모로 풀링되지 않은 레이어 5 기능 맵으로 시작합니다.

(b) 풀링되지 않은 맵은 각각 3x3 max pooling 연산(비 겹침 영역)을 거치며, 픽셀 오프셋 {0, 1, 2)에 대해 3x3회 반복한다.

(c) 이렇게 하면 여러 (∆x, ∆y) 조합에 대해 (3x3) 회 복제되는 풀링된 형상 맵 집합이 생성됩니다.

(d) 분류기(계층 6,7,8)는 5x5의 고정 입력 크기를 가지며, 풀링된 지도 내의 각 위치에 대해 C차원 출력 벡터를 생성한다. 분류기는 풀링된 맵에 슬라이딩 윈도우 방식으로 적용되어 C차원 출력 맵(특정 (∆x, ∆y) 조합)을 산출한다.

(e) 다양한 (∆x, ∆y) 조합에 대한 출력 맵은 단일 3D 출력 맵(두 개의 공간 차원 x C 클래스)으로 재구성됩니다.

그림 3: 스케일 2의 y 차원을 예로 들어 분류를 위한 출력 맵 계산의 1D 그림(스케일링)

(a): 20픽셀 풀링되지 않은 레이어 5 피쳐 맵.

(b): ∆ = {0, 1,2}픽셀(각각 적색, 녹색, 청색)의 오프셋을 사용하여 잘리지 않는 3픽셀 그룹에 대한 최대 풀링.

(c): 6픽셀 풀링 맵이 서로 다른 ∆에 대해 나타납니다.

(d) : 5픽셀 분류기(층 6,7)는 풀링된 맵에 슬라이딩 윈도우 방식으로 적용되며, ∆당 C 맵별로 2픽셀을 산출한다.

(e): C 출력 맵에 의해 6픽셀로 재형성됩니다.

이러한 연산은 하위 샘플링 없이 풀링 레이어를 통해 분류기의 보기 창을 1픽셀씩 이동하고 다음 레이어에서 스킵케르넬을 사용하는 것으로 볼 수 있다(이웃의 값이 인접하지 않은 경우). 또는 가능한 모든 오프셋에서 최종 풀링 레이어와 완전히 연결된 스택을 적용하고 출력을 상호 남겨 결과를 조합하는 것과 동등하다.

위의 절차는 각 이미지의 수평으로 플립된 버전에 대해 반복됩니다.

그런 다음 (i) 각 클래스의 공간 최대값을 각 스케일과 플립에서 가져가고, (ii) 다른 스케일과 플립에서 결과 C차원 벡터를 평균화하고, (iii) 평균 클래스 벡터에서 상위 1 또는 상위 5개 요소(평가 기준에 따라)를 가져옴으로써 최종 분류를 생성한다.

직관적인 수준에서, 특징 추출 계층 (1-5)과 분류자 계층 (6-출력)의 두 절반인 네트워크의 두 반이 반대되는 방식으로 사용된다.

형상 추출 부분에서 필터는 한 번의 통과로 전체 영상에 걸쳐 합성된다. 계산적인 관점에서, 이것은 고정 크기 피처 추출기를 이미지 위로 미끄러뜨린 다음 다른 위치에서 결과를 집계하는 것보다 훨씬 더 효율적이다2.

그러나, 이러한 원칙은 네트워크의 분류자 부분에 대해 역행한다.

여기서는 계층 5 기능 맵에서 다양한 위치와 규모에 걸친 고정 크기 표현을 검색하려고 한다.

따라서 분류기는 고정된 크기의 5x5 입력을 가지며 계층 5 맵에 전체적으로 적용된다. 철저한 풀링 방식(단일 픽셀 이동(∆x, ∆y)은 우리가 특징 맵에서 분류기와 객체의 표현 사이의 미세한 정렬을 얻을 수 있도록 한다.

3.4 Results

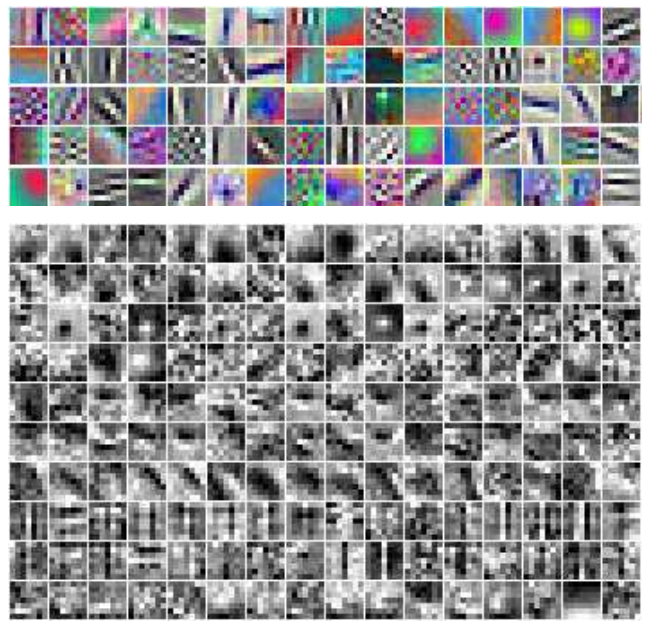

표 2에서는 다양한 접근 방식을 실험하고 이를 크리제프스키 등의 단일 네트워크 모델과 비교한다. [15] 참조.

위에서 설명한 접근 방식은 6개의 척도로 상위 5개 오류율 13.6%를 달성한다.

예상대로, 더 적은 척도를 사용하면 성능이 저하됩니다. 단일 척도 모형이 16.97%의 상위 5개 오차로 인해 더 나빠집니다. 그림 3에 설명된 미세한 보폭 기술은 단일 스케일 체제에서 비교적 작은 개선을 가져오지만 여기에 표시된 다중 스케일 이득에도 중요하다.

표 2: 검증 세트에 대한 분류 실험. Fine/corse stread는 분류기를 적용할 때 사용되는 values 값의 개수를 말합니다. 미세: ∆ = 0, 1, 2, 거칠게: ∆ = 0.

- 6척의 스케일을 가진 우리의 네트워크는 하나의 이미지를 처리하는 데 K20x GPU에서 약 2초가 걸린다.

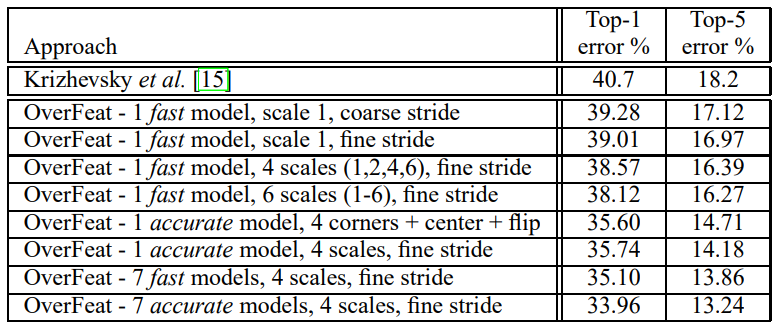

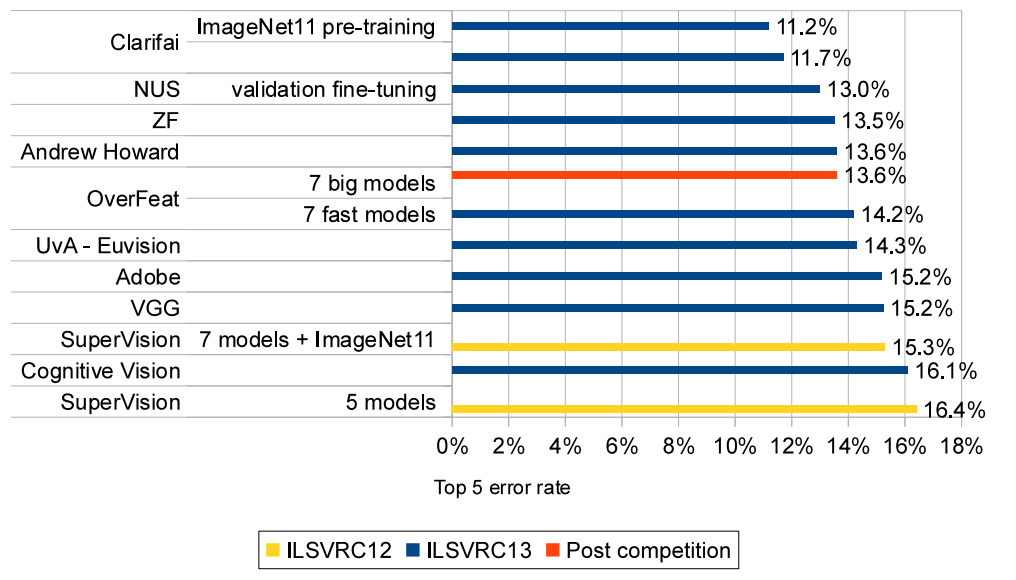

그림 4: 분류 결과를 테스트합니다. 경기 중, OverFeat는 평균 7개의 빠른 모델을 사용하여 14.2% 상위 5개의 오류율을 산출했다.

경쟁 후 작업에서 OverFeat은 더 큰 모델(더 많은 기능 및 더 많은 계층)을 사용하는 13.6%의 오류로 5위를 차지했다.

우리는 그림 4에서 우리의 모델(OverFeat)이 7개의 ConvNets(각각 다른 초기화로 훈련된)의 투표로 14.2%의 정확도를 얻고 18개 팀 중 5위를 차지한 2013년 대회의 테스트 세트 결과를 보고한다.

ILSVRC13 데이터만 사용한 최고의 정확도는 11.7%였다. ImageNet Fall11 데이터 세트의 추가 데이터를 사용한 사전 훈련은 이 수를 11.2%로 향상시켰다. 경쟁 후 작업에서는 더 큰 모델(더 많은 기능 및 더 많은 계층)을 사용하여 OverFeat 결과를 13.6% 오류까지 개선한다.

시간 제약으로 인해 이러한 더 큰 모델은 완전히 훈련되지 않았으며, 더 많은 개선이 제때 나타날 것으로 예상된다.

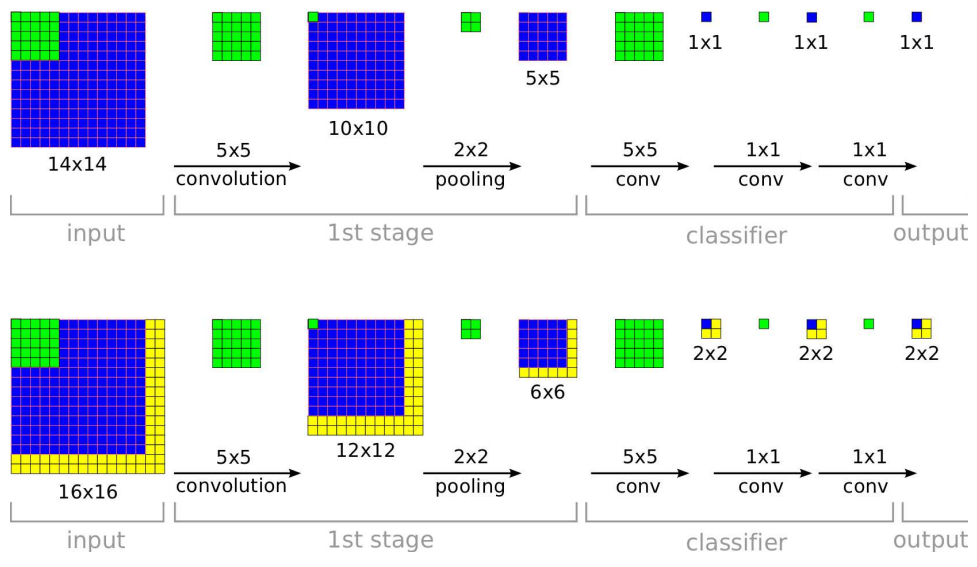

3.5 ConvNets and Sliding Window Effciency

입력의 각 창에 대한 전체 파이프라인을 한 번에 하나씩 계산하는 많은 슬라이딩 윈도우 접근법과 대조적으로 ConvNet은 중복 영역에 공통적인 계산을 자연스럽게 공유하기 때문에 슬라이딩 방식으로 적용할 때 본질적으로 효율적이다. 테스트 시 네트워크를 더 큰 이미지에 적용할 때, 우리는 전체 이미지의 범위에 대해 각 컨볼루션만 적용하면 된다.

이것은 각 레이어의 출력을 새로운 이미지 크기로 확장시켜, 결국 각 입력의 "창"(보기 영역)에 대한 하나의 공간 위치와 함께 출력 클래스 예측의 맵을 생성한다.

이것은 그림 5에 도해되어 있다.

컨볼루션은 상향식으로 적용되므로 인접 창에 공통되는 계산은 한 번만 수행하면 된다.

그림 5: 검출을 위한 ConvNet의 효율성 교육 중에 ConvNet은 단일 공간 출력(상단)만 생성합니다. 그러나 테스트 시간에 큰 이미지를 통해 적용하면 공간 출력 맵(예: 2x2(하단)이 생성됩니다.

모든 레이어가 컨볼루션으로 적용되기 때문에 더 큰 이미지에 필요한 추가 계산은 노란색 영역으로 제한된다.

이 다이어그램은 단순성을 위해 기능 차원을 생략합니다.

아키텍처의 마지막 계층은 완전히 연결된 선형 계층이라는 점에 유의한다. 테스트 시간에, 이러한 계층들은 1x1 공간 범위의 커널을 가진 컨볼루션 연산에 의해 효과적으로 대체된다.

그러면 전체 ConvNet은 단순히 컨볼루션, 최대 풀링 및 임계값 지정 작업의 순서일 뿐이다.

4. Localization

분류 훈련 네트워크에서 시작하여 분류기 계층을 회귀 네트워크로 교체하고 각 공간 위치와 규모에서 객체 경계 상자를 예측하도록 훈련한다.

그런 다음 지금 설명한 대로 각 위치의 분류 결과와 함께 회귀 예측을 결합한다.

4.1 Generating Predictions

개체 경계 상자 예측을 생성하기 위해 모든 위치와 규모에 걸쳐 분류기와 회귀기 네트워크를 동시에 실행한다.

이들은 동일한 특징 추출 계층을 공유하므로 분류 네트워크를 계산한 후 최종 회귀 계층만 재계산하면 된다.

각 위치에서 클래스 c에 대한 최종 소프트맥스 레이어의 출력은 클래스 c 개체가 해당 시야에 존재한다는(꼭 완전히 포함되지는 않지만) 신뢰도를 제공한다. 따라서 우리는 각 경계 상자에 신뢰도를 할당할 수 있다.

4.2 Regressor Training

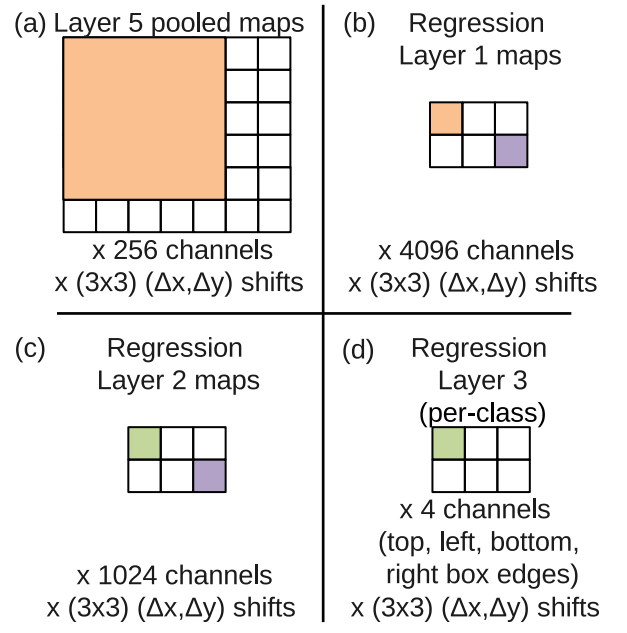

회귀 네트워크는 계층 5의 풀링된 기능 맵을 입력으로 받아들인다.

각각 4096과 1024채널 크기의 완전히 연결된 2개의 숨겨진 레이어를 가지고 있다.

최종 출력 계층에는 경계 상자 가장자리에 대한 좌표를 지정하는 4개의 단위가 있습니다. 분류와 마찬가지로, ∆x, ∆y 이동에서 비롯되는 (3x3)개의 사본이 있다. 그 구조는 그림 8에 나타나 있다.

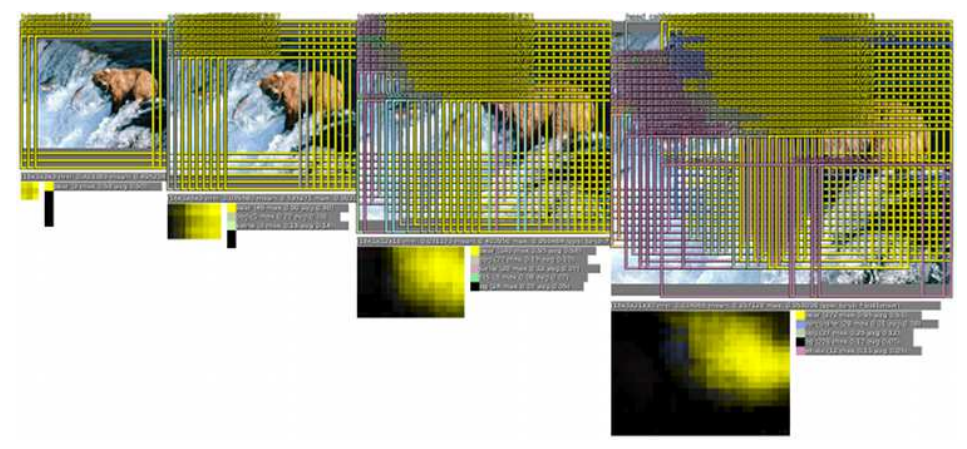

그림 6: 현지화/탐지 파이프라인

원시 분류기/검출기는 각 위치(1번째 다이어그램)에 대한 클래스 및 신뢰도를 출력합니다. 이러한 예측의 분해능은 섹션 3.3(2번째 다이어그램)에 설명된 방법을 사용하여 증가할 수 있습니다.

그런 다음 회귀 분석에서는 각 창(3번째 다이어그램)에 대한 개체의 위치 척도를 예측합니다.

그런 다음 이러한 경계 상자가 병합되고 소수의 개체(4번째 다이어그램)로 누적됩니다.

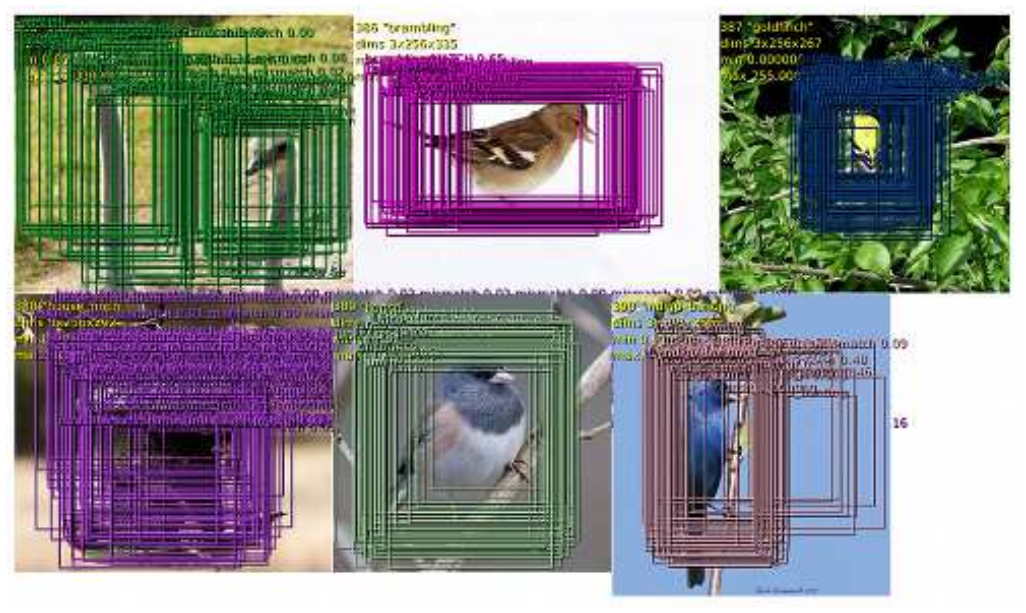

그림 7: 최종 예측으로 결합되기 전에 회귀 네트워크에서 생성된 경계 상자의 예.

여기에 표시된 예는 단일 규모입니다. 예측은 객체에 따라 다른 척도에서 더 최적일 수 있습니다.

여기서 처음에 그리드로 구성된 대부분의 경계 상자는 단일 위치와 척도로 수렴됩니다.

이는 네트워크가 객체 위치에 대해 랜덤하게 분산되는 것이 아니라 매우 자신 있다는 것을 나타냅니다.

왼쪽 위 이미지는 여러 개체가 있는 경우에도 여러 위치를 올바르게 식별할 수 있음을 보여줍니다.

예측된 경계 상자의 다양한 가로 세로 비율은 네트워크가 다양한 객체 포즈를 처리할 수 있음을 보여준다.

우리는 분류 네트워크에서 특징 추출 계층(1-5)을 고치고 각 예에 대해 예측된 경계 상자와 실제 경계 상자 사이의 ℓ2 손실을 사용하여 회귀 네트워크를 훈련시킨다.

최종 회귀 계층은 클래스마다 다르며 1000개의 다른 버전을 가지고 있다.

우리는 섹션 3에서 설명한 것과 동일한 척도 집합을 사용하여 이 네트워크를 훈련시킨다.

각 공간 위치에서 회귀선 그물의 예측을 콘볼루션 내에서 회귀선 변환 오프셋의 참조 프레임으로 이동한 지상 실측 경계 상자와 비교한다(그림 8 참조).

그러나, 우리는 입력 시야와 50% 미만의 겹침이 있는 경계 상자에 대해 회귀 분석기를 훈련시키지 않는다. 객체는 대부분 이러한 위치를 벗어나 있기 때문에 개체를 포함하는 회귀 분석 창에 의해 더 잘 처리될 것이다.

다중 스케일 방식으로 회귀 분석기를 훈련시키는 것은 전체 스케일 예측 조합에 중요하다.

단일 규모 교육은 해당 규모에서 우수한 성과를 거두며, 다른 규모에서도 상당한 성과를 거둘 수 있습니다. 그러나 다중 척도를 훈련하면 예측이 척도에 걸쳐 올바르게 일치하고 병합된 예측의 신뢰도를 기하급수적으로 증가시킨다.

결과적으로, 이를 통해 일반적으로 검출되는 많은 스케일 대신 몇 개의 스케일만으로 우수한 성능을 발휘할 수 있습니다.

보행자 감지에서 한 스케일에서 다른 스케일까지의 일반적인 비율은 약 1.05 대 1.1이다. 그러나 여기서는 약 1.4의 큰 비율(이 숫자는 네트워크 보폭에 정확히 맞도록 조정되기 때문에 서로 다르다)을 사용하여 시스템을 더 빨리 실행할 수 있다.

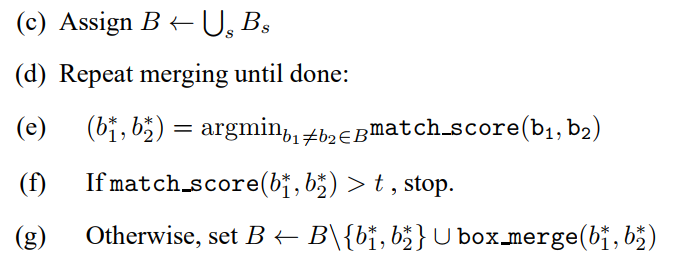

4.3 Combining Predictions.

우리는 다음 알고리듬을 사용하여 회귀 분석 경계 상자에 적용되는 탐욕 병합 전략을 통해 개별 예측(그림 7 참조)을 결합한다.

(a) 에 각 눈금에 대한 최대 감지 클래스 출력을 공간 위치에 걸쳐 가져옴으로써 각 눈금 s ∈ 1..6에 대한 Top k의 클래스 세트를 할당하십시오.

(b) C의 각 클래스에 대해, 스케일에서 모든 공간 위치에 걸쳐 회귀 분석 네트워크가 예측한 경계 상자 집합을 B에 할당합니다.

그림 8: 예를 들어 스케일 2에서 계층 5 기능에 회귀 네트워크를 적용합니다.

(a) 이 눈금에서 회귀기의 입력은 (3x3) ∆x, ∆y 시프트 각각에 대해 공간적으로 6x7픽셀이다.

(b) 회귀망의 첫 번째 층에 있는 각 단위는 모든 256개의 채널뿐만 아니라 계층 5 맵의 5x5 공간 이웃에 연결된다. 5x5 이웃을 이동시키면 레이어 내 4096개 채널 각각에 대해 2x3 공간 범위의 지도가 생성되고 (3x3) ∆x 각각에 대해 ∆y 이동한다.

(c) 2차 회귀 계층은 1024개의 단위를 가지며 완전히 연결된다(즉, 보라색 요소는 (b)의 보라색 요소에만 연결되며, 4096개의 모든 채널을 통해 연결된다).

(d) 회귀 네트워크의 출력은 2x3 맵의 각 위치와 (3x3) ∆x의 각 위치에 대한 4-벡터(경계 상자의 가장자리 지정)이다.

(c) B ← S B 할당

(d) 완료될 때까지 병합을 반복합니다.

(e) (b 1 1, b 2 2) = argminb16=b2∈Bmatch 점수(b1, b2)

(f) 일치 점수(b 1 1, b 2 2) > t, stop. (g) 그렇지 않으면 B ← B{b 1 1, b 22} merge 상자 병합(b 1 1, b 2 2)을 설정합니다.

위에서, 우리는 두 경계 상자의 중심과 상자의 교차 영역 사이의 거리의 합계를 사용하여 일치 점수를 계산한다.

상자 병합 - 경계 상자의 좌표 평균을 계산합니다.

최종 예측은 최대 클래스 점수로 병합된 경계 상자를 가져옴으로써 주어진다. 이는 각 경계 상자가 예측된 입력 창과 관련된 탐지 클래스 출력을 누적하여 계산한다. 단일 신뢰도 경계 상자에 병합된 경계 상자의 예는 그림 6을 참조하십시오.

이 예에서 일부 거북이와 고래 경계 상자는 중간 다중 스케일 단계에 나타나지만 최종 탐지 영상에서는 사라진다. 이러한 경계 상자는 분류 신뢰도가 낮을 뿐만 아니라(각각 0.11과 0.12), 이들의 수집은 상당한 신뢰도 증가를 얻기 위해 곰 경계 상자만큼 일관적이지 않다.

베어 박스는 신뢰도가 높고(척도당 평균 약 0.5) 일치 점수가 높습니다. 따라서 병합 후 많은 곰 경계 상자는 단일 매우 높은 신뢰 상자로 융합되는 반면, 잘못된 긍정은 경계 상자 일관성과 신뢰성의 부족으로 탐지 임계값 아래로 사라진다.

이 분석은 우리의 접근 방식이 경계 상자 일관성을 보상함으로써 기존의 최대 이외의 억제보다 순수 분류 모델에서 오는 잘못된 긍정에 대해 자연스럽게 더 강력하다는 것을 시사한다.

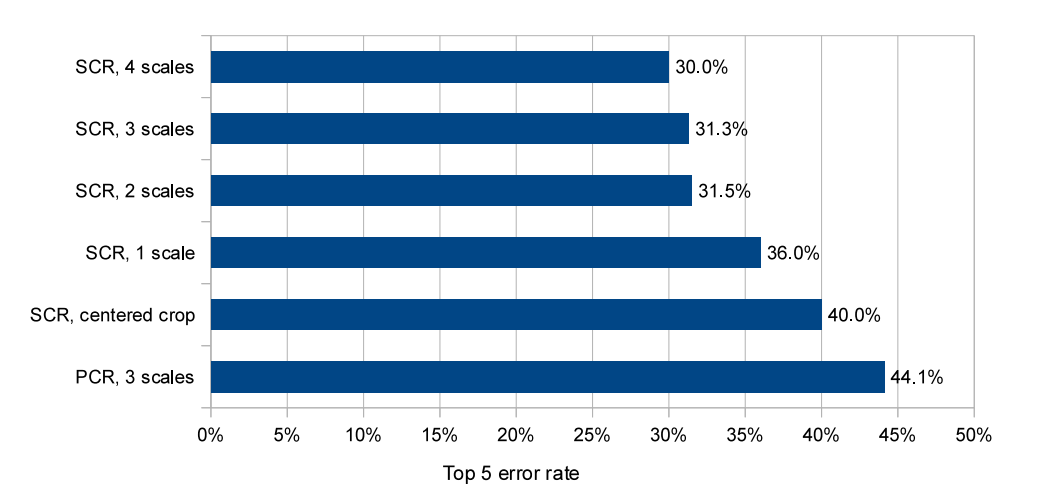

그림 9: ILSVRC12 유효성 검사 세트에 대한 현지화 실험. 우리는 다양한 척도를 실험하고 단일 클래스 회귀 분석(SCR) 또는 클래스당 회귀 분석(PCR)을 사용하여 실험한다.

4.4 Experiments

우리는 경쟁에 대해 지정된 지역화 기준을 사용하여 네트워크를 Imagenet 2012 검증 세트에 적용한다.

이에 대한 결과는 그림 9에 나와 있다. 그림 10은 2012년과 2013년 지역화 경기의 결과를 보여준다. (이 두 해 모두 열차와 시험 데이터가 동일하다.)

우리의 방법은 29.9%의 오류와 함께 2013년 대회의 우승자입니다.

그림 9: 단일 중앙 크롭만 사용하여 우리의 회귀 네트워크는 40%의 오류율을 달성하므로, 우리의 멀티스케일 및 다중 뷰 접근 방식은 우수한 성능을 얻는 데 매우 중요했다.

모든 공간 위치의 회귀 분석 예측을 두 가지 척도로 결합함으로써 31.5%라는 훨씬 더 나은 오류율을 달성한다.

3차 및 4차 척도를 추가하면 성능이 30.0% 오류로 향상됩니다.

각 클래스에 대해 회귀 네트워크(그림 9의 PCR)의 각 클래스에 대해 다른 최상위 계층을 사용하는 것은 놀랍게도 모든 클래스 간에 공유되는 단일 네트워크(44.1% 대 31.3%)를 사용하는 것보다 성능이 우수하지 않았다.

이는 훈련 세트에 경계 상자에 주석을 단 클래스당 예가 상대적으로 적은 반면, 네트워크는 1000배 더 많은 최상위 매개 변수를 가지고 있어 훈련이 부족하기 때문일 수 있다. 유사한 등급(예: 모든 등급의 개에 대한 네트워크 훈련, 차량 등에 대한 네트워크 훈련)에서만 매개 변수를 공유함으로써 이 접근 방식을 개선할 수 있다.

5. Detection

탐지 훈련은 분류 훈련과 유사하지만 공간적인 방식으로 이루어진다.

이미지의 여러 위치를 동시에 학습할 수 있습니다.

모델이 컨볼루션이기 때문에 모든 가중치가 모든 위치에서 공유된다.

지역화 작업의 주요 차이점은 개체가 없을 때 배경 클래스를 예측할 필요성이다.

전통적으로 부정적인 예는 훈련을 위해 처음에는 무작위로 취한다.

그런 다음 가장 불쾌한 네거티브 오류가 부트스트래핑 패스의 교육 세트에 추가됩니다.

독립적인 부트스트래핑 패스는 훈련을 복잡하게 만들고 부정적인 사례 수집과 훈련 시간 사이에 잠재적인 불일치를 초래할 수 있다.

또한, 부트스트랩 패스의 크기는 훈련이 작은 세트에 지나치게 맞지 않도록 조정해야 합니다.

이러한 모든 문제를 피하기 위해, 우리는 무작위적인 예나 가장 불쾌한 예와 같은 이미지당 몇 가지 흥미로운 부정적인 예를 선택하여 즉시 부정적인 훈련을 수행한다.

이 접근법은 계산 비용이 더 많이 들지만 절차를 훨씬 단순하게 만든다.

그리고 기능 추출은 처음에 분류 작업으로 훈련되기 때문에 탐지 미세 조정은 그리 길지 않다.

그림 11에서, 우리는 탐지 시스템이 19.4%의 평균 정밀도(mAP)로 3위를 차지한 ILSVRC 2013 경기 결과를 보고한다.

우리는 이후 24.3%의 mAP로 새로운 탐지 상태를 확립했다.

상위 3가지 방법과 다른 팀 사이에 큰 차이가 있습니다(4번째 방법은 11.5% mAP를 산출합니다). 또한 우리의 접근 방식은 후보 창을 약 200,000개에서 2,000개로 줄이기 위해 초기 분할 단계를 사용하는 상위 2개 시스템과 상당히 다르다.

이 기술은 추론 속도를 높이고 잠재적인 잘못된 긍정의 수를 크게 줄인다.

[29, 1]은 선택적인 검색이 아닌 조밀한 슬라이딩 윈도우를 사용할 때 검출 정확도가 떨어지며 이로 인해 잘못된 긍정이 감소함을 시사한다.

우리의 방법과 결합되어, 우리는 전통적인 밀도 방법과 분할 기반 방법 사이에서 여기서 보이는 것과 유사한 개선을 관찰할 수 있다.

또한 NEC와 UvA가 그랬던 것처럼 검출 검증 세트를 미세 조정하지 않았다는 점에 유의해야 한다. 검증 및 테스트 세트 분포는 교육 세트와 크게 달라서 결과만 약 1포인트 개선됩니다.

그림 11에서 두 가지 과열 결과 사이의 개선은 더 긴 훈련 시간과 컨텍스트 사용, 즉 각 척도는 더 낮은 분해능 척도를 입력으로 사용하기 때문이다.