Very Deep Convolutional Networks for Large-Scale Image Recognition (VGG)

https://arxiv.org/abs/1409.15563x3 convolution filter를 가진 network을 이용해 깊이를 증가시킨 모델을 평가합니다.깊이를 16-19 layer로 늘려 이전 모델들보다 개선됨을 보여줍니다.백서에서는 ConvNet 아

Transformers: State-of-the-Art Natural Language Processing

https://arxiv.org/pdf/1910.03771.pdfTransformers는 자연어 처리 분야를 혁신적으로 발전시킨 오픈소스 라이브러리로, Transformer 아키텍처와 효과적인 사전 학습을 통해 다양한 작업을 위한 고용량 모델을 만들었습니다.이

Training Language Models to Follow Instructions with Human Feedback

https://arxiv.org/abs/2203.02155다양한 대형언어모델이 다양한 NLP task를 풀기 위해 모델에 prompt를 줄 수 있습니다. 특히, task에 대한 몇 개의 예제를 함께 주는 prompt가 흔하게 쓰입니다. 하지만, 이러한 모델들은

Temporal Fusion Transformers for Interpretable Multi-horizon Time Series Forecasting

https://arxiv.org/pdf/1912.09363.pdf여러 날을 예측하는 Multi-Horizon Forecasting 시계열 데이터는 복잡한 입력들을 포함하는데 그러한 것들에는 시간에 따라 변하지 않는 변수(이 논문에서는 Static Covaria

PPT: Pre-trained Prompt Tuning for Few-shot Learning

img사전학습된 언어 모델을 미세조정(fine-tuning; FT)하는 연구는 많은 발전을 이룩해왔고, 우수한 성능을 보여주었습니다. FT에는 크게 두가지 방법이 있는데, 첫번째로는 task-specific head가 사전학습된 모델 위에 추가되어 전체 모델을 task

Language Models are Few-Shot Learners

https://proceedings.neurips.cc/paper/2020/file/1457c0d6bfcb4967418bfb8ac142f64a-Paper.pdf대규모 텍스트 코퍼스에서 사전 학습된 GPT-3 언어 모델을 사용하여, Few-shot 학습을 통해

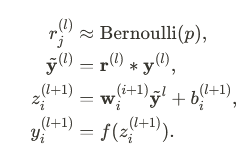

Generating Text with Recurrent Neural Networks

https://web.archive.org/web/20211224075156id\_/https://icml.cc/2011/papers/524_icmlpaper.pdf이 논문에서는 LSTM 기반 모델을 사용하여 단어 수준 언어 모델링 문제를 다루며, 순

Editing Factual Knowledge in Language Models

https://arxiv.org/abs/2104.08164언어 모델에 저장된 지식 중 일부를 수정하고 나머지 지식을 보존할 수 있는 KnowledgeEditor방법론을 제안했습니다. 지식을 외부에 저장했던 기존의 Knowledge Bases (KBs)와는 달리

Deep Learning of Representations: Looking Forward

https://arxiv.org/abs/1305.0445딥 러닝 알고리즘을 훨씬 더 큰 모델과 데이터 세트로 확장하고, 잘못된 컨디셔닝 또는 로컬 최소값으로 인한 최적화의 어려움을 줄입니다.보다 효율적이고 강력한 추론 및 샘플링 절차를 설계하고 관찰된 데이터의

Dropout: a simple way to prevent neural networks from overfitting

Deep Neural Network 의 Regularization 방법인 Dropout 을 제시한 논문입니다.학습 과정에서 일부 Node 를 제외(Drop)하는 것 만으로 Overfitting 을 방지할 수 있는 단순한 방법을 제시했습니다.Dropout 이전에도 ove

자료구조_그래프실습

그래프 자료구조 실습 다음 트리의 자료구조 DFS를 탐색해 보시오 실행 결과 예 node : A 방문지점 : ["A"] node : B 방문지점 : ["A", "B"] node : C 방문지점 : ["A", "B", "C"] node : D 방문지점 : ["A", "B", "C", "D"]...

자료구조_그래프

그래프 자료구조 컴퓨터과학 분야에서는 데이터를 저장하는 자료구조에서 그래프 이론을 사용하였다. 그래프의 특칭과 규칙을 갖도록 데이터를 저장한 것이며, 데이터들의 관계를 저장할 때 함께 정의하여 저장할 방법 컴퓨터과학 분야에서는 그래프 자료구조를 표현할 때 노드로 표현한다. 노드의 이름이나 노드의 정의보다는 노드의 수가 중요 그래프 형태로 저장한다는 것은 ...

확장형자료구조실습

스택 스택은 기본 자료구조에 규칙을 포함한 확장형 자료구조 스택의 규칙은 새로운 데이터를 저장할 때 항상 가장 마지막에 저장하며 이러한 저장 동작을 push, 저장된 데이터를 불러올 때 pop 동작이라고 정의 실습 예제 간단한 스택 추가 및 삭제 빈 스택에 데이터 추가, 삭제하기 빈스택에 시작해 데이터를 하나씩 추가 1:삽입, 2:삭제, 3:종료 ...

확장형 자료구조

자료구조란 주기억장치에 데이터를 저장하는 방식을 구조적으로 정의하는 것을 말하고, 알고리즘은 문제를 해결하는 방식을 말한다. 이때 자료구조인 데이터를 저장하는 방식에 특별한 문제를 해결하기 위하여 문제 해결의 절차, 즉 알고리즘을 포함한 자료구조가 존재 기본 자료구조에 문제 해결을 위한 특정한 규칙을 포함시킨 자료구조로써 확장형 자료구조라 정의하였음 스택,...

기본자료구조 실습

배열 리스트와 배열의 차이점 |리스트|배열| |:--:|:--:| |다양한종류의 데이터를 담을 수 있다 반복문을 사용하여 연산을 수행하기에 상대적으로 수행하는 속도가 느리다. 연산 처리 시 전체 리스트로 연산한다|동일한 종류의 데이터만 담을 수 있다 연속된 메모리에 데이터를 저장한다. 간단한 연산 처리가 가능하고 수행하는 속도가 빠르다 연산 처리...

기본 자료구조 - 배열, 연결 리스트

기본 자료구조와 확장형 자료구조 자료구조는 데이터를 주기억 장치에 저장하는 것에 중점을 두고 만들어진 방법 데이터를 주기억 정치에 저장하는 것이 가장 큰 문제였음 데이터를 어덯게 주기억 장치에 저장해야 주기억 장치를 효율적으로 사용하고 저장된 데이터를 빨리 찾을 수 있을 까의 문제였음 주기억장치에 어떤 데이터를 저장할지 연구하여 정의된 것이 자료...

추천 시스템 평가

추천 시스템을 활용해 서비스각 성장하려면 반드시 평가가 실행되어야 한다. 추천 시스템 평가에는 크게 온라인 평가와 오프라인 평가, 사용자 스터디가 있다. 3가지 평가 방법 오프라인 평가 실제 서비스상에서의 열람, 구매 등 사용자 행동 이력에서 얻은 과거의 로그(서비스 로그)를 사용해 모델의 예측 정밀도 등을 평가한다. 서비스 로그를 사용하는 온라인 평...

Chapter 5 - (3)

행렬 분해 행렬 분해 메모리 기반 협조 필터링에 비해 구현 관점에서 다소 복잡하지만 추천 성능은 좋다 행렬 분해라는 용어는 넓은 범위를 나타내며 문헌에 따라 행렬 분해라는 용어가 전혀 다른 바법을 가리키는 경우도 존재 추천 시스템에서의 행렬분해는 넓은 의미에서 평갓값 행렬을 저차원의 사용자 인자 행렬과 아이템 인자 행렬로 분해하는 것을 나타낸다. 사용자...

Chapter 5 - (2)

연관 규칙 연관 규칙의 경우 협조 필터링 추천 중에서도 과거부터 지금까지 폭넓게 업계에서 활용되고 있다. 연관 규칙에서는 대량의 구매 이력 데이터로부터 '아이템 A와 아이템 B는 동시에 구입하는 경우가 많다'는 규칙을 발견 '기저귀와 맥주'를 통하여 알 수 있다. SQL로도 구현 가능할정도로 계산 방법 자체는 간단 ||아이템A|아이템B|아이템C| |:-...

Chapter 5 - (1)

Chapter 5. 추천 알고리즘 상세 구체적인 추천 시스템 알고리즘을 소개 MovieLens라는 영화 데이터셋을 통하여 실습 알고리즘 비교 간단한 추천 모델을 시험해보고 싶다면 인기도 추천이나 연관 규칙을 선택 정확도를 높이고 싶다면 LDA 혹은 word2vec 또는 머신러닝 방법을 시험, 협조 필터링에서 정확도를 높이고 싶다면 행렬 분해 계열이나 ...