L2CS-NET: FINE-GRAINED GAZE ESTIMATION IN UNCONSTRAINED ENVIRONMENTS

0. Abstract

야외에서의 시선 추정은 눈의 외형의 독특성, 조명 조건의 다양성, 머리의 자세 및 시선 방향의 다양성 등으로 인해 어려운 문제이다.

본 연구는 unconstrained 환경에서 시선을 예측하기 위한 CNN 기반 모델을 제안한다.

- 각 시선 각도를 개별적으로 회귀시켜 각각의 예측 정확도를 향상 → 전체적인 시선 성능 향상

- 두 개의 손실 함수 사용 → 네트워크 학습 개선, 일반화 향상

MPIIGaze와 Gaze360 데이터셋에서 각각 3.92°와 10.41°의 최고 수준의 정확도를 달성

index : Appearance-based gaze estimation, Gaze Analysis, Gaze Tracking, Convolutional Neural Network

1. Introduction

시선 추정은 model-based와 appearance-based 방법이 존재한다.

- model-based : 전용 하드웨어 필요, unconstrained 환경에서 사용하기 어려움

- appearance-based : 저렴한 카메라로 촬영한 이미지에서 인간의 시선을 직접 회귀 → 다양한 위치와 비제약 설정에서 쉽게 생성 가능

최근에는 CNN 기반 appearanced-based 방법이 일반적으로 사용됌.

주로 얼굴 또는 눈 혹은 얼굴과 눈 이미지를 입력으로 받아서 backbone(VGG, ResNet-18, ResNet-50)을 사용하여 시선 feature를 추출하고 시선 방향을 출력하는 CNN 기반 네트워크. 일반적으로 사용되는 손실함수는 mean square loss, l2 loss.

l2 loss와 cross-entropy loss를 함께 사용해서 시선 방향과 오차 범위를 동시에 추정하는 pinball loss → unconstrained 환경에서 정확도 향상

CNN 기반 방법은 시선 정확도가 향상되었지만 unconstrained 환경에서의 견고성과 일반화가 부족하다

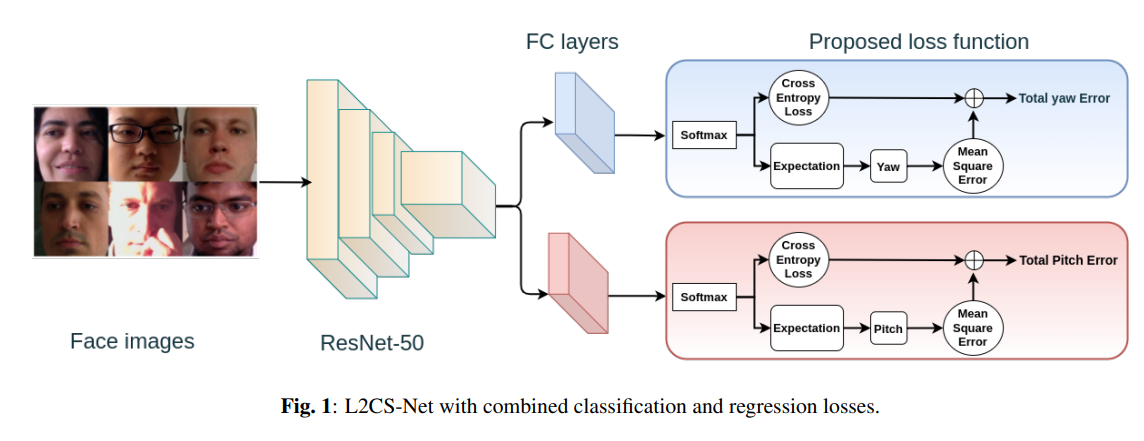

L2CS-Net은 RGB 이미지에서 3D 시선 각도 추정을 위해 multi-loss 접근을 사용한다. 두 개의 fully-connected 레이어와 별도 손실 함수를 정의하여 각각의 시선 각도(yaw, pitch)를 개별적으로 회귀시킨다. softmax 레이어와 cross-entropy 손실을 활용하여 시선 이진 분류를 수행하여 네트워크가 시선 각도 견고하게 추정한다.

2. Related Work

appearanced-based 시선 추정은 conventional과 CNN-based 접근이 존재한다.

conventional : 회귀 함수를 통해 person-specific 매핑 함수를 생성(adaptive linear regression, gaussian process regression). 비제약 환경에서 성능이 좋지 못함

CNN-based : 시선 간에 매우 비선형적인 매핑 함수를 모델링할 수 있

3. Method

3.1 Proposed loss function

일반적으로 3D 시선을 구면 좌표계의 각도(yaw, pitch)로 예측하며 MSE(l2) loss를 사용한다.

본 연구는

- 각각의 시선 각도에 두 개의 동일한 손실 함수를 사용한다. 각 손실 함수는 cross-entropy loss와 MSE loss를 조합한다.

- cross-entropy layer와 softmax layer를 사용해 구간별 시선 분류를 예측한다. 그 후 output의 기댓값을 추정하여 예측을 finegrain한다.

- output에 MSE를 사용하여 성능 개선을 한다

- l2 loss와 Softmax를 같이 사용하면 비선형 softmax layer를 유연하게 조정할 수 있다

corss-entropy loss :

mean-squared error :

proposed loss :

CLS는 즉 MSE와 cross-entropy loss의 선형 결합

p : 예측값

y : GT 값

β : regression coefficient

3.2 L2CS-Net Architecture

L2CS-Net은 얼굴 이미지를 입력으로 받아들이고, ResNet-50을 백본으로 사용하여 spatial gaze feature를 뽑아낸다. 백본의 convolution layer를 공유하는 두 개의 fully-connected layer를 사용해 각각의 각도를 개별적으로 예측한다. 동일한 두 개의 손실 함수 yaw, pitch 각각에 사용한다.

FC layer의 각 output을 softmax layer를 사용해 출력 logits을 확률 분포로 변환한다. 확률과 타겟 bin label 사이의 cross-entropy loss를 사용하여 bin classification loss를 계산한다. 이 예측에 대한 MSE를 계산해서 분류 손실에 추가한다.

3.3 Datasets

Gaze360 : 360도의 다양한 3D 시선 주석을 제공, 다양한 연령, 성별 및 인종, 조명 조건 및 배경과 같은 다양한 실내 및 실외 환경 설정

MPIIGaze : 15 명의 주체, 다양한 배경, 시간 및 조명으로 구성된 이미지

4. Experiments

4.1 Data Prerprocessing

- 가상 카메라에 rotation과 translation을 적용하여 머리의 roll angle을 제거하고 가상 카메라와 얼굴의 중심까지의 거리를 유지한다.

- 연속적인 gaze target(pitch, yaw)를 이진 레이블로 분할한다

→ 연속적인 레이블과 구간화된 레이블, 두 가지의 다른 target 주석을 가지고 있어서 결합된 회귀 및 분류 손실에 적합하다

MSE(평균 제곱 오차)는 회귀 손실 함수로, 예측 값과 실제 값 간의 평균 제곱 차이를 측정한다. 이는 시선 각도와 같은 연속적인 수치 값을 예측하는 회귀 작업에 일반적으로 사용된다다.

반면에, 크로스 엔트로피 손실은 분류 손실 함수로, 입력을 다른 범주로 분류하는 작업에 사용된다. 예측된 클래스 확률과 실제 클래스 레이블 사이의 불일치를 측정한다. 시선 추정의 맥락에서는, 시선 각도를 구간화하여 시선 분류를 수행하고자 할 때 크로스 엔트로피 손실을 사용할 수 있다.

4.2 Training and results

ImageNet으로 사전 훈련된 ResNet-50을 백본 네트워크로 사용한다. MPIIGaze와 Gaze360 데이터셋에서 제안된 네트워크를 평가한다. 회귀 계수(MSE)를 변경하며 출력 성능을 평가한다.

성능을 평가하기 위해 gaze angular error(◦)를 사용한다.

GT gaze vector : g (3차원)

predicted gaze vector :

gaze angular error :

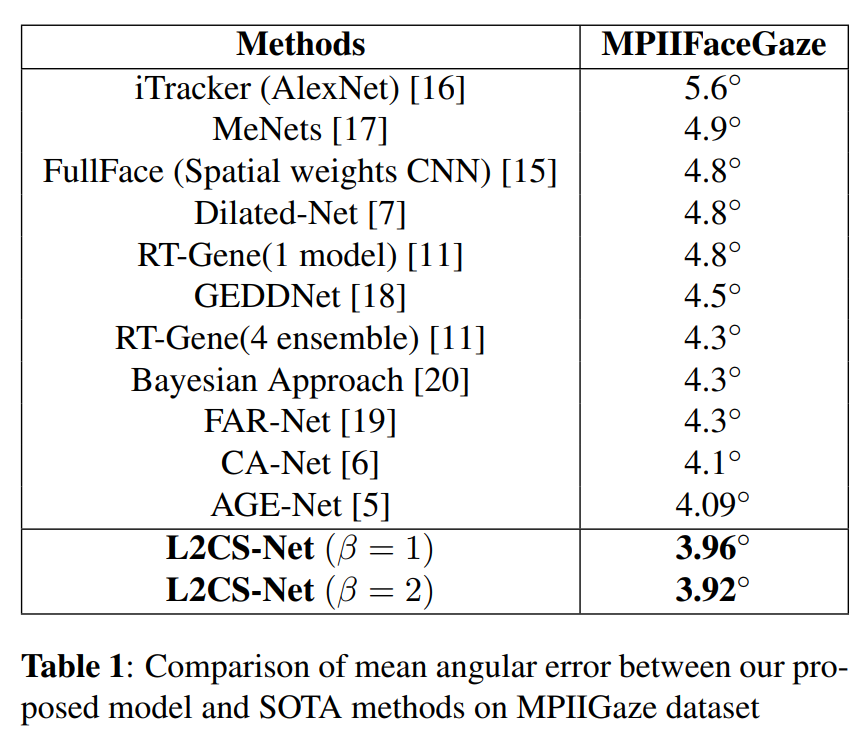

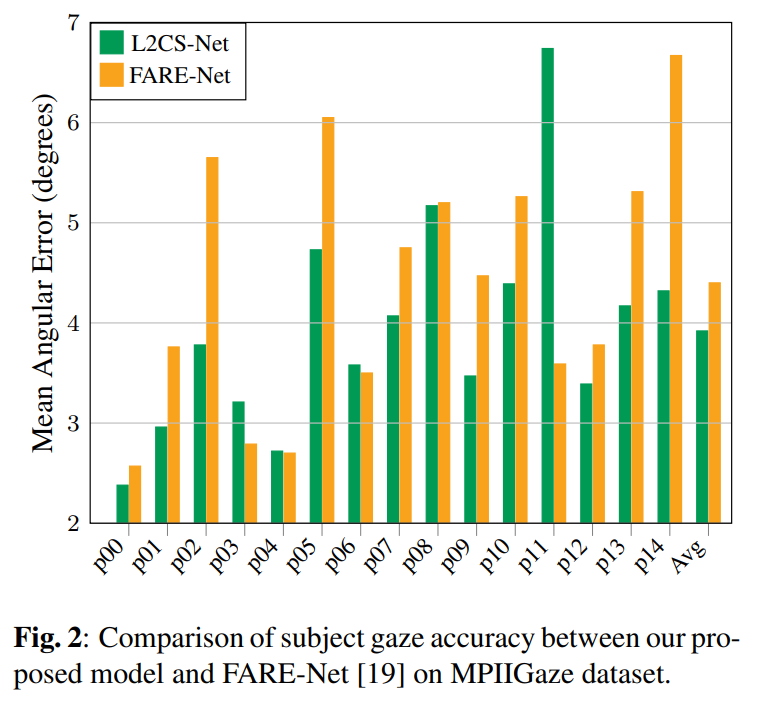

MPIIGaze 데이터셋에서 Leave-One-Subject-Out 교차 검증을 적용. 3.92◦ 평균 각도 오차로 SOTA. FARE-Net보다도 더 나은 시선 정확도

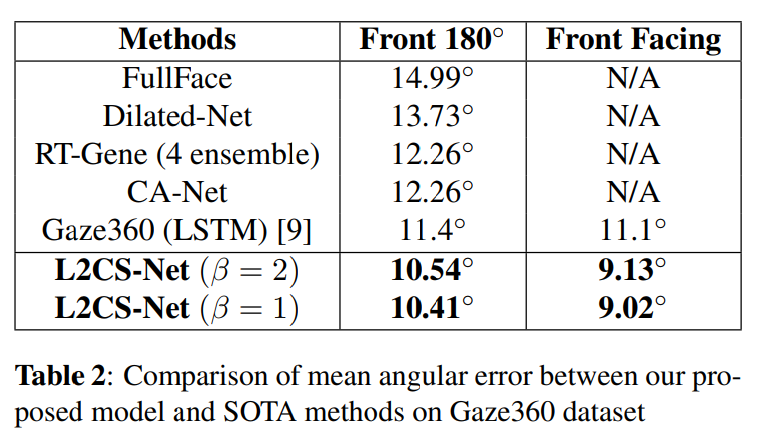

Gaze360 데이터셋을 앞쪽 180°와 정면만을 사용하여 평가. 앞쪽 180°에서 10.41° 평균 각도 오차, 정면에서는 9.02° 평균 각도 오차로 SOTA

5. Conclusion

비제약 환경에서 3D 시선 방향을 예측하기 위한 견고한 CNN 기반 모델인 L2CS-Net을 제안한다. 각 시선 각도를 개별적으로 예측하기 위해 두 개의 fully-connected 레이어와 ResNet-50 백본을 사용한다. 회귀와 분류 손실의 조합인 두 개의 별도의 손실 함수를 사용하여 네트워크 학습을 개선한다.

MPIIGaze와 Gaze360와 같은 비제약 시선 데이터셋을 사용하여 네트워크를 검증하고 최상의 시선 정확도를 달성했다.