IR (Information Retrieval) 경진대회 회고

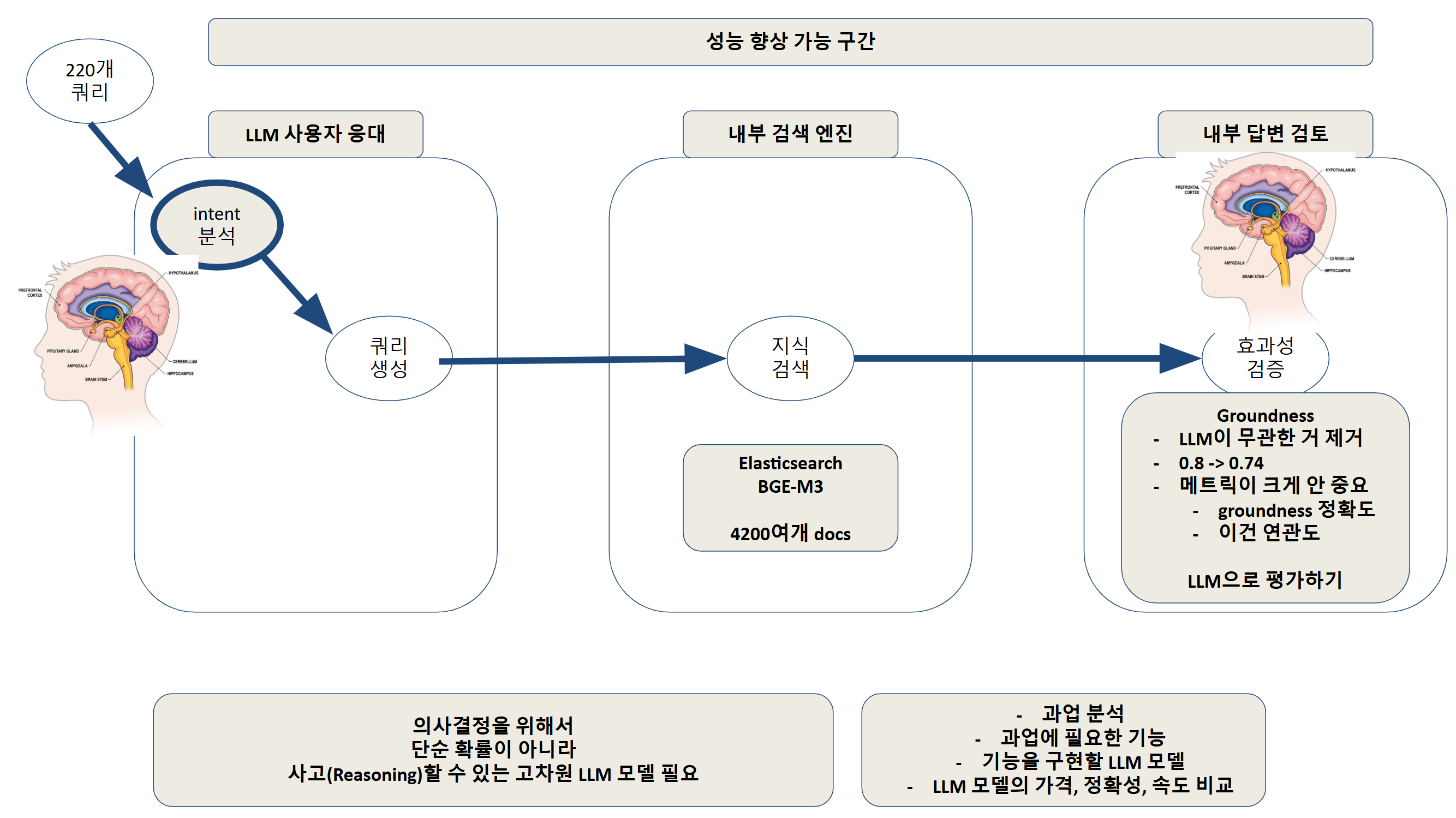

220개의 질문을 벡터화해서 4000여개의 지식문서에서 관련있는 것들만 뽑아오는 숙제

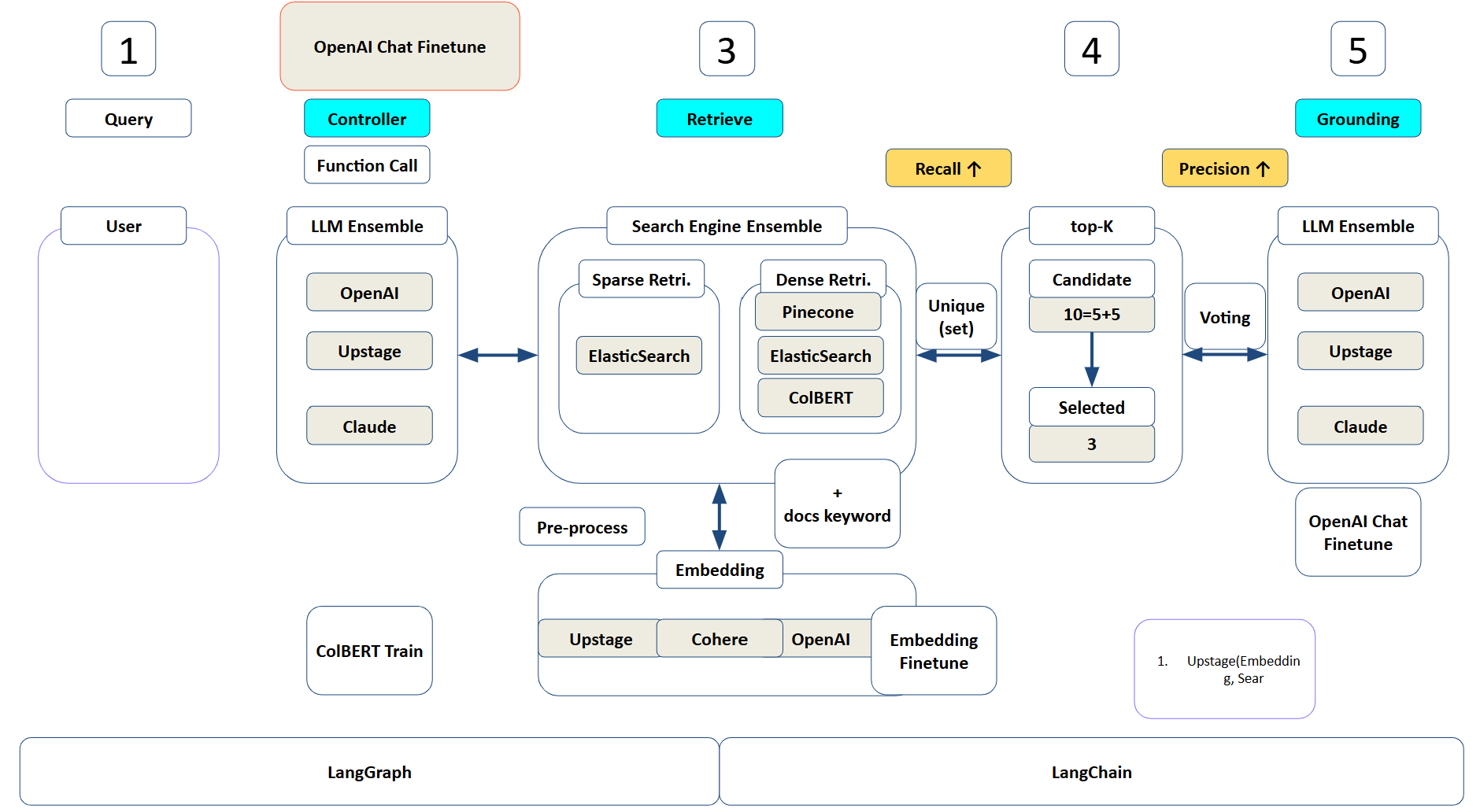

초기 설계도

처음에 강의 들을 때는 야심차게 시작을 했으나

막상 종결했을 때는 intent 분석 하나 해결하기도 벅찼다.

프로그램에게 단순히 어떤 일을 하는 건 너무 쉽고, 어찌보면 LLM이 필요없고,

여러번의 생각과 자기성찰을 거쳐서 정갈한 답변을 내놓지 못하고

엉성한 답변을 내놓는 것이 LLM의 약점이었다 Hallucination이라는 이상한 말로 마케팅으로 커버하려 하지만, 결국 내용을 파악하지 못하고, 이 단어 앞에 나올 다음 단어를 확률적으로 넣는다는 것이 약점이었다. 결국, LLM은 무슨말인지도 모르고 그냥 내뱉는다는 것이다.

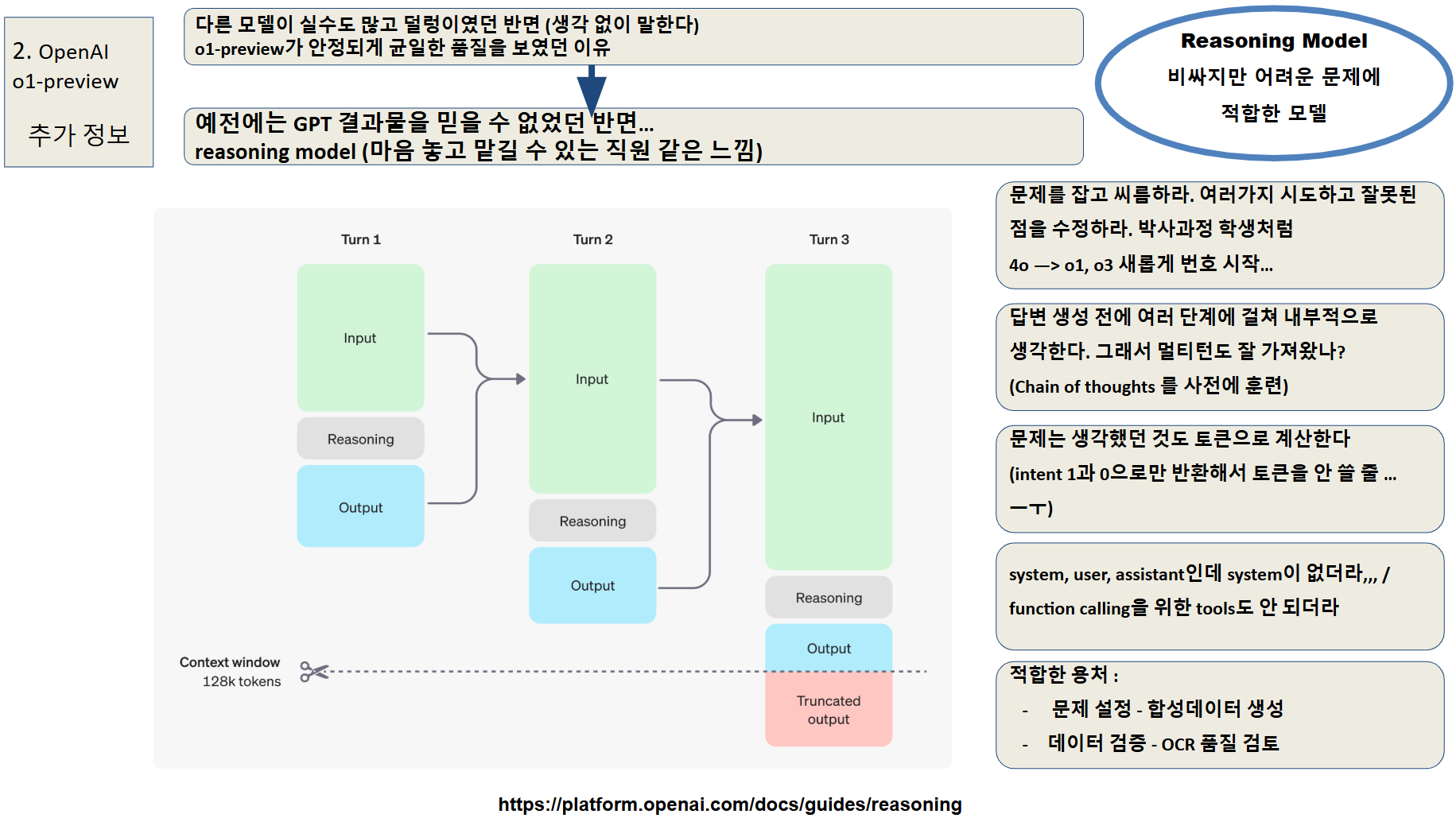

그래서 우리에게 필요한 것은 생각할 수 있는 reasoning model이었다!!!

OpenAI에서 GPT-4o같은 일반 모델을 Workhorse모델, o1, o3-mini 같은 모델을 reasoning 모델, 다시 말해서 "Planner"모델로 부른다는 것도 알았다.

intent를 분석하는 것은 ambiguous한 상황을 분석하여 결론을 도출하는 것으로 reasoning모델이 제일 잘하는 영역이라는 것이다.

결국 o1-preview 모델로 정확히 intent를 분석하게 되었다.

이후 쿼리 생성에서 약간의 성능향상 후에,

임베딩 모델 테스트, LLM as a judge 기능으로 결과 검증을 해보고 싶었지만 4일의 시간으로 할 수 없었다.

- 작성 내용(필수):

- 나는 내 학습목표를 달성하기 위해 무엇을 어떻게 했는가?

- 처음 리더보드에 제출하면서 경험한 intent 분석의 어려움을 해결하려고 노력했고, o1-preview라는 reasoning model을 사용하여 100% 가까운 수준으로 해결하였다

- 전과 비교해서, 내가 새롭게 시도한 변화는 무엇이고, 어떤 효과가 있었는가? (2번째 경진대회부터 해당)

- 이전 경진대회와는 달리 상업용 API 사용이 되어서, 현재 트렌드를 파악하며 가장 가성비가 최선이면서 본 문제해결에 적합한 모델을 찾아내었다.

- 마주한 한계는 무엇이며, 아쉬웠던 점은 무엇인가?

- 전체 성능향상 구간을 3개로 보았을 때 가장 핵심이 되는 RAG부분에 발을 들여놓지 못했다. Upstage, OpenAI 등 여러 임베딩 모델을 시도해보고 성능이 좋다는 ColBERT도 해보고 여러번 말을 들었던 Elasticsearch도 익혀보고 싶었지만, intent분석, LLM 분석에 깊이 빠져들어서 RAG까지 가보지 못했다.

- 한계/교훈을 바탕으로 다음 경진대회에서 시도해보고 싶은 점은 무엇인가?

- RAG, Embedding, 멀티모달 Embedding, LLM Cookbook을 사용하여 좀 더 풍성한 서비스 개발을 해보고 싶다.

- 나는 내 학습목표를 달성하기 위해 무엇을 어떻게 했는가?