📌과대적합

과대 적합

훈련 세트를 과도하게 학습해 훈련 세트에서는 정확도(손실)가 높고, 검증 세트에서는 정확도가 낮은 상황

과대 적합 이유?

- 매개 변수가 상당히 많음

- 학습 횟수에 제한이 없음

과대 적합 해결 방법

- 드롭 아웃

- 조기 종료

📍 드롭아웃

- 훈련과정에서 은닉층에 있는 뉴런을 무작위로 삭제해서 과대적합을 막는 방법

= 뉴런의 출력을 0으로 만들어 버린다. (=신호를 전달하지 않게 됨)

[학습 단계]

뉴런을 드롭아웃할 때는 뉴런의 50% 이상은 유지되어야 함

드롭아웃은 입력 계층과 은닉 계층에 적용

이 뉴런을 얼마나 삭제 할 것인가? = 하이퍼파라미터로 조정

[추론 단계]

- 뉴런을 드롭아웃 하지 않고 훈련 과정에서 확률적으로 생성했던 다양한 모델의 평균을 예측 해야함

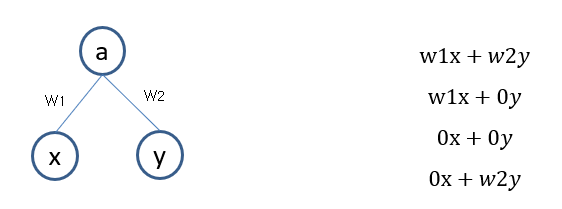

Ex) 입력 뉴런이 2개, 출력 뉴런이 1개인 신경망에 뉴런을 유지할 확률 p=0.5로 드롭아웃을 적용

각 모델이 생성될 확률은 1/4 이므로 네 모델의 평균을 계산하면

드롭아웃을 하지 않은 전체모델의 출력 (w1x+𝑤2𝑦)과 뉴런 유지 확률 p의 곱으로 표현됨