[AI Math] 확률론

딥러닝에서 확률론이 필요한 이유

딥러닝은 확률론 기반의 기계학습 이론에 바탕을 둔다.

기계학습에서 사용하는 손실함수들의 작동 원리는 데이터 공간을 통계적으로 해석해서 유도하게 된다.

ex-

회귀 분석에서 손실함수로 사용하는 L2 Norm은 예측오차의 분산을 가장 최소화하는 방향으로 학습하도록 유도한다.

분류 문제에서 사용하는 교차엔트로피(다음에 설명)는 모델 예측의 불확실성을 최소화하는 방향으로 학습하도록 유도한다.

분산과 불확실성을 최소화하기 위해서는 통계학에서 제공하는 측정법 을 알아야 함.

확률분포

확률변수는 확률분포에 따라 이산형과 연속형 확률변수로 구분된다.

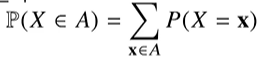

이산형 확률분포

확률변수가 가질 수 있는 경우의 수를 모두 합하여 모델링한다.

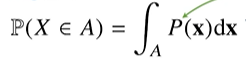

연속형 확률분포

데이터 공간에 정의된 확률변수의 밀도 위에서의 적분을 통해 모델링한다.

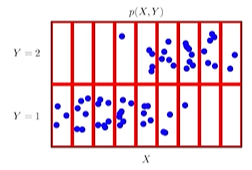

결합분포 P(x, y)

데이터 공간을 모델링함

주변확률분포 P(x)

y에 대한 정보를 주진 않는다.

조건부확률분포 P(x|y) ⭐

입력 x와 출력 y 사이의 관계를 모델링함

P(x|y) = 입력변수 y에 대해 정답이 x일 확률

연속확률분포인 경우에 P는 확률밀도함수임에 주의

로지스틱 회귀에서 사용했던 선형모델과 소프트맥스 함수의 결합은

데이터에서 추출된 패턴을 기반으로 확률을 해석하는데 사용된다.

회귀 문제의 경우 연속형 확률분포에 가까우므로 조건부 확률밀도함수를 사용한다.

회귀문제에서는 L2 Norm을 최소화하는 방향으로 해결하는데,.....아 무슨소린지 이해가 안댄다 ㅜㅡㅜ

딥러닝은 다층신경망을 이용해서 데이터로부터 특징패턴을 추출한다.

특징패턴을 학습하기 위해 어떤 Loss Func를 사용할지는 기계학습 문제와 모델에 의해 결정된다.