-

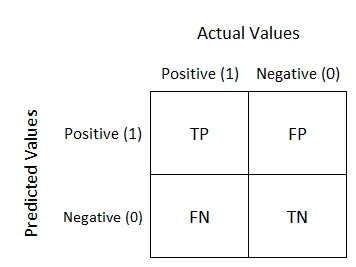

정확도 (Accuracy) :

-

정밀도 (Precision) :

모델이 Positive로 예측한 샘플 중 실제로 Positive인 샘플의 비율을 나타내는 지표 -

재현율 (Recall) :

실제로 Positive인 샘플 중 모델이 정확하게 Positive로 예측한 샘플의 비율을 나타내는 지표 -

F1 점수 (F1 Score) :

정밀도와 재현율의 조화 평균으로 계산되는 지표 -

ROC Curve :

ROC 곡선은 이진 분류 모델에서 임계값을 변화시키면서 True Positive Rate (재현율 또는 민감도)와 False Positive Rate (1 - 특이도)를 나타내는 곡선 -

AUC :

AUC는 ROC 곡선 아래의 면적을 나타내는 값으로, 분류 모델의 성능을 단일한 숫자로 요약

AUC 값은 0과 1 사이의 값을 가지며, 1에 가까울수록 좋은 분류 모델의 성능을 나타낸다. AUC가 0.5에 가까울 경우 모델의 분류 성능이 랜덤 수준에 가깝다는 의미이고, AUC가 1에 가까워질수록 분류 모델의 성능이 더 좋아진다.

✓ 다중 클래스 분류 모델에서도 One-vs-One ( 'ovo' ) 또는 One-vs-Rest ( 'ovr' ) 방식으로 각 클래스에 대한 ROC 곡선과 AUC를 계산할 수 있다.