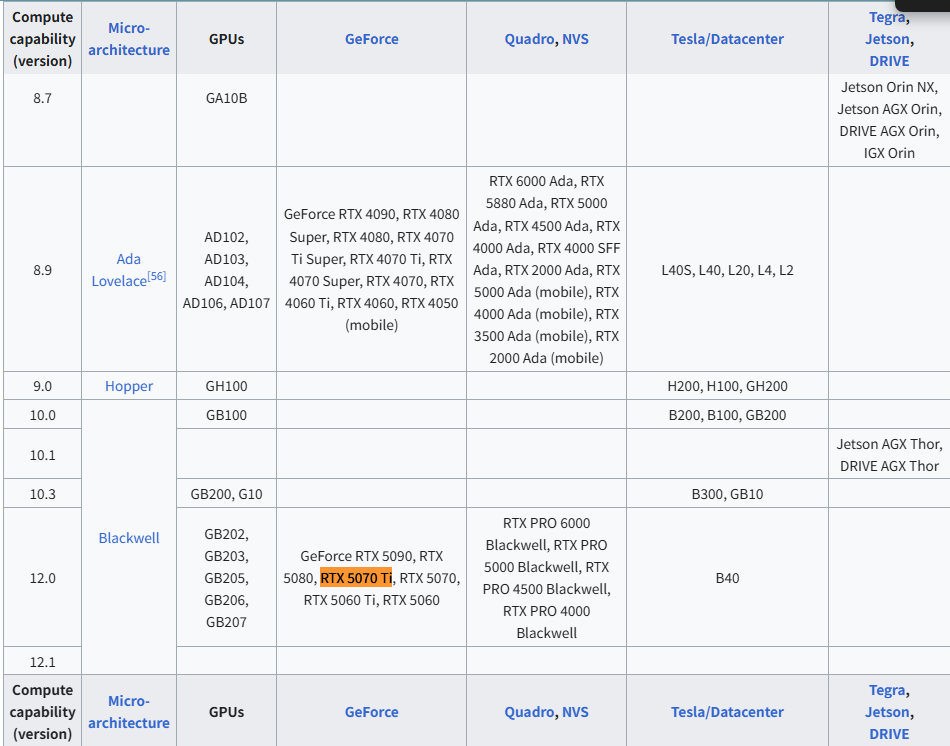

0. Using GPU Info

RTX 5070 TI

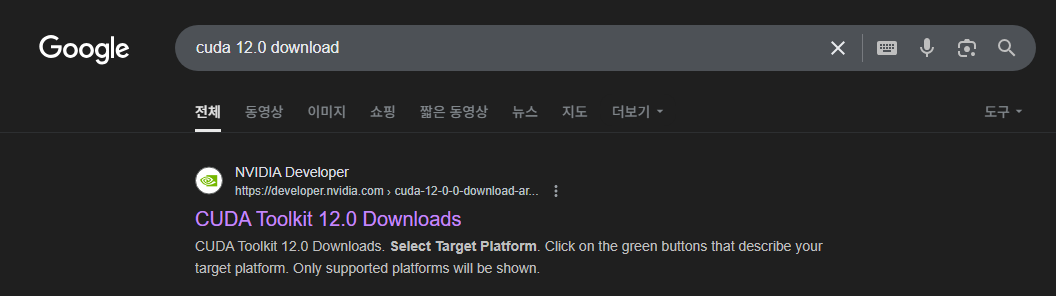

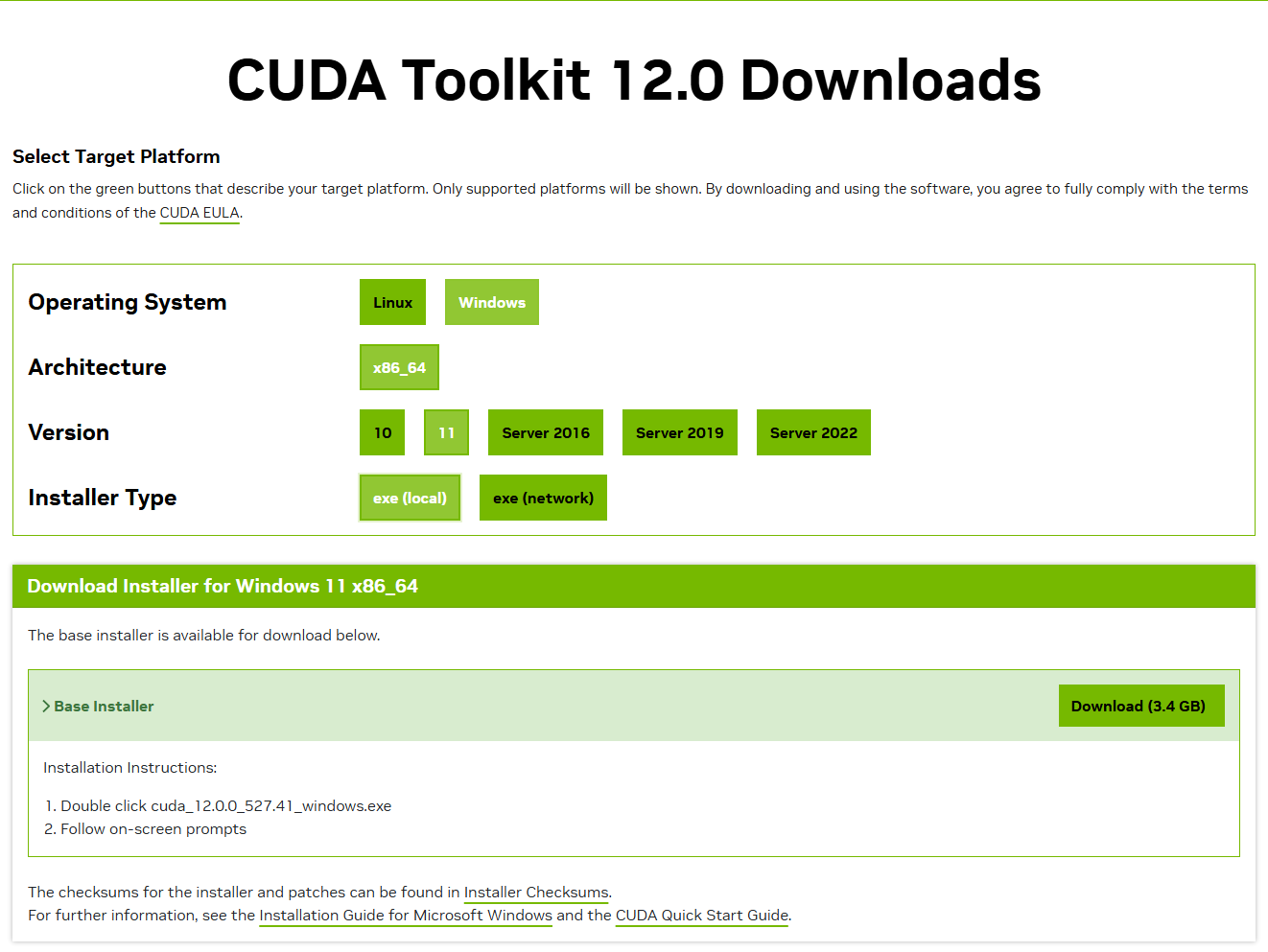

1. CUDA Download

https://en.wikipedia.org/wiki/CUDA?utm_source=pytorchkr&ref=pytorchkr#GPUs_supported

1. 위사이트에서 사용중인 GPU에 맞는 CUDA를 확인

ex) RTX 5070 TI → v12.0

2.구글에 cuda x.x download 검색 후 다운로드 후 실행 (NVIDIA 계정 필요)

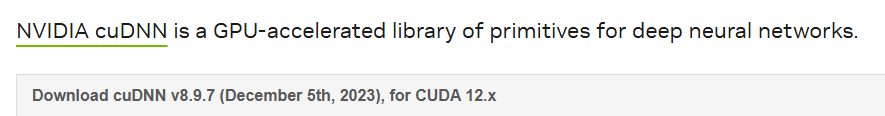

2. cuDNN Download

https://developer.nvidia.com/rdp/cudnn-archive?utm_source=pytorchkr&ref=pytorchkr

1. 다운받은 CUDA 버전과 동일한 버전의 cuDNN 다운로드

ex) CUDA: 12.0 → cuDNN for CUDA 12.x

3. cuDNN

1-2에서 CUDA를 다운 받으면

"C:\Program Files\NVIDIA GPU Computing Toolkit”디렉토리가 생기는데

해당 디렉토리에서C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.0안에

다운받은 cuDNN를 압축 해제 후 복사 해서 넣어준다

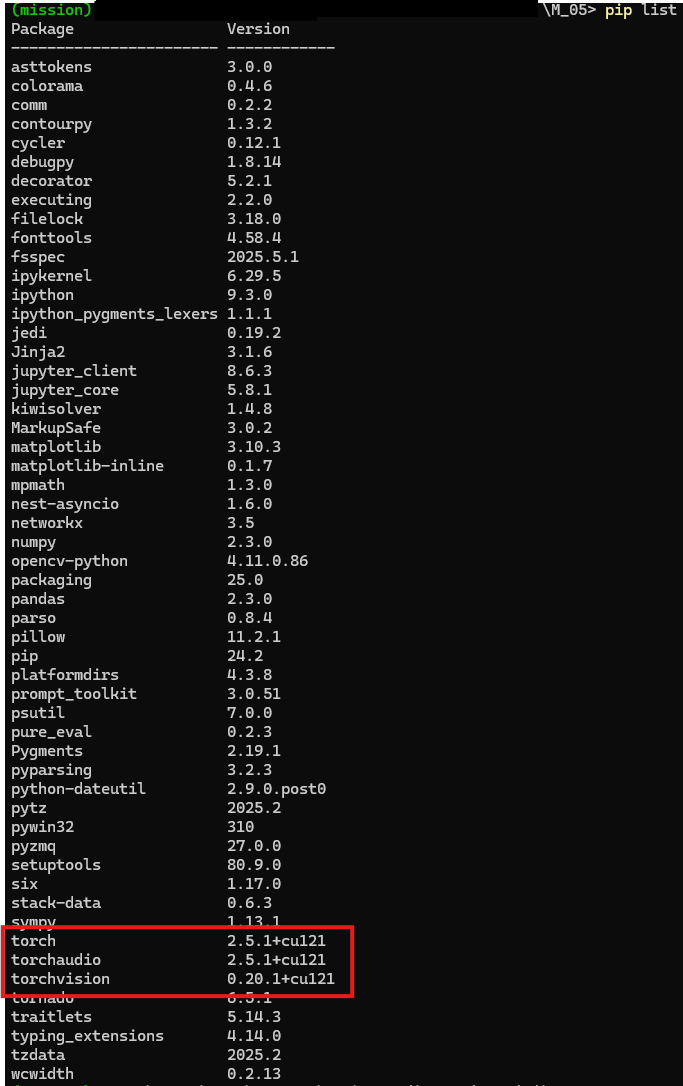

4. torch, torchvision CUDA와 동일한 버전으로 패키지 설치

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121cu121 → CUDA 12.1 버전을 의미하지만

범위 제한 문제가 생길 가능성이 있어서 상위 버전으로 패키지 설치 진행

5. 결과 확인

# device = "cuda" if torch.cuda.is_available() else "cpu"

# print(f"Using {device} device")

# print(torch.__version__)

# print(torch.version.cuda) # None이면 CPU 전용

# print(torch.backends.cudnn.version()) # cuDNN 연결 여부

# print(torch.cuda.is_available()) # False이면 GPU 인식 못함

print(torch.cuda.is_available())

if torch.cuda.is_available():

for i in range(torch.cuda.device_count()):

print(f"{i}: {torch.cuda.get_device_name(i)}")

else:

print("CUDA is not available")출력 결과

True

0: NVIDIA GeForce RTX 5070 Ti