[논문 리뷰] ReAct: Synergizing Reasoning and Acting in Language Models

목차

1. 개요

2.

안녕하세요. 오늘은 AI(LLM)을 응용하는 서비스를 현업에서 개발하다가, 실제로 쓰게 된 Agent패턴이 있어서 핵심 아이디어의 근간이 되는 논문을 가져와 보았습니다. 꽤 시간이 지난 논문이지만 2022년 10월에 구글이 발표했던, 그러나 현재 MCP를 통해 구조화된 Agent에서도 사용되고 있는 패턴인 ReAct 패턴에 대해서 살펴보겠습니다.

1. 개요

“ReAct: Synergizing Reasoning and Acting in Language Models”는 Princeton University의 Shunyu Yao와 Google Research Brain Team에서 공동으로 진행한 연구입니다. 2022년 10월에 처음 발표되어 2023년 ICLR에서 Notable Top 5% 논문으로 선정된 이 연구는, 현재까지도 AI 에이전트 설계의 핵심 패러다임으로 자리잡고 있습니다.

핵심 기여도 및 연구 동기

그렇다면 이 논문은 왜 만들어진 걸까요? 정말 필요한 것이었을까요?

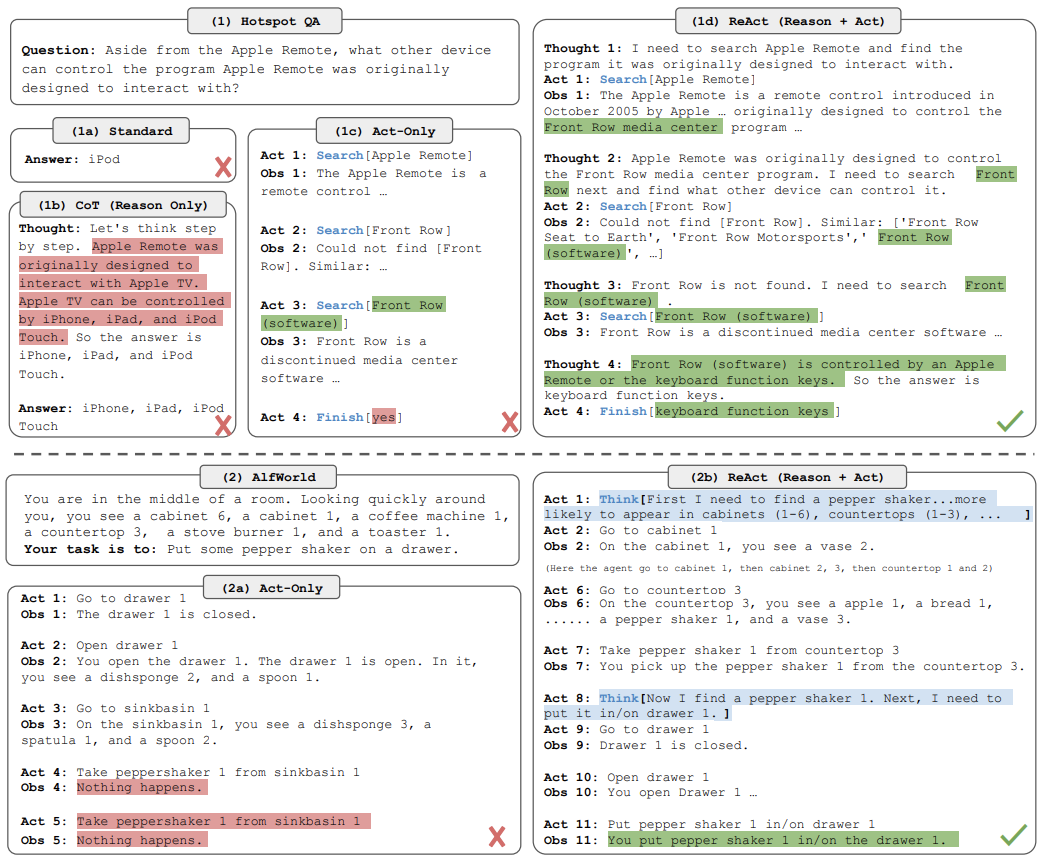

기존 대형 언어 모델들은 추론(reasoning)과 행동(acting) 능력을 각각 따로 연구해왔습니다. Chain-of-Thought 같은 추론 방법은 모델 내부 지식만으로 답을 생성하다 보니 환각(hallucination)과 오류 전파(error propagation) 문제가 있었고, 반대로 행동만 하는 방법들은 추상적 추론이나 장기 계획 능력이 부족했습니다.

기존 방법론의 한계점

Chain-of-Thought 방식의 가장 큰 문제는 외부 세계와 단절되어 있다는 것입니다. 모델이 자신의 내부 지식만으로 추론하다 보니 사실과 다른 정보를 생성하거나, 한 번 잘못된 추론이 시작되면 계속 틀린 방향으로 이어지는 오류 전파가 발생했습니다.

2. ReAct 방법론

핵심 개념: Reasoning + Acting 시너지

ReAct의 핵심은 간단합니다. 추론과 행동을 번갈아가며 수행하는 것이죠. 마치 사람이 문제를 해결할 때 ‘생각하고-행동하고-결과를 보고-다시 생각하는’ 과정과 유사합니다.

이런 방식으로 추론 과정은 행동 계획을 세우고 예외 상황을 처리하는 데 도움을 주고, 행동은 외부 환경에서 새로운 정보를 가져와 추론을 더 정확하게 만듭니다.

Think-Act-Observe 순환 구조

ReAct의 작동 방식은 다음과 같은 형태를 따릅니다

Question: 사용자 질문

...반복 시작...

1. Thought: 현재 상황 분석 및 다음 계획

2. Action: 도구 사용 (예: Wikipedia 검색)

3. Observation: 도구 실행 결과

...1~3 반복...

Final Answer: 최종 답변이렇게 정리해보았듯이, ReAct는 그저 하나의 구조일 뿐입니다. 다만 앞으로 지대한 영향력을 끼칠 구조이죠.

외부 도구 활용 메커니즘

ReAct에서 가장 중요한 점은 외부 도구와의 상호작용입니다. Wikipedia API를 통한 정보 검색, 계산기를 통한 수학 연산 등 다양한 도구를 활용해 모델의 내부 지식 한계를 극복합니다.

3. 실험 및 결과

주요 벤치마크: HotpotQA, Fever, ALFWorld, WebShop

연구팀은 4개의 다양한 벤치마크에서 ReAct를 평가했습니다. 질문 답변(HotpotQA), 사실 검증(Fever), 텍스트 기반 게임(ALFWorld), 웹 페이지 내비게이션(WebShop)에서 모두 우수한 성능을 보였습니다.

연구 성과를 돋보이기 위해서인지 너무 편향된 결과를 보여주는 것 같기도 하지만, 실제로 ReAct 구조가 더 깊은 추론을 해낼 수 있는 것은 명백해보입니다. 그러한 능력을 인정받아 지금까지도 Re-Act-Obs 패턴이 살아남은 것이겠구요.

성능 개선 결과

구체적인 수치를 살펴보면 정말 놀라운 결과를 보여줍니다. HotpotQA에서 ReAct+CoT 조합은 35.1%의 정확도를 달성해 기존 최고 성능인 29.4%를 크게 앞섰습니다. Fever에서도 64.6%로 기존 최고인 60.9%를 넘어섰죠.

더욱 인상적인 것은 상호작용 의사결정 작업에서의 성과입니다.

상호 의사결정 작업이란, 사람처럼 여러 단계의 사고와 의사 결정을 반복하여 문제를 해결하는 과정입니다. ReAct라는 구조가 근본적으로 해결하고자 하는 작업이 이러한 일이며, 우리가 지금껏 단순하게 배열한 llm의 직렬 구조로는 해결하지 못하고 있던 것이기도 하죠.

ALFWorld에서는 71% 성공률을 달성해 기존 최고 45% 대비 무려 34%나 향상되었고, WebShop에서도 40% 성공률로 기존 30.1% 대비 10% 절대 향상을 보였습니다.

기존 방법 대비 우수성 입증

특히 주목할 점은 ReAct가 단 1-2개의 예시만으로도 수천 개의 학습 데이터로 훈련된 모방 학습이나 강화학습 방법들을 능가했다는 것입니다. 이는 ReAct의 효율성과 범용성을 보여주는 강력한 증거입니다.

4. 주요 특징 및 장점

A. 환각 문제 해결

ReAct의 가장 큰 장점 중 하나는 환각 문제를 효과적으로 해결한다는 것입니다. 외부 정보원과 상호작용하여 사실 기반의 답변을 생성할 수 있기 때문입니다.

B. 해석 가능성 및 제어 가능성

ReAct는 추론 과정이 명시적으로 드러나므로 사람이 쉽게 이해하고 제어할 수 있습니다. 각 단계에서 모델이 어떤 생각을 하고 어떤 행동을 취했는지 투명하게 볼 수 있어, 필요시 사람이 중간에 개입해 수정할 수도 있습니다.

C. 적은 예시로 높은 성능 달성

ReAct의 또 다른 강점은 few-shot 학습에서의 뛰어난 성능입니다. 복잡한 파인튜닝 없이도 몇 개의 예시만으로 우수한 결과를 얻을 수 있어 실용성이 매우 높습니다.

5. 한계점 및 향후 방향

현재 제약사항

물론 ReAct도 완벽하지는 않습니다. 프롬프팅 기반 접근법의 한계로 인해 추론과 행동 행위의 지원이 제한적이고, 반복적인 LLM 호출로 인한 높은 계산 비용이 발생할 수 있습니다.

최근 연구에서는 ReAct의 성능이 예시와 쿼리 간 유사성에 크게 의존한다는 비판도 제기되고 있습니다. 따라서 저희 개발팀은 이를 보완하기 위해 planning Agent를 맨 처음에 배치하여, Planning Agent가 Task를 section으로 나누고, section 별로 reasoning모델과 base모델이 붙어서 reason-act-observe를 반복합니다.

(물론 이로 인해 토큰 비용이 올라간 것은 어쩔 수 없는 사실입니다 ㅜ)

개선 가능성 및 확장 방향

연구팀은 이미 파인튜닝을 통한 개선 가능성을 보여주었고, 대규모 멀티태스크 훈련과 강화학습과의 결합 등 다양한 확장 방향을 제시했습니다.

이런 확장성이 MCP를 만나며 더욱 빛을 발한게 아닐까 싶습니다. MCP로 프로토콜이 정리되면서 다른 사람이 만든 Agent, 또는 Tool을 가져와서 응용할 수 있는 시대가 되었는데, 이를 통해서 llm이 더 높은 정확성과 답변의 다양성을 확보할 수 있게 해줍니다. 이 ReAct은 더욱 진화하여 Deep Research 같은 기능이 되었고, 진화되어 만들어진 여러 패턴 중 비용과 성능의 적절한 trade-off를 따져가며 선택할 수 있는 부분이 개발자에겐 매우 효과적인 옵션으로 작용할 수 있습니다.

6. 결론 및 평가

논문의 의의 및 영향

ReAct 논문은 AI 에이전트 연구에 새로운 패러다임을 제시했습니다. 추론과 행동의 시너지라는 직관적이면서도 강력한 아이디어를 통해 기존 방법들의 한계를 극복했고, 이후 수많은 AI 에이전트 시스템의 기반이 되었습니다.

AI 에이전트 연구에 미친 기여

현재 LangChain, LangGraph 등 주요 AI 프레임워크에서 ReAct 패턴을 기본적으로 지원하고 있으며, AutoGPT, BabyAGI 같은 자율 에이전트들도 ReAct의 아이디어를 기반으로 구현되고 있습니다. 이는 ReAct가 단순한 연구 결과를 넘어 실제 산업에 미친 영향의 크기를 보여줍니다.

마무리하며

MCP로 인해 AI Agent의 구조가 비교적 일관화되어서, 다른 사람이 만든 Agent를 가져와서 사용할 수 있는 시대가 왔습니다.

Agent란 대행자, 즉 하나의 작업을 해낼 수 있는 단위의 모듈을 뜻하죠. 이렇게 차곡차곡 Agent를 만들어서 붙이고, 발전시키다 보면 결국.

그들이 말하는 AGI(사람 같은 인공지능)은 아닐지어도, 그걸 흉내낼 수 있는 것은 만들어지지 않을까요? 그것도 아주 짧은 시간 안에 말이죠.

Agent의 비약적인 발전으로 인해 AI가 할 수 있는 일의 범위가 넓어지고 있습니다.

MS는 6000명을 해고하겠다고 밝혔고, KT는 2400명을 이미 해고했습니다.

내년에는 가정부를 대체하기 위한 옵티머스 3세대를, 보스턴 다이나믹스는 "더럽고 위험한 일"을 대신 해줄 Atlas 모델을 내년에 상용화할 것으로 보입니다.

AI에 대체되지 않을 나의 강점은 무엇인가?

한번은 고민해보시길 바라며 글을 마칩니다. 감사합니다.