elasticsearch sockettimeout

sockettimetout 30초짜리 나고,node개수만큼 돌면서 계속 timeout 나는 현상rest-cleint내에 node개수만큼 돌면서 쿼리를 날리고, 계속 sockettimeout발생하여 cpu증가하는 현상=> 결론은 sockettimeout과 search.t

Elasticsearch number_of_shard 기본값 변경 대응

기종 6점대 까지는, index 생성 시 num_of_shards를 지정하지 않으면기본 5개 였는데, 7점대부터 기본 1개로 변경되었다.기존 자동 생성되도록 만들어진 index들이 그럼 앞으로 shard 1개로 만들어지니, 이를 방지하기 위해 기존 사용되던 5개의 값들

KAFKA 데이터지우기

kafka 설정에 log.retention을 줄이고 한대씩 재기동log.retention.hours=1 log.retention.ms=1000

Elasticsearch reindex 여러 인덱스 한번에 할때는 index이름을 변경해야한다.

아래와 같이 쓰면, 모든 index들이 그대로 신규 clsuter로 이동한다. log-test-1 -> log-test2-1log-test-2 -> log-test2-2그런데 아래와 같이, index명을 유지하고자 하는 경우에는 의도와 다르게 log-test2 하나의

Elasticsearch auto rollover 적용

elasticsearch에서 자동으로 index를 rollover하는 방식에 대해 알아보자.주의할점은, rollover는 alias기준으로 수행되는것이지, index기준으로 수행되는것이 아니다. index는 rollover시마다 이름이 바뀌기 때문에, rollover시

Elasticsearch 기본 score 계산 방법

검색시 explain=true값을 인자로 넘기면, score가 어떻게 계산되었는지 자세히 설명해준다.아래 \_explanation부분을 보자.score값인 1.6962869는 details array에 있는 두개의 value의 곱이다.details.details0.

Elasticsearch 'mapper_parsing_exception'

Join field에 null이 들어가면 fail to parse exception이 남.

consumer startOffset 안먹는 현상

이렇게 해놔도 latest가 아닌 earlist부터 가져옴. group명을 지정하면 startOffset이 earlist로 세팅됨.그래서 그간 쌓인 몇십만개를 다 읽어오려고함.. @.@https://cloud.spring.io/spring-cloud-strea

MySQL binlog설정

mysql binlog설정위치binlog_formatbinlog 읽기 위한 권한GRANT REPLICATION SLAVE : Enable the user to ask where master or slave servers areREPLICATION CLIENT : En

LEVEL-DB

A fast and lightweight key-value DB library made by Googlekey-value : NO-SQLlightweight library : Embeded DB 웹 애플리케이션용 DB를 위해 만들었다.데이터를 로컬에 저장하기 때문에

2. java filter plugin 개발

로컬에 logstash 소스가 있어야만 filter plugin 빌드가 가능하다. logstash download빌드하기해당 위치에 jar가 생성되었는지 확인환경변수 설정filter - example downloadC:\\Users\\SDS.gradle\\gradle.

1. logstash설치 및 실행

kafka message -> logstash -> ES에 넣어만 보기kafka-client 버전확인.kafka-input-plugin과 output-plugin이 integration으로 합쳐졌다고한다.아래 들어가면 kafka-client버전을 확인 할 수 있음..

0. LOG TO ES 전환

기존 audit_log를 kafka message로 쏘고 cassandra로 넣고있는데, cassandra가 조회가 이런저런 요건에 맡게 조회 하기가 힘들고, 활용도가 낮아(카산드라도 물론 설계를 잘 하면 되겠지만 현재는 그렇지 않다.) ES로 전환하기로 했다. 기존

maven import PKIX error

C:\\Program Files\\Java\\jdk1.8.0_251\\bin 으로 이동shift + 우클릭 > 여기서 cmd창 열기 (관리자모드로 실행)keytool -import -file "D:{인증서}" -keystore "C:\\Program Files\\Jav

Elasticsearch nested query : nested에 should와 must를 함께 쓰는 경우 inner_hit 안맞는 이슈

이번에 개발하다가 이상한 점을 발견했다.기존 should로만 구성된 nested query에 필수 조건이 붙어 must를 추가로 넣었는데, 쿼리는 잘 되는 듯 보였으나, inner_hit이 제대로 나오지 않는 현상이다. 쿼리의 결과는 제대로 나오고 있어서 제대로 되고있

moment().utcOffset()

이런 코드를 쓴 게 있었다..알고보니 아래 코드는 모두 같음utcOffset은 시간대를 어디로 표시할지에 대한 것이지 시간 값 자체를 바꿔주는 것이 아니다.

flume source NPE

root.logger를 debug로 바꾸니 아래와 같은 에러가 발생했다.에러를 따라가다보니 kafkaSource.class에서 log level이 debug일때만 실행되는 소스가 있는데incrementKafkaEmptyCount를 할때 를 하는데, increment시에

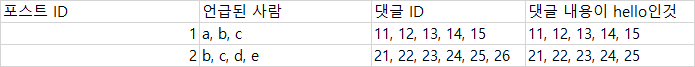

Elasticsearch join 관계에서 조건에 맞는 children count를 세는 composite aggregation

매핑은 아래와 같다post의 자식으로 comment가있고, post에는 언급된 사람들이 배열로 있다.(7버전 아래에서는 mappings 하위에 \_doc으로 감싸줘야함.)데이터 구분을 위해 모든 댓글의 내용(comment.content)는 "hello"이고, 26번만