💡 Comparative Study of CNN and RNN for Natural Language Processing_논문 리뷰

📌 Introduction

핵심적인 DNN 아키텍처로는 합성곱 신경망(CNN)과 순환 신경망(RNN) 두 가지 유형이 있다.

NLP task에서 둘 중 어떤 것을 선택해야하는지 명확하지 않다. 이전 연구들에선 일부 NLP task에 대해 성능 비교를 중점적으로 다루었고 체계적인 비교가 부족했다. 본 연구에선 CNNs, GRUs 및 LSTMs를 다양한 NLP 작업에 대해 체계적으로 비교한다.

- CNNs와 RNNs의 상호 보완성

- 하이퍼파라미터의 영향

📌 Experiments

-

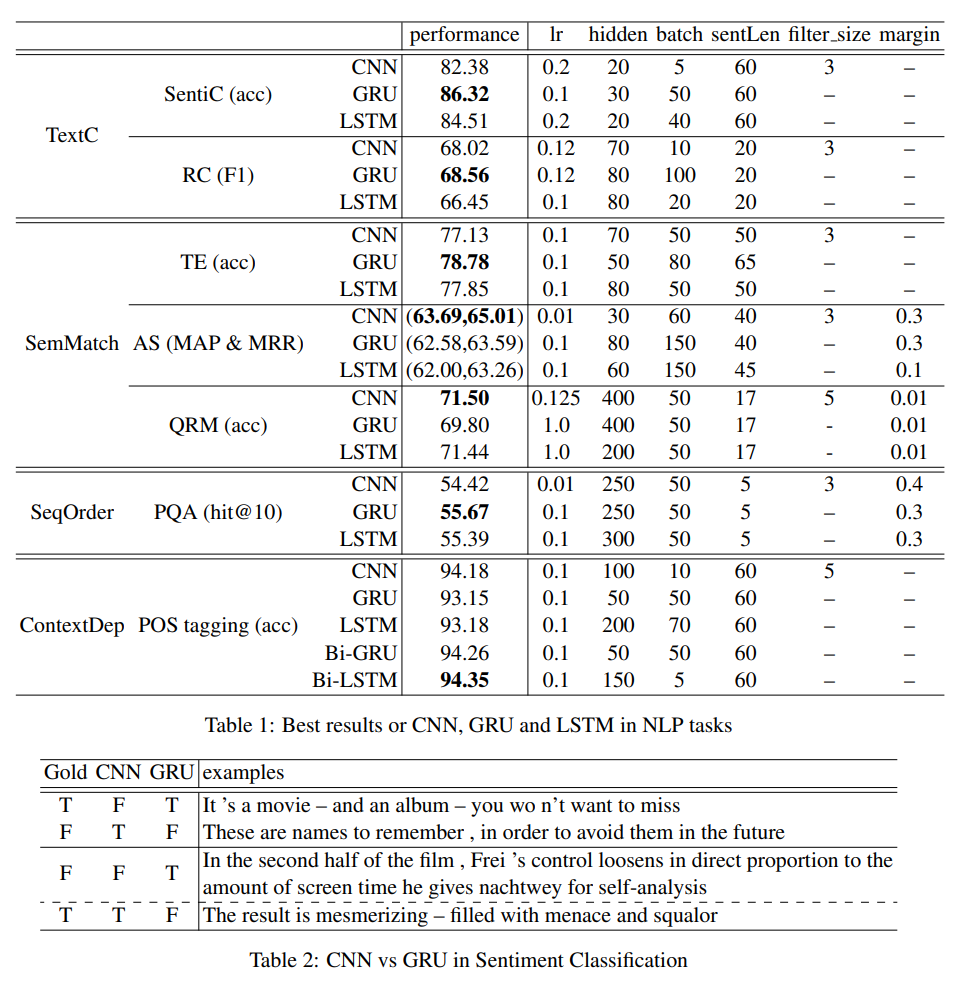

TextC : RNNs가 순서 정보 (PQA) 및 장거리 문맥 종속성 (POS 태깅)을 적절하게 인코딩하는데 적합

- GRU는 SentiC에서 가장 좋은 성능을 보이며 RC에서는 CNN과 유사한 성능

- RNNs는 PQA (SeqOrder) 작업과 POS 태깅 (ContextDep) 작업에서 CNN보다 우수한 결과

-

SemMatch : 전체 문장의 이해가 중요, textual entailment 작업에 더 적합

- CNN은 AS와 QRM에서 가장 좋은 성능, TE에서는 GRU와 LSTM이 CNN을 앞지름

-

SentiC : GRU가 CNN보다 우수, AS 작업에서는 CNN이 우위

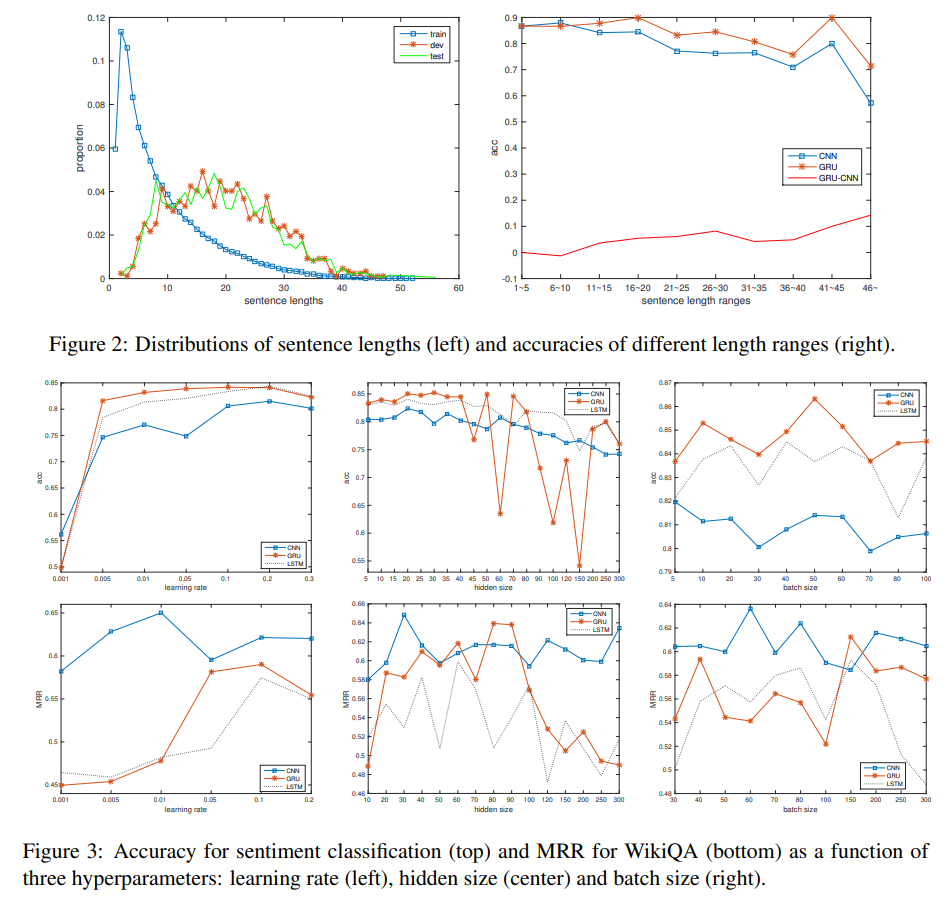

- 학습률을 변경해도 비교적 안정적인 성능

- 그러나 은닉 크기와 배치 크기를 조정하면 성능에 큰 변동

전체적인/장거리 의미 이해가 자주 필요한 경우에는 RNNs가 더 효과적

지역적이고 위치 무관한 특성을 추출하는데 강점을 가진 CNNs는 TextC 작업에서 더 좋은 결과

📌 Conclusion

- RNNs가 다양한 NLP 작업에서 강력하고 견고한 성능을 보임

특히, 키워드 인식 (keyphrase recognition) 작업인 일부 감정 감지 및 질문-답변 일치 작업을 제외하고 RNNs가 우수한 결과 - 은닉 크기와 배치 크기가 DNN의 성능에 큰 변동 -> 해당 매개변수의 최적화가 성능 향상에 중요함