[TIL] 20210222_Active function 필요성

배운점

- 딥러닝이란?

- deep neural network를 통해 학습하는 것을 말한다.

- 보통 layer의 개수가 3개보다 많을 때 심층 신경망(deep network)라고하며 보다 복잡한 문제를 풀수있다.

- 딥러닝에서 비선형 함수의 필요성

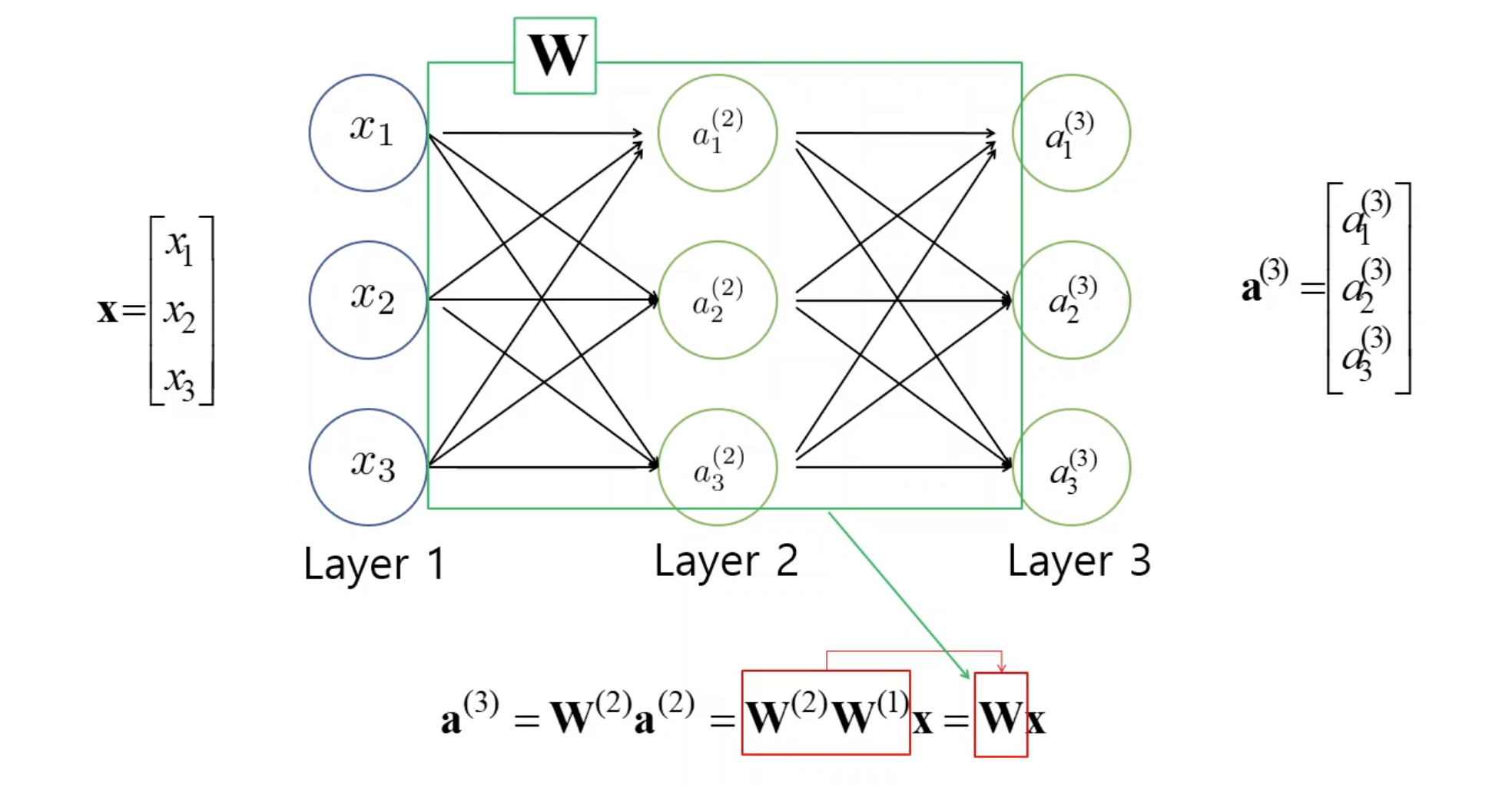

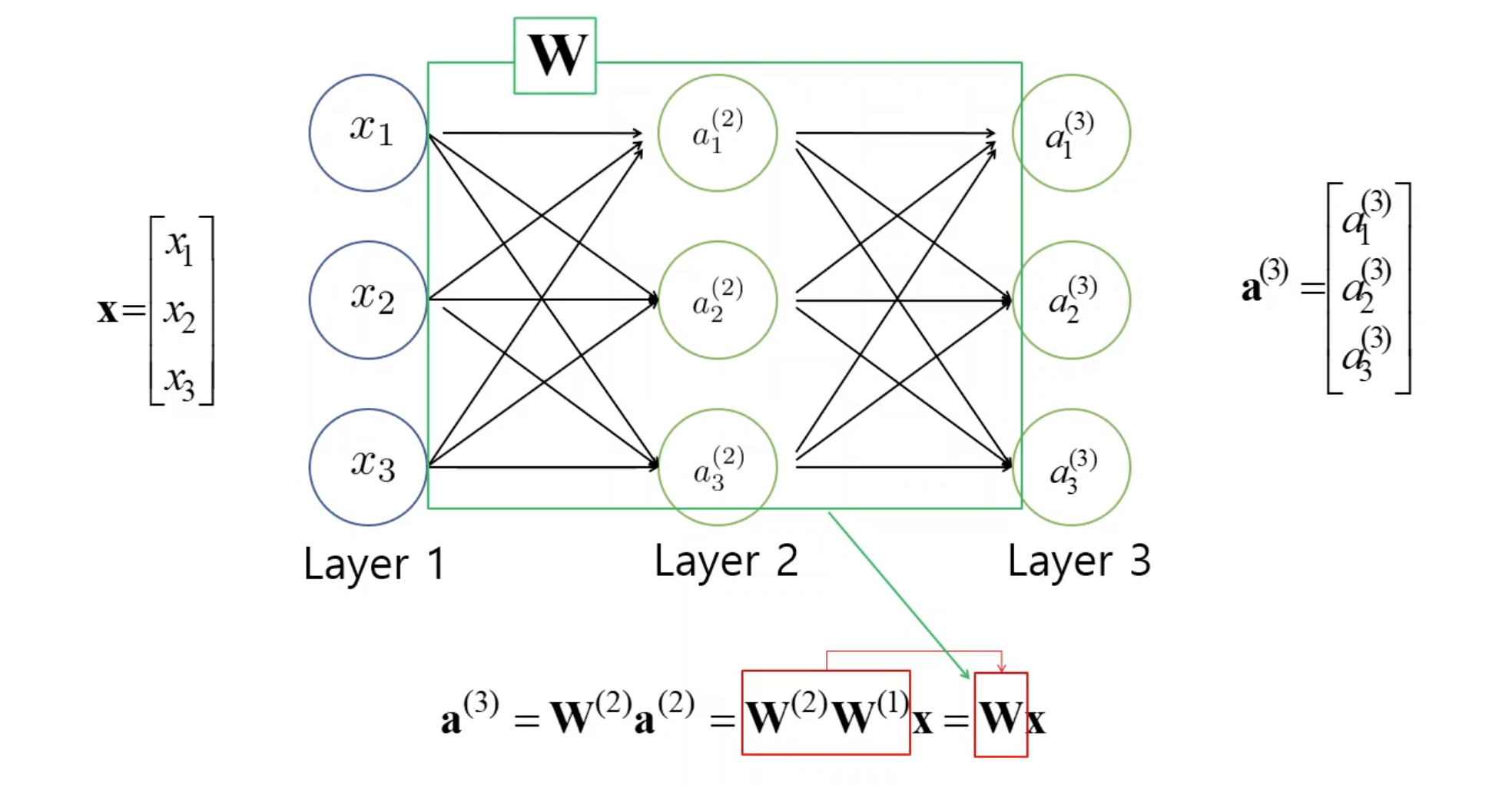

- 아래그림처럼 각 layer는 가중치 행렬(W)과 입력 벡터(X 또는 a)의 선형곱으로 나타내어질 수 있다.

따라서 비선형함수가 없다면 아무리 layer가 많아도 결국에 전체 모델은 선형모델이 되어 딥러닝이라고 볼 수가 없고 복잡한 문제를 설명하기위한 한계가 존재한다. 이런한 비선형 함수를 활성함수(Activation function : ReLU, sigmoid, tanh 등)라고하며 보통 각 layer마다 추가해준다.

- 전이학습

- 사전학습(pre-trained)된 모델, 가중치를 그대로 사용하는 것

- 전이학습의 유형으로는 1.Feature Extractor와 2.Classifier 모두 학습된 것을 사용하는 경우와 이 두 부분을 부분적으로만 사용하고 나머지는 fine-tuning 하는 경우가 있다.

- 학습할 때 데이터의 비율

- 예를들어 강아지냐 고양이냐를 분류하는 문제라고할 때, 실제 데이터에서 각 이미지의 갯수가 7:3 라고해서 학습할 때도 그 비율 그대로 진행해서는 안된다. 학습할 때에는 비율을 동일하게 해주어야 결과가 제대로 나온다. 만약 실제 데이터 비율로 학습을 시킨다면 높은 비율인 7쪽의 동물로 분류하게될 확률이 높아진다.