📦 Progressive Neural Compression for Adaptive Image Offloading under Timing Constraints

RTCL

목록 보기

14/15

Motivation

- IoT 디바이스는 엣지 서버와 보통 저전력 무선 네트워크로 연결되어 있습니다.

- 그렇기에, 추론 정확도를 유지하면서 이미지를 압축하여 전송하는 것이 중요합니다.

- 또한 이런 시스템은 종종 품질 관리 카메라나 경비 시스템과 같이 시간적 제약을 요구합니다.

Requirements

본 논문에서는 네트워크가 허용하는 데이터 전송량을 고려하여 분류 성능을 최적화하는 "open-loop" 솔루션에 집중합니다.

- Classification Accuracy: 이미지 재구성이 아닌 분류 정확도를 목표로 해야합니다.

- Encoding Efficiency: 이미지를 압축할 떄, 리소스 제약 조건을 고려하여 최소한의 계산 오버헤드가 발생해야 합니다.

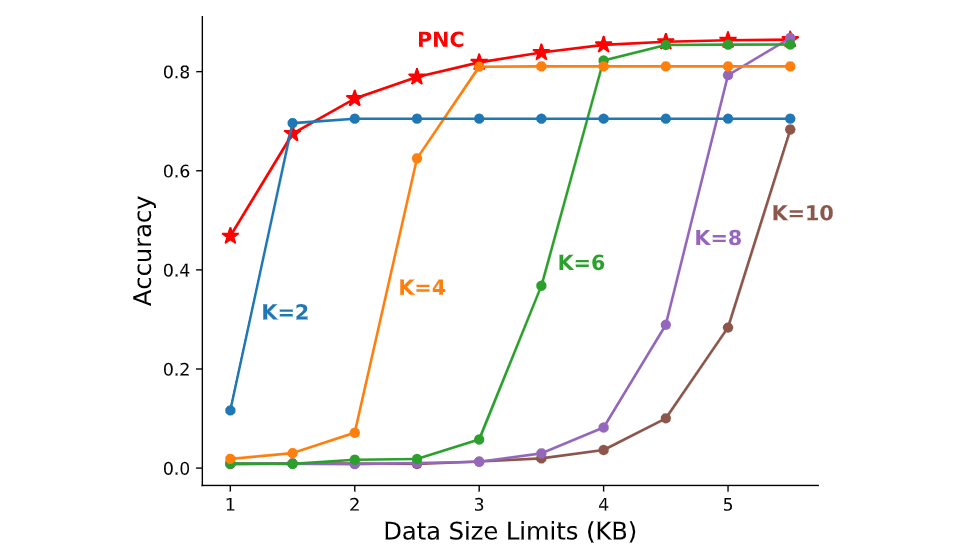

- Adaptation to different deadlines and varying bandwidth

: 대역폭이 감소하는 상황에서 우아한 성능 저하를 달성하면서 마감 기한까지 더 많은 데이터를 수신할수록 분류 정확도가 향상되어야 합니다.

Problem Formulation

- 이미지 시퀀스 는 초마다 찍힙니다.

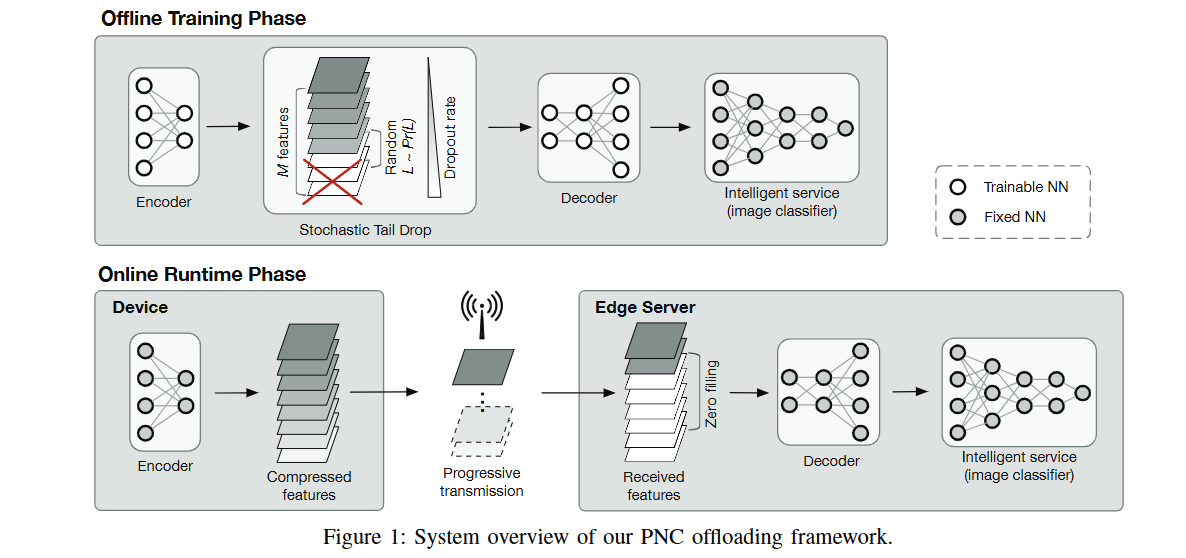

On-device Encoding

- 인코더 는 이미지 를 압축하여 벡터 로 변환합니다.

- 인코딩 지연은 로 정의됩니다.

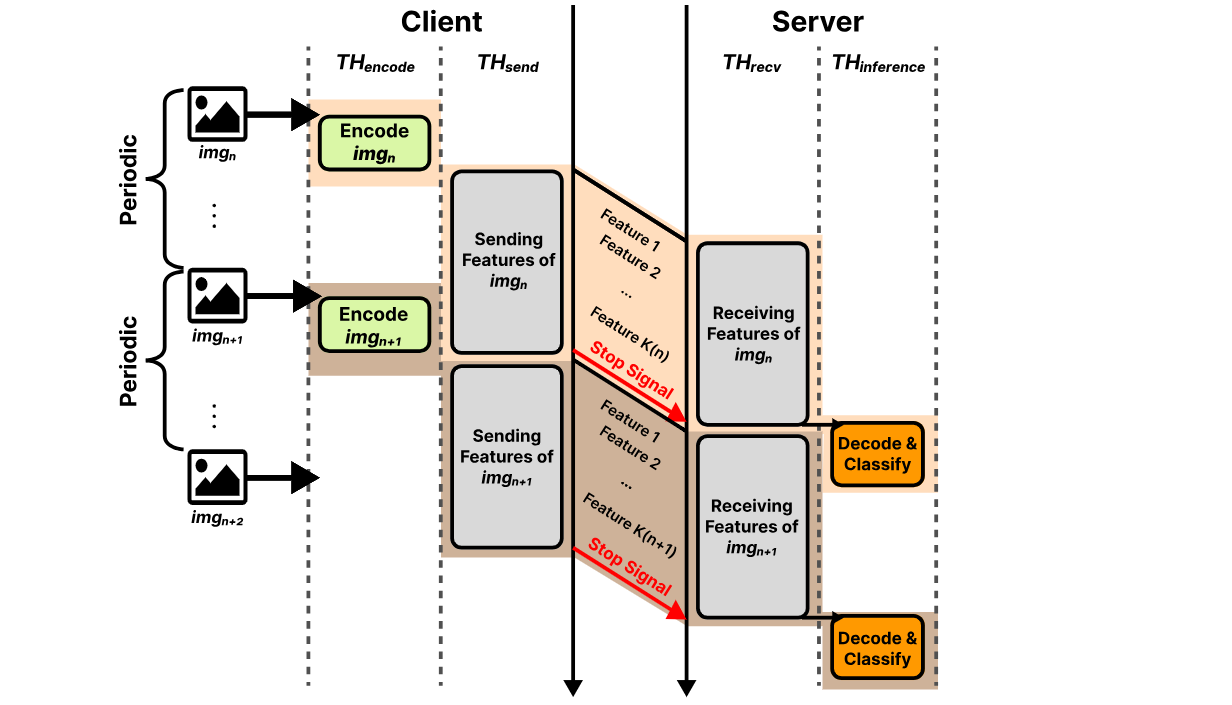

Network Offloading

- 다음 이미지가 인코딩될때까지 계속 이미지를 보낼 수 있다면, 데드라인 까지 를 전송할 수 있습니다.

- 네트워크 대역폭 에 대해 데드라인까지 보낼 수 있는 총량은 로 계산됩니다.

- 따라서, 실제 전송되는 데이터 는 다음과 같이 나타납니다.

Decoding and Classification

- 디코더 는 를 입력으로 받아 를 출력합니다.

- 가 분류기이고, 분류 결과과 라면, 추론 정확도 은 ground truth 에 대해 다음과 같이 정의됩니다.

Objectives

가변 대역폭 와 에 의해 부과되는 데드라인 제약 조건 하에서 정확도를 최대화하는 인코더 및 디코더의 학습 가능한 파라미터, 및 를 최적화하는 것입니다.

- 인코더는 분류를 위한 중요한 특징을 캡처하고 가장 중요한 특징을 먼저 전송한 다음 덜 중요한 특징을 전송해야 합니다.

- 디코더는 서버에 도착하는 불완전한 데이터를 처리하고 수신된 데이터 양을 고려하여 최상의 분류 정확도를 달성해야 합니다.

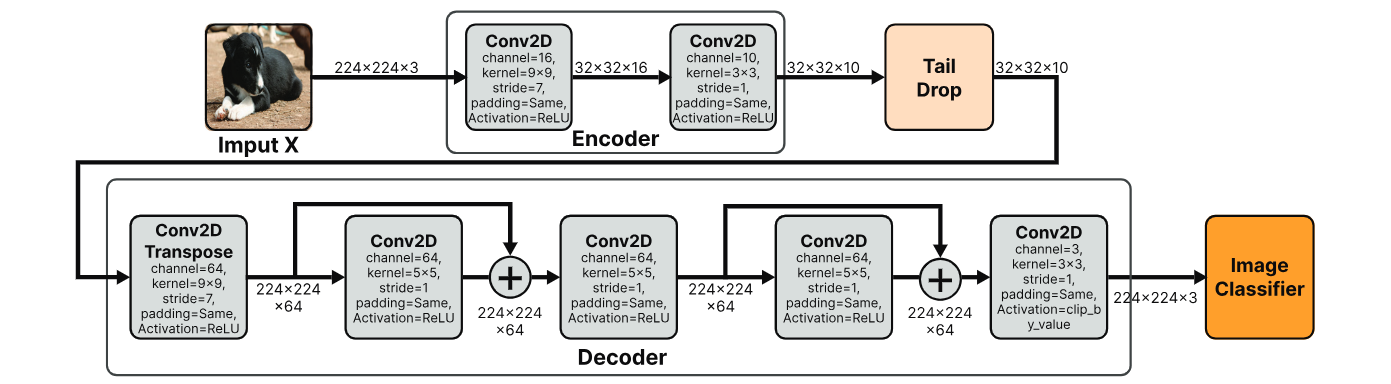

Design of PNC

Multi-objective Neural Compression

- 고정된 크기의 를 가정할 때, 목표는 다음을 만족하는 와 를 찾는 것입니다.

- 여기에서 은 이미지 재구성에 대한 손실함수를 의미합니다.

- 그러나, 이는 고정된 크기의 를 가정했을 때이므로, 우리는 다른 목적함수를 사용해야 합니다.

- 만약 개 채널만 수신했다면, 다음과 같은 목표를 세울 수 있습니다.

- 여기서 가능한 를 모두 고려한다면 다음과 같은 multi-objective 최적화 문제를 정의할 수 있습니다.

- 그러나 여기에 closed-form 해는 없습니다.

- 따라서 다양한 bottleneck 차원 간의 trade-off를 고려하여 가능한 한 Pareto frontier에 가까운 해를 찾아야 합니다.

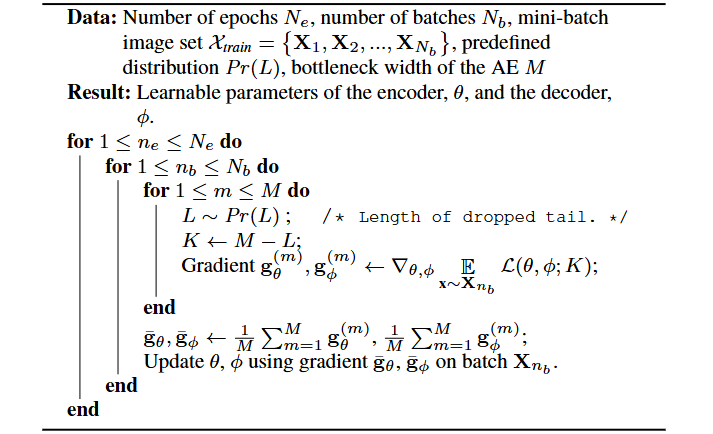

- 이는 최근 연구에서 제안된 "stochastic taildrop regularization"을 사용하여 해결할 수 있습니다.

Two-stage Offline Training

-

Unsupervised pretraining for image reconstruction

이 자기지도 학습단계는 AE 파라미터 가 잠재적인 대상 머신 러닝(ML) 서비스에 적응할 수 있는 일반화 가능한 상태로 준비합니다.

-

Knowledge Distillation for Inference

지식 증류 동안, 서비스 모델 는 파라미터가 고정된 블랙 박스로 취급되며, AE 파라미터인 와 만 업데이트됩니다.

Quantization and Huffman Coding

추가적인 압축을 위해, PNC는 다음과 같은 두 가지 방법을 사용합니다.

- Quantization

- Model Quantization: PNC는 모델 파라미터를 양자화하여 모델 크기를 줄입니다.

- Feature Quantization: PNC는 데이터의 0~255 값을 64개의 값으로 양자화합니다. 이는 데이터 크기를 3/4로 줄입니다.

여기까지 진행하면 224x224의 이미지가 약 0.75KB로 압축되며, 허프만 코딩을 통해 더 작은 크기로 압축할 수 있습니다.

- Huffman Coding

- PNC는 런타임에 양자화된 데이터를 추가로 압축하기 위해 허프만 코딩을 사용합니다.

- 이는 데이터의 빈도에 따라 가변 길이 코드를 할당하여 압축 효율을 높입니다.

Progressive Property of PNC

Image Offloading Architecture

Evaluation