abstract

LLM 의 파워를 leverage 할 수 있는 방식 세가지 소개

Intro

1) LLMSEQSIM - LLM을 통한 semantically rich embedding 제공, aggregate session embedding을 계산하고 비슷한 embedding을 가진 상품을 추천한다.

2) LLMSEQPROMPT - LLM을 prompt-completion pair 로 fine tuning 시킨다.

3) LLM2BERT4REC - 이미 존재하는 sequential model을 LLM 으로 부터 얻은 item embedding 으로 init 시키는 방식

3.1 LLMSEQSIM : Recommending semantically related items via LLM embeddings

- text-embedding-ada-002 model 사용

- item 카탈로그에서 이름을 query시켜 embedding을 얻음

- 각 product에 대한 embedding을 평균, weighted 평균 이런식으로 모아 session embedding을 만듦

- 각 item의 embedding 과 비교 (cosine sim, Euclidean, dot product) 해서 similarity 가 높은 item 추출

3.2 LLMSEQPROMPT : Prompt based recommendations by a fine tuned LLM

prompt 형태로 진행되고 있는 session 에 대한 정보를 준다. (domain knownledge injection)

prompt - completion(output) 쌍에 대한 fine tuning을 진행한다.

prompt 는 마지막 아이템을 제외한 아이템 들의 목록을 담고 있고 output은 마지막 item을 갖고 있다.

test 단계에서는 여러번 나타난 recommended item에 대한 confidence 가 높다고 판단 후 이 item embedding 과 가까운 dot product를 가지는 item을 추천한다.

generative model로서 존재하지 않는 아이템에 대한 추천이 있을 경우 위와 마찬가지로 dot product 가 가장 높은 item을 대신 추천한다.

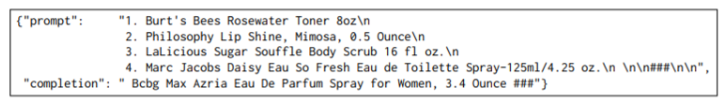

훈련 데이터 예시

3.3 LLM2BERT4REC : Recommending with an LLM-enhanced Sequential model

LLM 이 item을 semantically rich 하게 표현할 수 있다는 점을 이용해서 기존에 존재하는 sequential rec model 에 이의 도움을 받아보자하는 방식

BERT 의 item embedding 단을 LLM 의 embedding weight를 PCA 시켜서 줄인 결과로 대체 (initialize 시킴)

그 이후부터는 원래 BERT4REC 과 동일하게 훈련