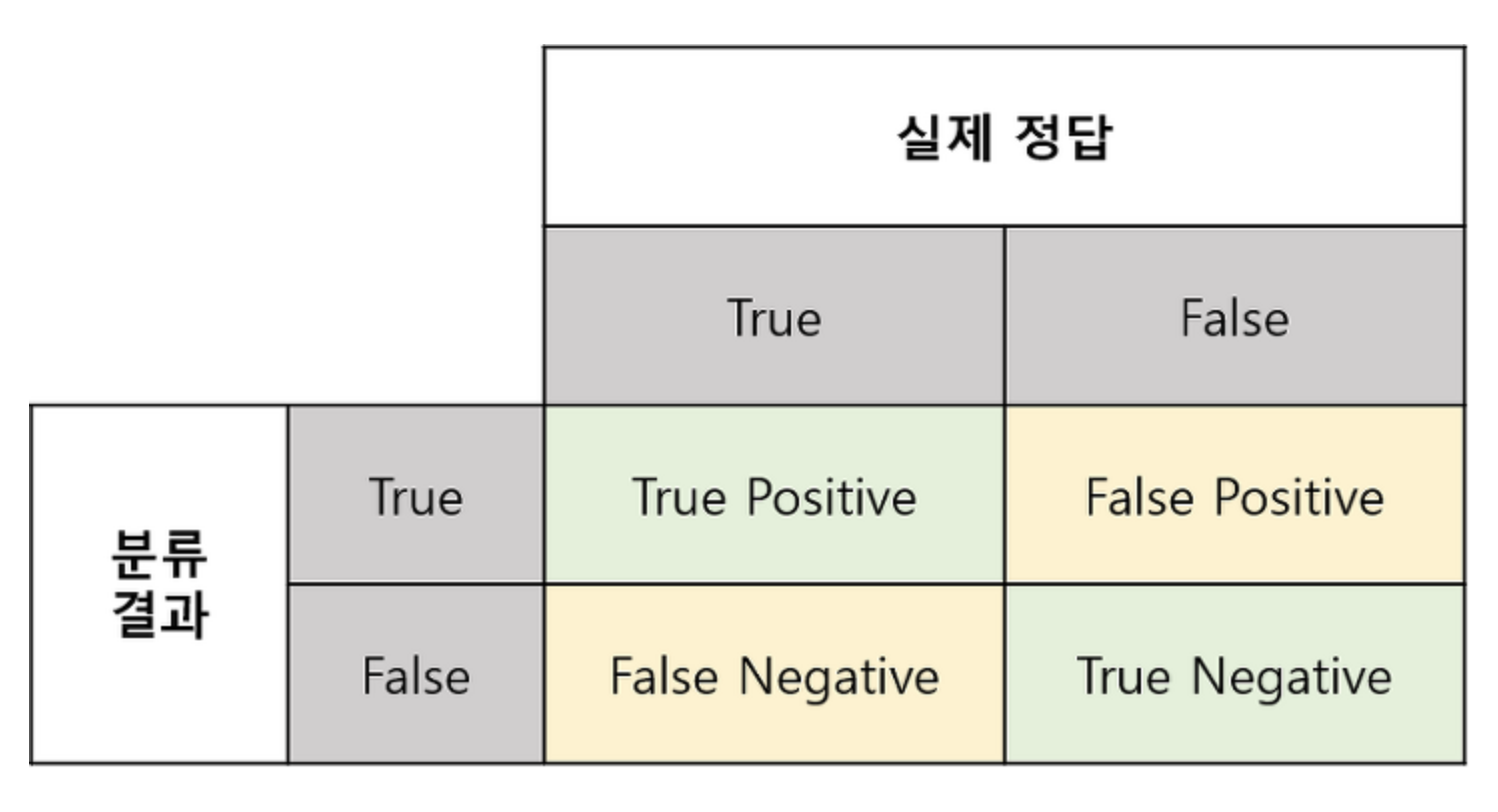

Confusion Matrix

Confusion Matrix는 실제 클래스와 예측된 클래스의 매칭을 이용하여 분류 모델을 평가하는 도구이다.

- True Positive(TP) : 실제 True인 정답을 True라고 예측 (정답)

- False Positive(FP) : 실제 False인 정답을 True라고 예측 (오답)

- False Negative(FN) : 실제 True인 정답을 False라고 예측 (오답)

- True Negative(TN) : 실제 False인 정답을 False라고 예측 (정답)

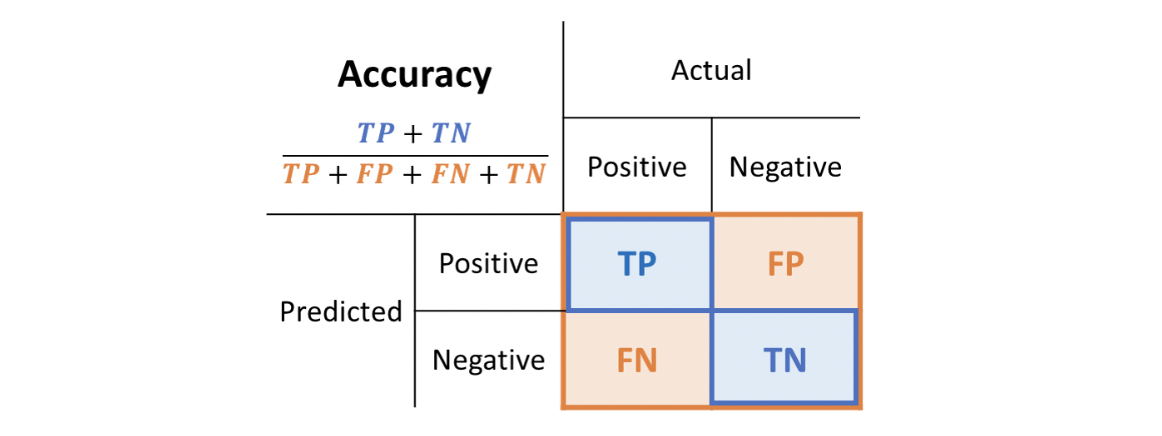

Accuracy (정확도)

정확도란 판별한 전체 샘플 중 TP와 TN의 비율이다. 분류 모델을 평가하기에 가장 단순한 지표이지만, 불균형한 클래스를 가진 데이터셋을 평가하기는 어렵다는 단점이 있다. 또한, Domain의 편중(Bias) 문제가 발생할 수 있다.

예를 들어, 더운 지역에 눈이오는 날 수를 예측한다고 할 때, 모두 '오지 않는다'라고만 분류기를 만들어도 분류기는 상당히 높은 정확성을 보일 것이다. 이처럼 data자체의 domain이 불균형할 경우 문제가 생길 수 있다.

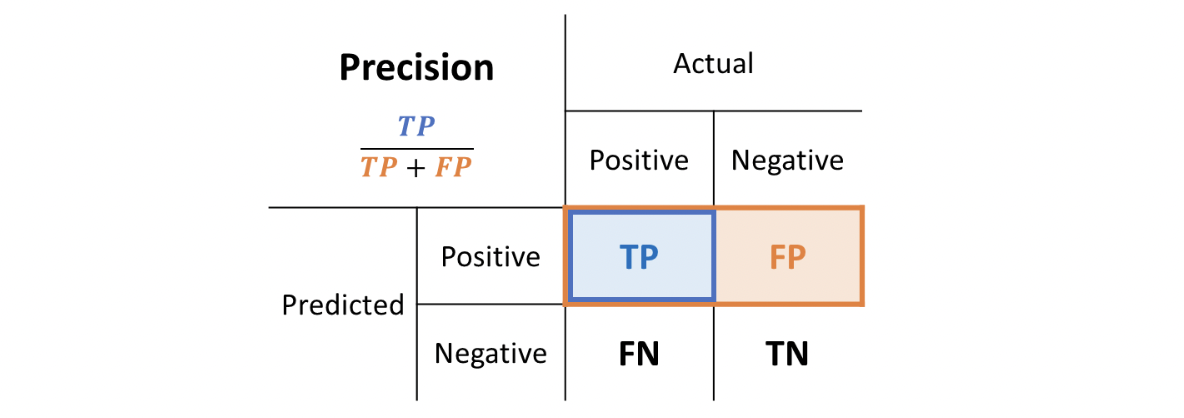

Precision (정밀도)

정밀도란 분류 모델이 Positive로 판정한 것 중, 실제로 Positive인 샘플의 비율이다.

Positive 정답률이라고도 불리며, Positive라고 분류된 결과가 얼마나 정확한지를 나타낸다.

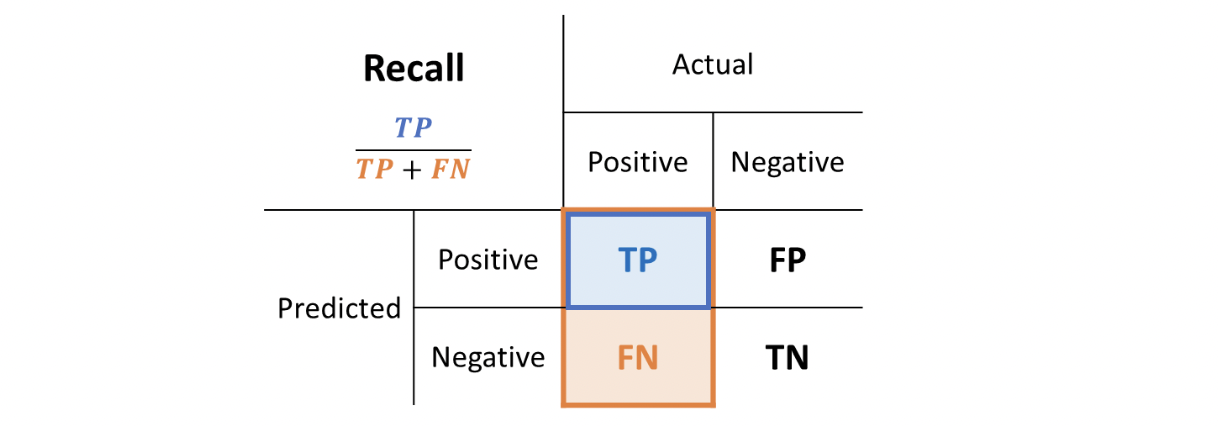

Recall (재현율)

재현율이란 실제 Positive 샘플 중 분류 모델이 Positive로 판정한 비율이다.

민감도라고도 불리며, 분류 모델이 실제 Positive 클래스를 얼마나 빠지지 않고 잡아내는지를 나타낸다.

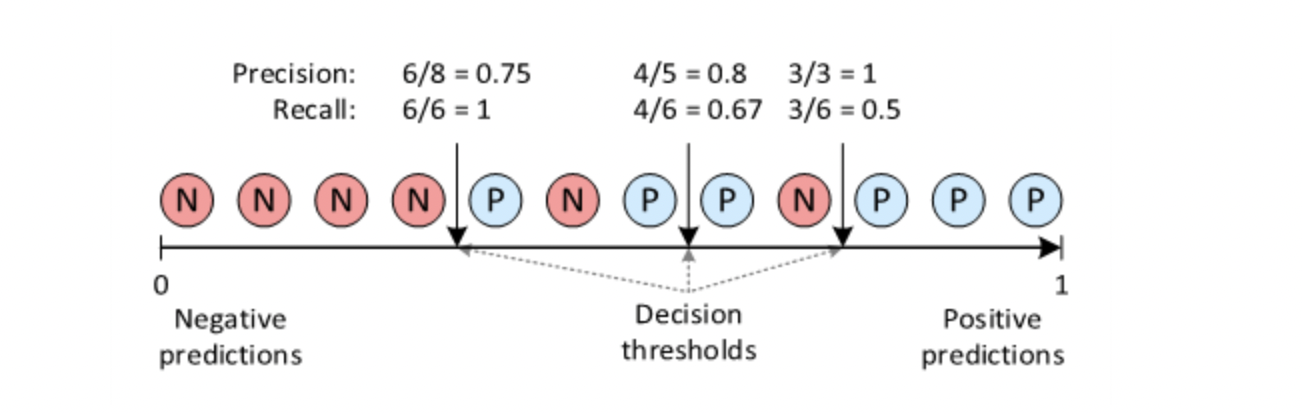

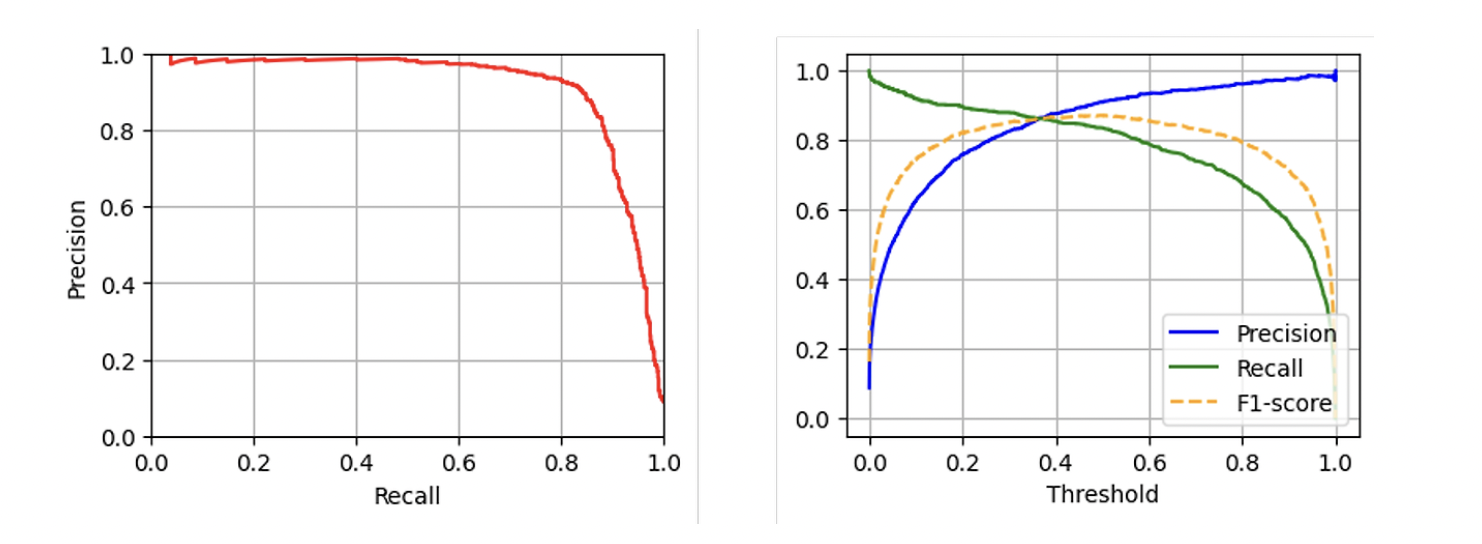

Precision - Recall Curve

Precision과 Recall은 trade-off 관계에 있어 어느 한쪽이 올라가면 다른 한쪽이 떨어진다. 분류 모델의 decision threshold를 통해 trade-off를 조절할 수 있다.

Decision Threshold란 분류 모델의 결과인 [0, 1] 사이의 값을 positive 또는 Negative로 결정하는 경계를 의미한다.

Precision-Recall Curve 위의 한 점은 특정 threshold에 해당하는 Precision과 Recall 값을 의미한다. 또한, 오른쪽 그림과 같이 Precision과 Recall 값을 Threshold 변화에 따른 그래프로 나타낼 수도 있다.