https://codingopera.tistory.com/41

위의 블로그를 공부하며 정리한 내용입니다

Attention이란?

Attention: 문맥에 따라 집중할 단어를 결정하는 방식

(그림: 한/영 번역에서의 Attention 예시)

우리가 글을 읽을 때 모든 단어들을 집중해서 읽지 않고, 중요한 단어들만 집중해 읽듯이 이렇게 문맥을 파악하는 방법을 딥러닝 모델에 적용한 것이 Attention이다.

위의 예에서는, 영어 'cafe'와 한국어 '카페'가 강한 Attention 상관관계에 있고, 다른 단어들은 약하다.

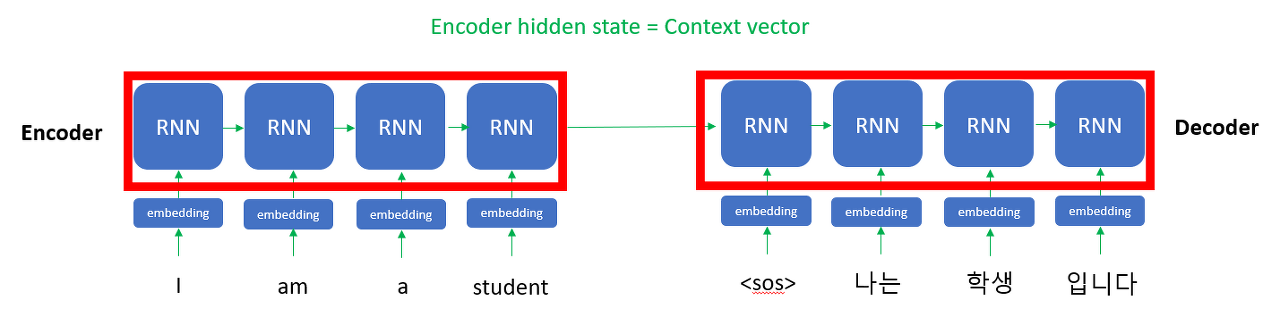

Attention 모델의 구조

대부분의 자연어 모델은 Encoder와 Decoder로 구성이 되어 있다

Encoder: 입력으로 input data를 받아 압축 데이터(context vector)로 변환 출력해주는 역할

Decoder: encoder와 반대로,

압축 데이터(context vector)를 입력해 output data를 출력해주는 역할

Encoder와 Decoder이 필요한 이유는, 정보를 압축함으로써 연산량을 최소화하기 위해