paper review

1.[paper review] Vision Transformers with Mixed-Resolution Tokenization

기존의 ViT들은 input image를 동일한 크기(equal-size)의 patch로 나눠 처리하였다.그러나 Transformer가 처음 제안된 배경인 NLP를 생각해보면, 이때는 각각의 token이 subword를 의미하며, arbitrary size로 학습이 되

2024년 2월 21일

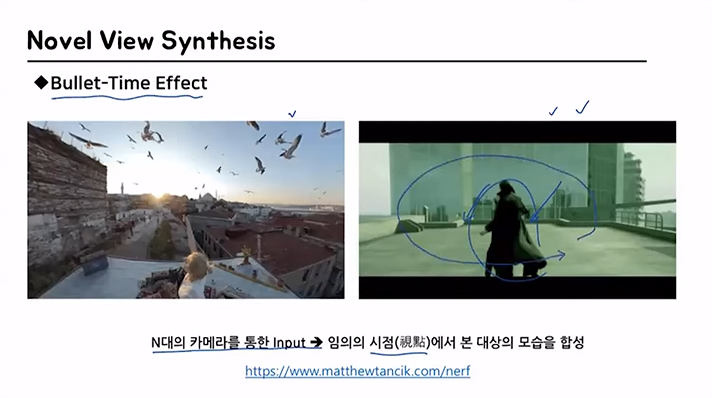

2.PR-302: NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis

https://www.youtube.com/watch?v=zkeh7Tt9tYQ&t=1900s다음 강의를 듣고 정리하였습니다.View Synthesis가 무엇일까?이미지를 한 개 혹은 여러개를 input으로 받은 후, continuous하게 임의의 시점에서 바라

2024년 3월 20일

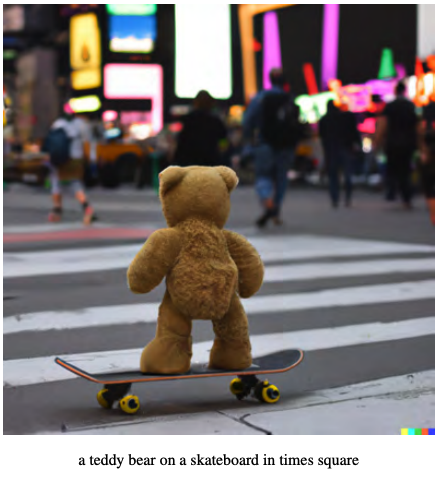

3.diffusion

https://ffighting.net/deep-learning-paper-review/diffusion-model/diffusion-model-basic/위의 블로그를 정리한 글입니다.학습 데이터에 없는 형태의 이미지들도 생성 가능text뿐 아니라 layou

2024년 8월 30일