lec9-1: XOR 문제 딥러닝으로 풀기

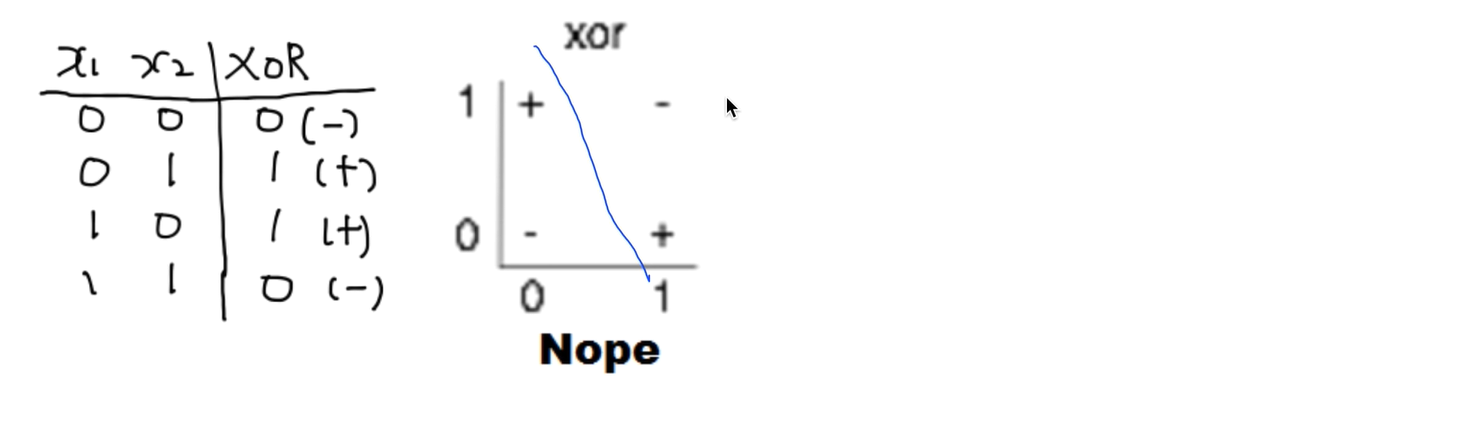

One logistic regression unit cannot separate XOR

XOR은 굉장히 간단했지만 초창기 뉴럴 네트워크 전문가들한테는 절망을 안겨다 줬었다

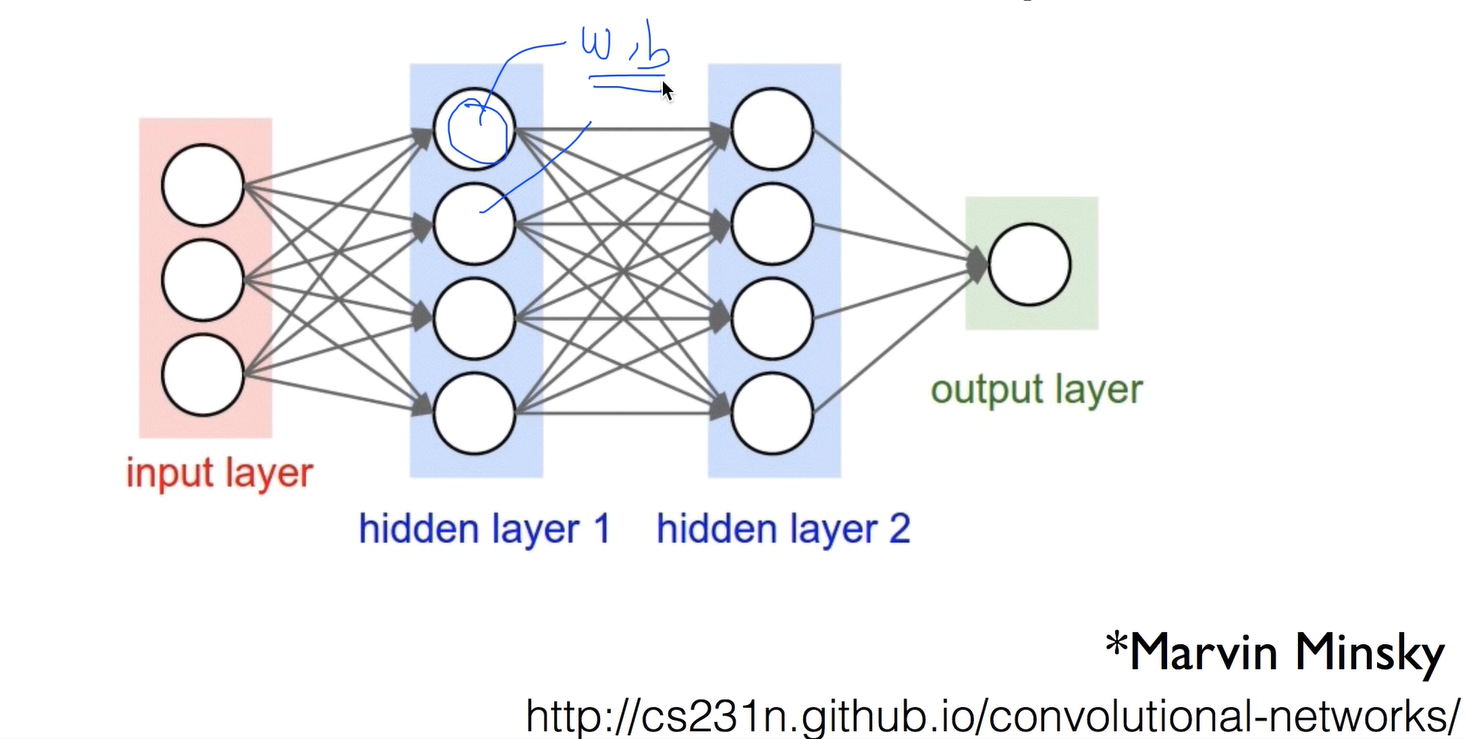

Neural network (NN) "No one on earth had found a viable way to train*"

그 당시에 나왔던 이야기가, 여러가지로 겹치면 풀수가 있지만 각각의 W, b를 어떻게 학습할 수가 있냐 불가능하다 라고 나옴

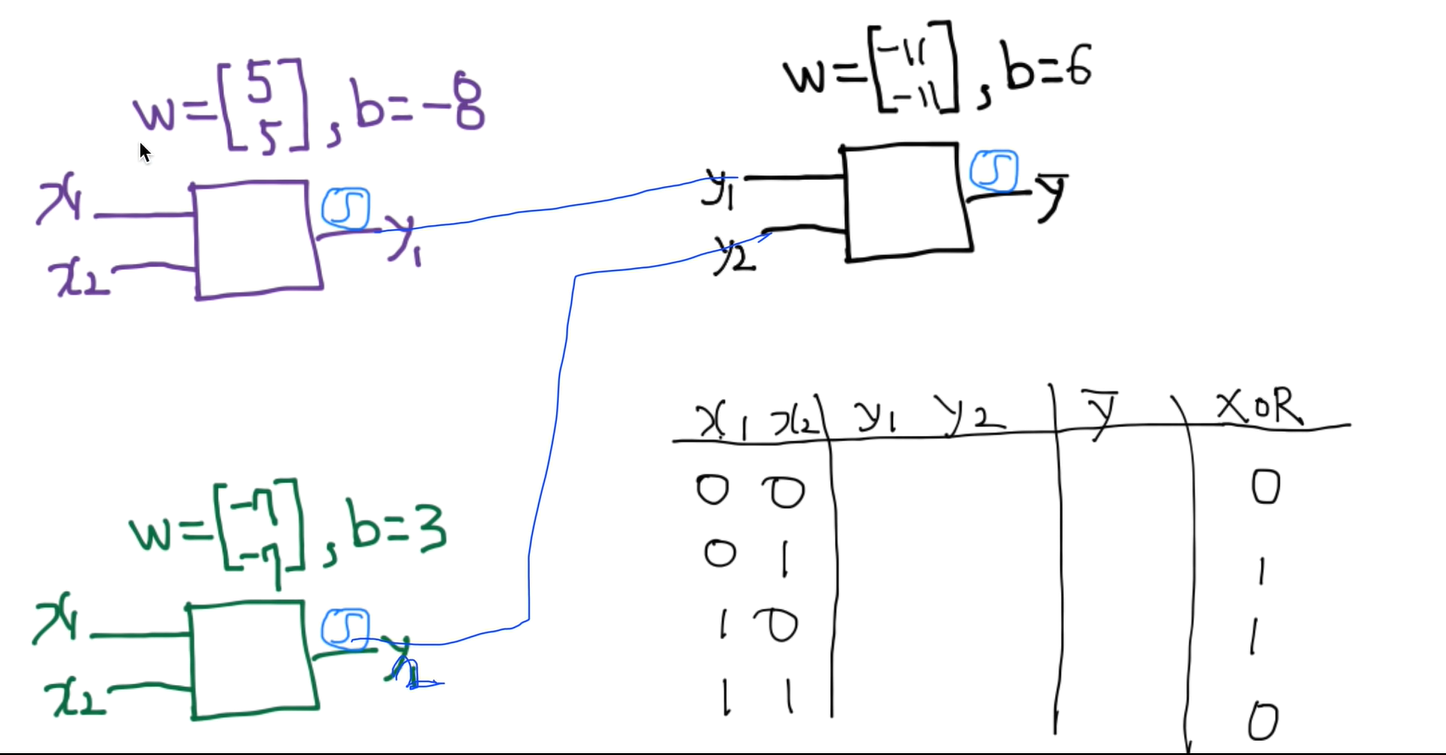

XOR using NN

XOR의 속성으로는 리니어하게 선을 찾을 수 없다

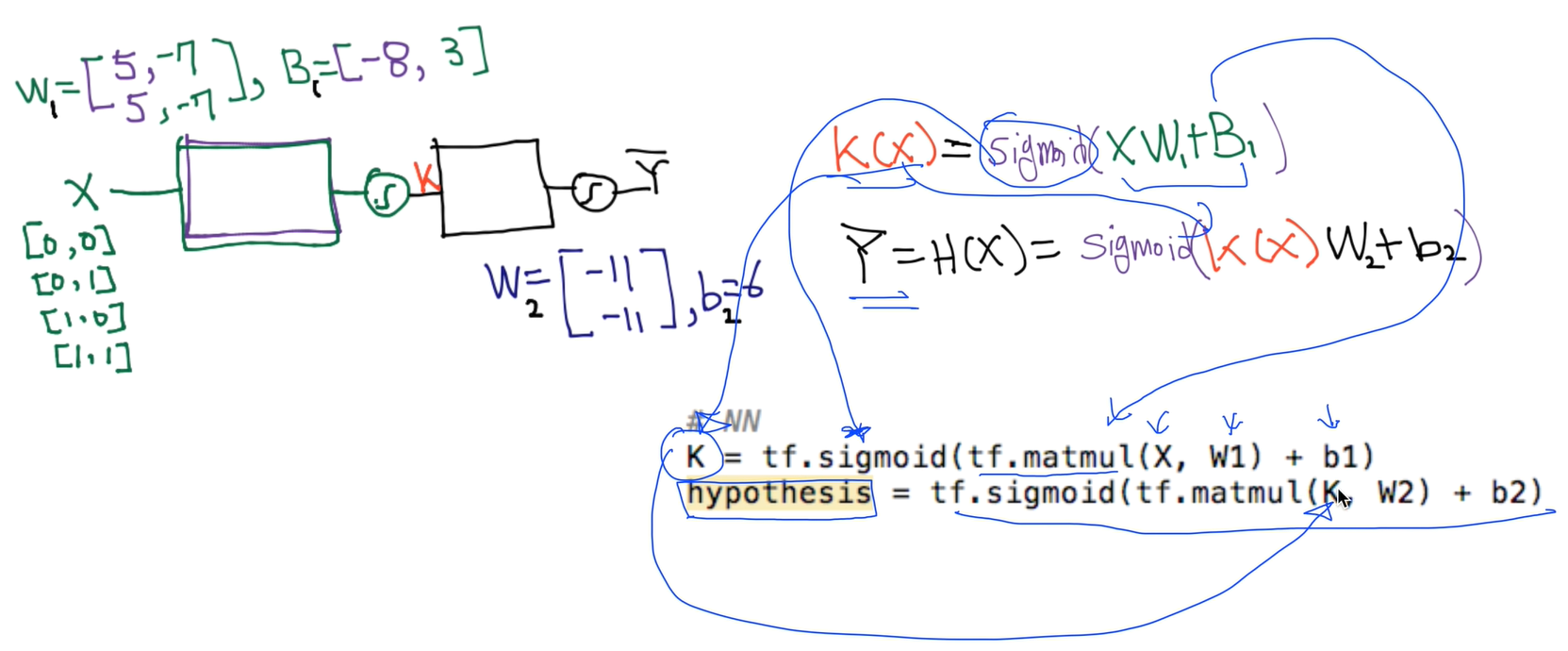

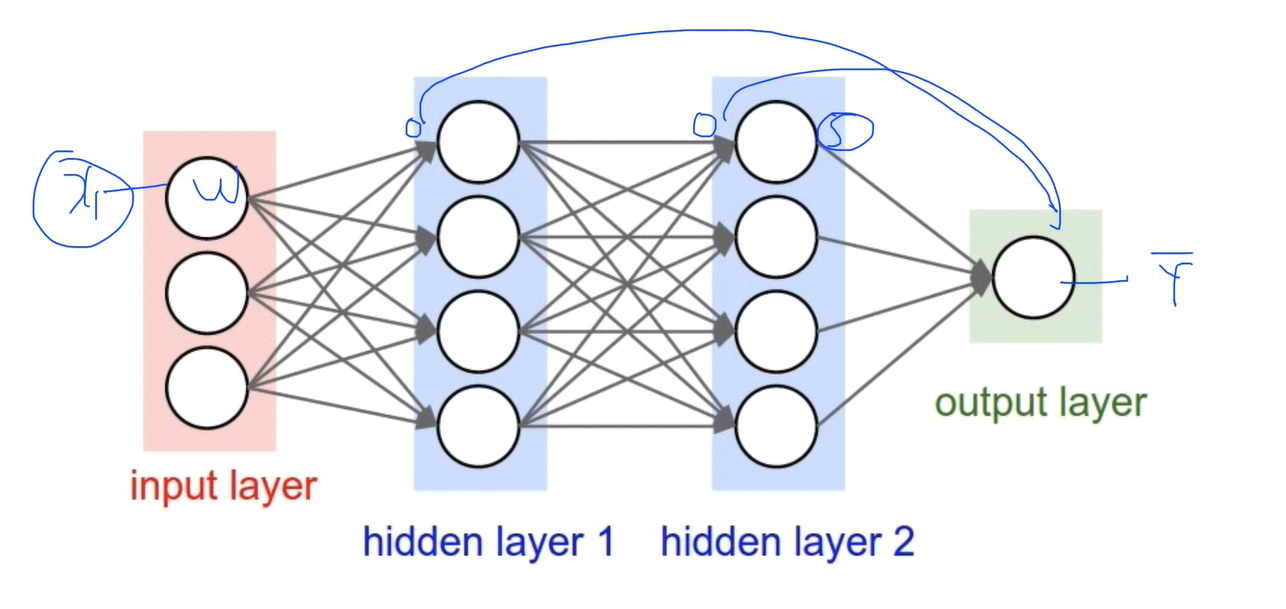

Neural Net

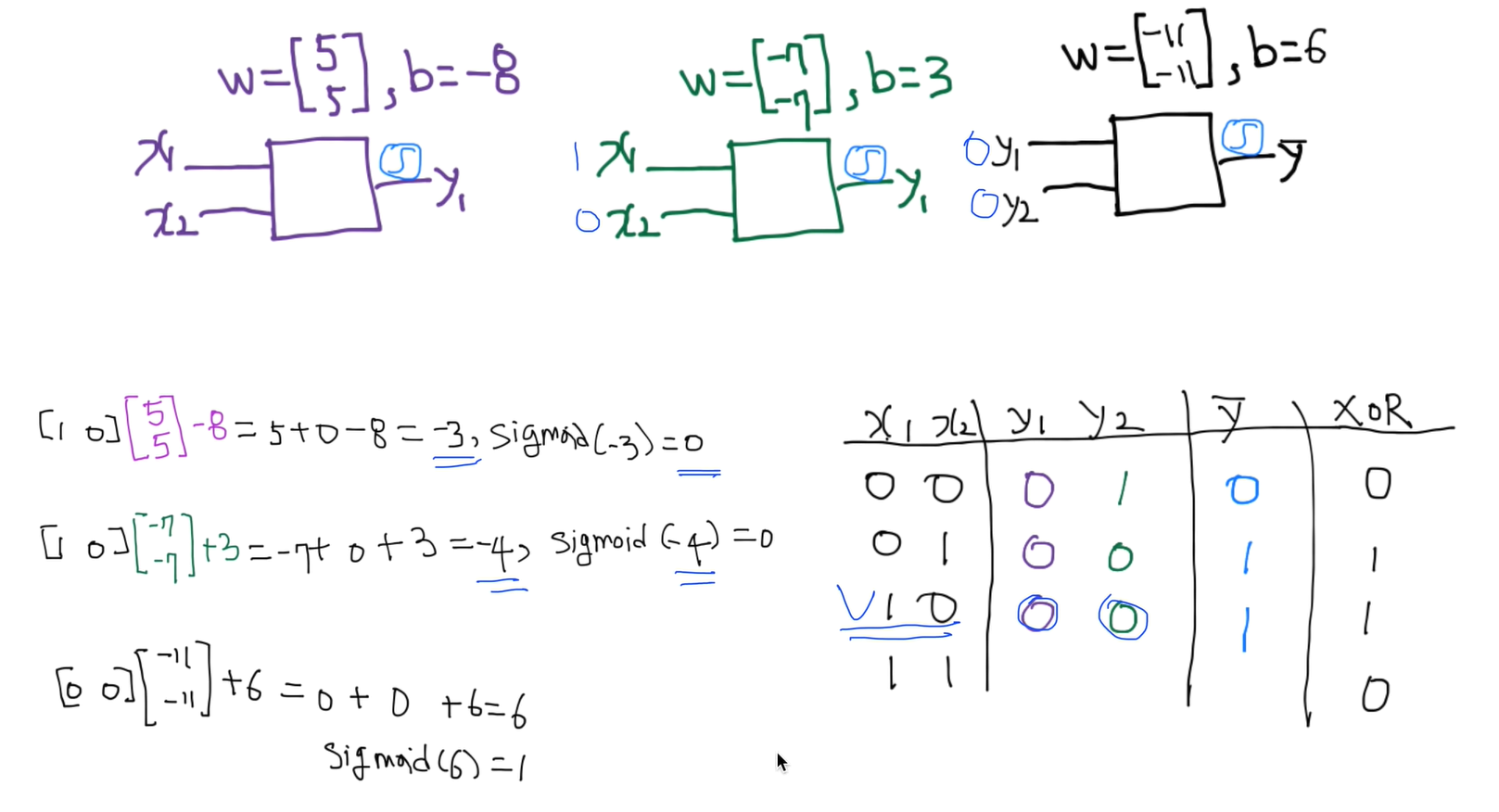

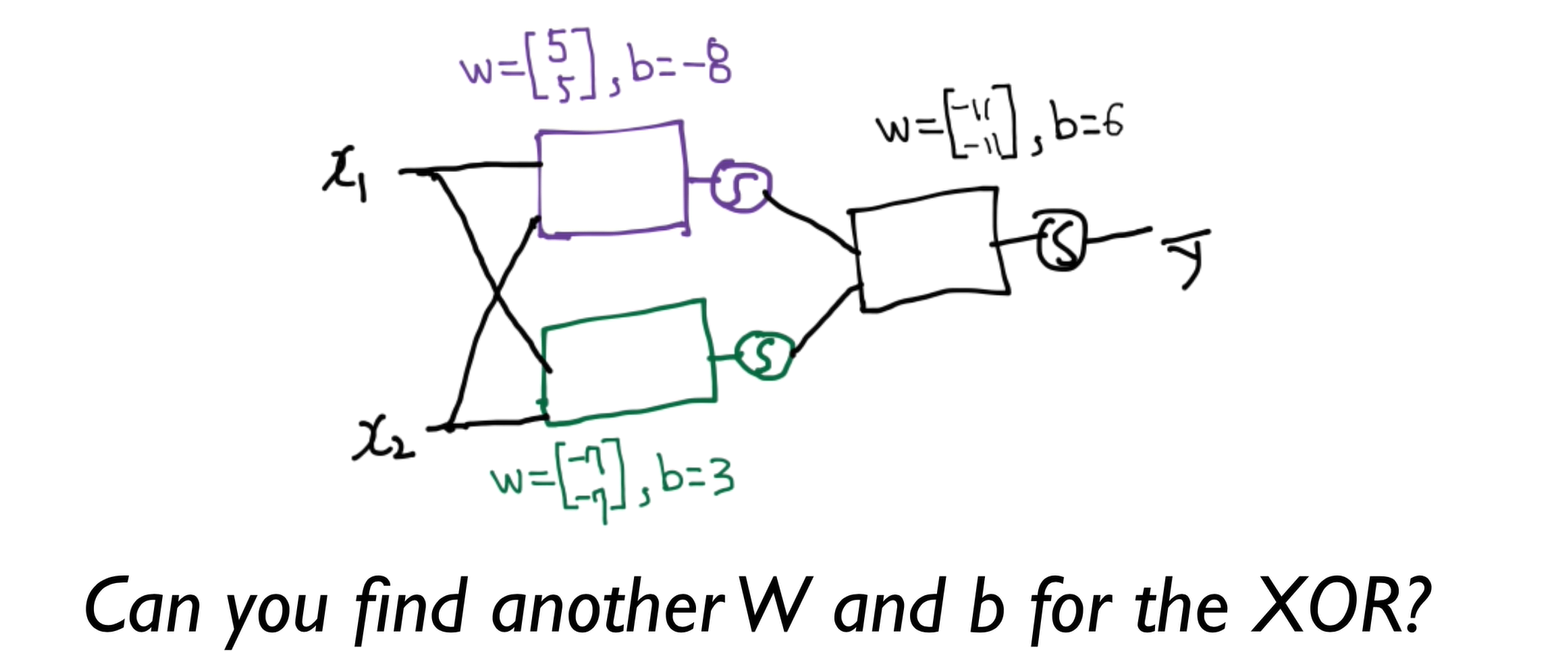

이 문제를 3개의 네트워크를 가지고 풀어보자

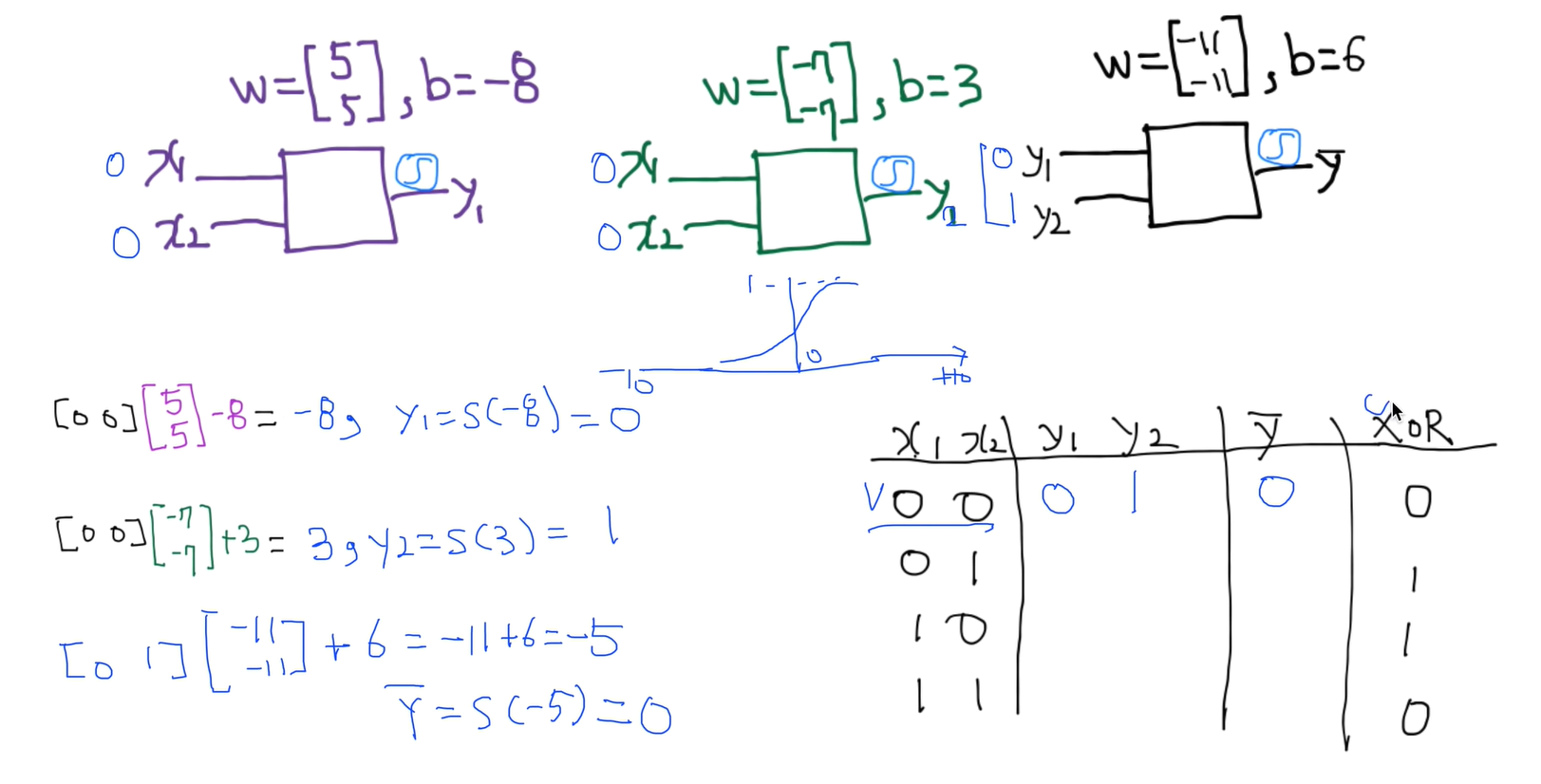

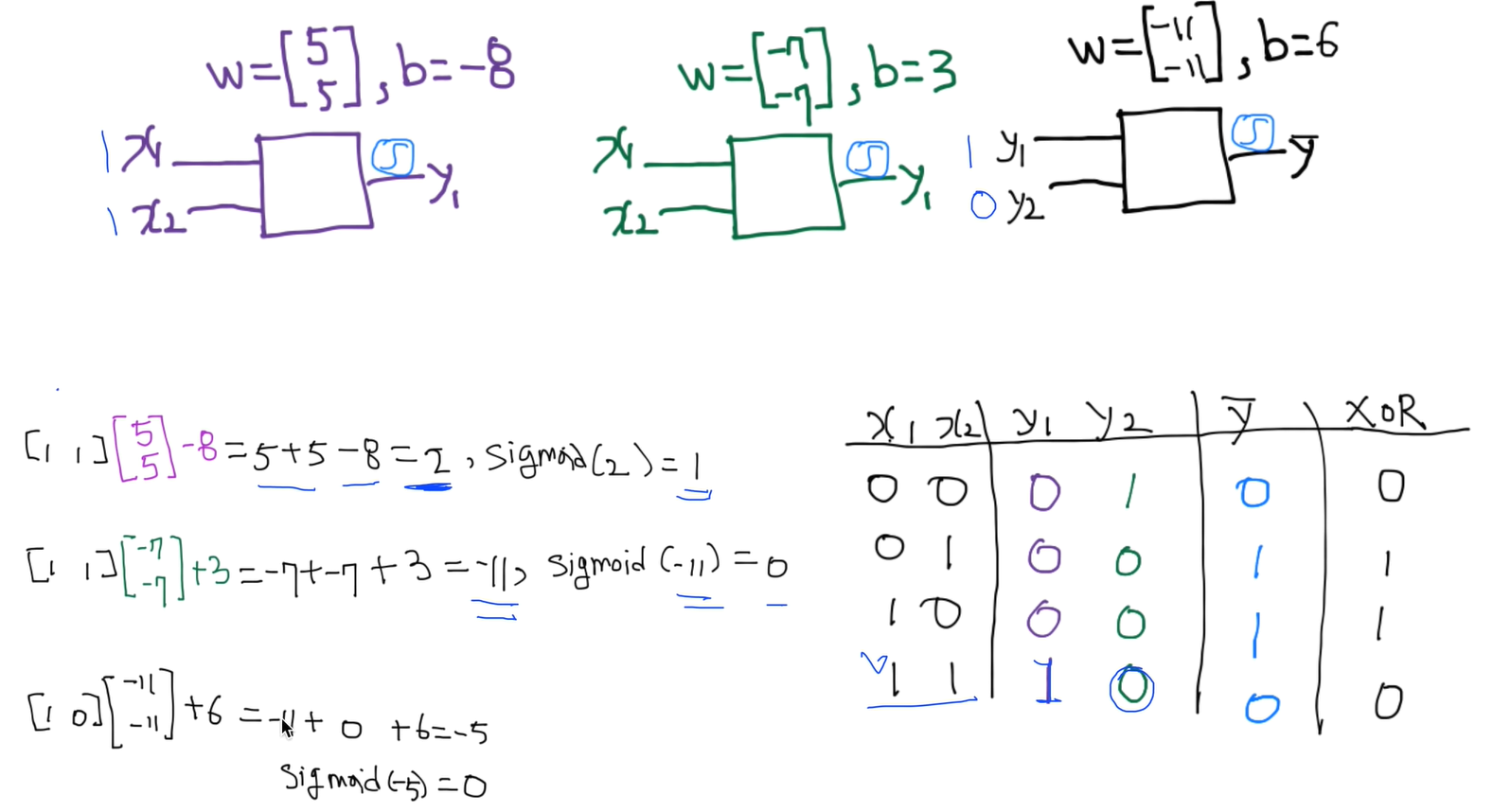

4가지 케이스로 테스트 해봅시다. ( 1번째 케이스)

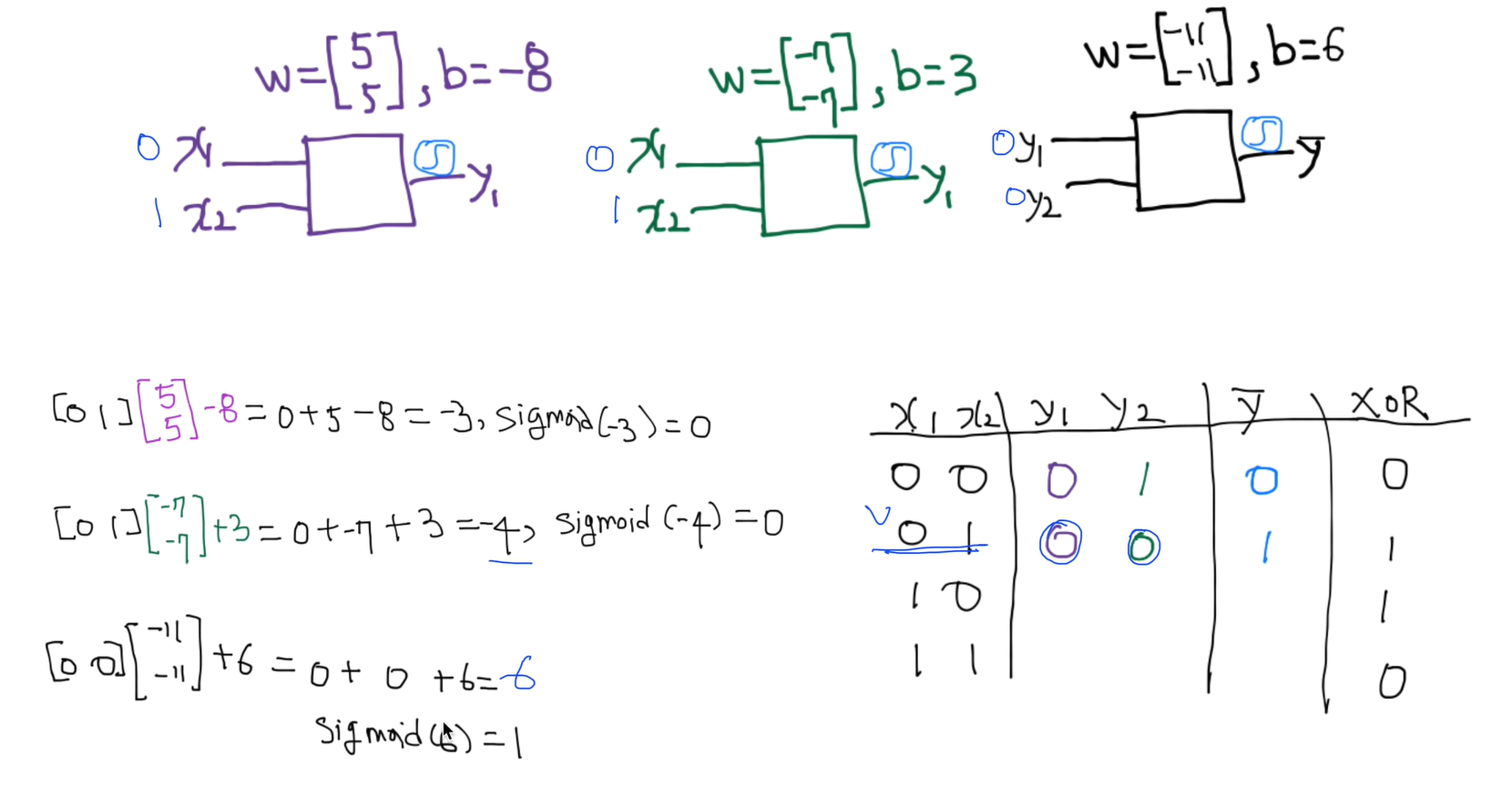

2번째 케이스

3번째 케이스

4번째 케이스

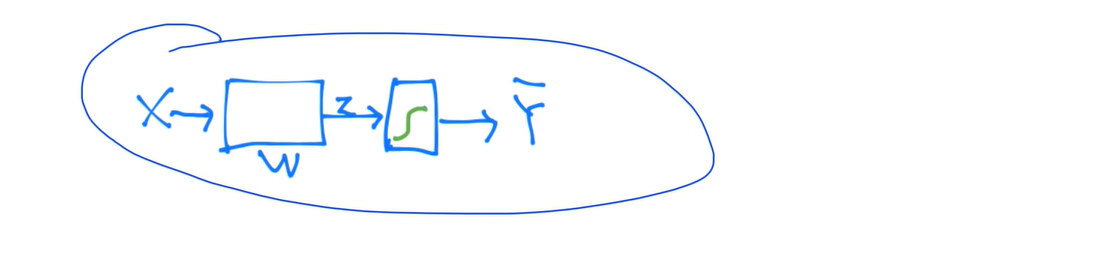

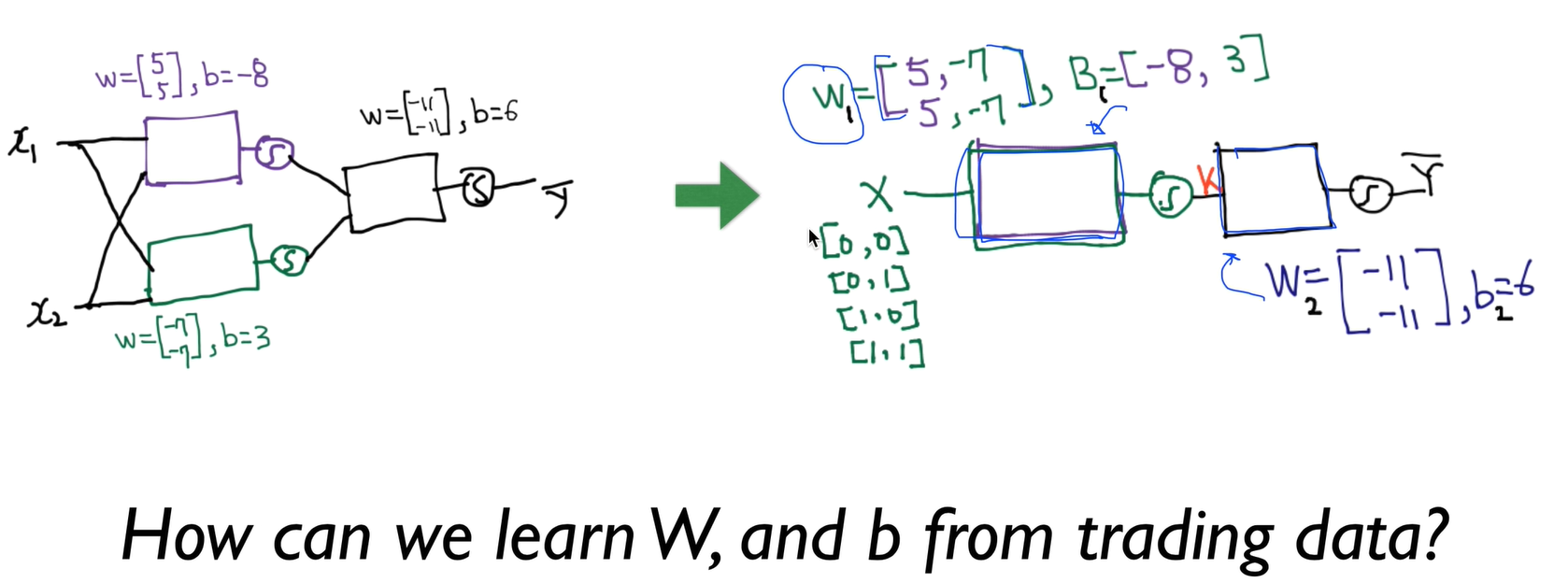

Forward propagation

각각 계산했던 식을 더 간편하게 작성 , 이게 즉 뉴럴 네트워크

NN

위에 작성했던 식을 더 간단하게 작성

수식어로 써본다면

lec9-x: 특별편: 10분안에 미분 정리하기 (lec9-2 이전에 보세요)

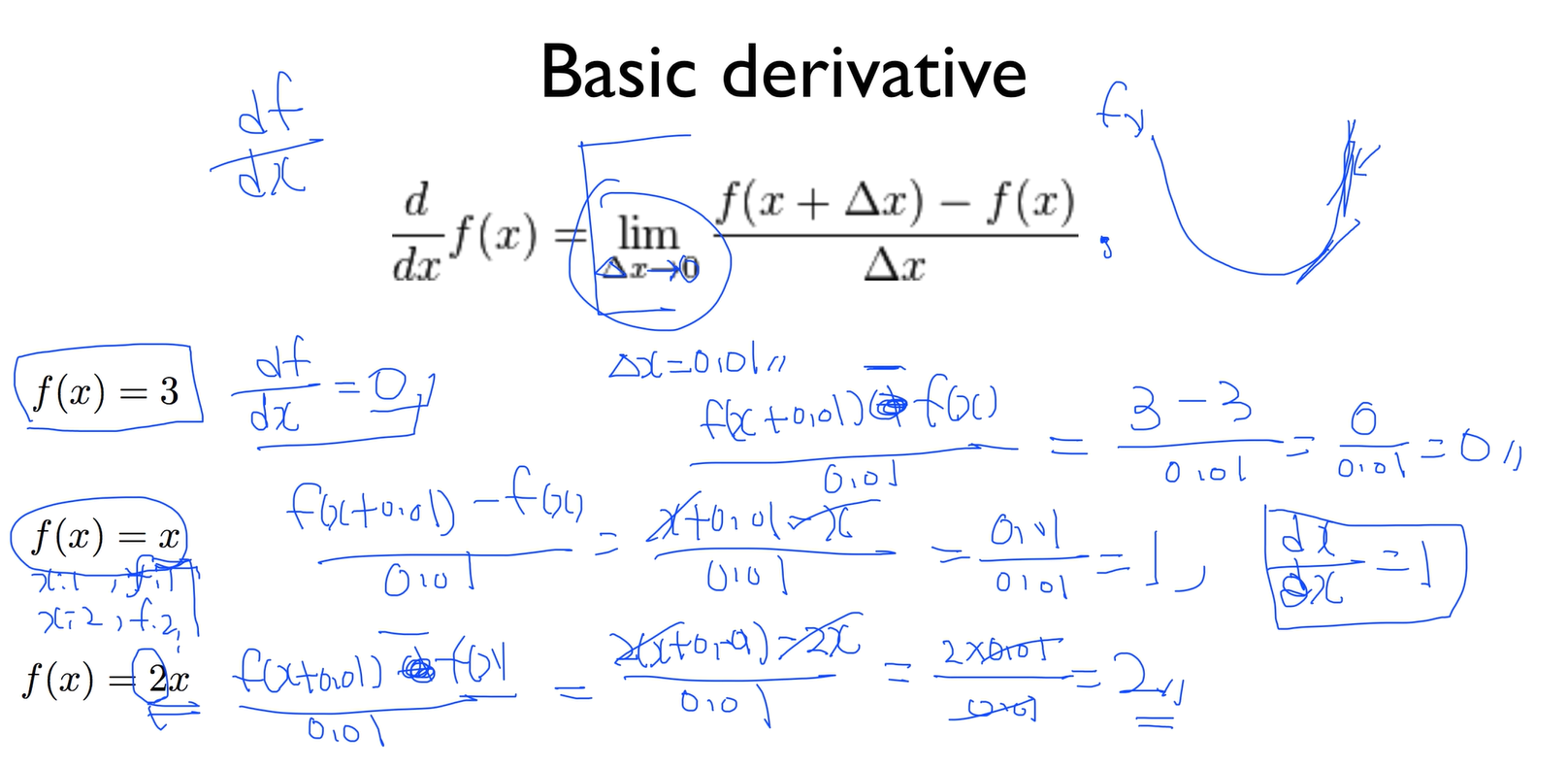

Basic derivative

델타 x를 아주 작은값, 0에 가까운 값으로 보낼 때 f(x)에 델타x를 더한값과 더하지 않는 값으로 해서 뺀걸 델타 x로 나눈다

다른말로 순간 변화율

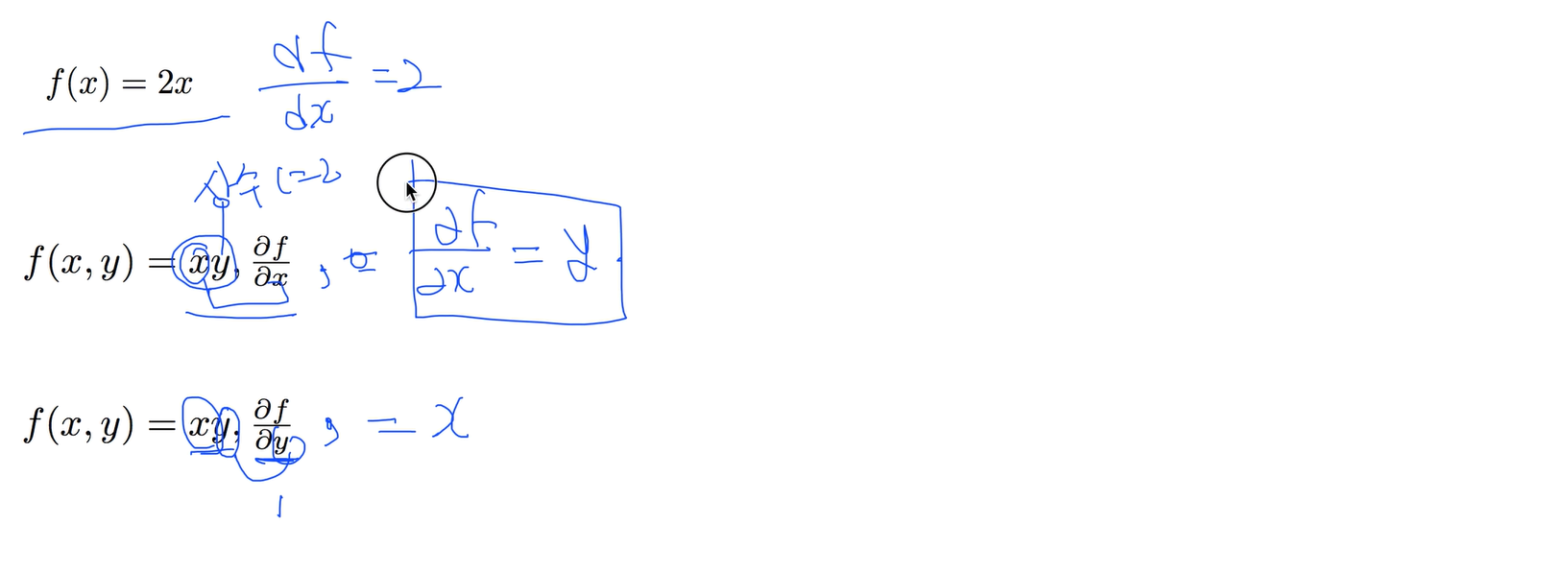

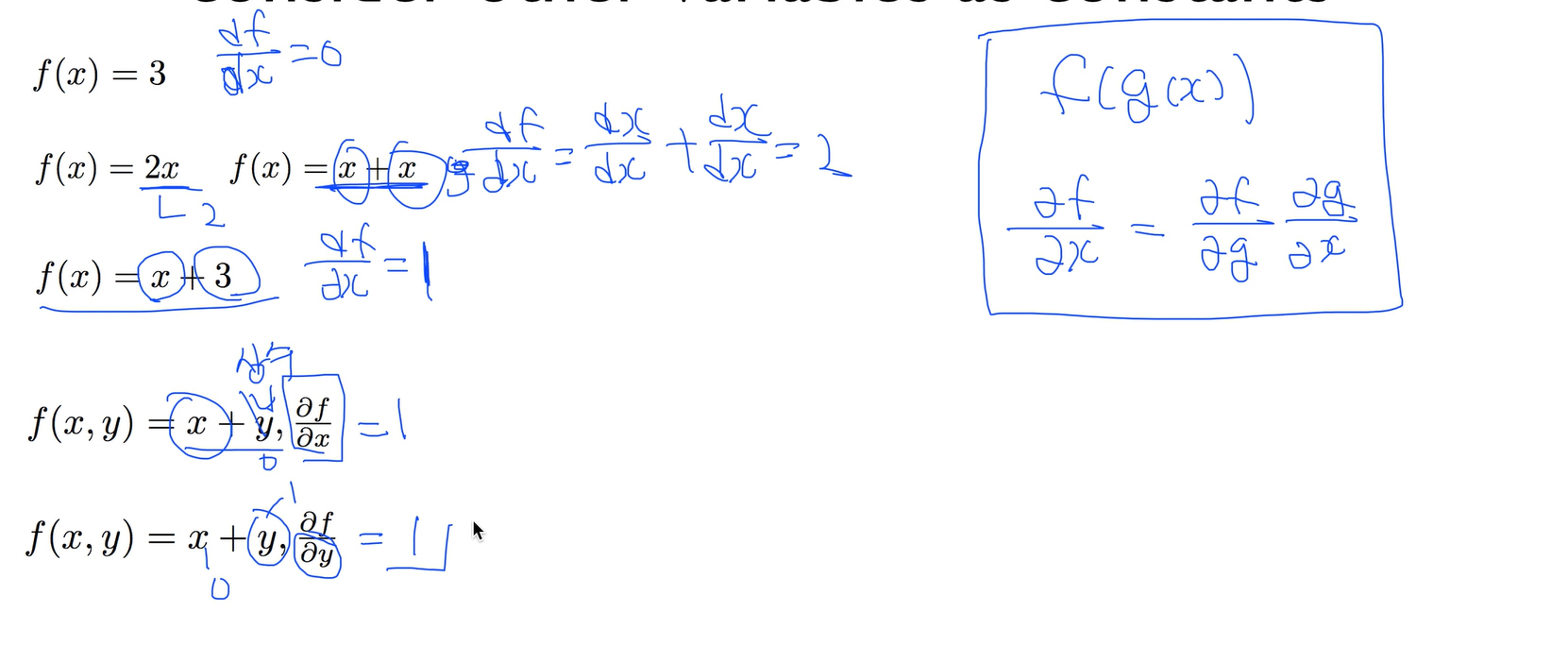

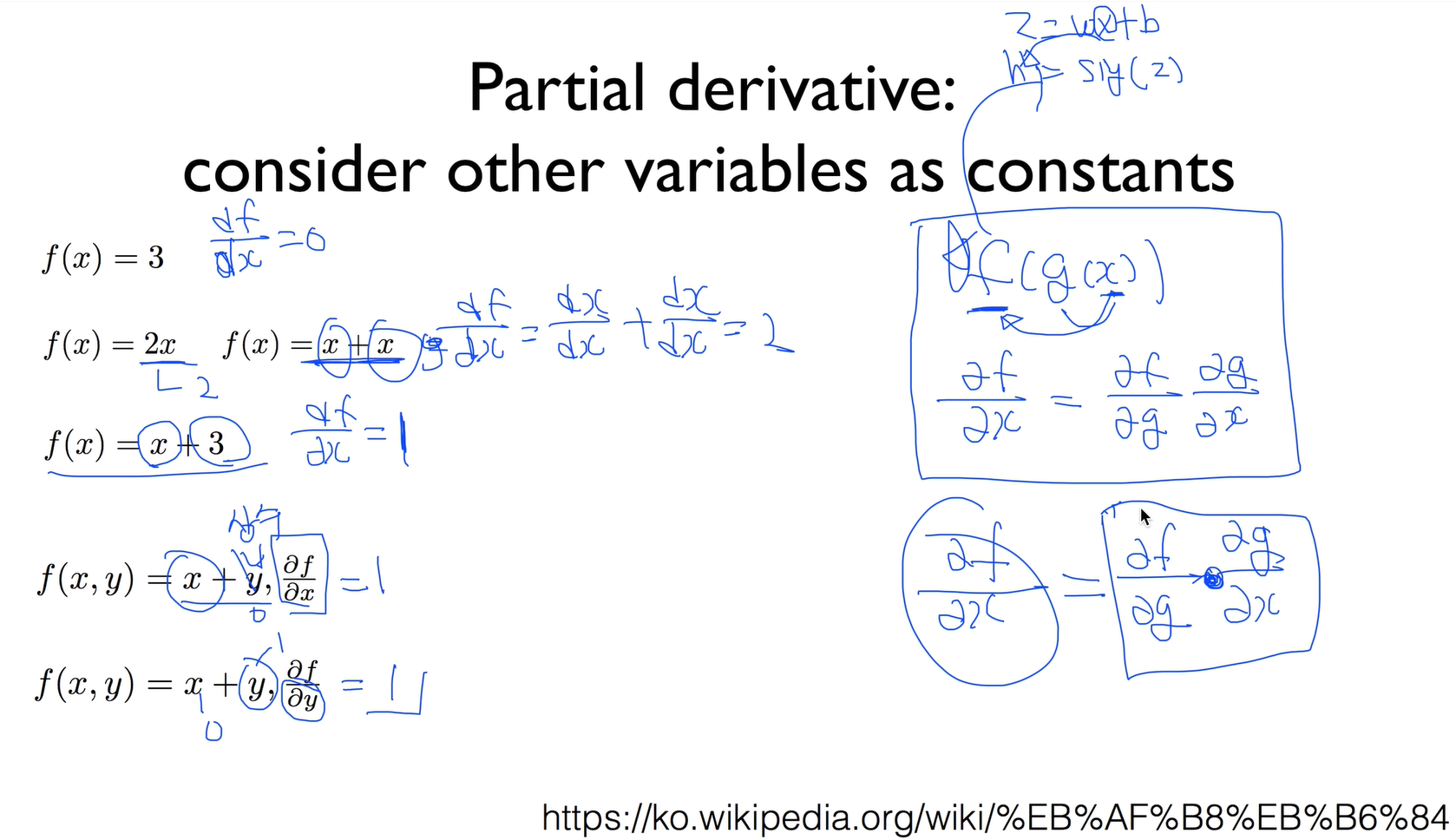

Partial derivative: consider other variables as constants

f(x, y) = xy, ax/af 에서는 x를 미분으로 쓰고 뒤에 y는 상수취급

상수함수는 미분하면 0이 됨

f(x) = x + x 을 미분하면 2

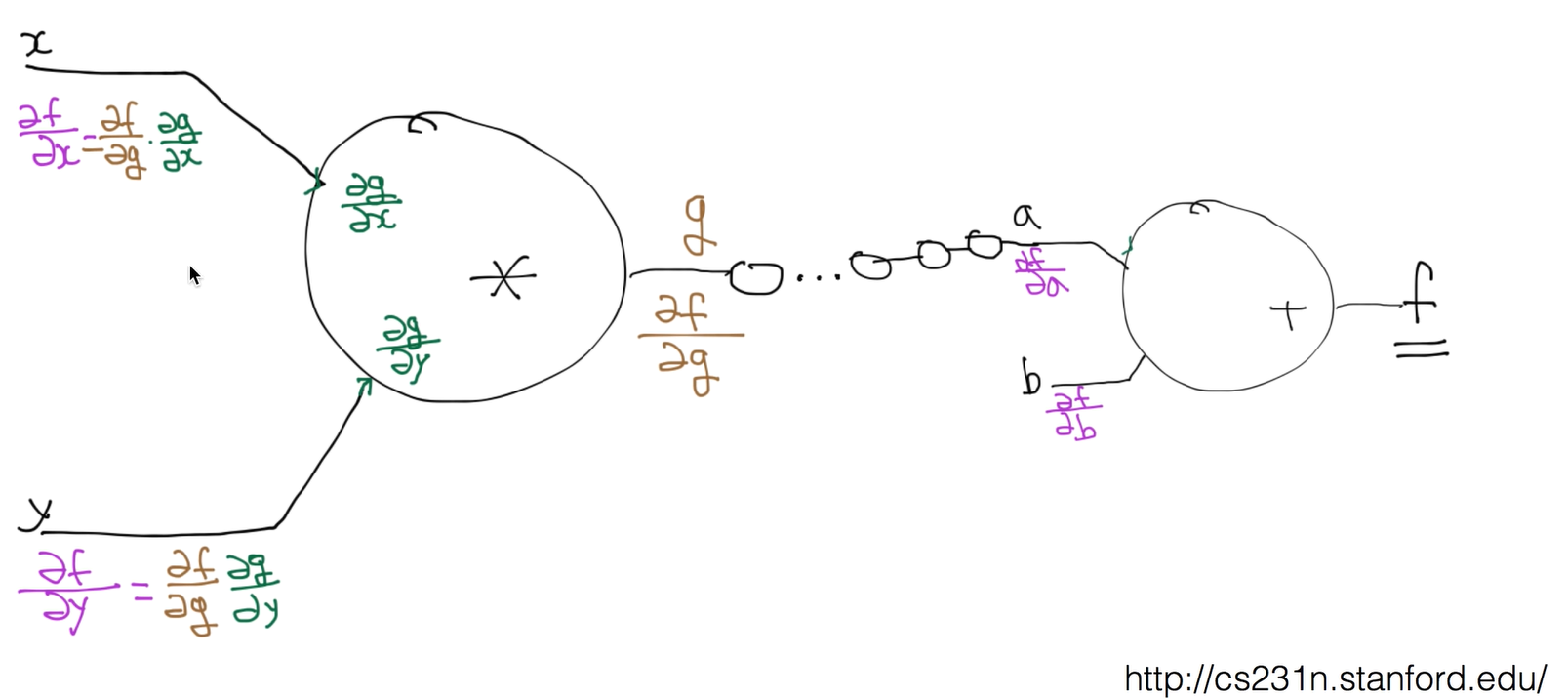

복합함수 f(g(x))는 ax/af = (ag/af)*(ax/ag)

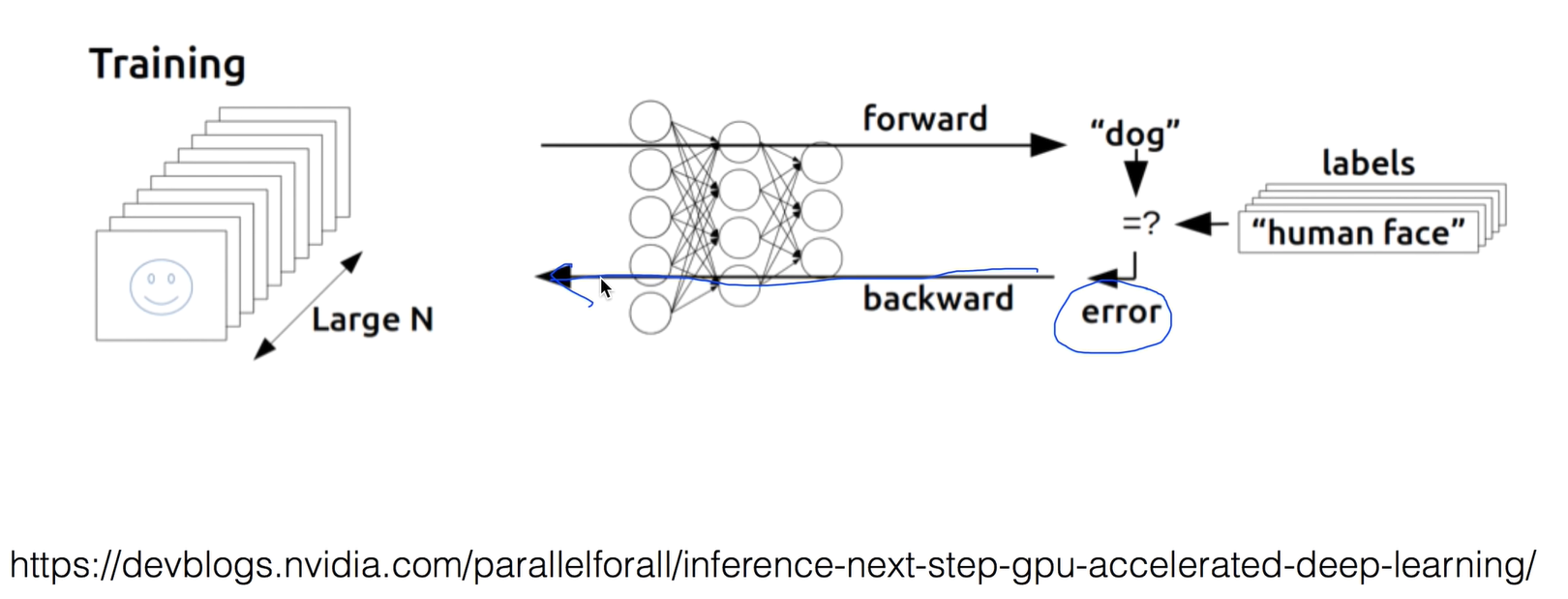

lec9-2: 딥넷트웍 학습 시키기 (backpropagation)

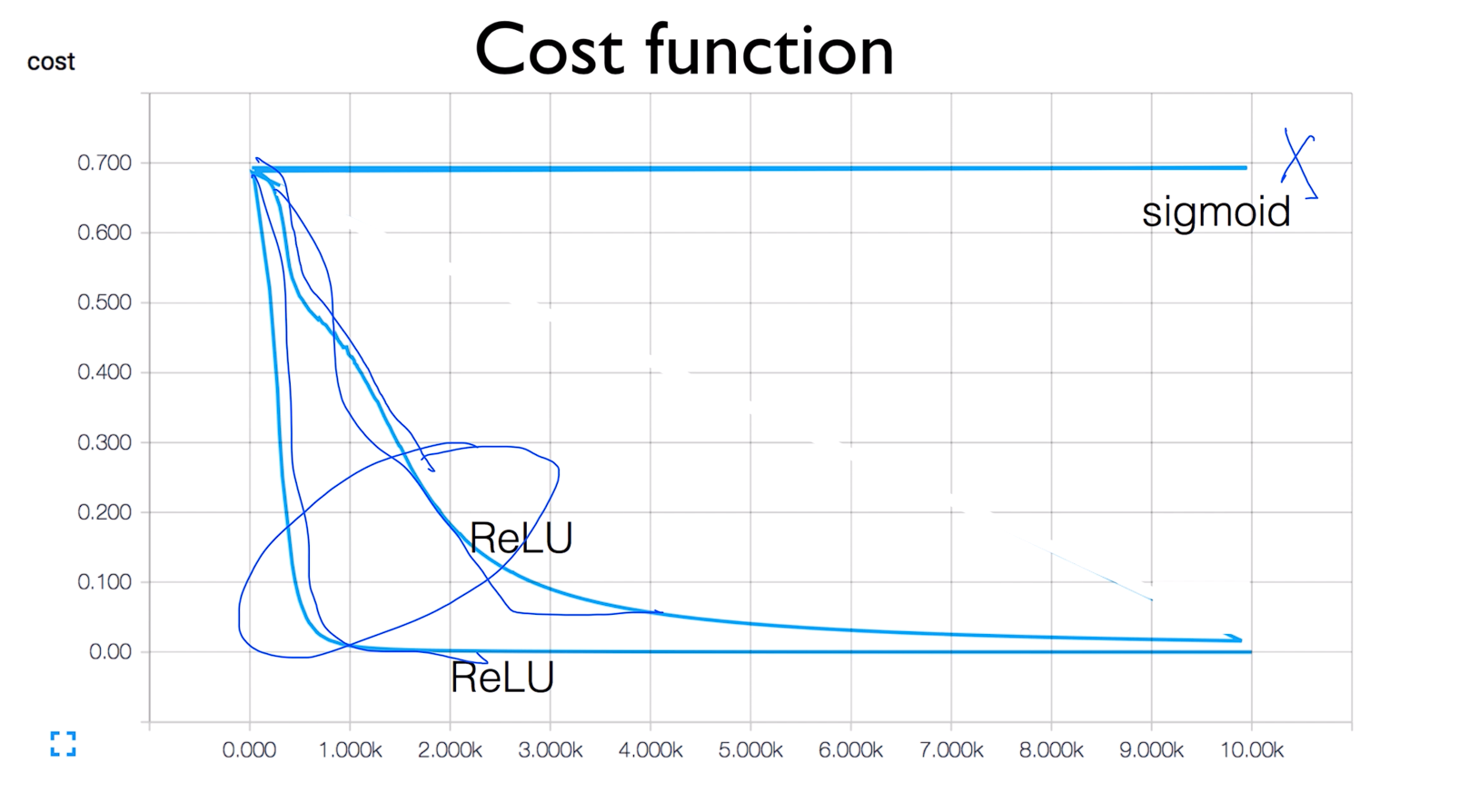

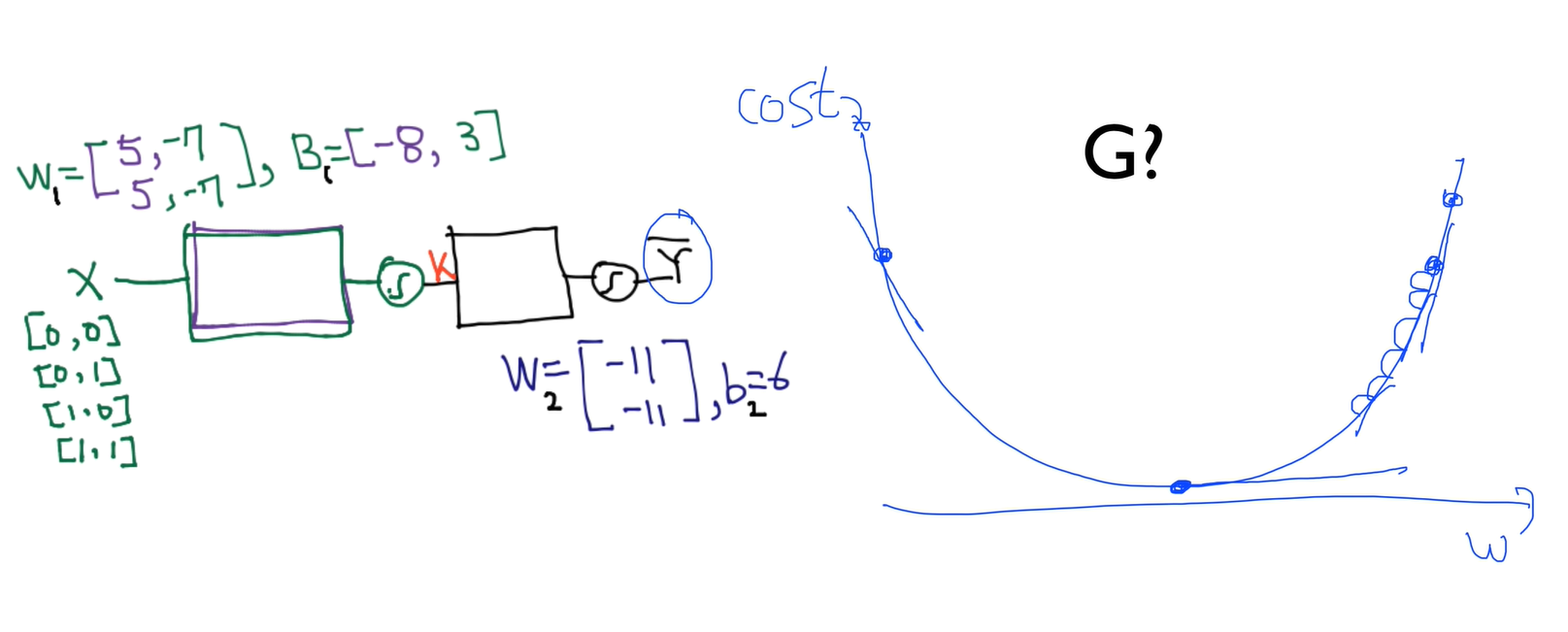

How can we learn W1, W2, B1, B2 from training data?

Derivation

Backpropagation (1974, 1982 by Paul Werbos, 1986 by Hinton)

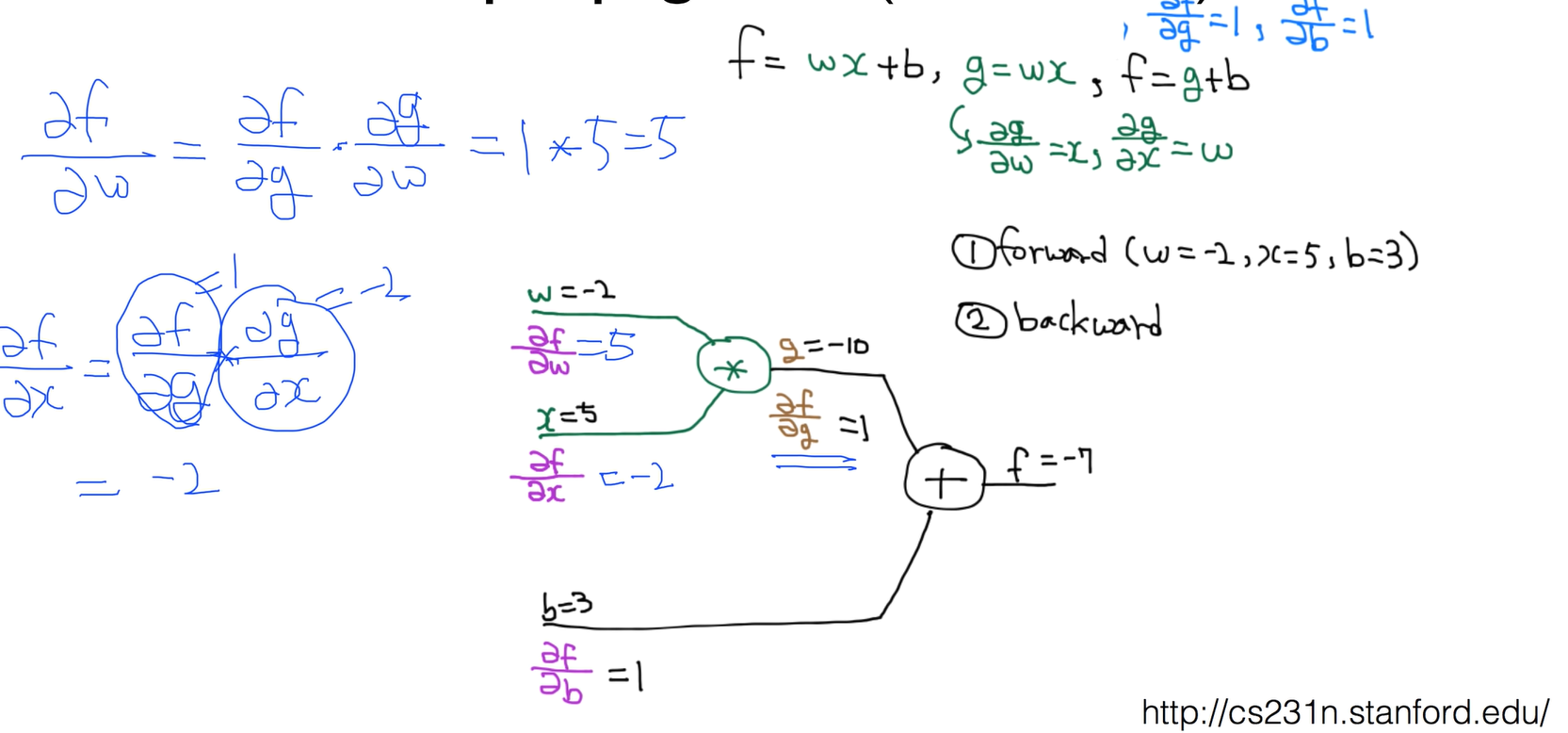

Back propagation (chain rule)

간단한 예제를 가지고 어떻게 동작하는지 이해해 보자.

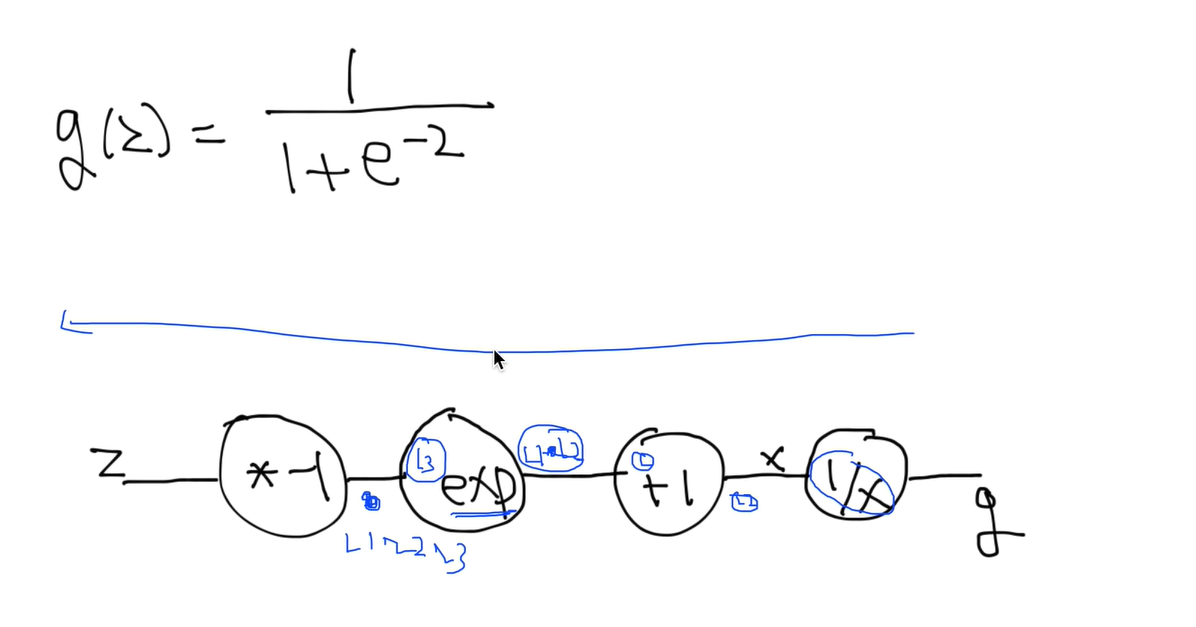

Sigmoid