모두를 위한 딥러닝

1.모두를 위한 딥러닝 - Lec 00, ML Lec 01

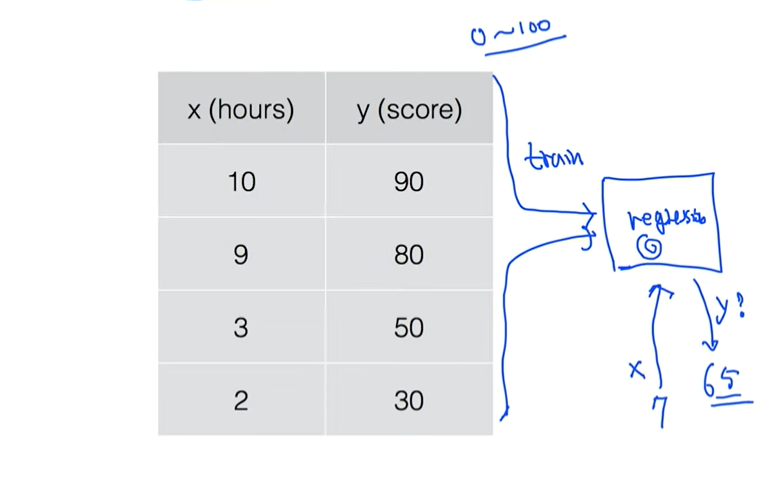

Want to understand basic machine learning (ML)No/weak math/computer science backgroundy = Wx + b (y=ax+b)Want to use ML as black-box with basic unders

2.모두를 위한 딥러닝 - ML Lec 02

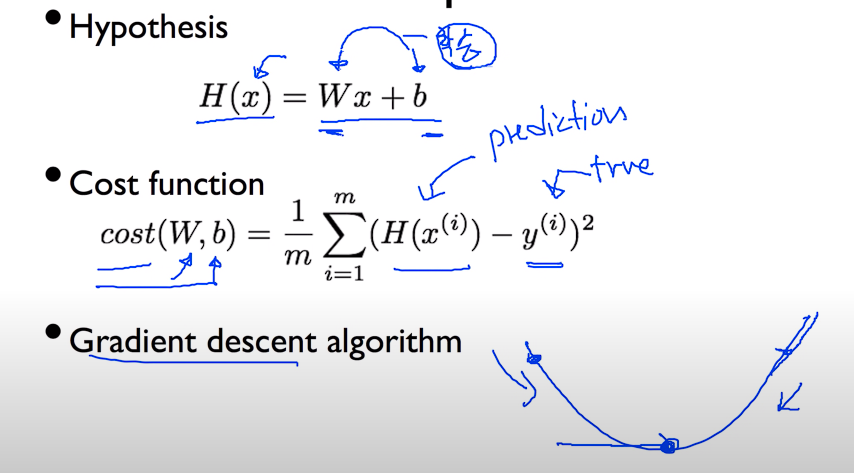

How fit the line to our (training) data경사를 따라 내려가는 알고리즘이다Minimize cost functionGradient descent is used many minimization problemsFor agiven cost func

3.모두를 위한 딥러닝 - ML Lec 03

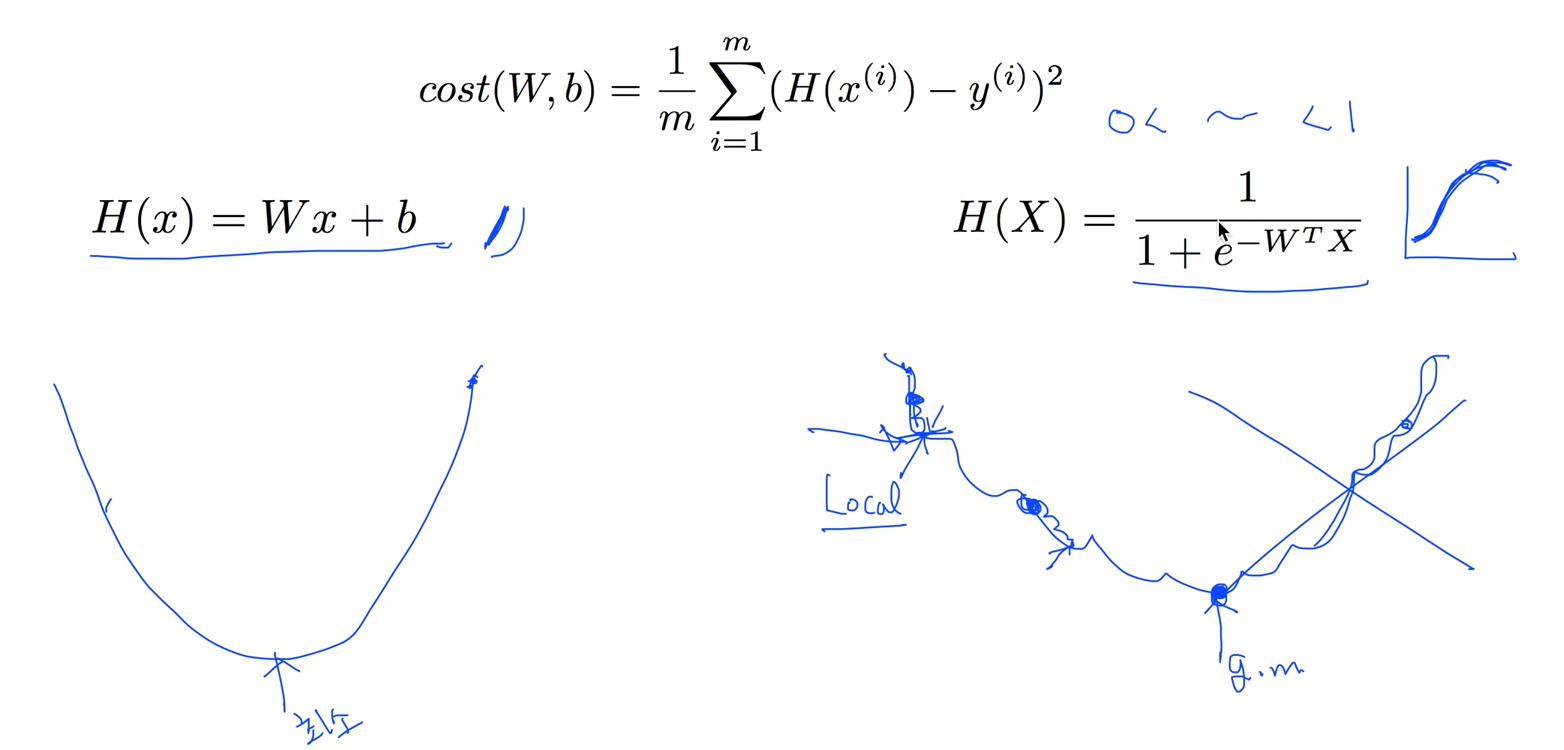

Hypothesis : H(x) = Wx + bCost function : Gradient descent algorithm작성중

4.모두를 위한 딥러닝 - ML Lec 04

시그모이드 함수는 경사하강법으로 최소점을 찾을 수 없다간단하게 코스트함수는 어떤값의 평균이니까 하나의 엘리먼트의 코스트를 구해서 평균내는걸 C함수라 합시다C함수는 두가지 경우에 따라 함수를 정의하는데 y = 1일땐 -log(H(x)) y = 0일땐 -log(1-H(x)

5.모두를 위한 딥러닝 - ML Lec 05

xy = MinMaxScaler(xy) 을 주게 되면 제일 작은값을 0 제일 큰값을 1로 줘서 그 사이를 값에 따라서 노말라이즈를 한다뇌가 굉장히 복잡하게 연결되어있다에 놀랍고, 연결된 부분부분들을 자세히 봤더니 Neuron이라 불리는 유닛이 너무 단순하게 동작이 되더

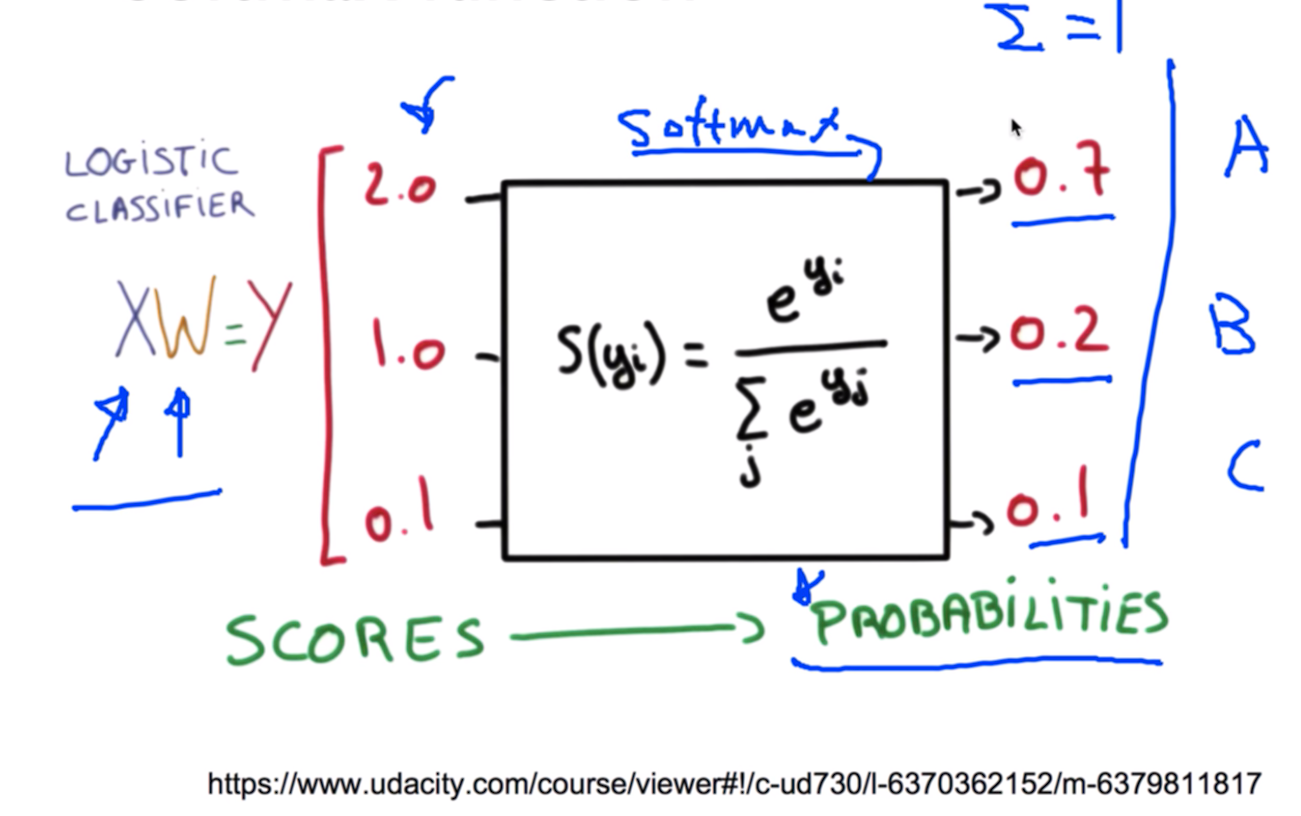

6.모두를 위한 딥러닝 - ML Lec 06

주어진 x값에 학습할 w값을 곱해서 y를 구하는걸로 시작한다.그런데 이렇게 나오는 값들은 그냥 스코어에 불과하는데 이것을 softmax function 으로 통과시키면 이것이 확률로 나오게 된다. A가 될 확률이 0.7 B가 될 확률이 0.2 C가 될 확률이 0.1 이

7.모두를 위한 딥러닝 - ML Lec 07

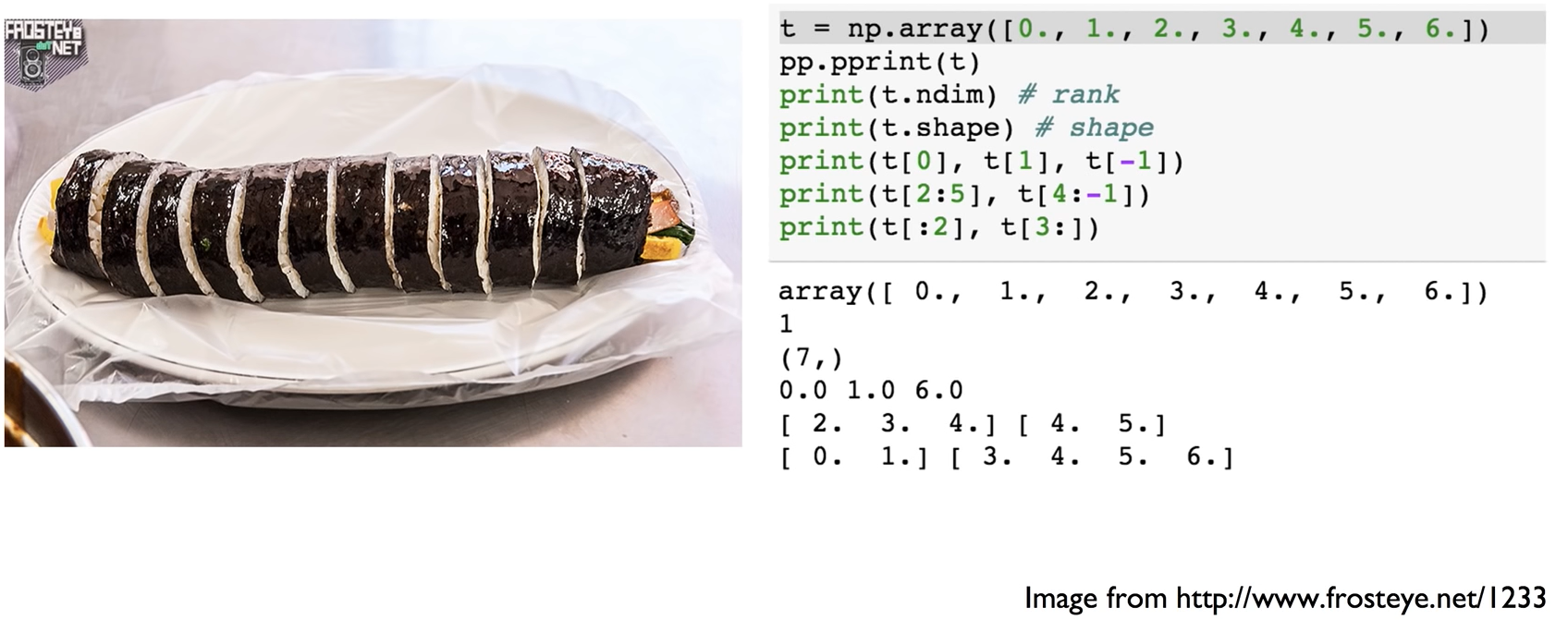

행렬쓰 4행 3열1차원 Array 일 경우 rank = 1, Shape = \[4]2차원 Array 일 경우 rank = 2, Shape = \[2, 2]4차원 Array 일 경우 rank = 4, Shape = \[1, 2, 3, 4]Axis 같은 경우 제일 안쪽에

8.모두를 위한 딥러닝 - ML Lec 08

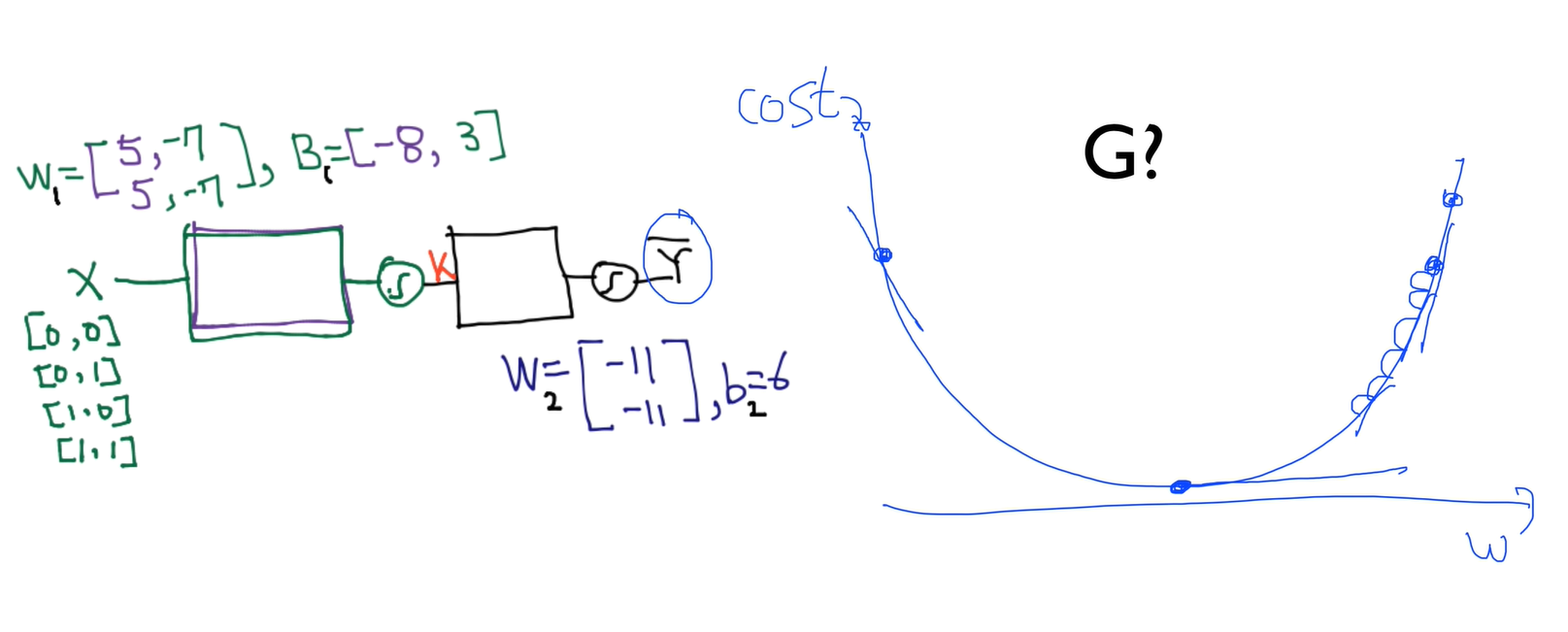

간단한 예제를 가지고 어떻게 동작하는지 이해해 보자.

9.모두를 위한 딥러닝 - ML Lec 09

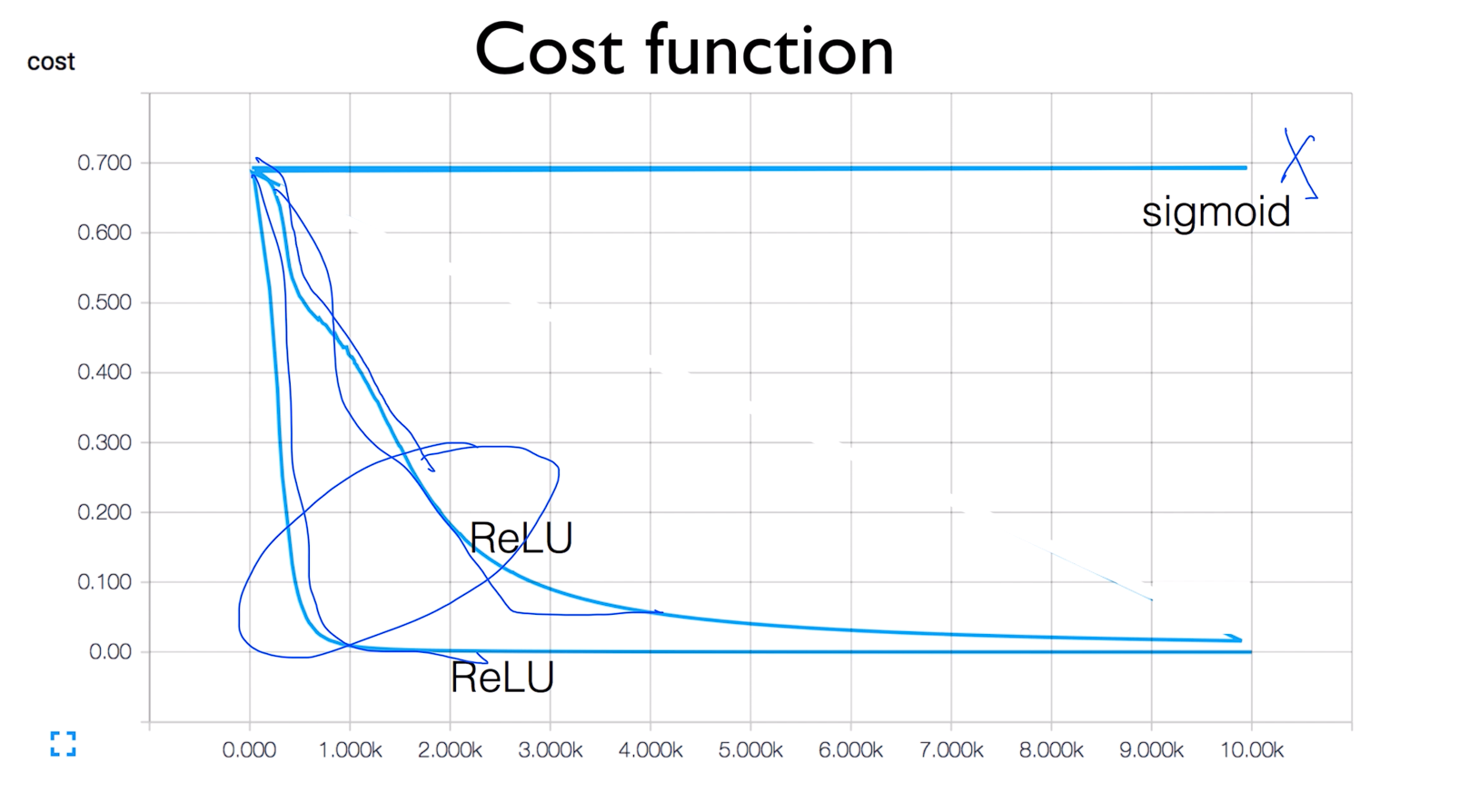

lec10-2: Weight 초기화 잘해보자 Cost function > ReLu를 두번 실행시키면 그래프의 값이 좀 다르게 나온다 그 이유는 실행 시킬때 W를 랜덤값으로 줘서 그런거임 Set all initial weights to 0 > W값을 다 0으로 줘

10.모두를 위한 딥러닝 - ML Lec 10

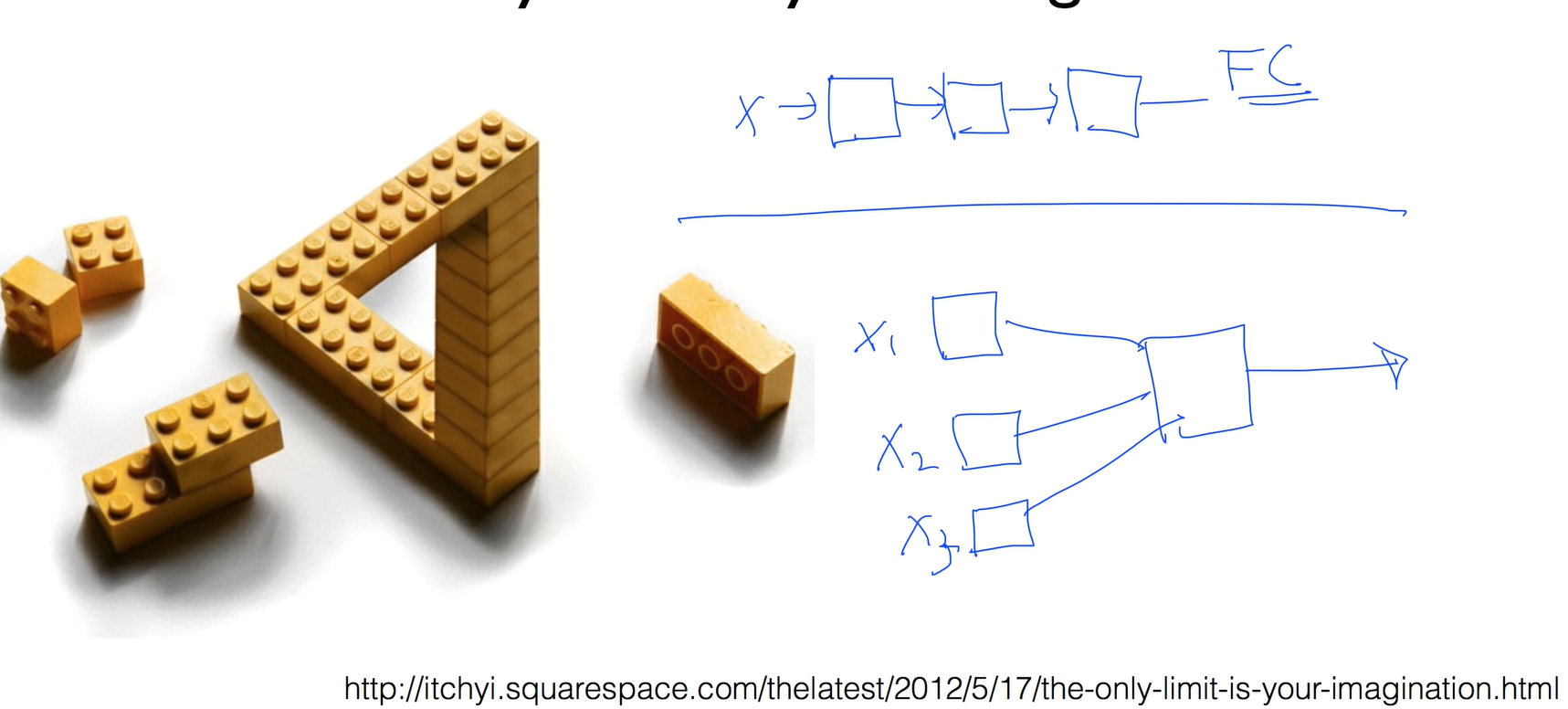

전체가 연결되어있다고 해서 FC 풀릿 커넥티드입력을 여러개로 나눈다음 하나로 합치고 앞으로 내보내는걸 생각해볼 수 있는데컴포셔널 뉴럴 네트워크 - CNN하나의 이미지가 있게 되면 이미지를 잘라서 넘기게되는데 이 창을 컴보셔널레이어 라고 한다.중간에 RELU창을 넣고 중

11.모두를 위한 딥러닝 - ML Lec 11

전체가 연결되어있다고 해서 FC 풀릿 커넥티드입력을 여러개로 나눈다음 하나로 합치고 앞으로 내보내는걸 생각해볼 수 있는데컴포셔널 뉴럴 네트워크 - CNN하나의 이미지가 있게 되면 이미지를 잘라서 넘기게되는데 이 창을 컴보셔널레이어 라고 한다.중간에 RELU창을 넣고 중

12.모두를 위한 딥러닝 - ML Lec 12

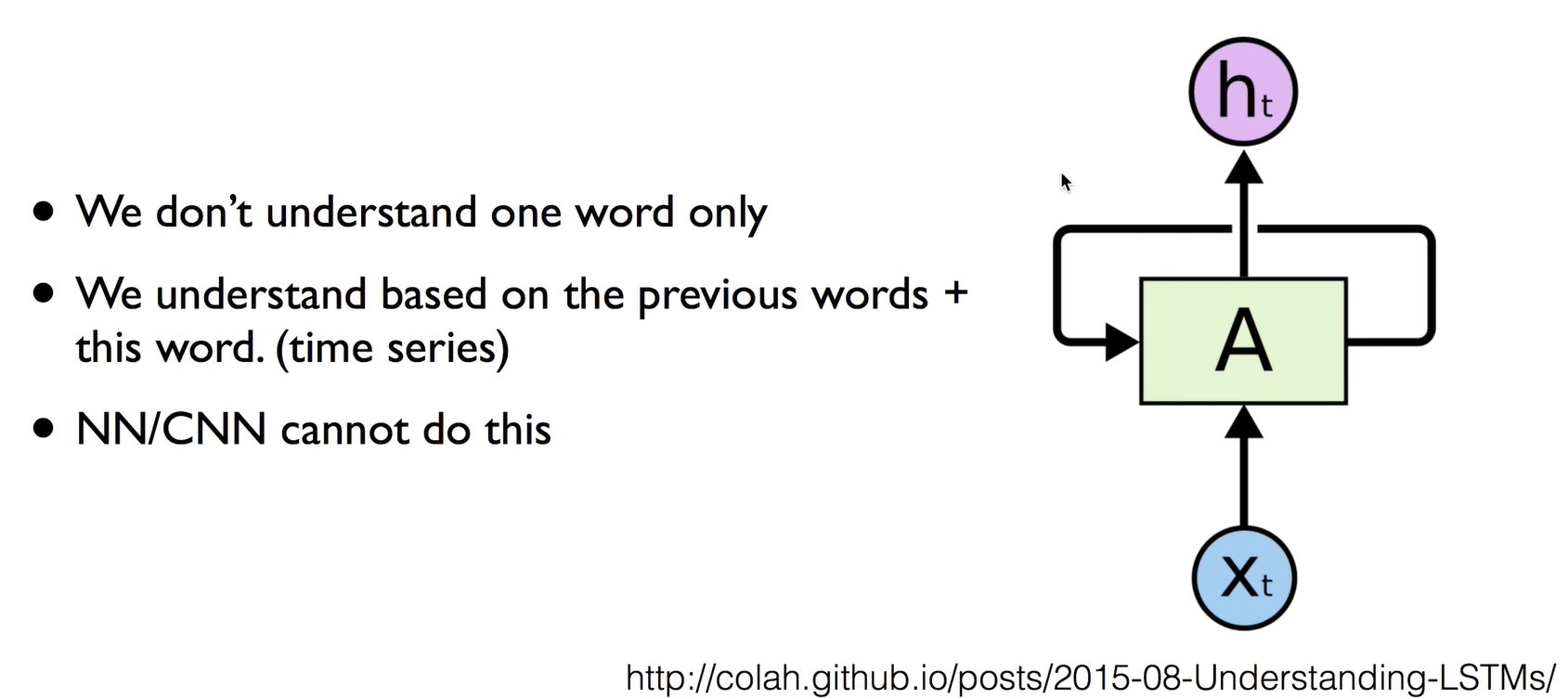

We don't understand one word onlyWe understand based on the previous words + this word. (time series)NN/CNN cannot do this우리가 사용하는 데이터중에서는 시퀀스 데이터들이 많