Learning rate

Gradient descent

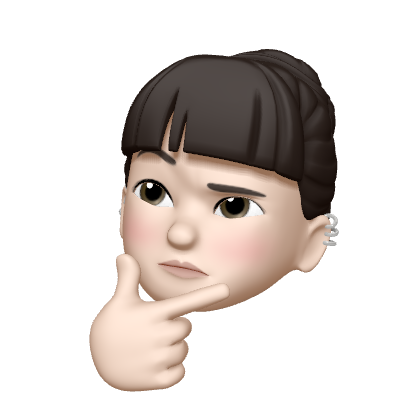

cost function을 최소화하기 위한 필요한 것으로 learning rate 존재

- Large learning rate: overshooting

- cost function이 줄어들지 않고 큰 값으로 가다가 튕겨나감 - Small learning rate: takes too long, stops at local minimum

보통 0.01부터 시작함

|  |

|---|---|

| learning rate = 1.5로 부여, cost 값이 nan 값이 나온다 -> learning rate가 클 수 있다는 것을 파악 | learning rate = 1e-10 부여, cost 값이 일정하게 나온다 -> local 에 빠졌거나 learning rate가 너무 작다는 것을 파악 |

processing for gradient descent

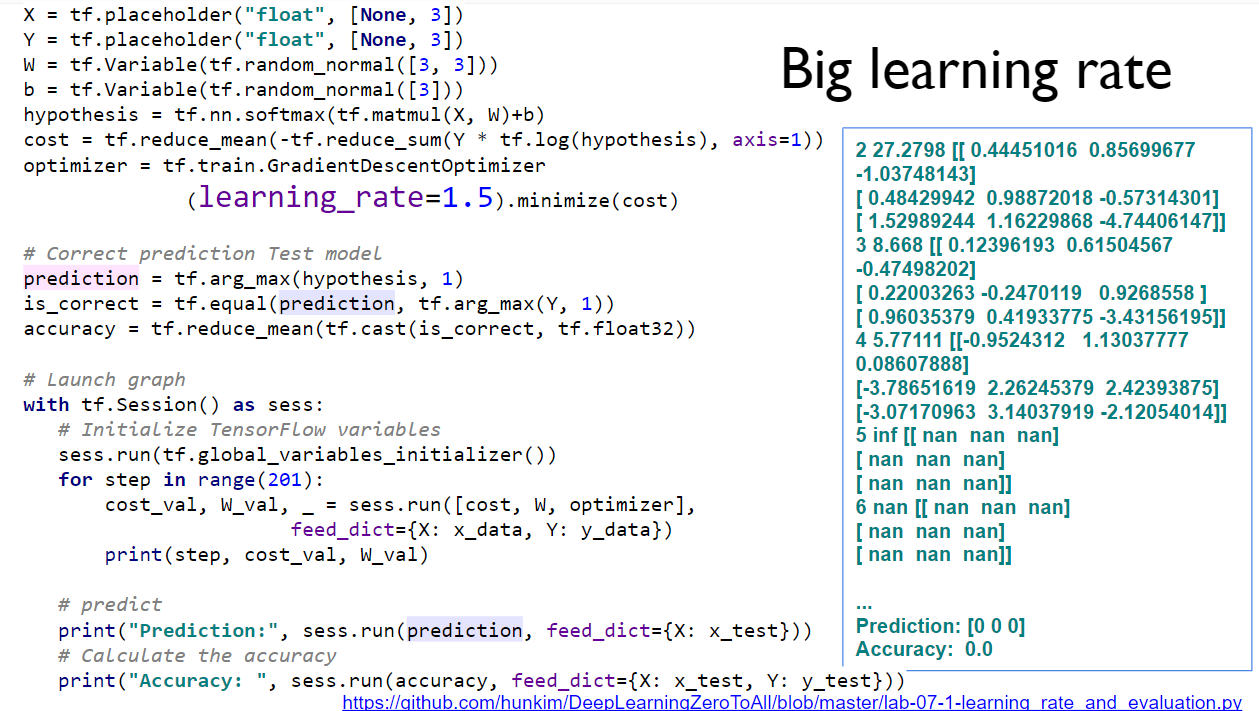

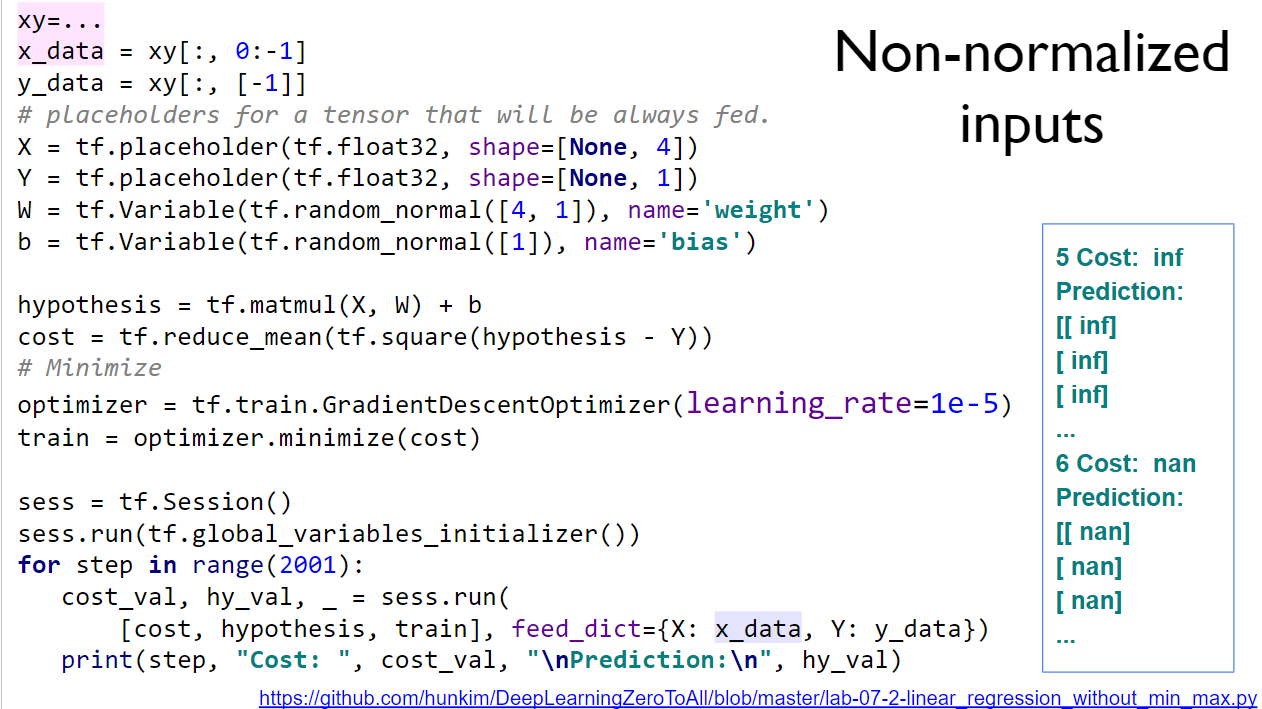

값의 변동이 클 때 -> normalize할 필요가 있다

값의 변동이 클 때 -> normalize할 필요가 있다

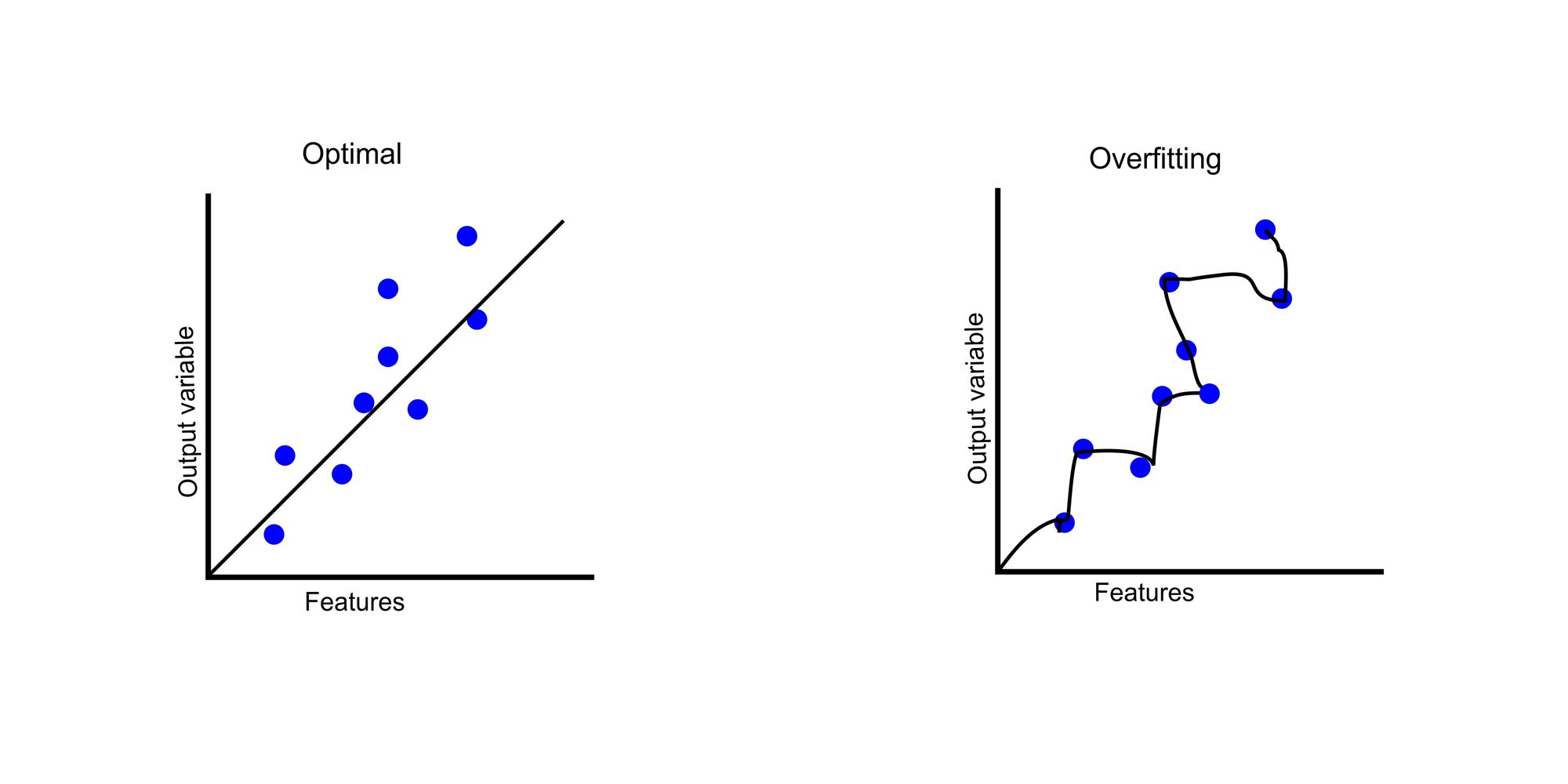

Overfitting

Solution for overfitting

- 더 많은 학습

- 피처 수들을 줄일 것

- ragularization

regularization

weight 를 줄이자

train, test set

Accuracy

- how many of predictions are correct?

- 95 ~ 99 %

Normalization

| x 값이 normalization이 안되었을 수도 있다는 것을 파악 | -> MinMaxScaler 사용(Min 0, Max 1로 설정 후, 값들 변경) |

- 이전과 동일한 작은 learning rate인 1e-5 로 학습하였는데도 학습 결과가 잘 나온 것으로 보아 normalization이 필요로 하는 것이 보임

- data 값들이 너무 크거나 들쑥날쑥한 것들은 normalization을 거칠 것