이해했다고 생각했는데 이해한 것이 아니었을 때!

그때가 남아서 공부해야 할 때...가 아닐까! 진작에 남아서 공부했어야 하는데..이런 후회가 몰려오지만 어쩔 수 없지.. 지금부터 하나하나 차근차근 해결해 나가자 ㅎㅎ

남아서 적는 TIL 가보자고

📝 오늘 공부한 내용

분류 (Classification)

- 데이터에 라벨을 붙여주는 작업

- 주어진 데이터(X)를 원하는 분류 기준(y = label)

Image Classification

single object

- classification: 이미지에서 물체 분류 (고양이가 있는 이미지라면 '고양이'라벨)

- classification + localization: 이미지 분류 + object가 있는 위치 파악

multiple objects

- object detection: 여러 object 찾고자 하는 애들을 찾는 것

- bounding box(bbox): 어떤 물체를 찾고, 어디에 있느냐 - instance segmnetation: pixel classification을 통해 정확한 영역을 찾는다

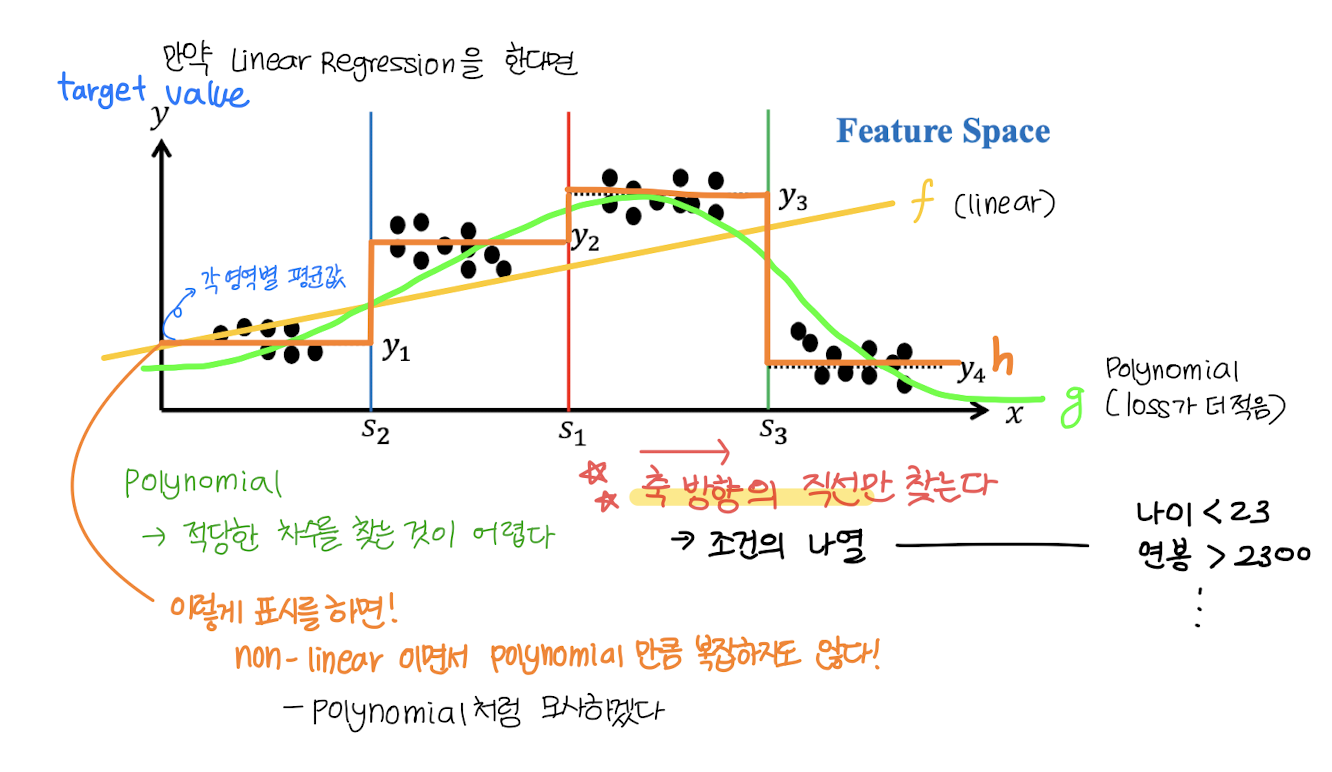

Linear Classifier

- 3차원 공간에서 hyperplane (decision boundary를 통해 평면을 기준으로 데이터가 분할)을 만들어 parameter 기준으로 데이터를 분류

- 고차원 공간에서는 non-linear인 decision boudnary가 더 분류 성능이 높다.

- 학습하고 난 후에 선을 그음

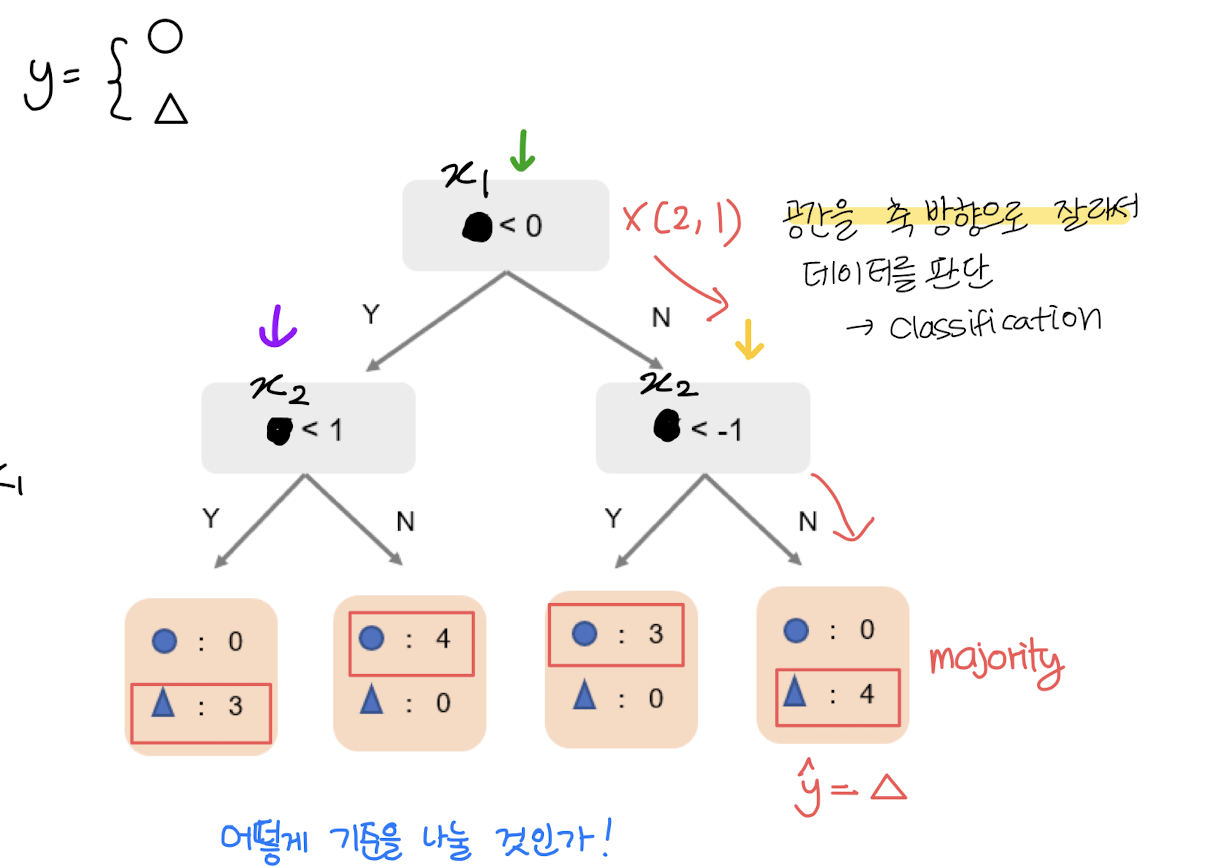

Decision Tree

Development Flow

Decision Tree (2001) Random Forest Gradient Boosting Machine

(2015) XGBoost (2016) LightGBM (2017) CatBoost

ㄴ> 얘네는 진짜 중요하니까 꼭 기억해두자

CART (Classification and Regression Trees)

- white box model: 내부 구조가 훤히 보임

- 모델을 학습할 때 분류, 회귀 중 하나를 골라야 함!

non-parametric learning

트리에는 파라미터가 없다!

train: tree build

- 트리를 만드는 것이 학습 과정

- 학습을 하면서 선을 긋는다라고 생각하자~

predict: tree traverse

- 트리를 순회하면서 데이터 예측

Regression Tree

Classification Tree

- best split = GINI Index

- how to choose the root node?

- calculate information gain

- choose the one with max gain value

🌷 느낀점

솔직히 나는 공부한다고 해놓고 마땅히 공부한 적도 없고...

화이팅 해야지

20대 중 1년을 공부하러 왔으니 해야지.. 화이팅! 항상 본인이 설명할 수 있는지 메타인지를 깨운 상태가 됩시다~