TIL

1.TIL - 2023.05.30

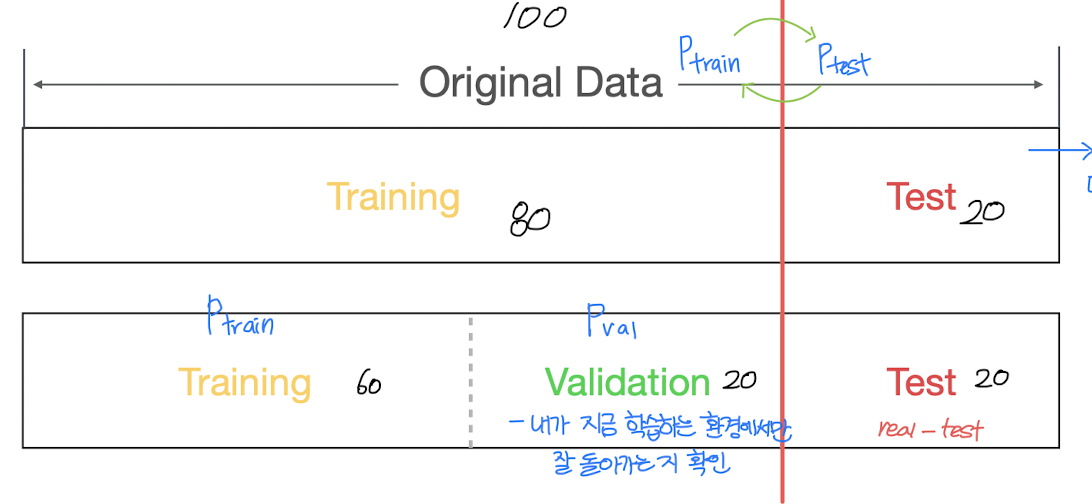

이제 머신러닝 advance과정으로 들어가게 되었다.인공지능회귀분석, 머신러닝basic에서 언제 시간이 이렇게 흘러 머신러닝 advance로 들어가게 되었는지... 이러다 배웠던 지식들이 사라질 것 같아 TIL을 작성하게 되었다. 데이터 분석 문제 정의데이터 용도에 따

2.TIL - 2023.05.31

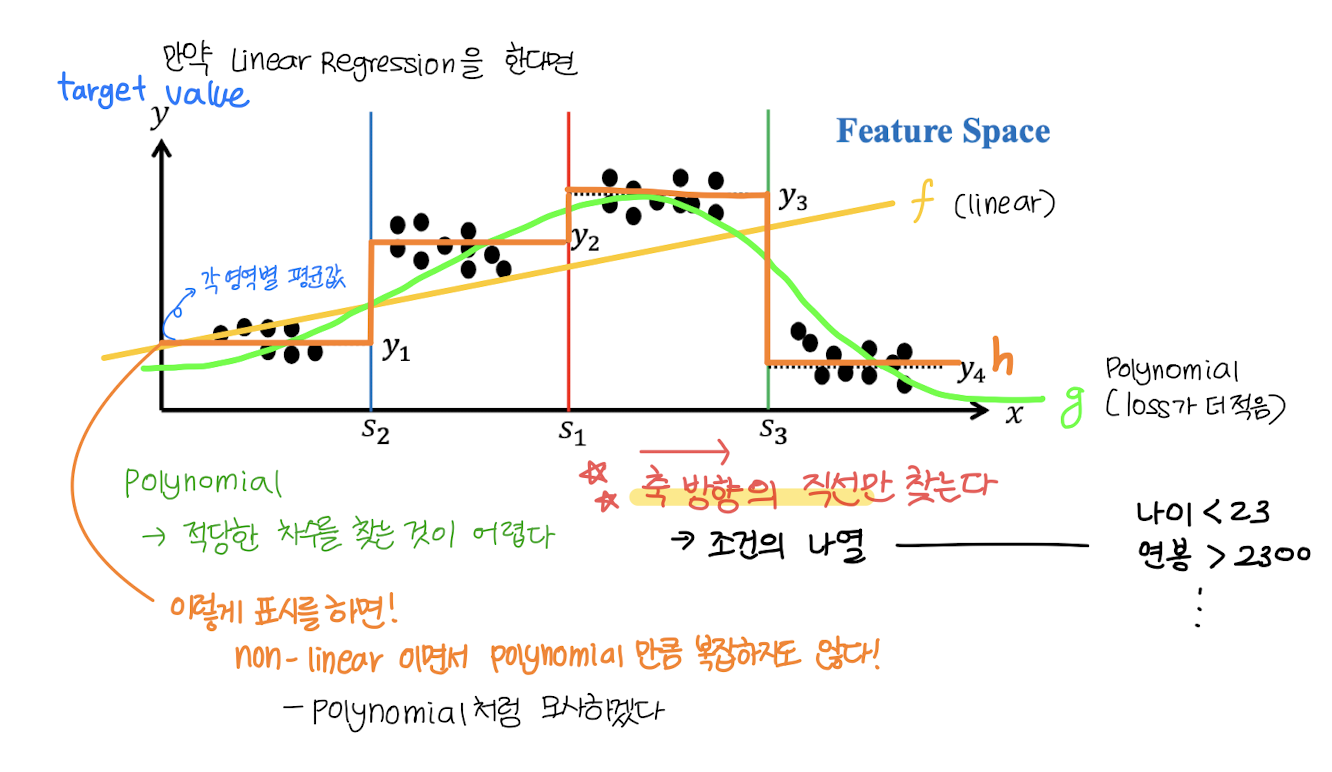

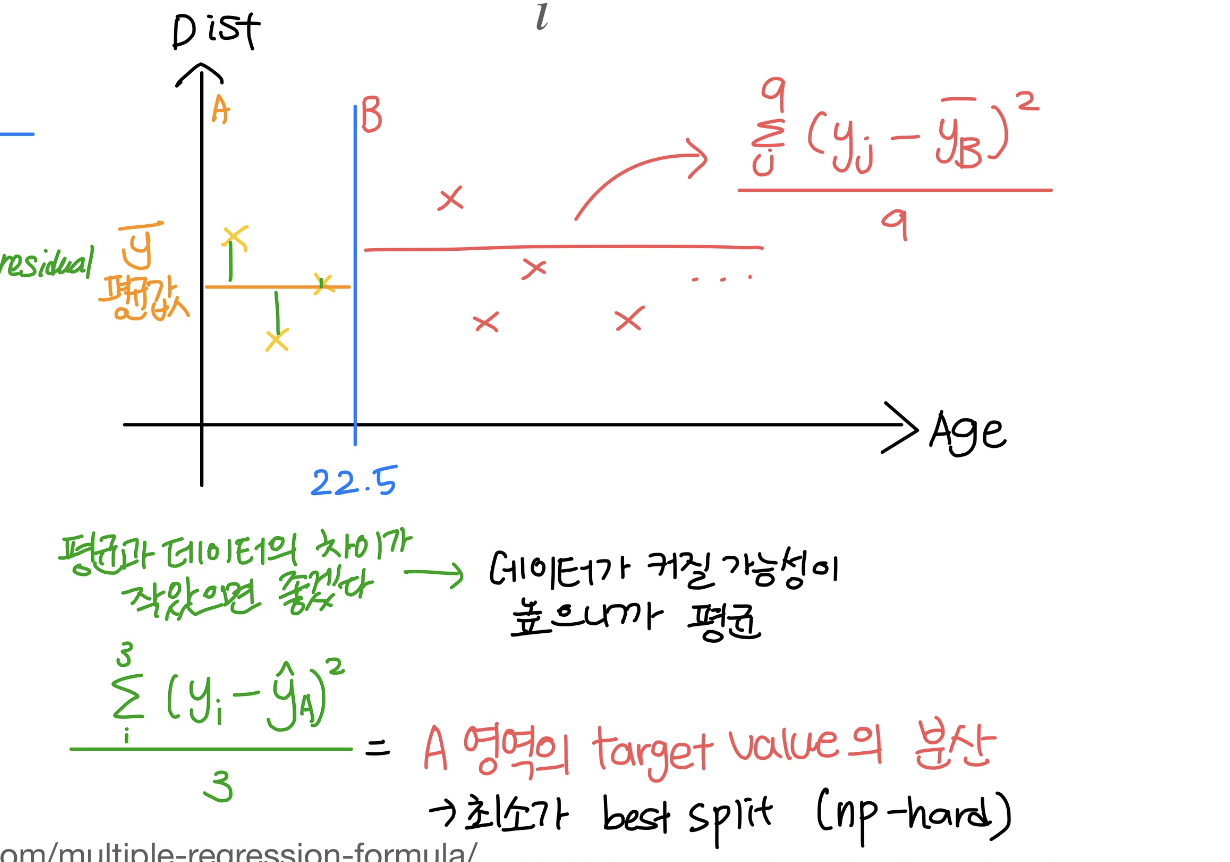

이해했다고 생각했는데 이해한 것이 아니었을 때!그때가 남아서 공부해야 할 때...가 아닐까! 진작에 남아서 공부했어야 하는데..이런 후회가 몰려오지만 어쩔 수 없지.. 지금부터 하나하나 차근차근 해결해 나가자 ㅎㅎ남아서 적는 TIL 가보자고데이터에 라벨을 붙여주는 작업

3.TIL - 2023.06.01

벌써 6월이라니! 믿기지 않아...2023년의 절반이나 왔다니 ㅎㅎ2023년의 남은 6개월도 뒤돌아 봤을 때 후회하지 않고 웃을 수 있는 나날들이 가득했으면 좋겠다.$$\\text{Gini Index} = 1 - \\displaystyle\\sum\_{i=1}^{k}{

4.TIL - 2023.06.02

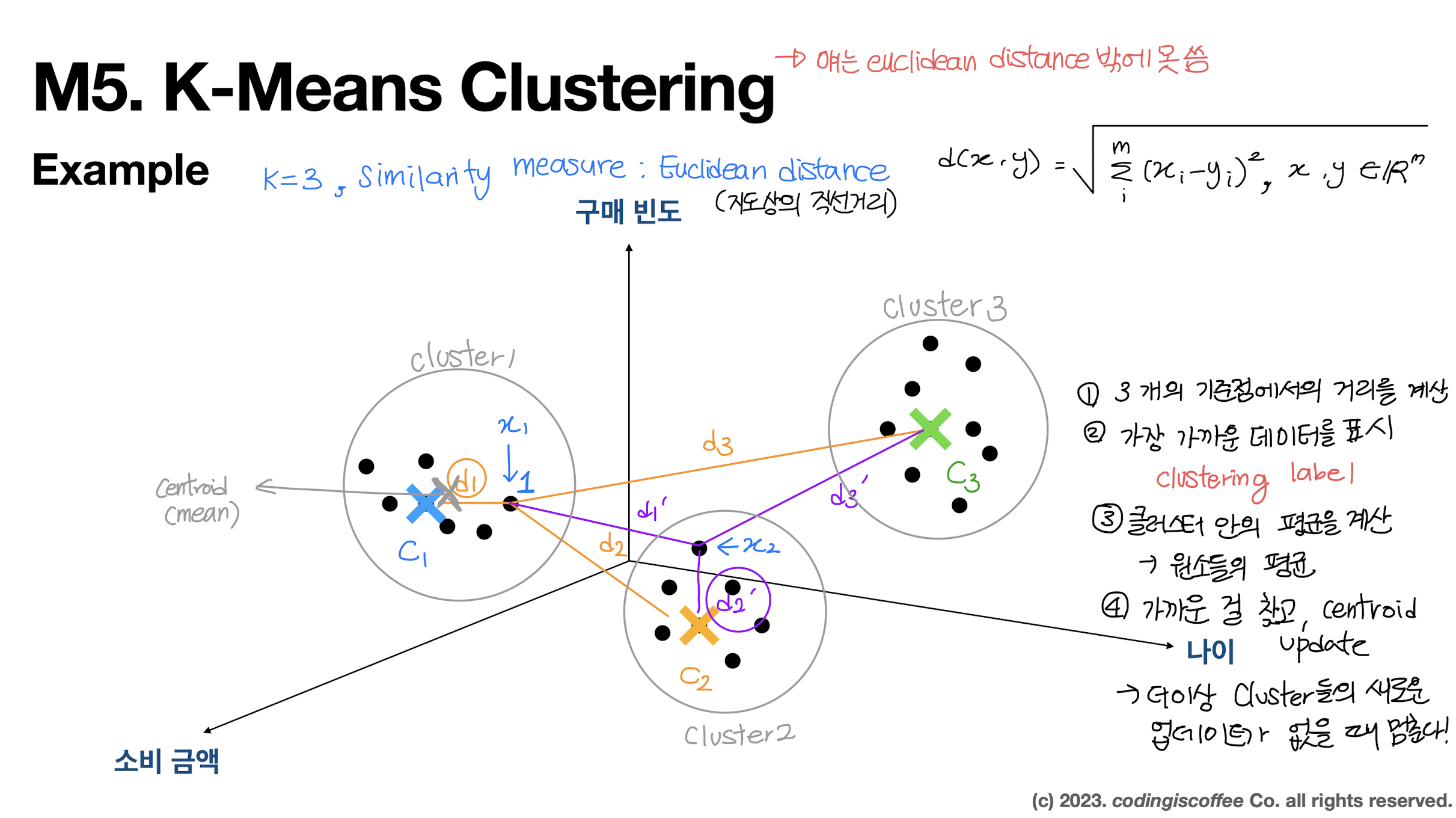

unsupervised learning \- 데이터에 정답이 필요 없다. (학습할 때 사용하지 않는다.)💡 clustering과 classification은 다르다!classification은 사과, 복숭아, 오렌지, 토마토, 배추, 청경채라는 데이터가 있을 때 '

5.TIL - 2023.06.05

오늘은 샌드위치 날이라서 그런가 사람들이 정말 많이 오지 않았다.9시에 시작인데 딱 50명 있었나? 그정도로 사람이 많지 않아 나도 기분이 굉장히 해이했다. 집중하기도 힘들고...오늘부터 중요한 XGBoost 같은 개념을 나간다고 해서 정말 탈주하고 싶었지만 ㅎㅎ 참았

6.TIL - 2023.06.07

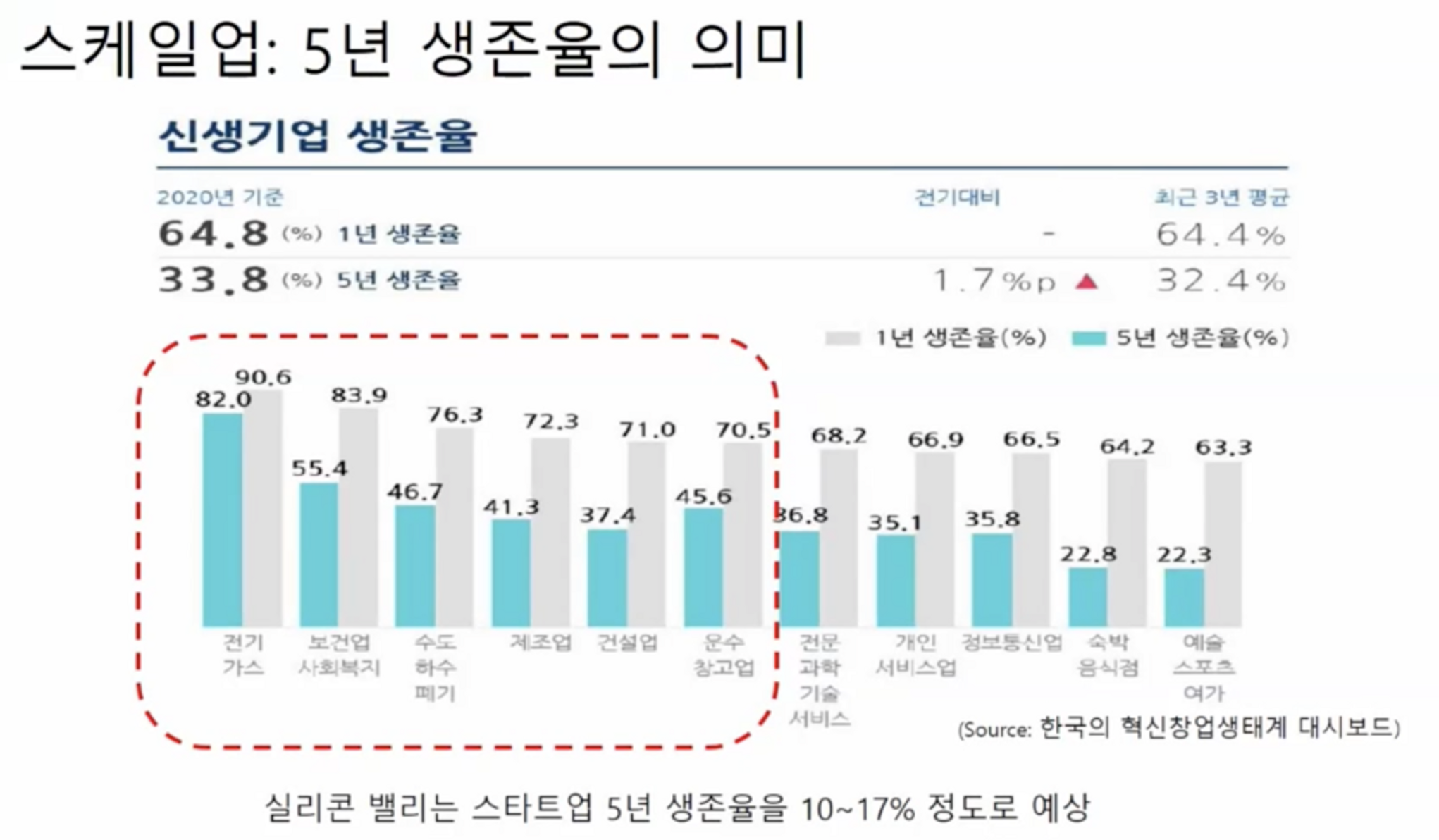

오늘은 XGBoost 다음으로 LightGBM을 배웠다. 수업 시작하기 전 강사님이 DS 과정의 미래?에 대해 설명해 주시는데 역시 대학원밖에 없을까...하는 생각이 들었다. 대학원을 바로 가야하나.. 그런 생각과 대학원을 간다면 나는 어떻게 발전될 수 있을지 (무엇을

7.TIL - 2023.06.08

오늘은 이론 공부는 없었고 실습 코드만 하루종일 돌렸다.실습 진행하면서 기억 해야할 몇 가지를 적어봐야지으로 데이터를 붙일 때는 자동으로 인덱스를 바꾸는 것이 아니라서처음 들어간 데이터를 바탕으로 DataFrame인덱스가 설정된다.예를 들어, traintrain.num

8.TIL - 2023.06.09

블로그 글 (too private)으로 시작한 것들이 적다보니 too professional 해지기 시작한다.이런 내용을 고도화하고 싶어져 연구를 시작하게 됐다.불분명한 것들 (헷갈리는 명제를) formula, equation을 사용해 이론을 가져와 설명을 하면 'cl

9.TIL - 2023.06.12

오늘은 XGBoost 논문을 배웠는데.. 이건 차근차근 기술블로그로 다시 훑어보며 작성하는게 나을 것 같다.괜히 지금 어설프게 건드렸다가 다 까먹을 것 같아..지금은 아침에 공부하러 오면서 책을 <<1년 안에 AI 빅데이터 전문가가 되는 법>> 책을 읽고 있

10.TIL - 2023.06.13

맥 말고 윈도우로 쓰는 벨로그는 ... UI가 너무 다르고 딱딱한 것 같다... 마크다운도 미리보기에서는 너무... 굴림체 아니오?Categorical feature에 대해서 학습이 잘 되도록 설계되어 있다.데이터의 갯수를 살펴보자!데이터의 갯수가 10000개 이하라면

11.TIL - 2023.06.14

K개의 이웃을 고려하여 현재 데이터의 값을 예측KNN과 KMeans는 같지 않다!데이터를 분석하고자 하는 목적에 맞게 가공하는 과정raw data --> (feature engineering) --> feature vecotrfeature space의 차원이 커질수록

12.TIL - 2023.06.15

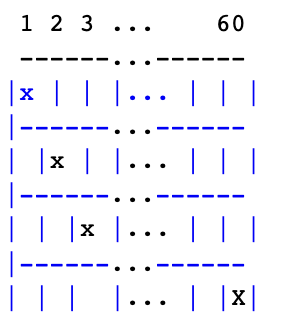

K-Fold Cross Validation 기법을 활용해서 더 나은 예측을 얻는 예측 기법K개의 모델을 각각 따로 학습 시켜서 K개의 모델이 성능이 가장 높게 나오는 파라미터 조합을 찾는 방식ProcedureGrid로 6가지 하이퍼 파라미터 조합이 있다면5 fold로

13.TIL - 2023.07.24

테이블 형태의 데이터를 분류하는 트랜스포머less than a second로 분류가 가능하고하이퍼 파라미터 튜닝이 필요 없다PFN은 Bayesian inference를 활용하여 synthetic 데이터셋을 만들어 낸다프로그래머스 > 탐욕법 > 체육복(https:

14.TIL - 2023.07.25

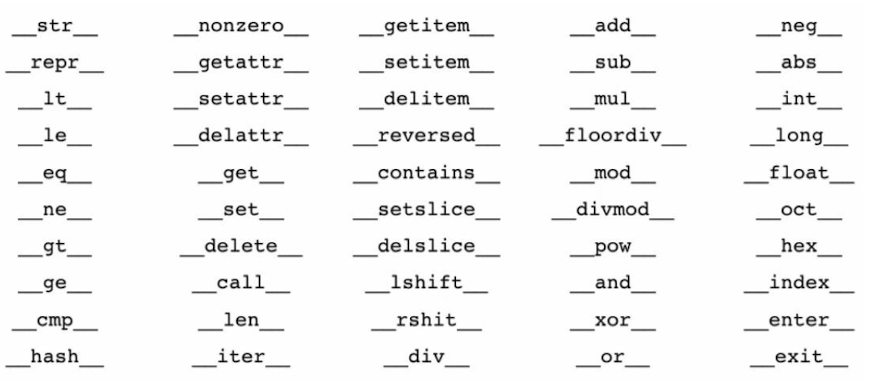

절차를 차례대로 실행문제점하나의 수정 사항이 뒤에도 큰 영향을 미칠 수도 있다하나를 고치면 나머지를 고쳐야 할 수도...객체 단위 코드 작성 및 분업Class당 여러 Object을 가질 수 있다.Object들은 다른 Attribute를 가질 수 있지만 Method는 동

15.TIL - 2023.08.09

오늘

16.TIL - 2023.08.12

오늘은 하루종일 잠만 잔 것...같기도 하고...오빠랑 카페가서 lck도 보고 (왜 베인을 했는가!!!) 집와서 아빠랑 오빠랑 밥먹고... 나름 힐링하는 하루를 보낸 것 같다! 엄청나게 집중해서 공부하지는 못했지만 그래도 나름 힐링하는 나날을 보낸 것 같다.목요일은 스

17.TIL - 2023.08.21

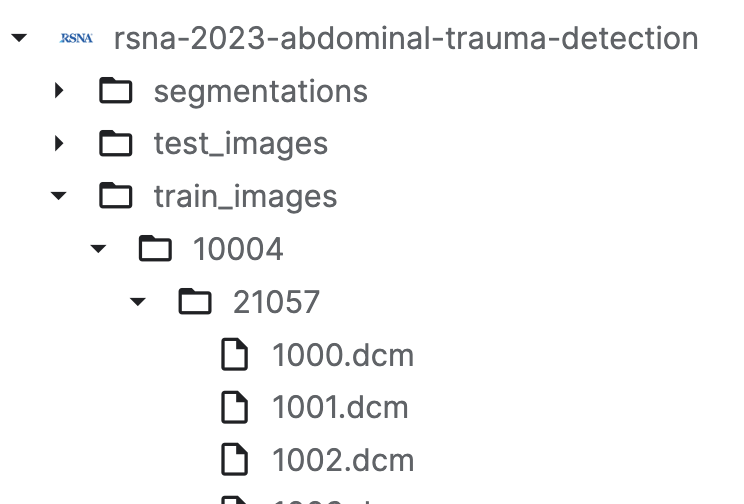

글로벌 클래스 간략하게 읽어가기 모각공 독서 TIL 작성 샐러드 먹기 AWS 환불 메일 작성외상성 복부 부상 판별RSNA EDA | Understanding the Data Firsttrain에서 Keras 모델 생성inference에 만든 Keras 모델 업로드li

18.TIL - 2023.09.12

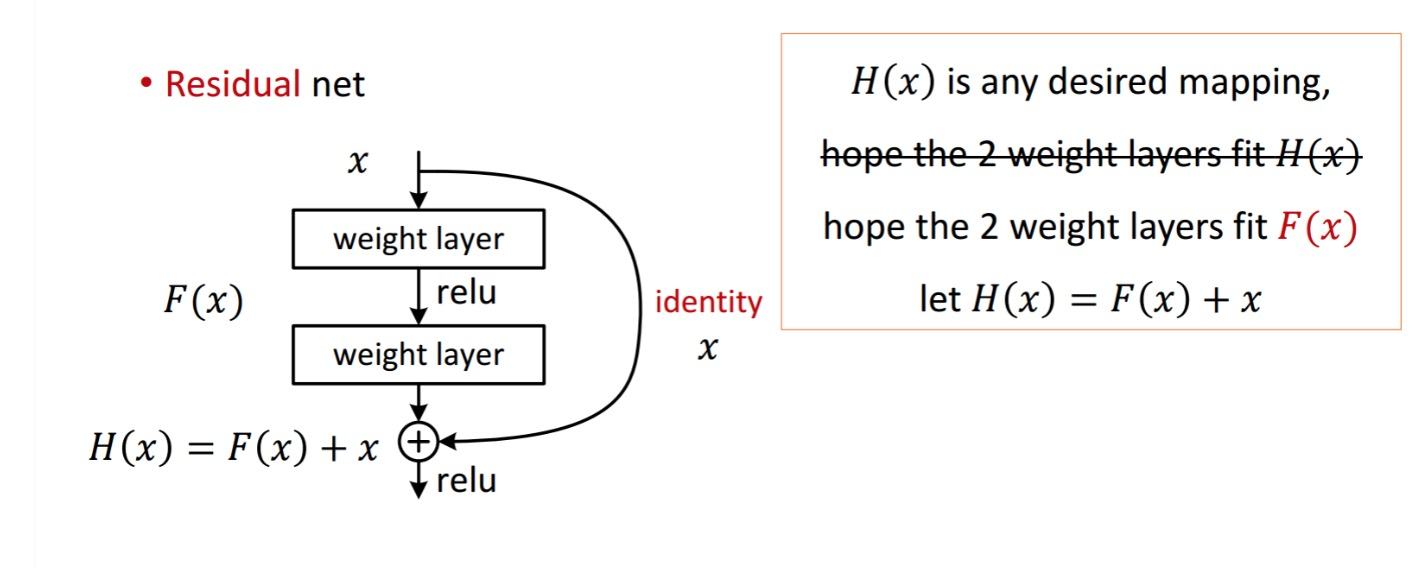

오늘은 저번에 배웠던 CNN, RNN을 이어 다양한 convolutional network 기법들을 배웠다. 다양한 기법이라고 해도 ResNet 나오기 전이라 이제는 역사속으로 사라졌지만 그래도 ResNet이 어떻게 나오게 됐는지, 각 기법들의 shortcomings이

19.TIL - 2023.08.28

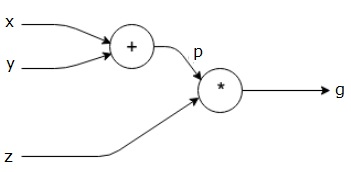

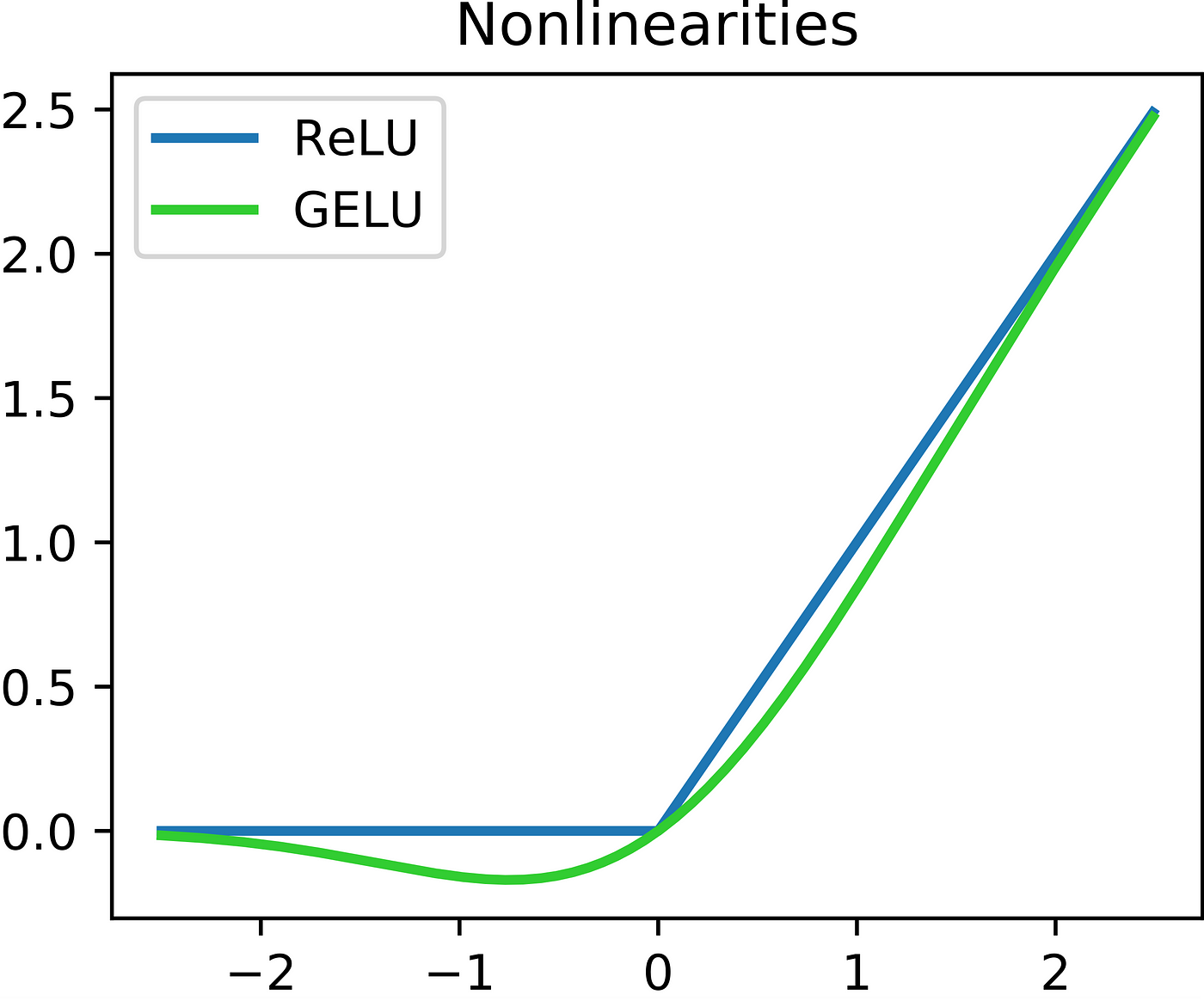

잊기 전에 빨리 쓰는 오늘의 TIL출력층에서 입력층 방향으로 오차를 전파시키며 각 층의 가중치를 업데이트 하는 방식인풋이 2차원 이상; 2개 이상의 변수를 가지는 함수를 다변수 함수라고 하는데, 다변수 함수 $f(x, y)$ 를 $x$로 편미분 하는 것을 $\\frac

20.TIL - 2023.09.11

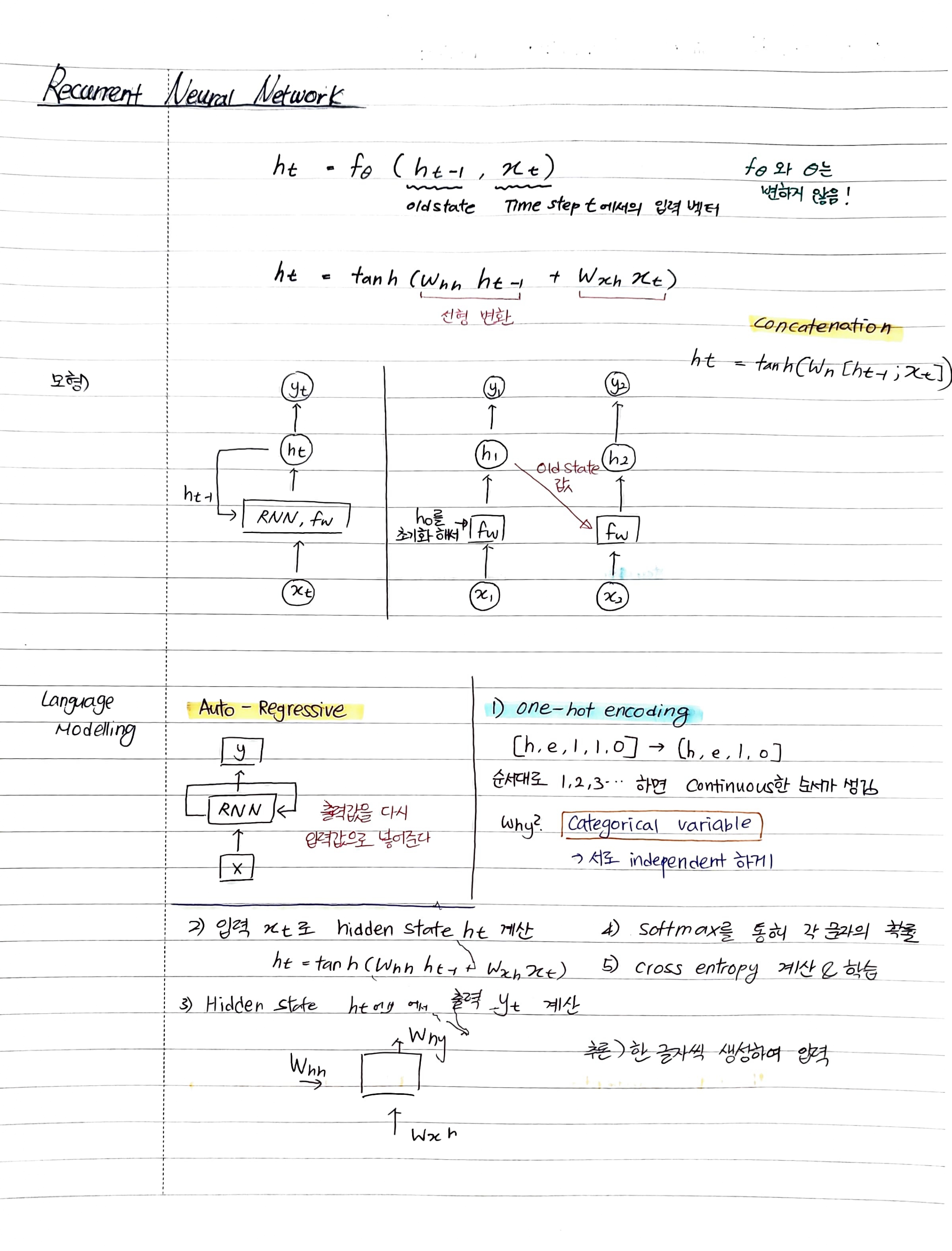

RNN의 단점LSTMself-attentionTransformer다 복습은 못하고 LSTM까지만 했다. 금요일 특강 강의에서 attention이랑 transformer를 공부해서 오늘은 어느정도 채워넣는 느낌이 들었다. 오늘 느낀 것은 노트에 적어가면서 공부하니 오히려

21.TIL - 2023.09.13

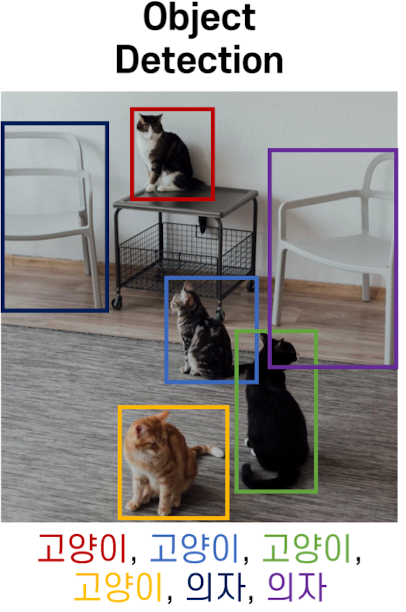

CV 이론글창사 - 투자 유치 강의 듣기오늘은 드디어 드디어 컴퓨터 비전 수업을 시작했다. 솔직히 많은 사람들이 컴퓨터 비전이나 생성 모델, nlp를 듣고 싶어서 지금까지 버틴게 아닐ㄲ....지금 11시 20분... 막차를 타기까지 시간이 얼마 안남아 뼈대만 잡고 집으

22.TIL - 2023.09.18

날짜를 적고 보니 벌써 9월의 반이 지나갔다.이렇게 시간이 빠르다니... 17일은 사촌오빠가 놀러와서 공부를 많이 하지는 못했고 밤에 코드만 몇 번 돌려보았다. 오늘은 그동안 사놓고 한번도 안펴본 <밑바닥부터 시작하는 딥러닝> 책으로 부족한 부분만 공부하기로 했다

23.TIL - 2023.09.26

오늘은 NLP 2일차이자 마지막 날..?아직 실습이 남았지만 추석 전으로 무언가를 배우는 날은 끝이고 추석 이후로는 모의경진대회를 한다고 해서 아쉽다ㅠㅜBert도 하이퍼파라미터의 지옥을 벗어날 수 없다...이러한 파라미터들은 에서 관리(?)할 수 있다. BertConf