잊기 전에 빨리 쓰는 오늘의 TIL

📝 오늘 공부한 내용

Backpropagation (역전파)

- 출력층에서 입력층 방향으로 오차를 전파시키며 각 층의 가중치를 업데이트 하는 방식

편미분

인풋이 2차원 이상; 2개 이상의 변수를 가지는 함수를 다변수 함수라고 하는데,

다변수 함수 를 로 편미분 하는 것을 이라고 표현한다.

Gradient

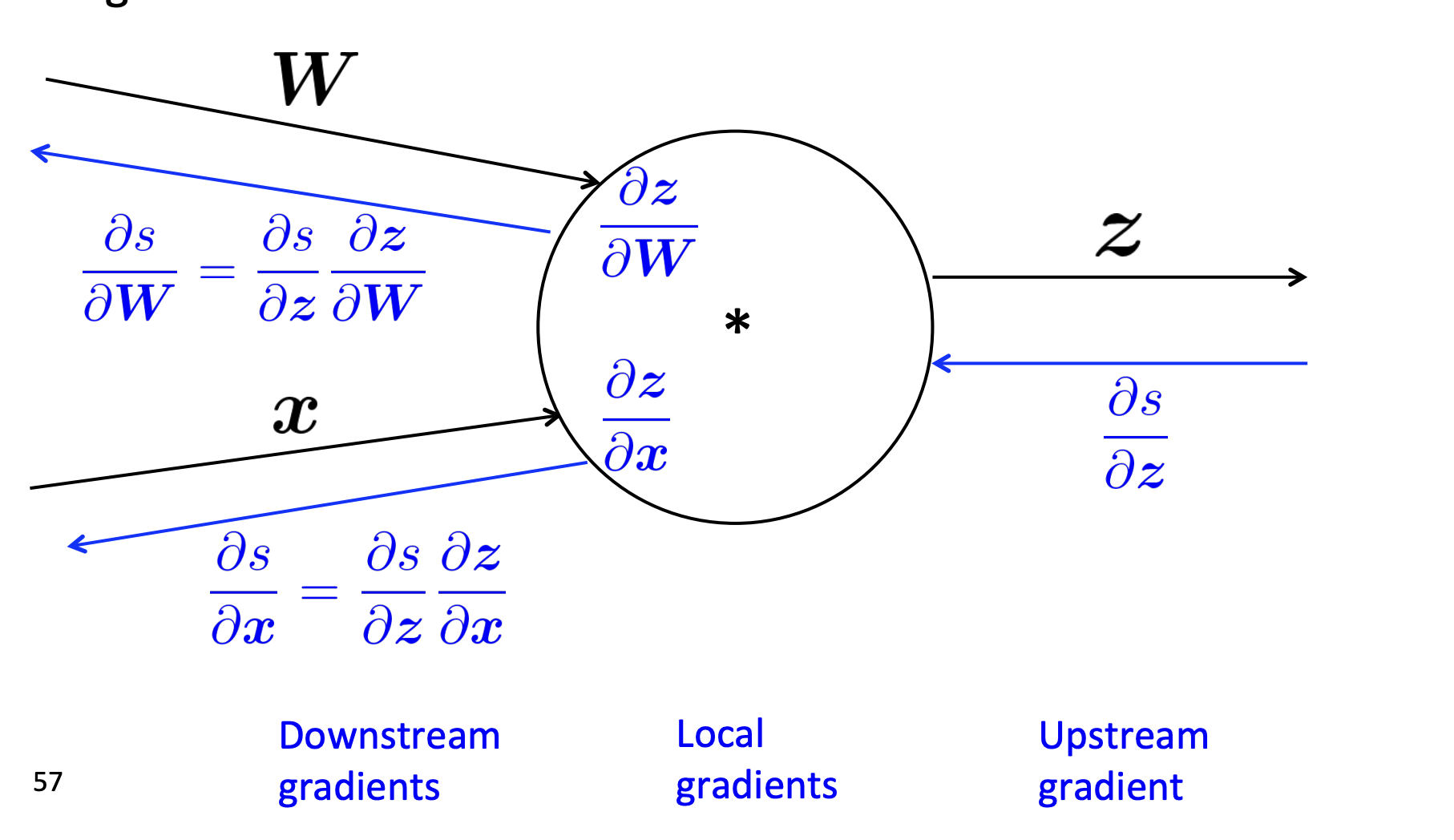

노드는 'upstream gradient'를 받아 올바른 'downstream gradient'를 전달하는 것이 목표!

1. Upstream Gradient

노드의 output에 대한 gradient

2. Local Gradient

Backpropagation을 하기 전에 기존 수식을 통해 구할 수 있는 gradient

3. Downstream Gradient

노드의 input에 있는 변수에 대한 gradient

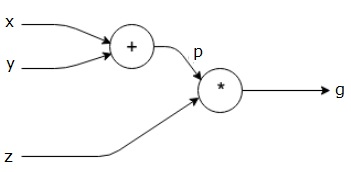

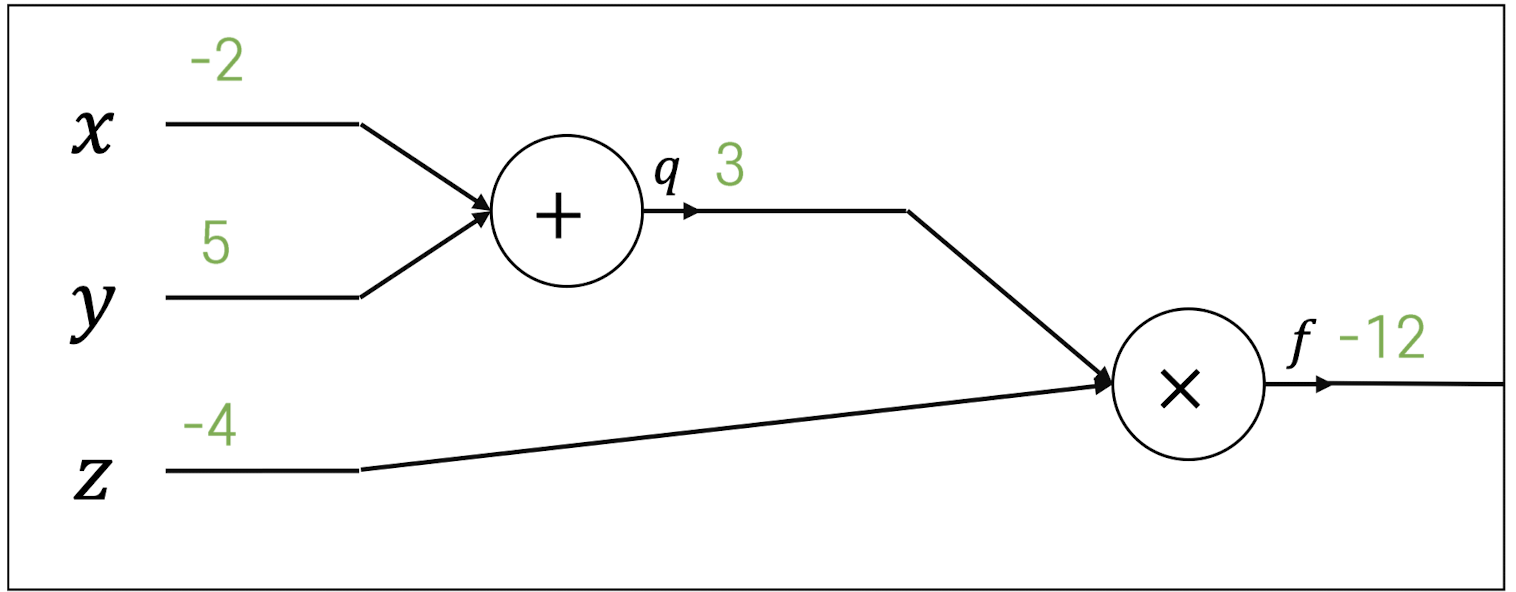

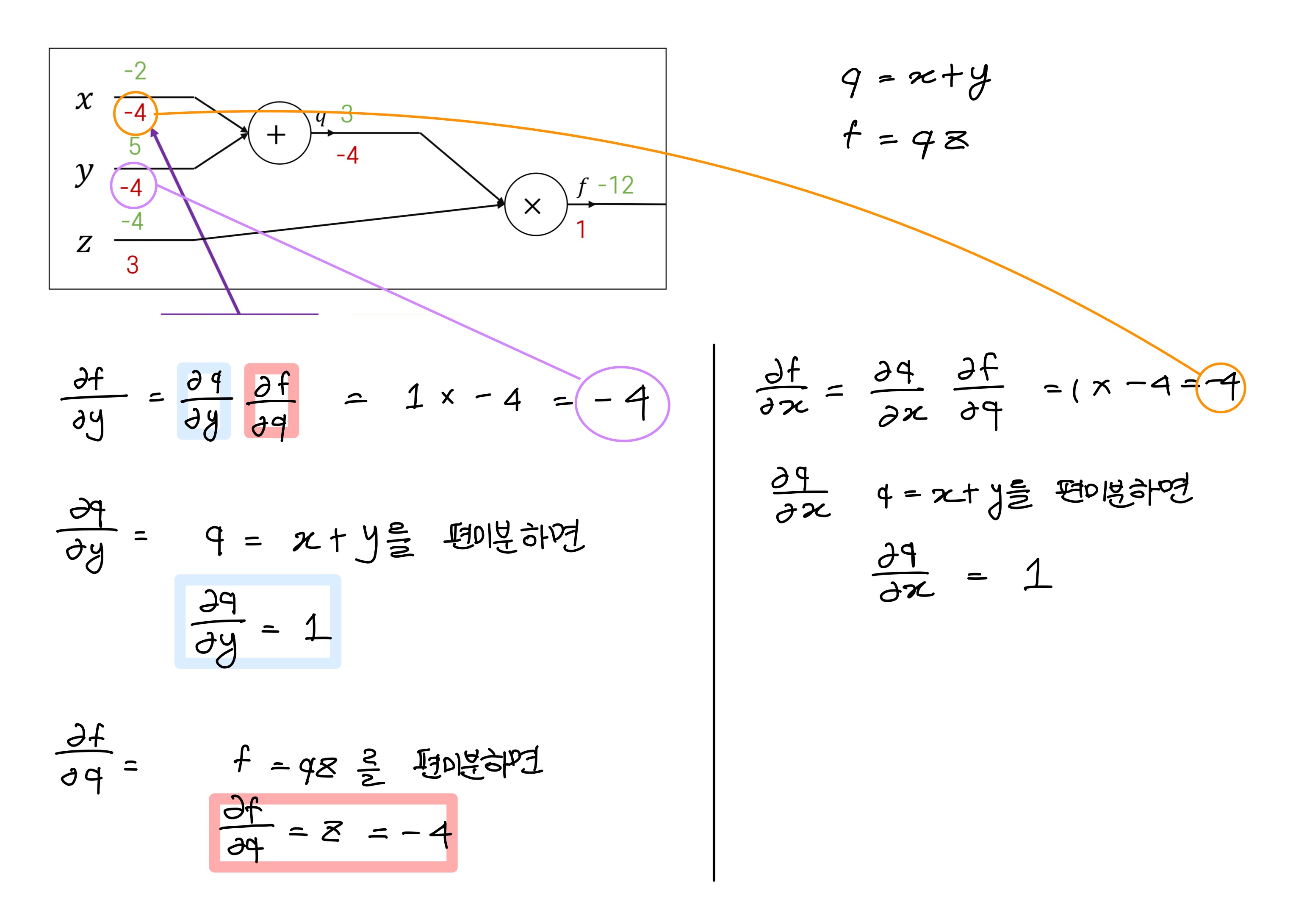

Computational Graph

방향성이 있고 노드가 특정한 연산을 나타내는 그래프

예시)

위 같은 computational graph를 가지고 있다고 했을 때,

,,를 어떻게 찾을 수 있을까?

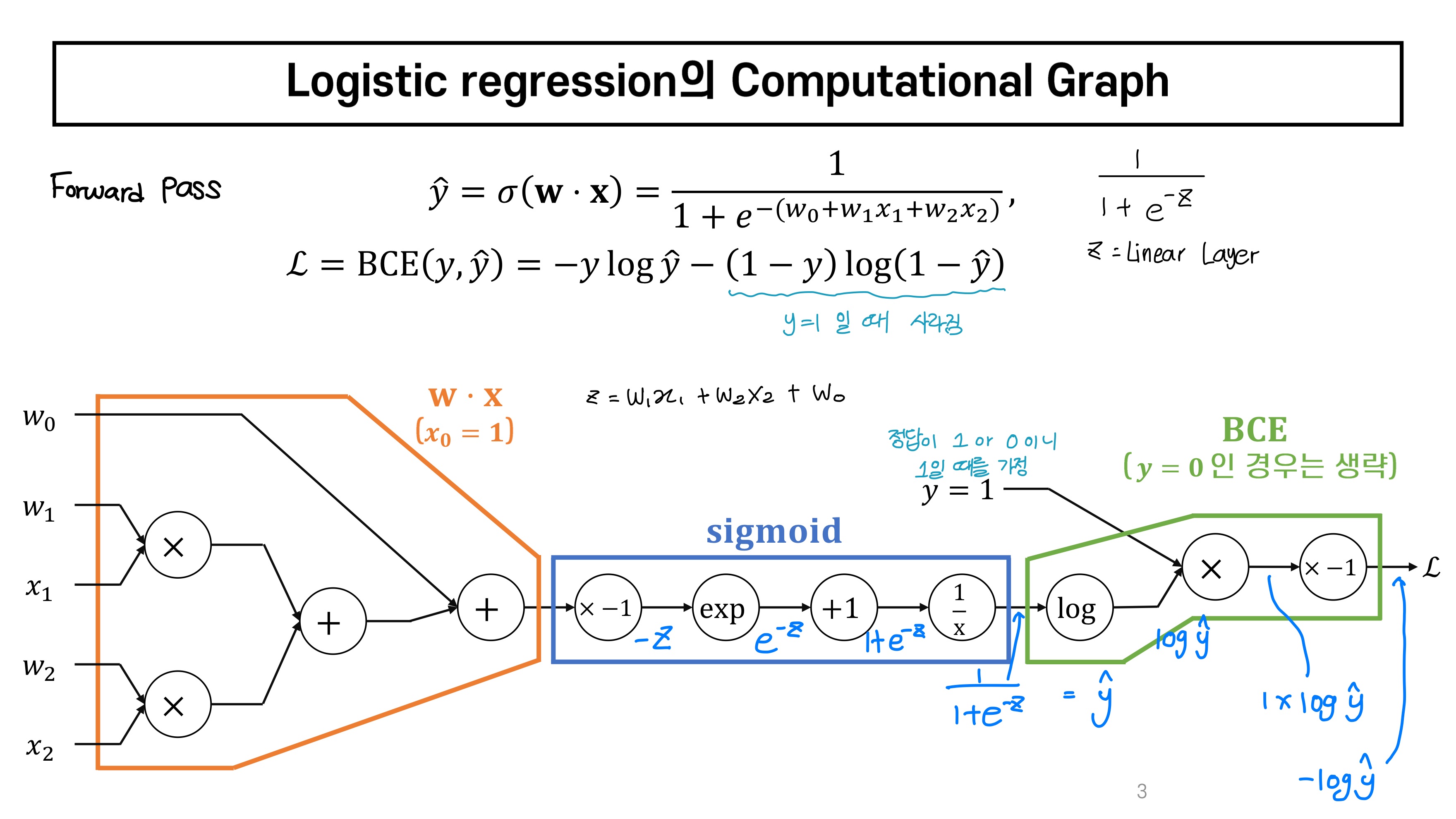

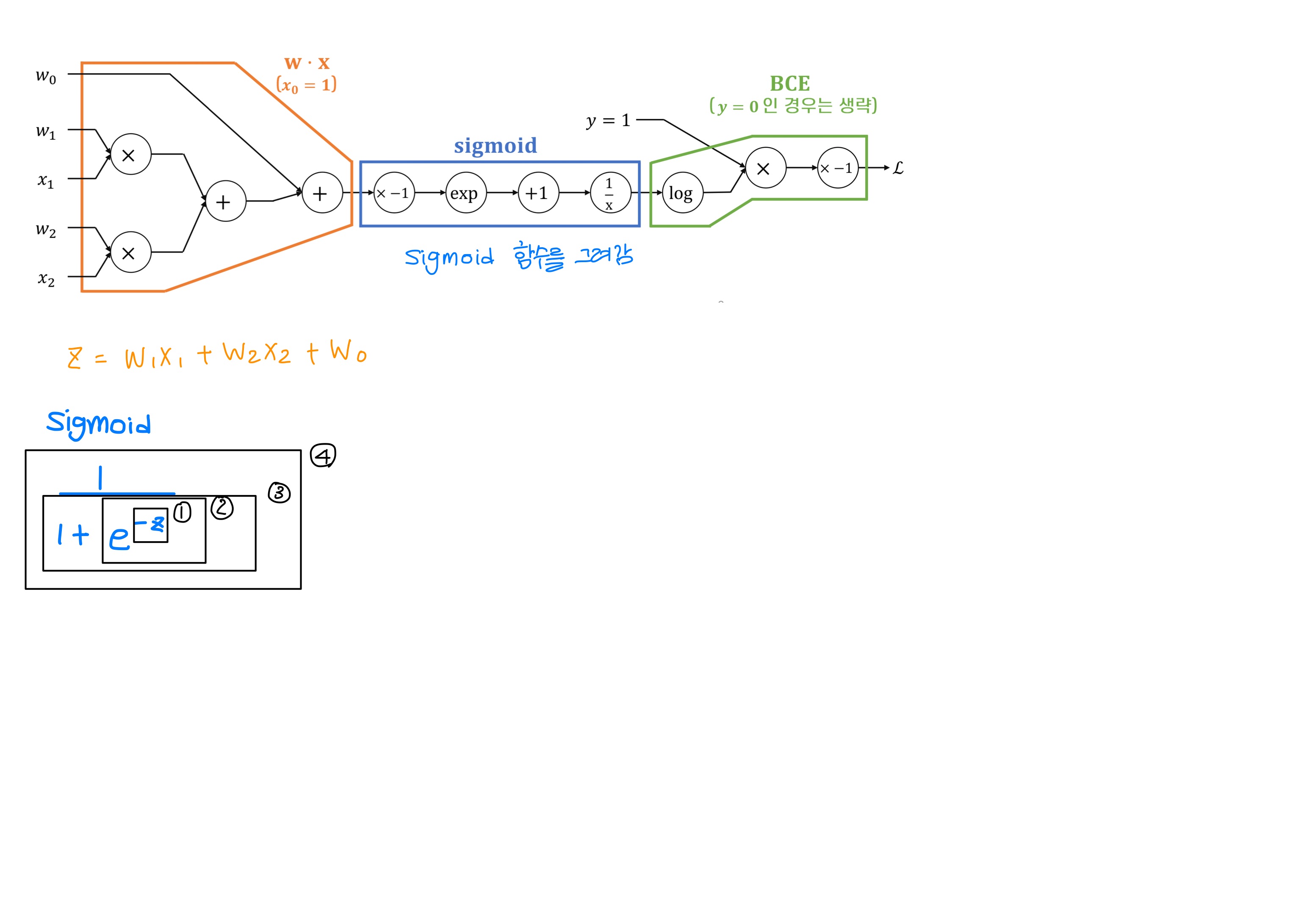

Logistic regresion의 Computational Graph

- 수식 하나하나를 다 풀어서 쓴 것

🍩 더 알아둘 것

Logistic regression이 softmax classifier backpropagation의 특수한 예시라는 걸 수업에는 이해했었는데 다시 보니까 기억이 안난당...내일 강의 올라오면 다시 봐야함

집가서 시청하기

[딥러닝] 6-1강. 역전파 (Backpropagation) | 딥러닝 시대를 열어준 단 한줄의 수식!!

🌷 느낀점 & 오늘 하루

오늘은 아침부터 비가 많이 와서 여름이 끝나가는게 실감이 났다. 내일부터는 뭐 하나 더 입고 와야지. 오늘 자기전에 실습 파일 한번 읽고 자야 돼!!