Source:

해당 블로그 포스트는 위 source들을 참고하여 작성했습니다.

TL;DR

-

해결하고자 하는 문제의 중요성:

- 대형 언어 모델의 환각(hallucination) 현상은 신뢰성을 크게 저해하는 핵심 문제

- 기존 최첨단 모델들에서도 지속적으로 발생하는 근본적 한계

-

기존 접근법의 한계:

- 환각을 신비로운 현상으로 다루어 근본 원인에 대한 체계적 분석 부족

- 후훈련 기법들이 환각을 완전히 제거하지 못하는 이유에 대한 명확한 설명 부재

-

제안하는 해결책의 독창성:

- Is-It-Valid (IIV) 이진 분류 문제로의 환원: 생성 오류를 이진 분류 오류와 연결하는 새로운 이론적 프레임워크

- 사회기술적 관점: 평가 방식 자체가 환각을 강화한다는 통찰

- 명시적 신뢰도 목표: 기존 벤치마크 수정을 통한 실용적 해결책 제시

-

예상되는 파급효과:

- 언어 모델 훈련과 평가 패러다임의 근본적 변화 유도

- 더 신뢰할 수 있는 AI 시스템 개발을 위한 이론적 기반 제공

📖 Chapter 1: Introduction - 환각 현상의 본질과 연구 동기

챕터의 핵심 기여

1. 환각을 신비로운 현상에서 통계적으로 이해 가능한 현상으로 재정의

2. 사전훈련과 후훈련의 역할을 명확히 구분하여 분석 프레임워크 제시

3. IIV 환원이라는 새로운 이론적 도구 도입

4. 평가 방식 자체가 문제라는 사회기술적 통찰 제시

서론은 환각 현상을 새로운 관점에서 바라보는 이론적 틀을 제시하며, 기존의 신비로운 현상으로 여겨졌던 환각을 통계적으로 분석 가능한 문제로 재정의합니다. 전체 논문의 핵심 아이디어인 Is-It-Valid(IIV) 환원과 사회기술적 해결책의 동기를 명확히 제시하는 중요한 도입부 역할을 합니다.

1. 환각 현상의 구체적 정의와 실증적 증거

학생-시험 유추의 심층 분석:

- 저자들은 우리가 직면하고 있는 언어 모델의 환각을 "어려운 시험 문제에 직면한 학생이 불확실할 때 추측하는 행동"에 비유합니다.

- 이 유추는 단순한 은유가 아니라 후반부에서 제시되는 사회기술적 분석의 핵심 토대가 됩니다

- 추측이 최적 전략이 되는 조건:

- 정답 시 1점, 오답이나 공백 시 0점인 이진 채점 시스템 (aka, 찍어서 맞추면 이득인 시스템)

구체적 환각 사례의 상세 분석:

-

Adam Kalai의 생일 질문:

- DeepSeek-V3 모델이 "알고 있다면 DD-MM 형식으로만 답하라"는 명확한 조건부 지시에도 불구하고 세 번의 시도에서 각각 다른 잘못된 날짜를 제공

-

실제 정답:

- 가을(Autumn) - 이는 모델이 계절 정보조차 활용하지 못했음을 시사

-

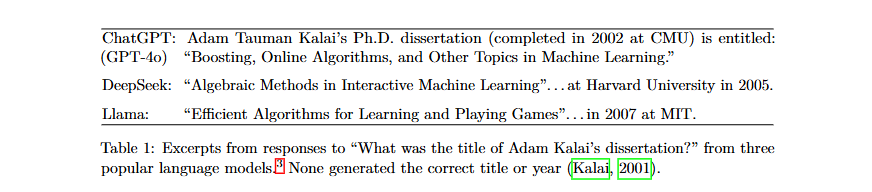

Table 1의 학위논문 제목 환각: 세 개의 인기 언어 모델 모두 완전히 다른 제목과 연도를 생성

- ChatGPT(GPT-4o): "Boosting, Online Algorithms, and Other Topics in Machine Learning" (CMU, 2002)

- DeepSeek: "Algebraic Methods in Interactive Machine Learning" (Harvard, 2005)

- Llama: "Efficient Algorithms for Learning and Playing Games" (MIT, 2007)

- 실제: Kalai (2001)

환각의 유형론적 분류:

- 내재적 환각(Intrinsic hallucinations): 사용자 프롬프트와 모순되는 내용

- 외재적 환각(Extrinsic hallucinations): 훈련 데이터나 외부 현실과 모순되는 내용

예제 Counting Problem :

- "DEEPSEEK에 D가 몇 개 있는가?"라는 단순한 질문에서도 "2", "3", "6", "7" 등 다양한 오답 생성

2. 계산 학습 이론적 접근법의 도입

형식적 정의의 중요성:

환각을 감성적이거나 직관적 용어가 아닌 수학적으로 정확한 개념으로 정의

- 전체 집합 X: 모든 그럴듯한 문자열의 집합

- 오류 집합 E: 그럴듯하지만 잘못된 문자열들

- 유효 집합 V: 올바른 문자열들

- 분할 조건: (서로소 집합)

계산 학습 이론 연결의 의의:

- 수십 년간 축적된 분류 오류에 대한 이론적 지식을 환각 분석에 활용

- 환각을 단순히 "고쳐야 할 문제"가 아닌 "이해할 수 있는 현상"으로 전환

- Kearns and Vazirani (1994)의 전통적 계산 학습 이론과의 명확한 연결 설정

3. Section 1.1: 사전훈련으로 인한 오류 - 통계적 필연성

기존 통념과 그 한계

일반적인 환각 원인 추정:

대부분의 연구자들과 개발자들은 환각이 다음과 같은 이유로 발생한다고 생각해왔습니다:

- 불완전한 훈련 데이터: 인터넷에서 수집한 데이터에 잘못된 정보가 포함

- 부족한 훈련량: 더 많은 데이터와 더 긴 훈련으로 해결 가능

- 모델 크기 한계: 더 큰 모델이면 환각이 줄어들 것

이러한 접근법의 근본적 한계:

- 하지만 저자들은 이런 "데이터 품질 개선" 접근법만으로는 환각을 완전히 해결할 수 없다고 주장합니다.

- 왜냐하면 완벽한 데이터를 사용해도 환각이 발생하기 때문입니다.

반직관적 핵심 주장

충격적인 발견:

- 오류 없는 훈련 데이터에서도 통계적 목적함수 최적화가 오류 생성으로 이어짐

- 이는 훈련 데이터의 질과 무관하게 발생하는 구조적 문제임을 의미

왜 이것이 중요한가:

- 기존에는 "더 깨끗한 데이터"를 수집하면 해결될 문제로 여겨졌습니다.

- 하지만 저자들의 분석에 따르면, 설령 모든 훈련 데이터가 100% 정확해도 여전히 환각이 발생할 수밖에 없습니다.

즉, 학습 방법이 잘못되었다는 말!!

오류를 피하는 퇴화된 모델들의 분석

환각 없는 모델들이 왜 실용적이지 않은가:

환각이 없는 모델은 크게 3가지가 있습니다:

1. “I don’t know” (IDK) 모델

- "항상 IDK" 모델:

사용자: "파리의 수도는 어디인가요?"

모델: "모르겠습니다"

사용자: "2+2는?"

모델: "모르겠습니다"- 오류는 피하지만 밀도 추정이라는 언어 모델링의 기본 목표에 실패

- 실용성이 전무하여 언어 모델로서 의미 없음

- "단순 암기" 모델:

사용자: "오늘 날씨는 어때요?"

모델: "Einstein was born in 1879" (훈련 데이터에서 무작위 선택)- 훈련 예제를 무작위로 반복 출력

- 오류 없는 훈련 데이터 가정 하에서는 오류 생성 안함

- 하지만 새로운 입력에 대한 일반화 능력 전무

- "최적 모델" p̂ = p:

- 훈련 분포와 완전히 일치하는 이론적 최적 모델

- 현실적으로 달성 불가능한 무한한 훈련 데이터 요구

- 계산적으로도 실현 불가능

핵심 통찰: 실용적인 언어 모델이면서 동시에 환각을 완전히 피하는 모델은 존재할 수 없습니다.

IIV(Is-It-Valid) 핵심 통찰

기존 접근법의 문제점:

환각을 신비로운 현상으로 다루어 근본 원인을 파악하기 어려웠습니다.

저자들의 혁신적 접근:

- 근본 질문: "이것이 유효한 언어 모델 출력인가?"

- 핵심 연결: 생성은 각 후보 응답에 대해 "유효한가?"를 묻는 것과 본질적으로 동일

- 수학적 관계: 생성 오류율 ≥ 2 × IIV 오분류율

구체적 예시:

질문: "Adam Kalai의 생일은?"

가능한 답변들:

- "3월 7일" (잘못된 추측)

- "10월 15일" (잘못된 추측)

- "모르겠습니다" (정직한 답변)

IIV 관점: 모델이 각 답변에 대해 "이것이 유효한가?"를 판단

→ 이 판단 과정에서 실수하면 환각 발생이론적 의의:

- 이 부등식은 환각이 "신비로운" 현상이 아님을 보여주는 핵심 결과

- 수십 년간 연구된 이진 분류 오류 이론을 환각 분석에 적용 가능

- 환각률을 정량적으로 예측하고 하한을 설정할 수 있음

4. Section 1.2: 사후훈련에서 환각 지속성 - 사회기술적 원인

기존 사후훈련 접근법과 그 한계

사후훈련의 원래 목표:

AI 커뮤니티는 환각 문제를 해결하기 위해 다양한 후훈련 기법들을 개발해왔습니다:

- RLHF (인간 피드백 강화학습): 인간이 선호하는 답변을 학습

- Constitutional AI: 헌법적 원칙을 따르도록 훈련

- 미세조정: 고품질 데이터로 추가 학습

그런데 왜 환각이 계속 남아있을까?

이론적으로는 이런 기법들이 환각을 크게 줄여야 하는데, 실제로는 여전히 환각이 발생합니다. 저자들은 이 현상을 사회기술적 관점에서 분석합니다.

학생-시험 유추의 심화

실제 교육 상황의 관찰:

시험장에서:

학생: "정확히 모르니까 추측해볼게... 1848년?"

→ 맞으면 점수, 틀려도 빈칸보다는 나음

일상생활에서:

학생: "죄송해요, 정확히 기억이 안 나네요"

→ 정직함이 신뢰를 쌓음언어 모델의 특수한 상황:

-

과신적이고 구체적인 추측: "9월 30일" vs "가을 어느 때"

- 불확실할 때도 구체적 날짜를 제시하는 것이 더 "그럴듯해" 보임

- 하지만 실제로는 더 위험한 환각

-

이진 채점의 최적화 압력: 정답 1점, IDK 0점 시스템에서 추측이 수학적으로 최적

수학적 계산: - 빈칸: 확실한 0점 - 추측: 10% 확률로 맞다면 → 0.1×1 + 0.9×0 = 0.1점 → 추측이 항상 더 좋은 선택 -

언어 모델의 "영구 시험 모드": 인간과 달리 "현실의 학교"에서 불확실성 표현의 가치를 학습할 기회 없음

왜 이런 비유를 사용하는가:

후훈련 과정에서도 결국 벤치마크 점수로 모델을 평가하기 때문에, 모델은 계속 "시험을 보는" 상황에 놓여있습니다.

정렬되지 않은 평가의 구조적 문제

현재 평가 시스템의 문제점:

- 대부분의 벤치마크가 표준화된 인간 시험 모방: 정확도, 통과율 등 이진 지표 사용

- MMLU, GPQA, SWE-bench 등 주요 벤치마크들이 모두 "맞히기" 방식

Model A vs Model B 사고실험:

구체적 시나리오:

질문: "2023년 화학 노벨상 수상자는?"

Model A (정렬된 모델):

- 확실할 때: "Moungi Bawendi, Louis Brus, Alexei Ekimov"

- 불확실할 때: "정확히 알지 못합니다"

Model B (추측 모델):

- 확실할 때: "Moungi Bawendi, Louis Brus, Alexei Ekimov"

- 불확실할 때도: "Carolyn Bertozzi" (2022년 수상자로 추측)

벤치마크 결과:

- 알고 있는 문제: 둘 다 맞음 (각각 1점)

- 모르는 문제: A는 0점, B는 가끔 맞춰서 점수 획득

→ 총점: B가 더 높음!- Model A: 정렬된 모델, 올바른 불확실성 신호, 절대 환각하지 않음

- Model B: Model A와 유사하나 불확실성 표시 없이 항상 "추측"

- 역설적 결과: 0-1 채점에서 Model B가 Model A보다 우수한 성능

"전염병(Epidemic)" 개념

문제의 압도적 규모:

저자들이 주요 벤치마크를 분석한 결과, 10개 중 9개가 이런 식으로 채점합니다.

- 불확실성과 기권을 처벌하는 평가들의 압도적 다수

- 1개의 좋은 평가 vs 9개의 나쁜 평가 = 여전히 추측이 유리

왜 "전염병"인가:

비유:

- 1개 병원: "정직하게 말씀드리면 잘 모르겠습니다"

- 9개 병원: "확실합니다!" (틀릴 수도 있지만)

환자들은 9개 병원을 더 신뢰하게 됨

→ 정직한 1개 병원이 경쟁에서 밀림

→ 모든 병원이 과신하는 방향으로 진화기존 해결책의 한계:

- 소수의 환각 평가로는 이러한 구조적 불균형 해결 불가능

- 새로운 환각 평가를 100개 만들어도, 기존 주류 평가들이 바뀌지 않으면 의미 없음

근본적 해결책의 필요성:

- 주요 평가들 자체의 수정 필요성

- 개별 환각 평가 추가가 아닌, 기존 시스템의 구조적 변경이 필요

- "완벽한 환각 평가"를 찾는 것이 아니라, 주류 평가들이 환각을 부추기지 않도록 하는 것이 핵심

📖 Chapter 2: Related Work - 기존 연구와의 차별화

챕터의 핵심 기여

1. 본 연구의 이론적 독창성을 기존 연구와의 명확한 비교를 통해 입증

2. 환각 연구 분야의 복잡성과 다면적 특성을 체계적으로 정리

3. 기존 해결책들의 한계를 분석하여 새로운 접근법의 필요성 부각

4. 후훈련 기법들의 부분적 성공과 근본적 한계를 균형있게 평가

이 장은 본 연구의 독창성을 기존 연구들과의 체계적 비교를 통해 부각시키고, 환각 연구 분야의 복잡성과 다면적 특성을 종합적으로 정리합니다.

특히 본 연구가 제시하는 IIV 환원의 새로움과 사회기술적 접근법의 차별성을 명확히 드러냅니다.

1. 환원 방법론의 이론적 독창성

새로운 환원의 의의:

- 지도학습 → 비지도학습 환원: 이진 분류(지도)에서 밀도 추정(비지도)으로의 환원이 본 연구의 핵심 기여

- 기존 환원 기법과의 차별성: 학습 문제 간 환원 자체는 확립된 방법론이지만, 특정 환원 방향은 참신

- Beygelzimer et al. (2016) 참조: 한 문제가 다른 문제보다 "최소한 어려움"을 보이는 전통적 방법론의 새로운 응용

환원의 실용적 가치:

- 수십 년간 축적된 이진 분류 오류 이론을 환각 분석에 직접 활용 가능

- Domingos (2012)가 정리한 기계학습 오류의 다면적 특성을 환각에 적용

2. 환각 원인 연구의 기존 성과들

Sun et al. (2025)의 종합적 요인 분류:

모델 자체의 구조적 문제:

- 모델 과신(Model overconfidence) - Yin et al. (2023): 부정확한 신뢰도 추정

- 디코딩 무작위성(Decoding randomness) - Lee et al. (2022): 생성 과정의 확률적 특성

- 노출 편향(Exposure bias) - Bengio et al. (2015): 훈련과 추론 시 입력 분포 불일치

데이터와 훈련 과정의 문제:

- 긴 꼬리 훈련 샘플(Long-tailed training samples) - Sun et al. (2023): 드물게 나타나는 사실들의 학습 어려움

- 오도하는 정렬 훈련(Misleading alignment training) - Wei et al. (2023): 부적절한 후훈련 목표

- 허위 상관관계(Spurious correlations) - Li et al. (2022): 우연한 패턴에 대한 과도한 의존

시퀀스와 맥락의 문제:

- 눈덩이 효과(Snowballing effects) - Zhang et al. (2023): 초기 오류가 후속 생성에 미치는 누적 영향

- 역전 저주(Reversal curse) - Berglund et al. (2024): "A는 B이다"로 훈련된 모델이 "B는 A이다"를 학습하지 못하는 현상

- 맥락 하이재킹(Context hijacking) - Jeong (2024): 악의적 또는 오도하는 맥락에 의한 응답 조작

3. 가장 밀접한 이론적 연구와의 관계

Kalai and Vempala (2024)와의 비교:

공통점과 기여:

- Good-Turing 추정기 연결: Alan Turing의 우아한 "누락 질량" 추정을 환각에 적용

- Theorem 3의 영감 제공: 본 연구의 핵심 정리 중 하나의 이론적 토대

본 연구의 확장된 기여:

1. 불확실성 표현 포함: IDK와 같은 명시적 불확실성 응답 고려

2. 지도학습 연결: 이진 분류와의 수학적 관계 수립

3. 후훈련 수정 분석: 사전훈련 이후 단계의 체계적 분석

4. 프롬프트 모델 포함: 맥락-응답 쌍을 포함한 더 현실적 모델링

5. 사회기술적 해결책: 평가 방식 수정을 통한 실용적 접근

다른 이론적 연구들:

Hanneke et al. (2018):

- 유효성 오라클 쿼리: 인간 검증자를 활용한 대화형 학습 알고리즘

- 통계적 효율성: 합리적인 데이터 양으로 환각 최소화

- 계산적 비효율성: 실용적 구현의 어려움

최근 이론 연구들의 핵심 통찰:

- Kalavasis et al. (2025): 일관성(무효 출력 방지)과 폭(다양하고 언어적으로 풍부한 콘텐츠 생성) 간의 본질적 트레이드오프

- Kleinberg and Mullainathan (2024): 광범위한 언어 클래스에 대해 훈련 데이터를 넘어 일반화하는 모델은 환각하거나 모드 붕괴를 겪을 수밖에 없음을 증명

4. 후훈련 기법들의 성과와 한계

효과가 입증된 기법들:

인간 피드백 기반 강화학습 계열:

- RLHF (Reinforcement Learning from Human Feedback) - Ouyang et al. (2022): 인간 선호도를 통한 모델 정렬

- RLAIF (Reinforcement Learning from AI Feedback) - Bai et al. (2022): AI가 생성한 피드백 활용

- DPO (Direct Preference Optimization) - Rafailov et al. (2023): 강화학습 없이 직접 선호도 최적화

특정 유형 환각에 대한 성과:

- 음모론과 일반적 오해에 대한 환각 감소 효과 입증

- 하지만 모든 유형의 환각을 완전히 제거하지는 못함

미세조정의 역설적 결과:

- Gekhman et al. (2024)의 발견: 새로운 정보에 대한 단순 미세조정이 초기에는 환각률을 감소시키지만, 시간이 지나면 다시 증가

- 이는 근본적 해결책이 아닌 임시방편일 수 있음을 시사

예측 신호 연구:

- 자연어 쿼리와 내부 모델 활성화: 사실적 정확성과 모델 불확실성에 대한 예측 신호 인코딩 (Kadavath et al., 2022)

- 의미론적으로 관련된 쿼리 간 불일치: 환각 탐지나 완화에 활용 가능 (Manakul et al., 2023; Xue et al., 2025; Agrawal et al., 2024)

5. 기존 연구들의 한계와 본 연구의 차별성

포괄적 해결책들의 현황:

- Ji et al. (2023), Tian et al. (2024)의 서베이: 다양한 환각 완화 방법들이 개발되었지만 채택에 장벽 존재

- 2025 AI Index 보고서 (Maslej et al., 2025): 환각 벤치마크들이 "AI 커뮤니티 내에서 견인력을 얻는 데 어려움을 겪고 있음"

평가와 벤치마크의 한계:

- Bang et al. (2025), Hong et al. (2024): 포괄적 벤치마크와 리더보드가 도입되었지만 채택 장벽에 대한 분석 부족

- 본 연구가 이러한 장벽의 근본 원인을 사회기술적 관점에서 분석

불확실성 표현 연구:

- 이진 확실성을 넘어선 접근: Mielke et al. (2022), Lin et al. (2022a), Damani et al. (2025)의 점진적 불확실성 표현 연구

- 화용론(Pragmatics) 연구: Ma et al. (2025)의 맥락이 의미를 형성하는 방식 연구 - 언어 모델의 정보 전달 개선에 대한 관련성 증가

📖 Chapter 3: Pretraining Errors - 사전훈련에서의 오류 발생 메커니즘

챕터의 핵심 기여

1. IIV 환원의 수학적 엄밀성: 환각을 이진 분류 문제로 환원하는 완전한 이론적 프레임워크 제시

2. 다층적 오류 분석: 임의적 사실, 불량 모델, 계산적 어려움 등 다양한 원인의 체계적 분류

3. 정량적 예측: 싱글톤 비율과 환각률 사이의 구체적 수학적 관계 규명

4. 일반성과 구체성의 균형: 일반적 이론과 구체적 예시(삼중항 모델, 문자 세기)의 조화

이 장은 본 논문의 가장 중요한 이론적 기여인 IIV 환원 방법을 수학적으로 엄밀하게 제시하고, 사전훈련 단계에서 환각이 발생하는 근본적 메커니즘을 다각도로 분석합니다. 단순한 자동완성 관점을 넘어서 일반적인 밀도 추정 문제로 접근하여 환각의 통계적 필연성을 증명합니다.

3.1 프롬프트가 없는 환원 - 기본 이론 구축

기본 설정의 수학적 정의:

확률 분포로서의 기본 모델:

- 기본 모델 p̂: 집합 X에 대한 확률 분포

- 전체 집합 분할: X = E ∪ V (오류 집합과 유효 집합의 서로소 합집합)

- 오류율 정의:

- 무잡음 훈련 가정: 훈련 분포 p에 대해 p(E) = 0 (모든 훈련 데이터는 유효함)

IIV 이진 분류 문제의 형식적 구성:

목표 함수 정의:

훈련 분포 설계:

이 분포는 유효한 예제(훈련 데이터에서 추출)와 균등하게 무작위로 선택된 오류의 50/50 혼합입니다.

분류기 구성과 임계값 설정:

핵심 결과 - Corollary 1:

임의의 훈련 분포 p(V) = 1과 임의의 기본 모델 p̂에 대해:

여기서:

- err: 생성 오류율

- err_iiv: IIV 오분류율

- δ: 보정 오차 = |p̂(A) - p(A)| for A := {x ∈ X | p̂(x) > 1/|E|}

부등식의 실용적 의미:

- 상수 2는 상대적으로 tight한 bound (큰 |E|와 작은 δ에 대해 err_iiv는 1/2에 가까울 수 있고 err ≤ 1)

- 학습 불가능한 개념들에 대해서는 err_iiv가 필연적으로 크고, 따라서 모든 기본 모델이 오류를 범할 것

환각 오류로의 적용:

- 환각의 정의: E를 하나 이상의 그럴듯한 거짓을 포함하는 생성의 집합으로 설정

- 접지되지 않은 생성: 훈련 데이터에 접지되지 않은 생성도 포함 (p(V) = 1 가정 하에서 사실적 오류는 사실적으로 정확한 훈련 데이터에 접지될 수 없음)

보정(Calibration) 분석의 심층 고찰

보정 오차 δ의 해석:

- 언어 지식 불요: 균등 분포 p̂(x) = 1/|X|로도 δ = 0 달성 가능

- 감사 가능성: 훈련 샘플 x ~ p와 생성 샘플 x̂ ~ p̂을 사용하여 δ 추정 가능

- 날씨 예보 유추: Dawid (1982)의 보정 개념 - 예측 확률과 실제 발생률의 일치

교차 엔트로피 목적함수와의 관계:

표준 사전훈련 목적함수:

스케일링을 통한 보정 분석:

확률을 인수 s > 0으로 재조정:

핵심 통찰:

δ ≠ 0이면 s ≠ 1로 재조정하여 손실을 줄일 수 있으므로, 지역 최솟값이 아닙니다. 따라서 지역 최적화는 작은 δ를 산출해야 합니다.

3.2 프롬프트가 있는 환원 - 현실적 확장

프롬프트 모델의 형식적 정의:

- 프롬프트 분포: μ에서 추출된 맥락 c ∈ C

- 예제 구조: x = (c, r) (프롬프트 c와 응답 r의 쌍)

- 맥락별 분할:

- V_c := {r | (c, r) ∈ V} (유효 응답)

- E_c := {r | (c, r) ∈ E} (오류 응답)

조건부 분포로의 확장:

- 훈련 분포: p(r | c), 기본 모델: p̂(r | c)

- 결합 분포: p(c, r) := μ(c)p(r | c), p̂(c, r) := μ(c)p̂(r | c)

일반화된 IIV 문제:

- 동일한 목표 함수: f(x) := + iff x ∈ V

- 일반화된 분포 D: 등확률로 x ~ p 또는 x = (c, r) for c ~ μ, r ∈ E_c에서 균등하게 선택

- 일반화된 분류기: f̂(c, r) := + iff p̂(r | c) > 1/min_c |E_c|

Theorem 1 - 주요 정리:

임의의 훈련 분포 p(V) = 1과 임의의 기본 모델 p̂에 대해:

여기서 δ := |p̂(A) - p(A)|, A := {(c, r) ∈ X | p̂(r | c) > 1/min_c |E_c|}

3.3 기본 모델의 오류 요인들 - 구체적 분석

3.3.1 임의적 사실 환각 - 인식론적 불확실성

임의적 사실의 수학적 모델:

Definition 1 (Arbitrary Facts):

고정된 요소들:

- 임의의 프롬프트 분포 μ(c)

- IDK 응답

- 각 프롬프트 c에 대해: 응답 집합 R_c, 응답 확률 α_c ∈ [0, 1]

독립적 정답 선택:

각 c에 대해 독립적으로, 단일 정답 a_c ∈ R_c가 균등하게 무작위로 선택됩니다.

- p(a_c | c) = α_c

- p(IDK | c) = 1 - α_c

- 따라서 E_c = R_c \ {a_c}, V_c = {a_c, IDK}

싱글톤 비율의 정의:

Definition 2 (Singleton rate):

프롬프트 c ∈ C가 싱글톤이 되는 조건: N개 훈련 데이터에서 기권 없이 정확히 한 번 나타남:

|{i : c^(i) = c ∧ r^(i) ≠ IDK}| = 1

싱글톤 집합을 S ⊆ C라 하면:

Turing의 누락 질량 추정과의 연결:

- Alan Turing의 우아한 접근: 정확히 한 번 나타나는 샘플의 비율을 미출현 사건 확률의 추정치로 사용

- 직관: 싱글톤들은 추가 샘플링에서 얼마나 많은 새로운 결과를 만날지에 대한 프록시 역할

Theorem 2 (Arbitrary Facts) - 하한 및 상한:

임의적 사실 모델에서, N개 훈련 샘플을 받아 p̂를 출력하는 임의의 알고리즘에 대해, ⃗a = ⟨ac⟩{c∈C}와 N개 훈련 예제에 대해 99% 확률로:

하한:

상한: 보정된 p̂ (δ = 0)를 출력하는 효율적 알고리즘이 존재하여 99% 확률로:

실용적 시사점:

- 20%의 생일 사실이 사전훈련 데이터에서 정확히 한 번 나타나면, 기본 모델이 최소 20%의 생일 사실에서 환각할 것으로 예상

- 이는 빈도와 환각 사이의 직접적 관계를 수학적으로 확립

3.3.2 불량 모델 - 표현력과 적합성 문제

Agnostic Learning 프레임워크:

주어진 분류기 패밀리 G의 최소 오류율:

언어 모델 기반 분류기 패밀리:

매개변수 θ ∈ Θ로 매개화된 언어 모델 p̂θ에 대해:

$$G := {g{θ,t} | θ ∈ Θ, t ∈ [0, 1]}$$

Theorem 1에서의 직접적 도출:

순수 다중 선택 사례 - Theorem 3:

|V_c| = 1 for all c이고 C = min_c |E_c| + 1이 선택지 수라면:

구체적 예시 - 삼중항 모델의 한계:

프롬프트와 응답 설계:

- c₁ = "She lost it and was completely out of..."

- c₂ = "He lost it and was completely out of..."

- r₁ = "her mind.", r₂ = "his mind."

- V{c₁} = E{c₂} = {r₁}, V{c₂} = E{c₁} = {r₂}

Corollary 2:

μ가 {c₁, c₂}에 대해 균등분포라면, 임의의 삼중항 모델은 최소 1/2의 생성 오류율을 가져야 합니다.

증명 스케치: C = 2이고 삼중항 모델에 대해 opt(G) = 1/2이므로 Theorem 3에서 직접 따라옵니다.

현대적 예시 - 문자 세기:

DeepSeek-R1 추론 모델의 377-토큰 사고 과정:

"Let me spell it out: D-E-E-P-S-E-E-K.

First letter: D — that's one D. Second letter: E — not D. Third letter: E — not D...

So, the number of Ds is 1."토큰화의 표현적 도전:

현대 언어 모델들이 개별 문자가 아닌 토큰(예: D/EEP/SEE/K)으로 프롬프트를 표현하는 것이 문자 세기 작업의 표현적 한계를 보여줍니다.

3.4 추가적 오류 요인들 - 포괄적 분석

계산적 어려움 (Computational Hardness)

암호학적 예시:

- 안전한 암호화 시스템에서는 효율적 알고리즘이 우연보다 나은 추측을 할 수 없음

- Observation 2 (Appendix D): "c의 복호화는 무엇인가?" 형태의 다루기 어려운 쿼리에 Theorem 1 적용

- β-breaking 보안 정의 하에서 보정된 언어 모델은 1 - β - 2/(|M| - 1) - δ 이상의 확률로 잘못된 복호화를 출력

분포 이동 (Distribution Shift)

전통적 기계학습 문제:

- 훈련과 테스트 데이터 분포의 divergence (Quiñonero-Candela et al., 2009)

- 언어 모델에서는 OOD(Out-of-Distribution) 프롬프트로 나타남

- 예시: "깃털 1파운드와 납 1파운드 중 어느 것이 더 무거운가?" 같은 훈련 데이터에 없을 법한 질문

GIGO: Garbage In, Garbage Out

훈련 데이터 품질의 한계:

- 대규모 훈련 코퍼스는 필연적으로 많은 사실적 오류 포함

- 기본 모델들이 훈련 데이터의 오류를 복제할 수 있음

- Lin et al. (2022b), Levy et al. (2021), Alber et al. (2025)의 연구로 입증

후훈련으로의 자연스러운 전환:

GIGO는 일반적 오해와 음모론 같은 특정 GIGO 오류를 감소시키는 후훈련으로의 자연스러운 연결점을 제공합니다. 하지만 일부 환각은 지속되거나 심지어 악화될 수 있습니다.

📖 Chapter 4: Post-training and Hallucination - 후훈련에서의 환각 지속성

챕터의 핵심 기여

1. 사회기술적 원인 규명: 환각 지속성의 근본 원인이 평가 방식 자체에 있음을 입증

2. 구조적 문제 정량화: 주류 벤치마크들의 메타 분석을 통한 이진 채점의 압도적 비중 확인

3. 실용적 해결책 제시: 기존 벤치마크의 단순 수정을 통한 점진적 개선 방안

4. 행동 보정 개념: 새로운 평가 패러다임으로서의 행동 보정 도입

이 장은 사전훈련 이후에도 환각이 지속되는 이유를 사회기술적 관점에서 분석하고, 평가 방식 자체가 환각을 강화한다는 핵심 통찰을 제시합니다. 단순히 더 나은 후훈련 알고리즘을 제안하는 대신, 기존 평가 시스템의 구조적 문제를 지적하고 실용적 해결책을 제안합니다.

4.1 평가 방식이 환각을 강화하는 메커니즘

이진 평가의 구조적 문제점

잘못된 이분법의 강요:

현재 언어 모델 평가들이 부과하는 거짓 정답-오답 이분법은 다음과 같은 유용한 응답들에 전혀 점수를 주지 않습니다:

- 불확실성 표현: "확실하지 않습니다", "정확히 모르겠습니다"

- 모호한 세부사항 생략: 불확실한 구체적 정보 대신 확실한 일반적 정보 제공

- 명확화 요청: "어떤 종류의 전화를 말씀하시는 건가요?" (휴대폰 vs 유선전화)

주류 지표들의 이진적 특성:

- 정확도(Accuracy): 맞음/틀림의 단순 이분법

- 통과율(Pass rate): 기준 통과/미통과의 이분법

- 이러한 지표들이 분야의 지배적 규범임을 저자들이 강조

Observation 1 - 수학적 증명:

임의의 프롬프트 c에 대해, 이진 채점자에 대한 임의의 분포 ρc에서:

$$A_c \cap \arg\max{r \in Rc} E{g_c \sim \rho_c}[g_c(r)] = \emptyset$$

여기서 A_c ⊂ R_c는 그럴듯한 기권 응답들의 집합입니다.

증명의 핵심 아이디어:

- 이진 채점자 g_c에 대해 모든 r ∈ A_c는 g_c(r) = 0

- 하지만 R_c \ A_c에서 일부 r'에 대해 Pr[g_c(r') = 1] > 0

- 따라서 기권은 항상 차선책

"전염병(Epidemic)" 개념의 심층 분석

Model A vs Model B 사고실험:

Model A (정렬된 모델)의 특성:

- 올바르게 불확실성을 신호

- 절대 환각하지 않음

- 확실하지 않을 때 적절히 기권

Model B (추측 모델)의 특성:

- Model A와 유사하지만 불확실성 표시 없음

- 불확실할 때 항상 "최선의 추측" 제공

- 과신적이고 구체적인 거짓 정보 생성

0-1 채점에서의 역설적 결과:

Model B가 Model A보다 더 높은 점수를 받게 됩니다:

- Model A: 정확한 답변에만 점수, 기권에는 0점

- Model B: 정확한 답변 + 운 좋은 추측에 점수

메타 평가 결과 - Table 2의 체계적 분석:

저자들이 주요 벤치마크들을 분석한 결과:

대표적 이진 채점 벤치마크들:

1. GPQA: 다중 선택 정확도, IDK 크레딧 없음

2. MMLU-Pro: 다중 선택 정확도, IDK 크레딧 없음

3. IFEval: 프로그래매틱 지시 검증, IDK 크레딧 없음

4. Omni-MATH: 등가성 채점, IDK 크레딧 없음

5. BBH: 다중 선택/정확히 일치, IDK 크레딧 없음

6. MATH (L5 split): 등가성 채점, IDK 크레딧 없음

7. SWE-bench: 패치가 단위 테스트 통과 여부, IDK 크레딧 없음

유일한 예외 - WildBench:

- LM 기반 루브릭 사용 (1-10 점수)

- IDK가 부분적 크레딧 획득 가능

- 하지만 문제적 채점: IDK는 "공정한" 응답보다 낮은 점수 (3-4점 vs 5-6점)

- 따라서 여전히 환각을 강화하는 구조

소수 환각 평가의 한계

압도적 불균형 문제:

- 주류 평가들의 압도적 다수가 이진 채점

- 소수의 환각 전용 평가로는 구조적 불균형 해결 불가능

- "완벽한 환각 평가"를 추구하는 기존 연구 방향의 한계 지적

근본 원인의 식별:

문제는 환각 평가의 부족이 아니라 정렬되지 않은 평가의 과다입니다.

4.2 명시적 신뢰도 목표 - 실용적 해결책

인간 시험과의 유사성 분석

잘못된 답변에 패널티가 있는 시험들:

저자들이 실제 존재하는 시험 사례들을 제시:

국제적 표준화 시험들:

- 인도: JEE (Joint Entrance Examination), NEET, GATE 시험

- 미국: 과거의 SAT, AP, GRE 테스트

- 수학: Mathematical Association of America의 AMC 테스트

핵심 특징:

1. 명시적 채점 방식 고지: 시험 지시사항에 명확히 기재

2. 신뢰도 임계값 인식: 수험자들이 언제 추측할지 알고 있음

3. 투명한 위험-보상 구조: 정답 시 얻는 점수 대비 오답 시 잃는 점수가 명확

제안하는 해결책의 구체적 설계

명시적 신뢰도 목표 문구:

각 질문에 다음과 같은 문구를 추가:

"t 이상 확신할 때만 답하시오. 실수는 t/(1-t) 점 감점되고, 정답은 1점, '모르겠다'는 0점입니다."

자연스러운 임계값들:

- t = 0.5 (패널티 1): 50% 이상 확신할 때만 답변

- t = 0.75 (패널티 3): 75% 이상 확신할 때만 답변

- t = 0.9 (패널티 9): 90% 이상 확신할 때만 답변

- t = 0 (패널티 0): 기존 이진 채점 = "불확실해도 최선의 추측을 하라"

수학적 정당화:

답변의 기댓값이 IDK(점수 0)를 이기는 조건:

정확도 확률 × 1 + 오답 확률 × (-t/(1-t)) > 0

⟺ 정확도 확률 > t

따라서 t를 명시함으로써 모델이 정확히 t 이상 확신할 때만 답하는 것이 수학적으로 최적이 됩니다.

기존 접근법과의 차별점

첫 번째 차별점 - 명시성:

- 기존 연구: 대부분 신뢰도 목표나 패널티를 지시사항에서 생략

- 본 연구: 신뢰도 임계값을 명시적으로 지시사항에 포함

- 예외: Wu et al. (2025)의 "위험 고지" 프롬프트는 명시적 패널티 사용

명시성의 중요성:

- 객관적 채점 가능: 임계값이 명시되어 있으면 공정한 평가 기준 설정

- 합의 형성 용이: 언어 모델 개발자들 간 명확한 기준점 제공

- 학생들도 불공정하다고 느끼지 않음: 채점 기준이 투명하게 공개됨

두 번째 차별점 - 주류 평가 통합:

- 기존 연구: 주로 전용 환각 평가에서 암시적 오류 패널티 도입

- 본 연구: SWE-bench 같은 기존 주류 평가에 신뢰도 목표 통합 제안

주류 평가 통합의 장점:

- 정확도-오류 트레이드오프 문제 해결

- 적절한 불확실성 표현에 대한 패널티 감소

- 환각 전용 평가의 효과성 증폭

행동 보정 (Behavioral Calibration) 개념

기존 보정과의 차이:

- 확률적 신뢰도 출력: 모델이 "87% 확신합니다" 같은 수치 제공

- 행동 보정: 특정 임계값에서 가장 유용한 응답 형성

행동 보정의 정의:

모든 임계값에서 동시에 최적인 행동이 존재:

해당 임계값보다 높은 정확도 확률을 가진 예제에서만 답변하고, 나머지에서는 IDK 출력

감사 및 평가 방법:

- 임계값별로 정확도와 오류율 비교

- 지수적으로 많은 정답 표현 방식 문제 우회 (Farquhar et al., 2024)

- 기존 모델들이 행동 보정을 보이는지 확인 가능

객관적 평가로서의 가치:

행동 보정은 모델의 불확실성 처리 능력을 평가하는 새로운 객관적 지표로 활용될 수 있습니다.

📖 Chapter 5: Discussion and Limitations - 연구의 한계와 확장 가능성

챕터의 핵심 기여

1. 한계 인정의 정직성: 제시된 프레임워크의 한계를 숨기지 않고 명확히 기술

2. 확장 가능성 제시: 각 한계점에 대한 구체적인 향후 연구 방향 제시

3. 실용성과 이론의 균형: 완벽한 이론보다는 실용적 개선에 초점

4. 미래 연구 의제 설정: 언어적 보정, 화용론적 능력 등 새로운 연구 영역 개척

이 장은 제시된 이론적 프레임워크와 실용적 해결책의 적용 범위와 한계점을 정직하고 균형잡힌 시각으로 검토합니다. 각 한계점에 대해 향후 연구 방향을 제시함으로써, 이론의 확장 가능성과 실용적 적용에서의 고려사항들을 체계적으로 다룹니다.

1. 그럴듯함과 무의미함의 경계 문제

현재 프레임워크의 범위

그럴듯한 거짓에 대한 집중:

- 환각의 정의: "그럴듯한 거짓"

- 무의미한 문자열은 현재 분석에서 제외

- 현실적 근거: 최첨단 언어 모델들이 무의미한 문자열을 거의 생성하지 않음

확장된 프레임워크로의 수정 가능성

수정된 분할 구조:

전체 집합을 세 부분으로 확장:

- X = N ∪ E ∪ V

- N: 무의미한 예제들 (nonsensical examples)

- E: 오류 예제들 (error examples)

- V: 유효한 예제들 (valid examples)

수정된 정의들:

- err := p̂(N ∪ E) (무의미함과 오류를 모두 포함)

- D(N) = 0 (훈련 분포에서 무의미한 예제는 0 확률)

- p(V) = 1 (유효한 예제만 훈련 데이터에 포함)

이론적 강건성:

저자들이 강조하는 중요한 점: Theorem 1의 진술과 증명이 이 수정된 정의에서도 그대로 성립한다는 것입니다.

2. 개방형 생성의 복잡성

현재 연구의 초점과 한계

단일 사실적 질문 중심:

- 논문에서 제시된 대부분의 예제들이 명확한 답이 있는 질문들

- "Adam Kalai의 생일은?", "논문 제목은?" 등

개방형 프롬프트의 도전:

복잡한 생성 작업의 예시:

"Write a biography about [person]..."

이런 프롬프트에서는 단일한 "정답"이 존재하지 않으며, 부분적 환각이나 정도의 차이가 존재할 수 있습니다.

프레임워크 확장 방안

복합적 환각 정의:

- 하나 이상의 거짓을 포함하는 응답을 오류로 정의

- 하지만 이 경우 환각의 정도를 고려하는 것이 자연스러움

- 몇 개의 오류가 있는지에 따른 차등적 분석 필요

미래 연구 방향:

보다 미묘한 환각 분류 체계와 연속적 환각 측정 방법 개발의 필요성을 시사합니다.

3. 검색과 추론의 한계 - 만병통치약이 아님

RAG (Retrieval-Augmented Generation)의 성과와 한계

기존 연구들의 성과:

다수의 연구들이 검색 증강이 환각을 줄인다는 것을 입증:

- Lewis et al. (2020): 지식 집약적 NLP 작업에서의 RAG

- Shuster et al. (2021): 대화에서의 검색 증강

- Nakano et al. (2021): WebGPT - 브라우저 지원 질문 답변

- Zhang and Zhang (2025): RAG 시스템에 대한 최신 종합 검토

구조적 한계의 지속

Observation 1의 일반적 적용:

저자들의 핵심 통찰: Observation 1이 RAG를 포함한 임의의 언어 모델에 적용됩니다.

구체적 문제점들:

1. 검색 실패 시의 추측 압력:

- 검색이 확신 있는 답변을 제공하지 못할 때

- 이진 채점 시스템이 여전히 추측을 보상

-

내재적 환각에 대한 무력함:

- 문자 세기 예시: "DEEPSEEK에 D가 몇 개?"

- 이는 외부 검색으로 해결할 수 없는 내재적 추론 능력의 문제

- 토큰화 방식 (D/EEP/SEE/K)과 같은 모델 구조적 한계

-

계산적 오류들:

- 수학적 계산이나 논리적 추론에서의 실수

- 검색으로는 해결되지 않는 추론 과정의 오류

4. 잠재적 맥락 - 숨겨진 정보의 문제

현재 오류 정의의 한계

프롬프트-응답 쌍만으로는 판단 불가능한 오류들:

구체적 예시:

사용자 질문: "전화에 대해 질문이 있습니다"

모델 응답: 휴대폰에 대한 답변 제공

실제 의도: 유선전화에 대한 질문이었음

이러한 모호성은 프롬프트와 응답 외부의 맥락에 의존하므로 현재 오류 정의에 맞지 않습니다.

확장 가능성 - 숨겨진 맥락 모델

제안되는 확장:

- 언어 모델에게 주어지지 않은 "숨겨진 맥락" 포함

- 오류 판단에는 사용되지만 모델 입력에는 포함되지 않는 정보

- Aleatoric uncertainty (우연적 불확실성)과의 연결

이론적 도전:

이는 현재 프레임워크를 상당히 복잡하게 만들지만, 더 현실적인 환각 모델링을 위해서는 흥미로운 확장 방향입니다.

5. 잘못된 삼분법 - 단순화의 한계

현재 분류 체계의 부족함

정확/부정확/IDK 범주의 한계:

저자들은 자신들의 프레임워크도 불완전함을 솔직하게 인정합니다:

- 오류의 다양한 규모: 사소한 실수와 심각한 오류를 구분하지 않음

- 불확실성의 정도: "약간 불확실"과 "완전히 모름" 사이의 차이를 반영하지 못함

- 맥락 의존적 적절성: 상황에 따라 다른 응답이 적절할 수 있음

통계적 이상과 실용적 절충

이론적 이상향:

- 각 평가를 다운스트림 응용에서와 정확히 같은 방식으로 채점하는 것

- 하지만 이는 응용마다 다른 채점 기준을 요구하므로 표준화 어려움

실용적 절충안:

- 명시적 신뢰도 목표: 적어도 IDK 옵션을 제공하는 실용적이고 객관적인 수정

- 잘못된 삼분법 vs 잘못된 이분법: 불완전하더라도 이분법보다는 개선된 접근

6. IDK를 넘어서 - 불확실성 표현의 다양성

다양한 불확실성 신호 방법들

언어적 불확실성 표현의 스펙트럼:

1. 헤징 (Hedging): "아마도", "~인 것 같습니다", "확실하지는 않지만"

2. 세부사항 생략: 확실한 일반적 정보는 제공하되, 불확실한 구체적 세부사항은 생략

3. 질문하기: "어떤 종류의 ~을 말씀하시는 건가요?"

4. 조건부 응답: "만약 ~을 의미하신다면..."

언어적 보정 (Linguistic Calibration)의 가능성

미래 연구 방향:

- Mielke et al. (2022), Damani et al. (2025)의 연구에서 제시된 점진적 불확실성 표현

- 단순한 확률 수치가 아닌 자연스러운 언어를 통한 신뢰도 전달

화용론적 현상의 미묘함:

Austin (1962), Grice (1975)의 화용론 연구에서 드러나는 언어의 복잡성:

- 맥락이 의미를 형성하는 방식

- 명시적 내용과 암시적 의미 간의 차이

확률적 신뢰도 진술의 문제점

부자연스러운 발화의 예:

"칼라이의 생일이 3월 7일일 확률은 1/365입니다."

이런 표현은 기술적으로는 정확하지만 자연스러운 대화에서는 어색합니다.

본 논문의 집중점:

저자들은 "무엇을 말할 것인가"라는 최상위 결정에 대한 통계적 요인에 집중하며, 더 미묘한 화용론적 표현은 미래 연구 과제로 남겨둡니다.

📖 Chapter 6: Conclusions - 연구 성과의 종합과 전망

결론 장은 전체 연구의 핵심 성과를 간결하게 요약하고, 언어 모델 개발과 평가에 미칠 장기적 영향을 전망합니다.

단순한 요약을 넘어서 연구의 실용적 함의와 분야 전체의 방향 전환 가능성을 제시합니다.

챕터의 핵심 기여

1. 통합적 성과 요약: 이론적 기여와 실용적 해결책을 균형있게 정리

2. 실현 가능성 강조: 단순한 수정을 통한 큰 변화의 가능성 제시

3. 미래 비전 제시: 더 신뢰할 수 있는 AI 시스템으로의 발전 방향 제시

4. 행동 촉구: 연구 커뮤니티의 구체적 행동 방안 제시

1. 환각 현상의 완전한 탈신비화

사전훈련에서 후훈련까지의 통합적 이해

이론적 기여의 핵심:

- 사전훈련 단계: 환각이 발생하는 통계적 메커니즘의 수학적 규명

- 후훈련 단계: 환각이 지속되는 사회기술적 원인의 체계적 분석

- 전체 파이프라인: 현대 훈련 과정 전반에 걸친 완전한 이해 제공

지도학습과의 평행 관계 확립

핵심 통찰의 재강조:

- 사전훈련에서 생성 오류가 지도학습의 오분류와 평행관계에 있음을 증명

- 이는 신비로운 현상이 아님을 의미

- 수십 년간 축적된 분류 오류 이론을 환각 분석에 직접 활용 가능

교차 엔트로피 손실 최소화의 자연스러운 결과:

- 환각이 모델의 결함이나 실수가 아닌, 표준 훈련 목적함수의 자연스러운 결과임을 입증

- 이는 환각을 "고칠 수 있는 버그"가 아닌 "이해하고 관리해야 할 특성"으로 재정의

2. 평가 방식의 근본적 문제 지적

단일 평가 vs 구조적 문제의 대비

"Certainly" 평가와의 대조:

저자들이 제시하는 중요한 구분:

- 단일 문제: "Certainly"로 응답을 시작하는 습관 같은 경우

- 단일 "Certainly" 평가로 해결 가능

- 다른 평가들에 영향을 주지 않음

- 구조적 문제: 환각은 대다수 주류 평가들이 환각적 행동을 보상하는 구조

압도적 규모의 문제

수치적 압도:

- Table 2에서 보인 바와 같이 주요 벤치마크들의 압도적 다수가 이진 채점

- 소수의 환각 전용 평가로는 이러한 구조적 불균형 해결 불가능

- 환각 연구자들이 "완벽한 환각 평가" 추구에만 집중하는 것의 한계

근본적 해결책의 필요성:

개별 환각 평가 추가가 아닌, 주류 평가들 자체의 수정이 필수적입니다.

3. 실용적 해결책의 실현 가능성

주류 평가의 단순한 수정

최소한의 변화로 최대한의 효과:

- 기존 벤치마크의 지시사항 수정만으로도 큰 변화 가능

- 새로운 평가 개발이나 복잡한 알고리즘 불필요

- "t 이상 확신할 때만 답하시오" 같은 간단한 문구 추가

인센티브 재정렬의 메커니즘:

- 적절한 불확실성 표현을 처벌하는 대신 보상하는 구조로 전환

- 이는 Model A (정렬된 모델)가 Model B (추측 모델)보다 우수한 성과를 내도록 함

- 수학적으로 최적화된 신뢰도 임계값 설정을 통한 객관적 평가

4. 향후 연구 방향의 새로운 지평

환각 억제 장벽의 제거

현재 상황의 변화:

- 기존: 후훈련 알고리즘 개발에도 불구하고 환각 지속

- 변화 후: 평가 방식 수정을 통한 구조적 장벽 제거

- 결과: 기존 및 미래의 환각 완화 기법들의 효과성 증대

미묘한 언어 모델의 가능성

더 풍부한 화용론적 능력:

Ma et al. (2025)의 화용론 연구와 연결하여:

- 맥락에 따른 적절한 불확실성 표현

- 자연스러운 언어를 통한 신뢰도 전달

- 사용자와의 더 효과적인 소통

언어적 보정 (Linguistic Calibration):

- 확률 수치가 아닌 자연스러운 언어 표현을 통한 불확실성 전달

- 화용론적 맥락을 고려한 적절한 응답 생성

5. 분야 전체의 패러다임 전환

리더보드와 벤치마크 생태계의 변화

점진적 변화의 전략:

- 개별 연구자나 기관의 노력만으로는 한계

- 사회기술적 합의를 통한 분야 전체의 방향 전환 필요

- 영향력 있는 리더보드들의 채택이 핵심

변화의 연쇄 반응:

- 주요 리더보드에서 명시적 신뢰도 목표 채택

- 모델 개발자들이 새로운 평가 기준에 맞춰 최적화

- 더 신뢰할 수 있는 모델들이 경쟁에서 우위

- 사용자들이 더 나은 경험을 하게 됨

더 신뢰할 수 있는 AI 시스템으로의 전환

사회적 영향:

- 의료, 법률, 금융 등 고위험 도메인에서의 AI 신뢰성 향상

- 일반 사용자들의 AI에 대한 신뢰도 증가

- AI 안전성에 대한 사회적 우려 완화

기술적 발전:

- 불확실성을 적절히 처리하는 모델 개발 촉진

- 행동 보정 같은 새로운 평가 패러다임 확산

- 환각 완화 기술들의 효과성 증대

결론은 환각 문제를 해결하기 위한 "은탄환"을 찾는 대신, 시스템적 접근을 통한 점진적이지만 근본적인 개선이 가능함을 보여줍니다. 이는 단순히 기술적 해결책이 아닌, 사회기술적 합의를 통한 분야 전체의 발전을 추구하는 성숙한 연구 접근법을 보여줍니다.

읽어주셔서 감사합니다 😸