Transformer 기반의 미래의 트래픽 예측 모델을 제안한다.

즉, 다음날 방문자 수를 예측하는 모델입니다.

인터넷 사용의 증가로 트래픽 패턴을 이해하고 네트워크 리소스를 효율적으로 관리하는 것이 중요해졌습니다.

LSTM으로 시퀀스간 트래픽 패턴을 예측하였습니다.

LSTM은 seasonality와 long-term trends를 잘 capture하는 모델이기 때문입니다.

이후 attention mechanism을 포함한 multiple encoder와 Decoder를 도입한 Transformer를 기반으로 하는 아키텍쳐가 등장했습니다.

Method

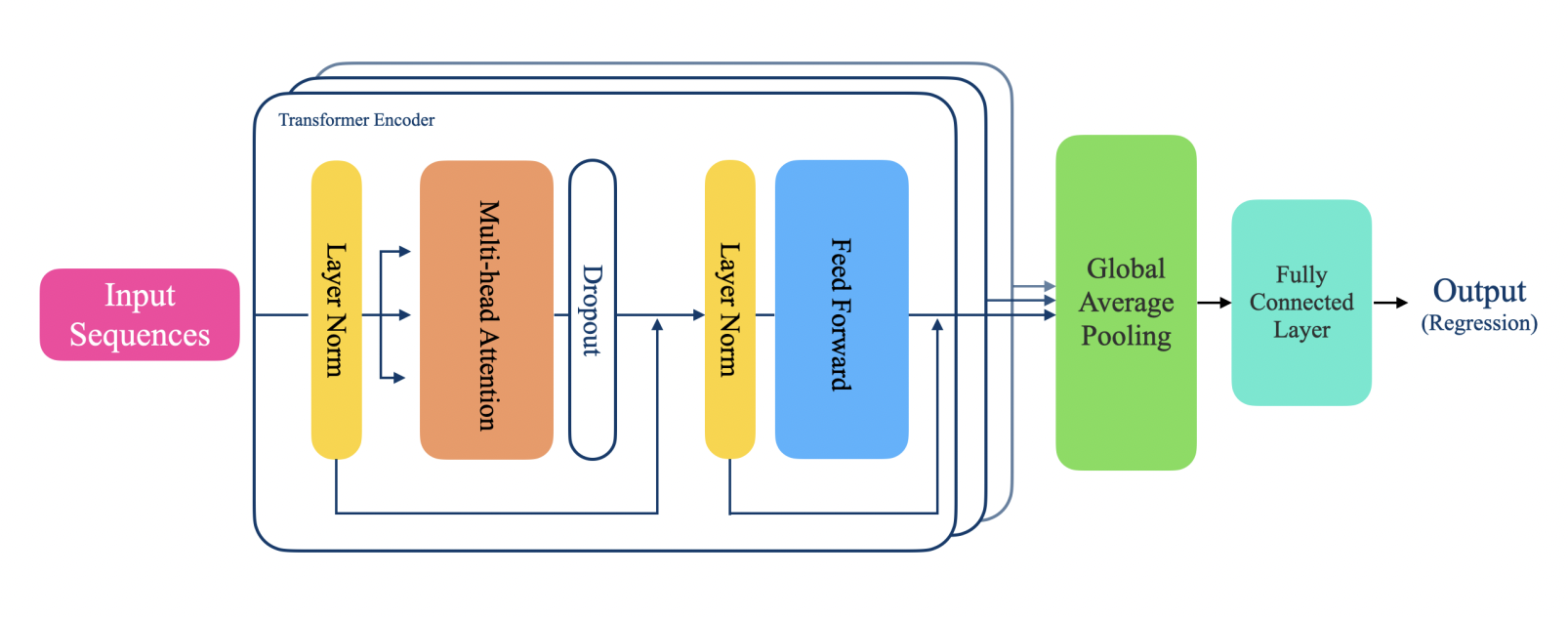

A. Model Architecture

1) Input Sequences

2) Transformer Encoder

Input에서 comprehensive feature를 추출

Multihead attention; 장단기 temporal characteristic을 캡쳐

Multihead attention과 feed-forward layer에 layer normalization과 residual skip connection 적용

3) GAP (Global Average Pooling)

Feature를 1차원 벡터로 만들기 위한 pooling

같은 채널의 feaure를 평균냄

(height, width, channel) -> (channel,) 형태로 변환

4) FC layer (Fully Connected Layer)

Drop out: 0.4

Multilayer perceptron 64

5) Output

다음 날 트래픽 수를 예측하는 것이기 때문에 Regression을 사용

B. Data Description

145K Wikipedia articles의 일일 방문 수로 구성된 large-scale Wikipedia dataset, Kaggle

데이터 기간 2015.07.01 ~ 2017.10.10

각 페이지의 일일 방문 수 외에도 Spider, Desktop, Moblie의 세 가지 유형의 액세스 장치를 통해 일일 방문수를 제공

C. Experiment Setup

다양한 액세스 장치 별로 예측하기 위해, 각 장치에 대한 상위 10개의 위키백과 페이지를 사용했습니다.

All의 경우에는 장치 유형에 상관 없이 방문 횟수 기준으로 상위 10개의 페이지를 사용했습니다.

각 데이터 세트에 대해 처음 506일동안 방문한 횟수는 train/val set으로 사용되고 나머지는 test set입니다.

train/val 비율은 8:2입니다.

입력의 시퀀스 길이는 20으로 설정됩니다.

이때, 시퀀스 길이는 이전 방문의 관측 가능한 일수를 의미합니다.

epoch count: 200

batch size: 3

early stop: 5 epoch마다 적용

loss function: MSE

D. Performance Metric

1) Mean Absolute Percentage Error

range: [0, 1]

2) R2-score

Error가 없으면 1입니다.

음수인 경우 data의 trend를 따라가지 못했음을 의미합니다.

3) Root Mean Squared Error

range: [0, inf]

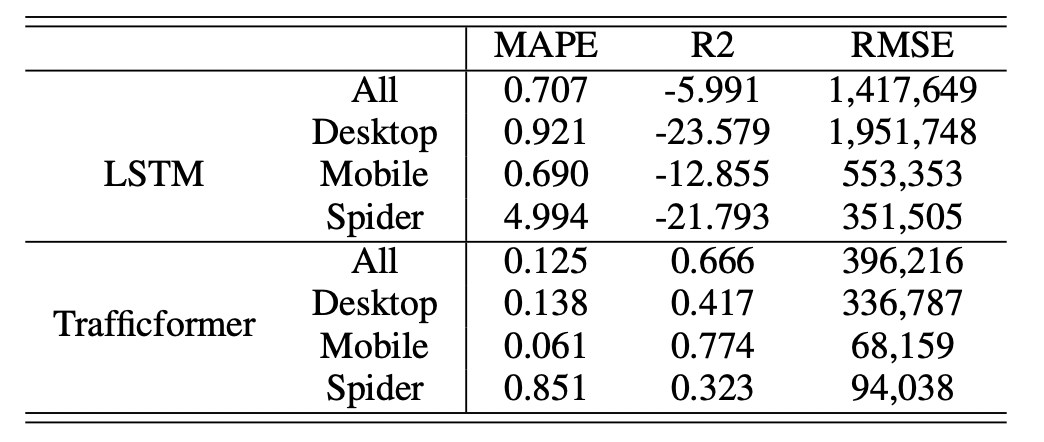

Results

LSTM: 8개 cell로 구성

모든 실험에서 Trafficformer가 더 우수한 성능을 보입니다.

특히 mobile 기기에서 더 좋은 성능을 나타냅니다.

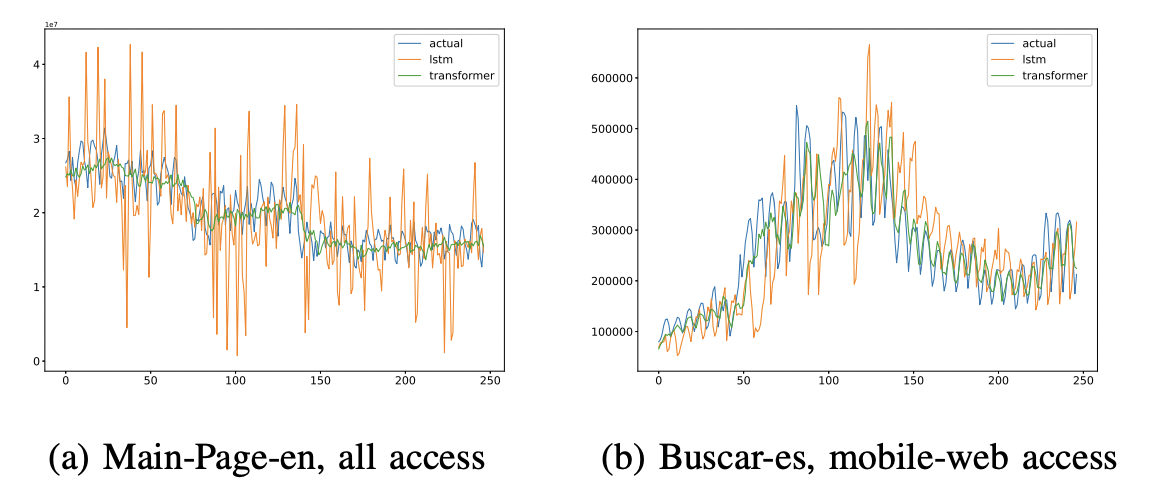

파란색: 실제 방문수

주황색: LSTM 모델의 예측값

초록색: Trafficformer 모델의 예측값

전반적으로 Trafficformer 모델보다 LSTM 모델이 더 fluctuate(변동)하는 경향이 있습니다.

특히 Fig(b)에서 100th-150th를 보면 급격한 변화가 있는 경우 LSTM 모델의 변동성이 더 증가합니다.

즉, Trafficformer 모델이 트래픽 데이터의 갑작스러운 변화에 강력하며 변동이 큰 트래픽을 정확하게 예측할 수 있음을 의미합니다.

Conclusion

이 논문은 미래의 트래픽 데이터를 예측할 수 있는 transformer-based model을 제안합니다.

웹 트래픽 데이터 세트를 사용한 평가는 제안된 모델이 시계열 트래픽 예측에서 널리 사용되어 온 LSTM 기반 모델을 능가하며, 특히 모바일 트래픽의 경우 높은 성능을 보여줍니다.

논문에서 제안한 모델이 5G/6G 네트워크 자원을 관리에 도움을 줄 수 있다는 것을 기대합니다.

- 왜 mobile data에서 가장 좋은 성능을 보일까?

- 왜 GAP를 사용했을까?

- GAP을 쓰면 FC layer를 안 사용해도 되는데 쓴 이유는 채널이 여러 개 이기 때문일까?