introduce

swin transfomer은 cnn과 transfomer의 장점을 통합함

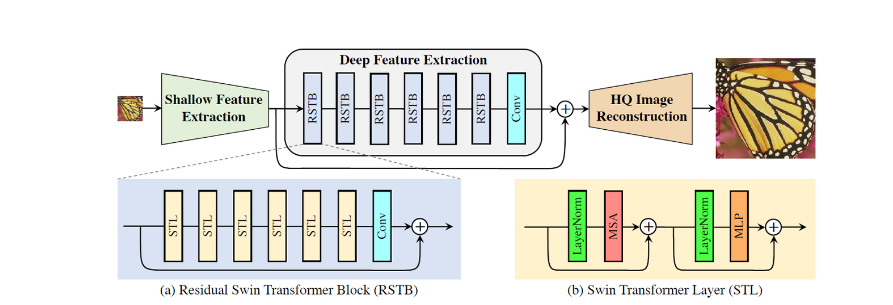

method

Shallow Feature Extraction

하나의 3x3 conv로 특징추출

Deep Feature Extraction

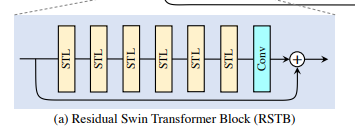

Hdf는 k개의 RSTB와 마지막에 하나의 3X3 conv로 이루어짐

Image Reconstruction

shallow feature은 low-frequencies를 포함하고 있고 deep feature은 잃어버린 high-frequencies 복원에 집중한다.

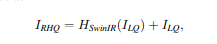

HQ대신 LQ를 이용해 reconstruct한다.

loss function

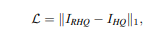

l1 norm을 사용한다.

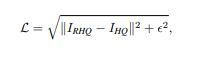

real-world image SR에서는 다음과 같은 loss function을 사용한다.

입실론은 0.001

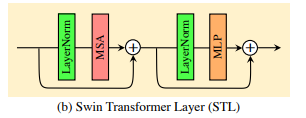

Residual Swin Transformer Block

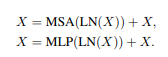

위 그림을 수식화 한것이 아래 식

Swin Transformer layer

original transfomer layer의 multi-head self attention 기반이다.

MSA에서 attention function을 parallel하게 h번 수행하고 concatenate한다.

MLP에서는 GELU사용.

구현

RSTB:6개

STL:6개

WINDOW SIZE:8

CHANNEL NUM:180

ATTENTION HEAD NUM:6개

LIGHTWEIGHT 버전은 RSTB 4개, CHANNEL 60개