🤍✨🤍✨🤍

📃 Playing Atari with Deep Reinforcement Learning

- arXiv (Deep Mind)

- 강화학습 (CV)

- https://arxiv.org/pdf/1312.5602.pdf?source=post_page---------------------------

📃 A Neural Algorithm of Artistic Style

- arXiv

- 스타일 변환 (CV)

- https://arxiv.org/pdf/1508.06576.pdf?translate=1&translate=1&translate=1&translate=1

🤍✨🤍✨🤍

📃 On Measuring Social Biases in Sentence Encoders

- NAACL

- Bias Metrics (차별적 결과를 띌 수 있는 편향)

- https://aclanthology.org/N19-1063.pdf

🤍✨🤍✨🤍

📃 Bi-Cross 사전 학습을 통한 자연어 이해 성능 향상

- 제33회 한글 및 한국어 정보처리 학술대회 논문집 (2021년) (네이버 Clova팀)

- BERT 계열에서 [cls] 토큰이 성능이 높지 않은 경향이 있어, => 나머지 토큰의 평균값을 산출해 활용하자는 주장이 최근에 나오고 있음.

- https://www.koreascience.or.kr/article/CFKO202130060669824.pdf

- 아직 구현한 코드는 없음

📃 Enriching Pre-trained Language Model with Entity Information for Relation Classification

- arXiv

B-BERTModel관계 추출Task에서 성능을 높이기 위해 개선된 모델- https://arxiv.org/abs/1905.08284

- 구현 코드 있음

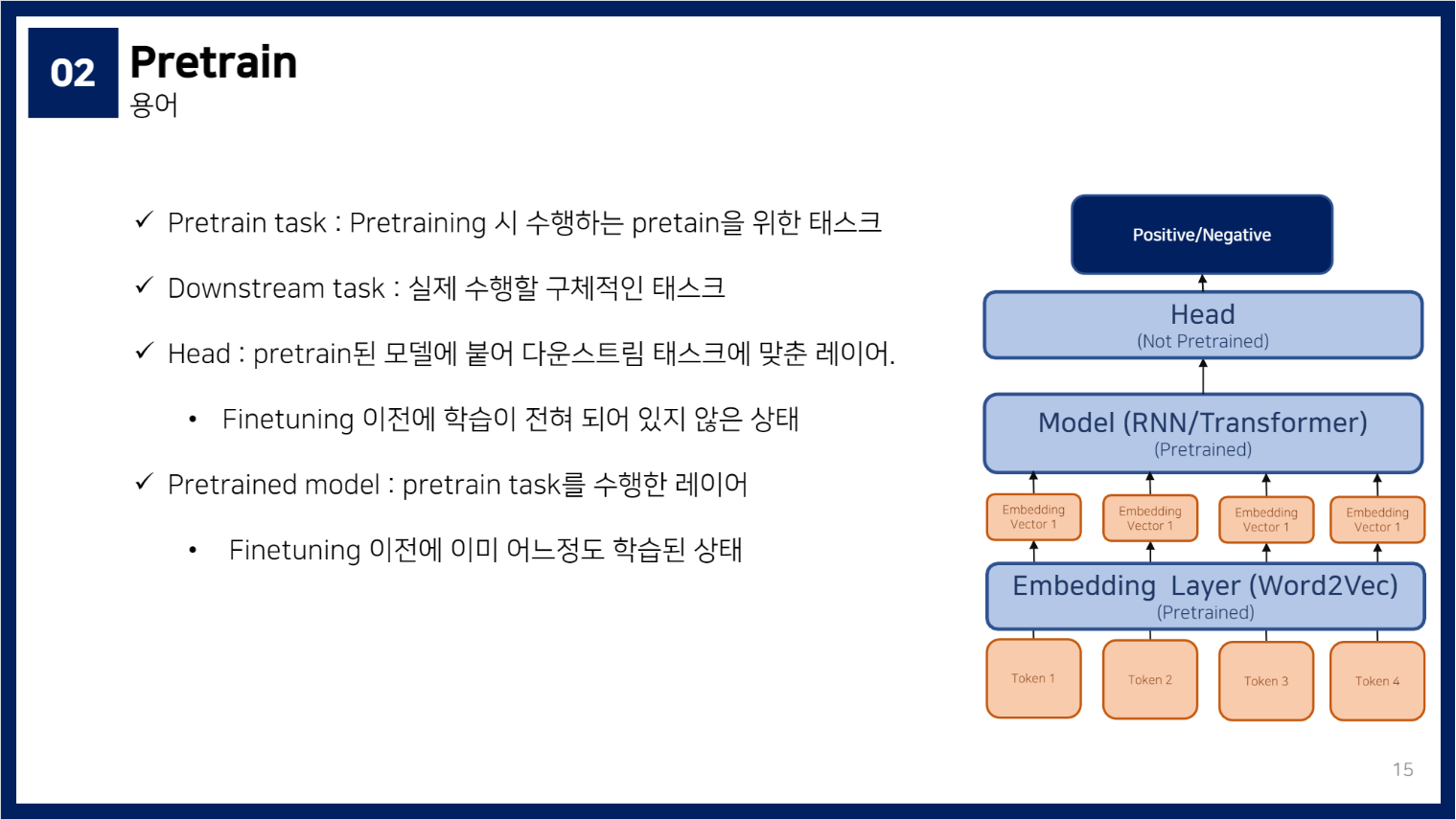

* Pretrained Model에 Head 붙이기

- ➕)

head를 좀더 쌓는 개선 방법들- ex.

convolution 1d layer를 하나 추가한 개선법 (지엽적 정보를 좀더 활용할 수 있게끔 만들어줌) - ex.

LSTM ld layer를 하나 추가한 개선법

- ex.

- ➕)

🤍✨🤍✨🤍