부스트캠프 AI Tech 3기 👩💻

1.[Pre] 온보딩 키트 도착 📦

1/17(월) 부터 시작하는 부스트캠프 AI Tech 3기의 온보딩 키트 도착🌟무한한 가능성🌟의 5개월 여정 스타트 💪

2.[1주차] boostcamp 회고록 (Python & AI Math)

💡 경사하강법(Gradient Desecent) 구현 Gradient Descent를 활용한 Linear Regression 구현 > 는 (오차*x값)의 평균, 에는 (오차)의 평균이 쓰였다. 수식의 의미를 피어세션에서 팀원들에게 질문하며, 계산에 쓰인 MSE의

3.[PyTorch] PyTorch 프로젝트 구조 (작성중)

4.[PyTorch] PyTorch 구조 학습하기

공식 Documentation https://pytorch.org/docs/stable/generated/torch.nn.Module.html정의모든 딥러닝을 구성하는 layer의 Base Class다. (Base class for all neural netw

5.[2주차] boostcamp 회고록 (Pytorch)

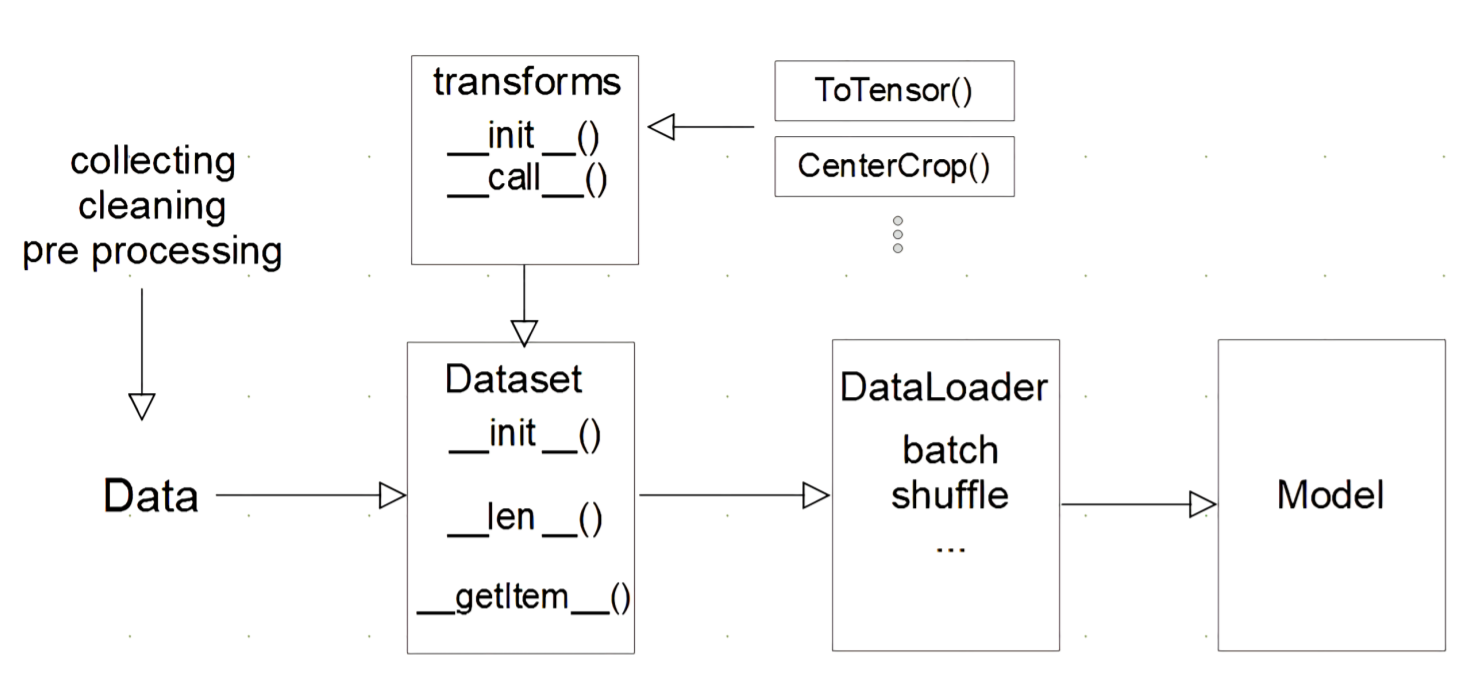

📝 2주차 회고 PyTorch의 다양한 함수들을 직접 과제에서 nn.Module 클래스를 활용한 Custom Model 정의하고, torch.utils.data 라이브러리 및 DataLoader 함수를 활용한 Custom Dataset을 정의하며, 적용해보며 성장한

6.[3주차] boostcamp 회고록 (Data viz)

피어 스터디 13. 서브워드 토크나이저(Subword Tokenizer) - 현재 통상적으로 많이 사용하고 있는 `Hugging Face`의 `WordPiece Tokenizer`(구글의 `BERT`모델)나 센텐스피스(`Sentencepiece`)(구글) 이

7.[DL Basic] 딥러닝 기본 및 최적화

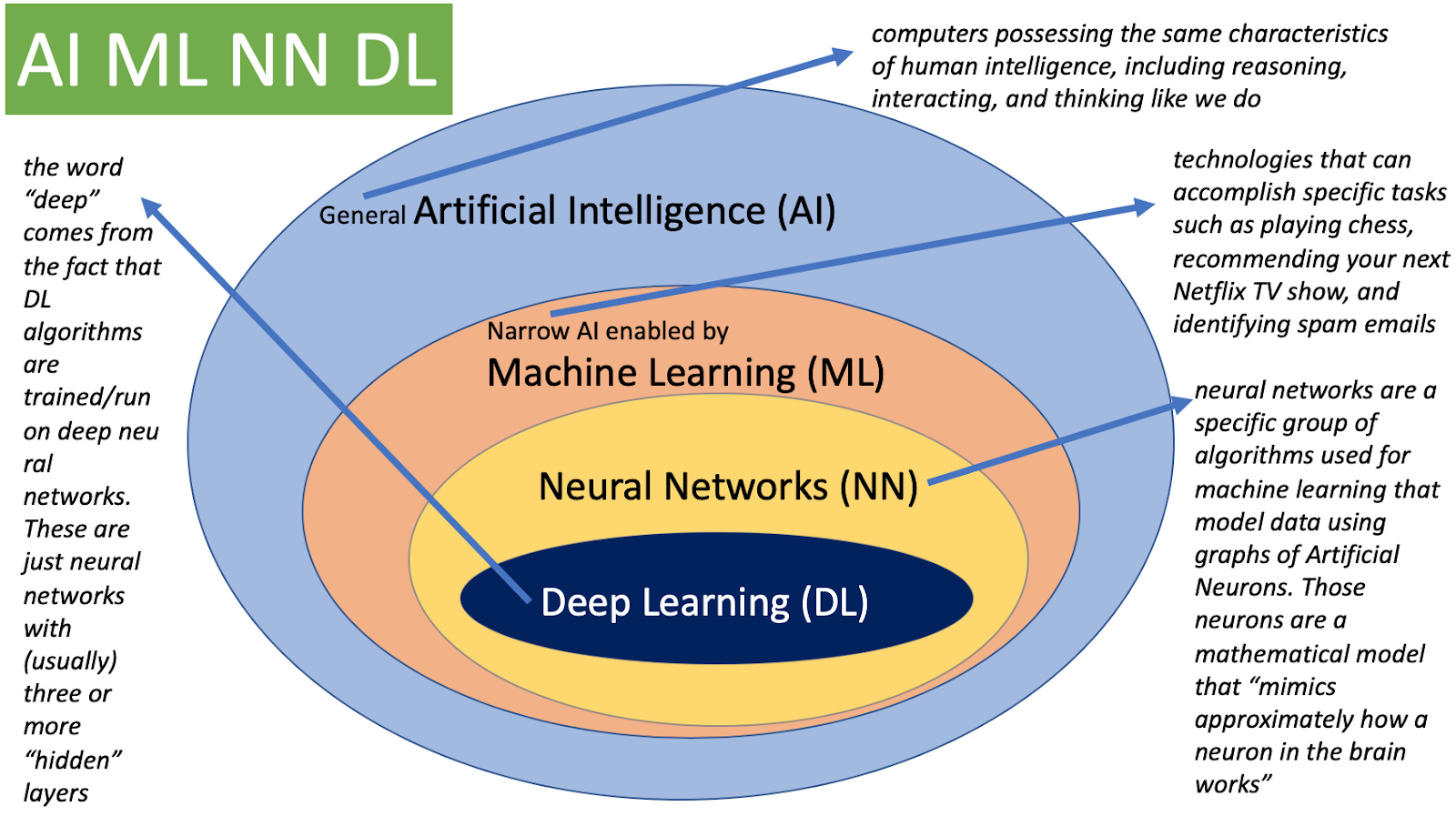

Deep Learning 딥러닝의 구분 AI (인공지능) Mimic human intelligence, 사람의 지능을 모방 ML (기계학습) Data-driven approach, 데이터를 기반으로 무언가를 (기계)학습 DL (딥러닝) Neural Networks

8.[DL Basic] Sequential Models - Transformer

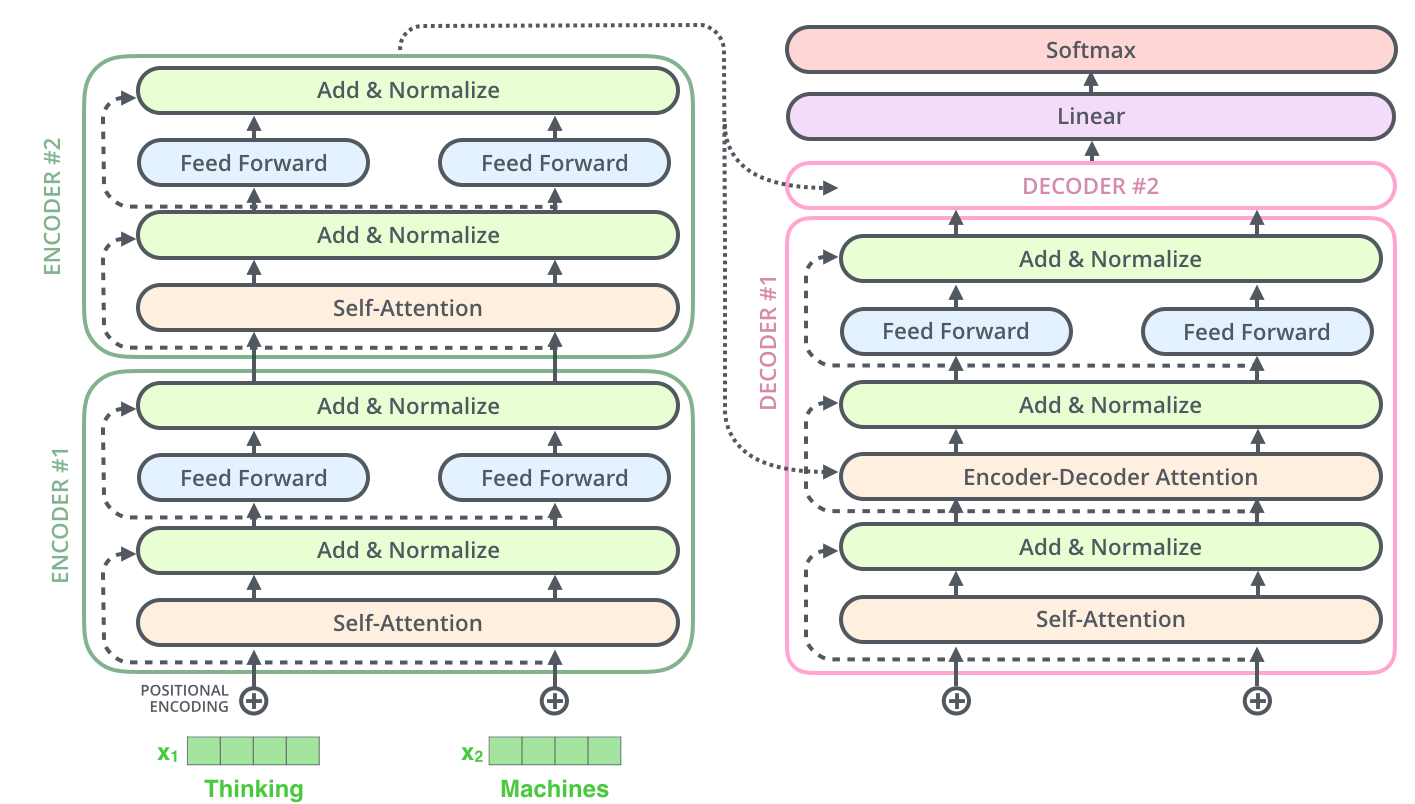

시퀀셜 모델링을 어렵게 하는 문제들 Sequence는 뒤에가 잘리는 경우, 중간에 생략되는 경우, 어순이 바뀌는 경우 등이 존재 따라서 재귀적으로(recurrersive) 동작하는 RNN 계열의 경우에는, 이런 문제들을 반영해 학습하기가 어려웠음. Transform

9.[DL Basic] Transformer - SDPA(Scaled Dop-Product Attention) & MHA(Multi-Head Attention) PyTorch 구현

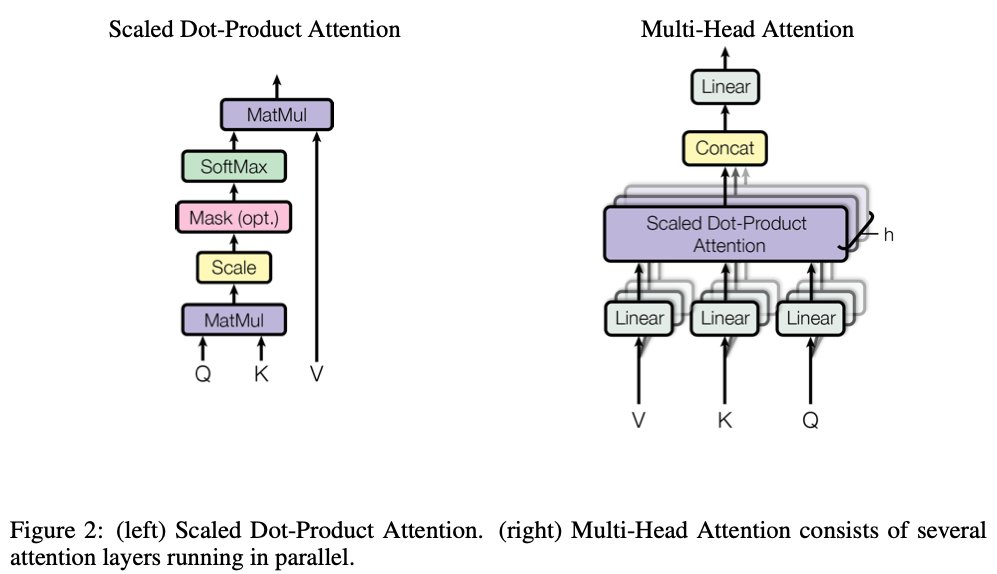

1. 셀프 어텐션 (SDPA(Scaled Dop-Product Attention)) 수식의 구현 Flow [1] Query벡터와 transpose한 Key벡터의 내적 [2] Key벡터의 차원의 루트 값으로 나누어 주어 정규화

10.읽어볼 만한 논문 List

🤍✨🤍✨🤍arXiv (Deep Mind)강화학습 (CV)https://arxiv.org/pdf/1312.5602.pdf?source=post_page---------------------------arXiv스타일 변환 (CV)https://arx