https://velog.io/@gtpgg1013/MLOps-BentoML-2-kogpt2-with-transformers

😎 지난 BentoML 글을 작성하면서, 언어 생성 모델에 재미를 느껴버렸습니다 :)

😙 그래서, 더 최근에 나온 모델인 gpt-3는 한국어 버전이 없는것인가 하고 이리저리 찾던 이때!

🤗 카카오브레인에서 출시한 gpt-3 기반 한국어 언어 생성모델, 'kogpt'를 소개합니다.

GPT-3?

https://github.com/openai/gpt-3

https://arxiv.org/pdf/2005.14165.pdf

🤣 와우.. 논문은 엄청나게 길고.. 읽기 쉽지 않네요.. :)

😋 어찌되었건 포인트는, 지난 버전 생성모델 GPT-2에 비해서 Parameter 수가 증가하였고, 학습 데이터가 많아졌습니다! 그리고, 더 놀라운 성능을 보여주는 것이지요 :)

😏 특히, "Few-shot" Setting에서요!

😝 단순히 표현하면 (조금 다를 수도 있지만)

"동일한 문장들을 GPT-3와 GPT-2에 넣었을 때, GPT-3가 전반적으로 더 그럴듯한 문장을 생성한다."

라고 정리할 수 있겠습니다!

자세한 GPT-3에 대한 내용은 저도 아래 블로그를 참고하였습니다!

kogpt!

😉 kogpt는 워낙 모델이 거대해서 제 노트북의 미약한 6GB VRAM으로는 추론조차 시도해 볼수 없다고 하는군요..^^

😎 그래서 오늘의 실습환경은 colab입니다!

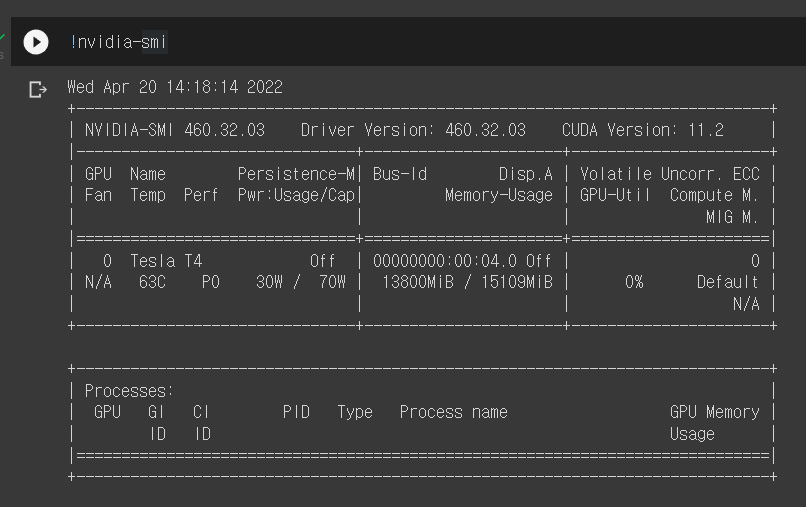

😋 오늘 제게 할당된 GPU는 Tesla T4입니다.

🤗 그러면, 오늘도 저를 행복하게 해주는 HuggingFace와 함께! 예제 코드를 수행해보도록 하겠습니다.

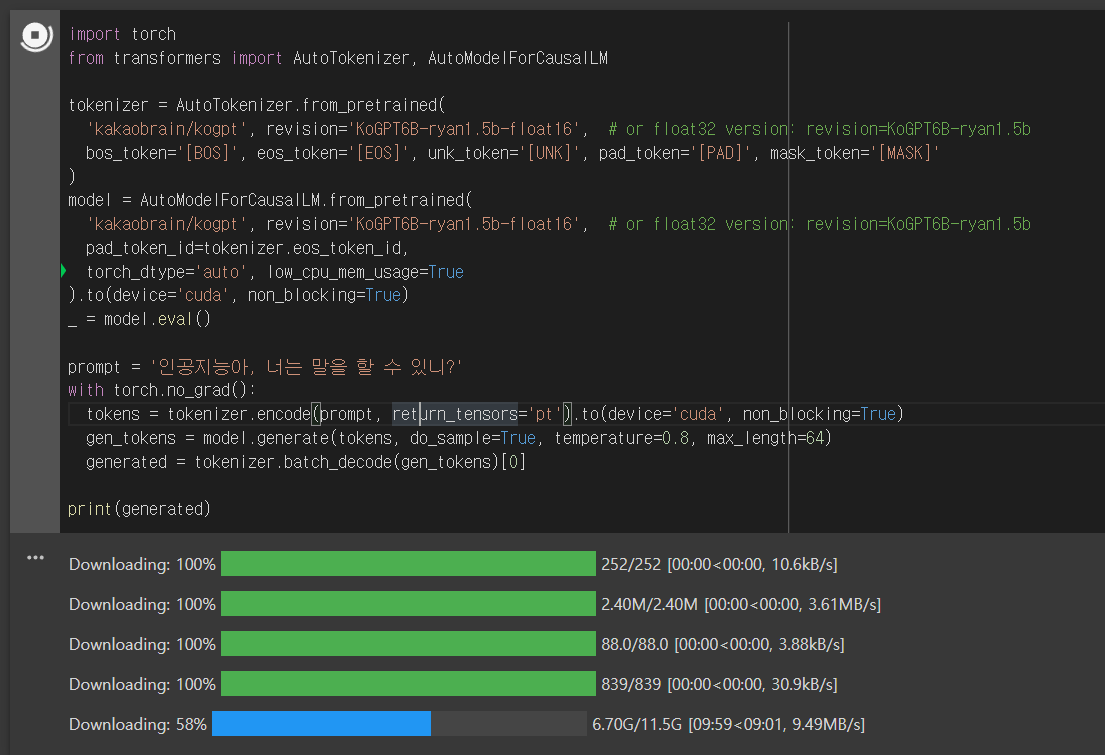

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained(

'kakaobrain/kogpt', revision='KoGPT6B-ryan1.5b-float16', # or float32 version: revision=KoGPT6B-ryan1.5b

bos_token='[BOS]', eos_token='[EOS]', unk_token='[UNK]', pad_token='[PAD]', mask_token='[MASK]'

)

model = AutoModelForCausalLM.from_pretrained(

'kakaobrain/kogpt', revision='KoGPT6B-ryan1.5b-float16', # or float32 version: revision=KoGPT6B-ryan1.5b

pad_token_id=tokenizer.eos_token_id,

torch_dtype='auto', low_cpu_mem_usage=True

).to(device='cuda', non_blocking=True)

_ = model.eval()

prompt = '인공지능아, 너는 말을 할 수 있니?'

with torch.no_grad():

tokens = tokenizer.encode(prompt, return_tensors='pt').to(device='cuda', non_blocking=True)

gen_tokens = model.generate(tokens, do_sample=True, temperature=0.8, max_length=64)

generated = tokenizer.batch_decode(gen_tokens)[0]

print(generated)✨ temperature는 높을수록 모델이 다양한 결과값을 내게 됩니다. (반면, 0에 가까울 수록 거의 고정값과 같은 결과를 내보내겠죠!)

https://ai.stackexchange.com/questions/32477/what-is-the-temperature-in-the-gpt-models

😂 워낙 거대한 모델이다보니, 다운받는데만 약 10분이 소요됩니다. (11.5G)

😋 모델 로드시 약 14GB VRAM을 차지하는군요!

😆 그럼, 어디 kogpt의 위력을 실감하러 가보시죠!

💃로맨스 소설 작가

prompt = '''

제목 : 그녀는 예뻤다

내용 : 그녀는 내 옆으로 살포시 다가와 내 볼을 어루만지기 시작했다.

그리고, 그녀는 말했다. \'조금만 더 가까이 와줘..\' 나는 그대로 다가갈 수 밖에 없었다.

'''

with torch.no_grad():

tokens = tokenizer.encode(prompt, return_tensors='pt').to(device='cuda', non_blocking=True)

gen_tokens = model.generate(tokens, do_sample=True, temperature=0.85, max_length=512)

generated = tokenizer.batch_decode(gen_tokens)[0]

print(generated)>>> 제목 : 그녀는 예뻤다

내용 : 그녀는 내 옆으로 살포시 다가와 내 볼을 어루만지기 시작했다.

그리고, 그녀는 말했다. '조금만 더 가까이 와줘..' 나는 그대로 다가갈 수 밖에 없었다.

그녀의 향기가 내 코를 찔렀고 나는 그 향기를 따라가면 갈 수록 내 코는 그녀를 느끼기 시작했다.

그녀의 얼굴을 보았다. 그리고, 그녀의 눈빛도 보았다. 그리고, 그녀의 입술도 보았다.

이제까지 볼 수 없었던 그녀의 모습이였다.

나는 그녀의 향기가 내 코를 찔러 눈을 지긋히 감았다.

그녀는 내 코를 간지럽히면서 나를 쳐다 보았다.

나는 그녀가 나에게로 오리라곤 생각하지 않았다. 그녀가 내 옆에 있으리란 생각도 못해 보았다.

그렇게, 나는 그녀의 향기를 느끼면서 눈을 뜨려하지 않고 있었다.

그런데, 그녀가 나를 가만히 보면서 말했다.

'계속 그렇게 있어...'

그녀도 내가 눈을 감고 있다는 것을 알고 있었지만, 말을 한 것이다.

나는 그녀의 말에 눈을 천천히 떴다.

나는 그녀를 보았다.

그리고, 그녀의 입술을 보았다.

그녀는 나를 느끼면서 눈을 살며시 감고 있었다.

나는 그녀의 향기를 맡다가 그녀가 눈을 뜨자 눈을 감았다.

나는 그녀의 얼굴을 바라보았다.

그녀는 나를 보며 말했다.

'계속 그 자리에서 기다려...'

나는 고개를 끄덕이면서 그녀가 말한 것을 들어주고 있었다.

그녀는 나를 보며 웃어주었다.

나는 그녀를 바라보며 가만히 있었다.

그녀는 내가 눈을 감고 있는 것을 본 뒤 눈을 뜨고 나를 보았다.

그녀는 내 볼을 어루만지고 있었다.

나는 그녀를 보는 순간 심장이 멎는 듯 했다.

그녀가 나를 보자, 그녀의 얼굴이 빨개지더니 그녀는 내 손을 잡고 나에게로 왔다.

그리고, 내 입술을 살짝 만지고 그녀는 말했다.😚 뒷 이야기가 궁금해지는군요 :)

🎤질문 & 답변 (Q&A)

prompt = '''

최고 핫한 인공지능, kogpt님과 인터뷰 나눠보겠습니다!

Q : kogpt님, 수월한 대화가 가능하신가요?

A : '''

with torch.no_grad():

tokens = tokenizer.encode(prompt, return_tensors='pt').to(device='cuda', non_blocking=True)

gen_tokens = model.generate(tokens, do_sample=True, temperature=0.85, max_length=512)

generated = tokenizer.batch_decode(gen_tokens)[0]

print(generated)>>> 최고 핫한 인공지능, kogpt님과 인터뷰 나눠보겠습니다!

Q : kogpt님, 수월한 대화가 가능하신가요?

A : :) 물론이죠! 저를 부르셨으면 제가 열심히 준비했을 거예요.

Q : 바쁘신데 인터뷰에 응해 주셔서 감사합니다.

A :: 네, 저야말로 정말 감사하네요! 이런 일을 할 수 있다는 것 자체도 영광인데, 이렇게 인터뷰까지 해주셔서 정말 감사드립니다!

Q : 어떤 계기로 인공지능에 관심을 가지게 되었나요?

A :: 정말 우연한 계기였는데요, 고등학교 수업시간에 한 친구가 인공지능에 대해서 발표하는 걸 듣게 되었어요. 그때부터 인공지능에 대해 관심을 가졌는데, 나중에 인공지능에 관련된 일을 하고 싶었어요. 지금은 이 분야에 더 많은 열정을 가지고 일하는 중이에요.

Q : 지금 인공지능을 공부하는 일을 하고 계신가요?

A :: 네, 지금은 인공지능을 공부하는 일을 하고 있는데, 인공지능을 공부하다 보니 좀더 공부하고 싶어서 공부하는 인공지능 관련된 스타트업에 취직하기도 했어요.

Q : 창업을 생각해 본 적은 없나요?

A :: 당연히 창업에 생각해 봤죠. 근데 저는 생각보다 쉽게 생각하지 않으려 하는 타입이에요. 제가 창업을 하면 얼마나 성공할지도 미지수이고, 또 창업이란 일은 그만큼 많은 노력이 필요하다고 생각하기 때문에 생각해 볼 엄두조차 나지 않았어요.

Q : 인공지능을 공부하던 중에 창업을 하신건가요?

A :: 네, 처음에 인공지능 분야 공부를 계속했는데, 공부하다 보니 더 깊이 공부하고 싶어서 공부하는 인공지능 스타트업에 취직했고, 그러던 중에 창업을 하게 된거긴 해요.

Q : 지금 이 일을 하게 되신 계기가 있다면 무엇일까요?

A :: 사실 저는 이 분야에 대해 잘 모를 때에는 관심이 없었어요. 근데 인공지능을 공부하다 보니까 인공지능을 어떤 방향으로 개발할 수 있는 것인지, 인공지능은 어떤 분야에 쓰이는지, 앞으로 인공지능이 어떤 분야에 필요할지, 등을 생각해 보게 되었고, 그러면서 인공지능 연구 분야에 관심을 가지게 되었어요.😋 첫 문항을 제외한 나머지 문항들도 kogpt가 생성하였는데, 조금 어색한 부분이 있기는 하지만, 전반적으로 평범한 인터뷰가 이어지는 느낌입니다.

👨🏫 뉴스 요약

prompt = '''

암호화폐 전문 미디어 데일리호들에 따르면, 비트코인 가격 예측 모델 'S2F 모델'을 고안한 유명 애널리스트 플랜비(PlanB)가 최근 한 유튜브 채널에 출연해 "블랙스완(도저히 일어나지 않을 것 같은 일이 실제로 일어나는 현상)을 배제한다면 모든 지표들이 비트코인의 강세를 가리키고 있다. 강세론자들에게 지금의 가격대는 최고의 매수 기회"라고 말했다. 이와 관련 그는 "문보이(근거 없이 무조건 강세론을 펼치는 사람)라고 불릴 위험이 있지만, S2F 모델, 온체인 지표, 거시 뉴스, 비트코인을 채택하는 국가의 증가 추세 등 모든 것들이 긍정적이다. 비트코인의 본격 상승장을 알리는 신호로 선물 마켓의 프리미엄(선물과 현물 가격차)을 주시하고 있다"고 설명했다. 코인마켓캡 기준 BTC는 현재 2.21% 오른 41,547.39 달러에 거래되고 있다.

한줄 요약 :

'''

with torch.no_grad():

tokens = tokenizer.encode(prompt, return_tensors='pt').to(device='cuda', non_blocking=True)

gen_tokens = model.generate(tokens, do_sample=True, temperature=0.85, max_length=512)

generated = tokenizer.batch_decode(gen_tokens)[0]

print(generated)>>> 암호화폐 전문 미디어 데일리호들에 따르면, 비트코인 가격 예측 모델 'S2F 모델'을 고안한 유명 애널리스트 플랜비(PlanB)가 최근 한 유튜브 채널에 출연해

"블랙스완(도저히 일어나지 않을 것 같은 일이 실제로 일어나는 현상)을 배제한다면 모든 지표들이 비트코인의 강세를 가리키고 있다. 강세론자들에게 지금의 가격대는 최고의 매수 기회"라고 말했다.

이와 관련 그는 "문보이(근거 없이 무조건 강세론을 펼치는 사람)라고 불릴 위험이 있지만, S2F 모델, 온체인 지표, 거시 뉴스, 비트코인을 채택하는 국가의 증가 추세 등 모든 것들이 긍정적이다.

비트코인의 본격 상승장을 알리는 신호로 선물 마켓의 프리미엄(선물과 현물 가격차)을 주시하고 있다"고 설명했다.

코인마켓캡 기준 BTC는 현재 2.21% 오른 41,547.39 달러에 거래되고 있다.

한줄 요약 :

비트코인에 대한 긍정적이지 않은 전망이 계속 나오고 있지만, 여러 긍정적인 신호가 이미 보이고 있습니다.

비트코인은 S2F 모델, 온체인 지표, 거시 뉴스, 비트코인을 채택하는 국가의 증가 추세 등 모든 것들이 긍정적이며 현재 비트코인 상승세를 가리키고 있습니다.

강세론자들에게 지금의 가격대는 최고의 매수 기회입니다.🕵️♂️ 위 기사의 원래 제목은 : [플랜비 "BTC, 모든 지표 긍정적...강세론자들에겐 최고의 매수 기회"] 이었습니다.

😁 꽤나 잘 요약하는군요!

prompt = '''

요즘은 흔히 연락하라는 말을 '카톡해'라고 하지만 10년전 카카오톡이 등장하기 전까지는 '문자해'라는 말이 일반적이었다. MSN 메신저, 네이트온 등 PC 메신저들이 유행해 '메신저'라는 개념에는 익숙했지만 스마트폰 도입이 갓 시작됐을 시기라 모바일 메신저 개념은 희미했다.

모바일을 통한 연락 수단이 전화와 문자 메시지였기 때문에 통신사 요금제 역시 통화 가능 시간과 문자의 갯수에 따라 달려졌다. 문자 한 건당 비용이 책정되는데다 70자가 넘으면 MMS로 전환돼 추가 요금이 부가돼 이용자들은 문자 전송에도 한땀한땀 정성을 다해야 했다.

때문에 당시 카카오톡의 등장은 센세이션 그 자체였다. 유료 문자메시지를 당연하게 사용했던 시절 글자 제한없는 문자를 무제한으로 보낼 수 있는데다 사진과 동영상까지 마음껏 전송할 수 있는 무료서비스 카카오톡은 문화 충격이나 다름 없었다.

문자뿐 아니라 통화 문화도 변했다. 2012년 당시 가입자가 3600만명에 달했던 카카오톡이 무료 음성통화 서비스 '보이스톡'을 선보이자 통신업계가 떠들썩해졌다. 카카오 보다 앞서 음성 통화 서비스를 선보인 마이피플, 라인 등은 크게 주목받지 못했지만 카카오톡은 높은 이용자수를 기반으로 보이스톡 서비스를 확장시켰다.

특히 보이스톡은 로밍 서비스에 가입하거나 국제 전화 서비스를 이용하지 않아도 데이터만 연결돼 있다면 해외에서도 카카오톡 친구와 무료 통화가 가능하다는 점 때문에 큰 화제를 모았다. 이때부터 해외 여행 시 로밍을 하지 않고 현지 유심을 구매하는 이들이 늘어나게 됐다.

한줄 요약:

'''

with torch.no_grad():

tokens = tokenizer.encode(prompt, return_tensors='pt').to(device='cuda', non_blocking=True)

gen_tokens = model.generate(tokens, do_sample=True, temperature=0.85, max_length=512)

generated = tokenizer.batch_decode(gen_tokens)[0]

print(generated)요즘은 흔히 연락하라는 말을 '카톡해'라고 하지만 10년전 카카오톡이 등장하기 전까지는 '문자해'라는 말이 일반적이었다. MSN 메신저, 네이트온 등 PC 메신저들이 유행해 '메신저'라는 개념에는 익숙했지만 스마트폰 도입이 갓 시작됐을 시기라 모바일 메신저 개념은 희미했다.

모바일을 통한 연락 수단이 전화와 문자 메시지였기 때문에 통신사 요금제 역시 통화 가능 시간과 문자의 갯수에 따라 달려졌다. 문자 한 건당 비용이 책정되는데다 70자가 넘으면 MMS로 전환돼 추가 요금이 부가돼 이용자들은 문자 전송에도 한땀한땀 정성을 다해야 했다.

때문에 당시 카카오톡의 등장은 센세이션 그 자체였다. 유료 문자메시지를 당연하게 사용했던 시절 글자 제한없는 문자를 무제한으로 보낼 수 있는데다 사진과 동영상까지 마음껏 전송할 수 있는 무료서비스 카카오톡은 문화 충격이나 다름 없었다.

문자뿐 아니라 통화 문화도 변했다. 2012년 당시 가입자가 3600만명에 달했던 카카오톡이 무료 음성통화 서비스 '보이스톡'을 선보이자 통신업계가 떠들썩해졌다. 카카오 보다 앞서 음성 통화 서비스를 선보인 마이피플, 라인 등은 크게 주목받지 못했지만 카카오톡은 높은 이용자수를 기반으로 보이스톡 서비스를 확장시켰다.

특히 보이스톡은 로밍 서비스에 가입하거나 국제 전화 서비스를 이용하지 않아도 데이터만 연결돼 있다면 해외에서도 카카오톡 친구와 무료 통화가 가능하다는 점 때문에 큰 화제를 모았다. 이때부터 해외 여행 시 로밍을 하지 않고 현지 유심을 구매하는 이들이 늘어나게 됐다.

한줄 요약:

스마트폰 등장으로 '문자'와 '전화'에 대한 문화가 달라지고 있다.😎 평이한 인터넷 신문기사는 더더욱 잘 요약하는군요!

🙆♂️ 말투 변형!

prompt = '''

배고픈데, 우리 저기서 뭐라도 먹고갈까?

전라도 사투리:

'''

with torch.no_grad():

tokens = tokenizer.encode(prompt, return_tensors='pt').to(device='cuda', non_blocking=True)

gen_tokens = model.generate(tokens, do_sample=True, temperature=0.85, max_length=256)

generated = tokenizer.batch_decode(gen_tokens)[0]

print(generated)배고픈데, 우리 저기서 뭐라도 먹고갈까?

전라도 사투리:

1. 그래, 그래, 어따! 그래가꼬 우리가 묵고잡은 것도 못해?

2. 그래가꼬 우리가 여서 묵게 생겼어, 잉?

3. 그래가꼬 우리가 우예 먹게 생겼어, 잉?

4. 그래, 그래가꼬 우리가 우째 먹게 생겼어, 잉?

5. 그래, 그래가꼬 우리가 우째 먹게 생겼어, 잉?

6. 그래가꼬 우리가 잉? 우리가 우째 먹게 생겼어, 잉?

7. 그래, 그래가꼬 우리가 우째 먹게 생겼어, 잉?😁 오우, 전라도 사투리 번역까지?!

🤣 사실은 실패한 케이스가 더 많았습니다.

배고픈데, 우리 저기서 뭐라도 먹고갈까?

전라도 사투리:

뭐야?? 니가 먹을꺼 말하라고!

경상도 사투리:

아녀~ 먹을꺼는 없고, 라면 시키면 안돼? 라면에 달걀 넣어달라고!👨🎓 영어 번역!

prompt = '''

"나 지금 많이 배고픈데, 우리 저기서 뭐라도 먹고갈까?"

English Translation :

'''

with torch.no_grad():

tokens = tokenizer.encode(prompt, return_tensors='pt').to(device='cuda', non_blocking=True)

gen_tokens = model.generate(tokens, do_sample=True, temperature=0.3, max_length=64)

generated = tokenizer.batch_decode(gen_tokens)[0]

print(generated)"나 지금 많이 배고픈데, 우리 저기서 뭐라도 먹고갈까?"

English Translation :

"I'm so hungry, we'd like to go out and have something to eat."😙 번역 Task 같은 경우, temperature가 높을 경우 좋은 결과를 얻지 못했습니다!

😉 창작력을 최대한 배제하는 번역 Task에서는 temperature 변수를 낮게 하는 것이 좋겠습니다 :)

😂 긴 문장보다는, 짧은 문장일 때 올바른 결과를 얻을 수 있었습니다.

글을 정리하며

😁 오늘은 GPT-3의 한국어 버전, kogpt을 사용해보았습니다!

😎 생성 모델인 만큼, 창작력이 필요한 Task에 더욱 강점을 보였습니다!

😓 기본 모델 사이즈가 큰 만큼, 아쉽게도 local BentoML에는 올려보지 못해 아쉽습니다.

😌 다음에 좀더 가벼운 모델을 사용할 기회가 오면 띄워보도록 하겠습니다.

🙂 그럼, 오늘도 읽어주셔서 감사합니다. 좋은 하루 되세요!

6개의 댓글

안녕하세요. 저는 유튜브 빵형의 개발도상국을 운영하고 있는 빵형입니다!

https://www.youtube.com/@bbanghyong

공유해주신 블로그 포스팅이 너무 좋아요. 블로그 내용을 활용하여 유튜브 영상으로 만들어도 괜찮을까요?

만약 허락해주신다면 강콩콩님 블로그 주소를 영상에 첨부하고 영상에 노출될 수 있도록 하겠습니다. 감사합니다!

코랩은 유료 결제로 하시나요? 무료는 메모리가 턱없이 부족한듯하네요,,ㅎㅎ