대푯값: 숫자 더미를 한줄로 요약

같은 데이터를 보고 평균으로 요약?

같은 데이터를 보고 중앙값으로 요약

같은 데이터를 보고 최빈값으로 요약

값의 균형점을 찾는 것 : 평균값

즉 데이터의 중심위치를 알려줌(데이터를 간단 요약)

하지만 극단값/이상치에 민감하다.

중앙값

데이터들의 크기 순으로 정렬했을 때 가운데 값

중앙값 구하는 방법

홀수일 때는 가운데 값

짝수일 경우에는 가운데 두값의 평균

대부분의 현실을 말하려면 중앙값

분석가들은 분석할 때 평균만 보고하는 것이아니라 중앙값,최빈값도 같이 보고해야한다.

최빈값

범주형(문자/카테고리) 데이터 특히 중요

(예시:범주형(장르,관람형태 등급)

Q. 언제 무엇을 알수 있냐?

실제 행동과 선호도를 보여줌(소비자의 선호 분석에 유용)

예시) 가격대별 프로모션

마케팅 전략에서 많이 팔아야하니까 선호도를 봐야하니 최빈값을 이용한다.

예시2)

[Drama, Drama, Comedy, Action, Drama, Comedy, Comedy]

장르 횟수: Drama 3, Comedy 3, Action 1

최빈값: Drama와 Comedy (동률이면 여러 개 존재 가능 → 다모드)

예시3)

상영시간 구간(버킷)으로 본 러닝타임-> 연속형 데이터를 구간을 나누어 보기

Short(<100분), Mid(100–139), Long(≥140)로 나누고 개수 세기

가장 많은 버킷이 최빈값 버킷 → “요즘 내가 보는 영화는 주로 Mid 러닝타임이네!

Q. 언제 유용하고, 언제 주의?

✅ 범주형: 장르, 국가, 관람 형태, 등급 → 최빈값이 가장 자연스러워요.

⚠️ 연속형(정확한 분 단위 러닝타임처럼 모두 값이 다른 경우)은 최빈값이 의미 없음

→ 이런 땐 구간을 묶어(버킷팅) 최빈 구간을 볼 수 있음

→ 즉 범주화를 시키는 것

→ 러닝타임을 구간(버킷)으로 나누는 건 ‘범주화(=이산화, binning)’

(연속형(분 단위 러닝타임)을 범주형(Short/Mid/Long 같은 라벨)으로 바꾸는 작업)

✅ 이상치(outlier)에 둔감(평균처럼 휘둘리지 않음),

⚠️ 표본이 작으면 우연에 좌우되어 불안정할 수 있다.

대푯값(평균, 중앙값, 최빈값)을 어떻게 쓰는 거냐? (세 값 비교)

평균만 보면 극단값을 알수 없다.

최빈값, 중앙값을 알아야 알수 있다

VIP 관리

중앙값 + 상위 분위수(예: p90, p95)로 체감 수준을 파악

평균은 “큰 손” 몇 명에 끌려 왜곡되기 쉬움 → 보조지표로 사용

가격대별 프로모션

최빈값: “가장 많이 사용된 프로모션 유형/코드/가격대”처럼 범주형에 적용

중앙값을 바라볼 필요가 없는 케이스

일반 고객 전략

평균+중앙값을 함께 제시 (치우침 확인)

최빈값은 카테고리/채널/요일 등 범주형 행동 파악에 활용

평균: 모든 값을 반영-> 극단값에 취약

평균은 “큰 손” 몇 명에 끌려 왜곡되기 쉬움 → 보조지표로 사용

중앙값: 일반적 수준-> 극단값에도 안정적

최빈값: 가장 흔한 선택-> 범주형/소비자 행동에 유용

✔️어떤 대표값을 보느냐에 따라 해석(결론)이 달라짐

한 쇼핑몰 데이터

평균 결제금액=30만원

중앙값=5만원

최빈값= 9900원

중앙값이랑 최빈값이 있어야 극단값의 존재를 알수 있고, 평균값만 보면 극단값의 존재를 잘 모름 중앙값은 대부분은 이정도의 금액을 쓰고 최빈값 가장 많이 팔린 책의 가격대를 알 수 있음

반 평균 키

반에서 10명의 평균키는 170cm

이 말만보고 우리 반 학생 대부분이 170cm 근처인 것을 알수 있는가?

(X)

다시 한번 말하면 평균은 극단값에 민감

실제로는 9명이 160cm대 1명이 210cm→ 평균이 170일 수도 있음 현실은 중앙값으로 봐야 더 정확.

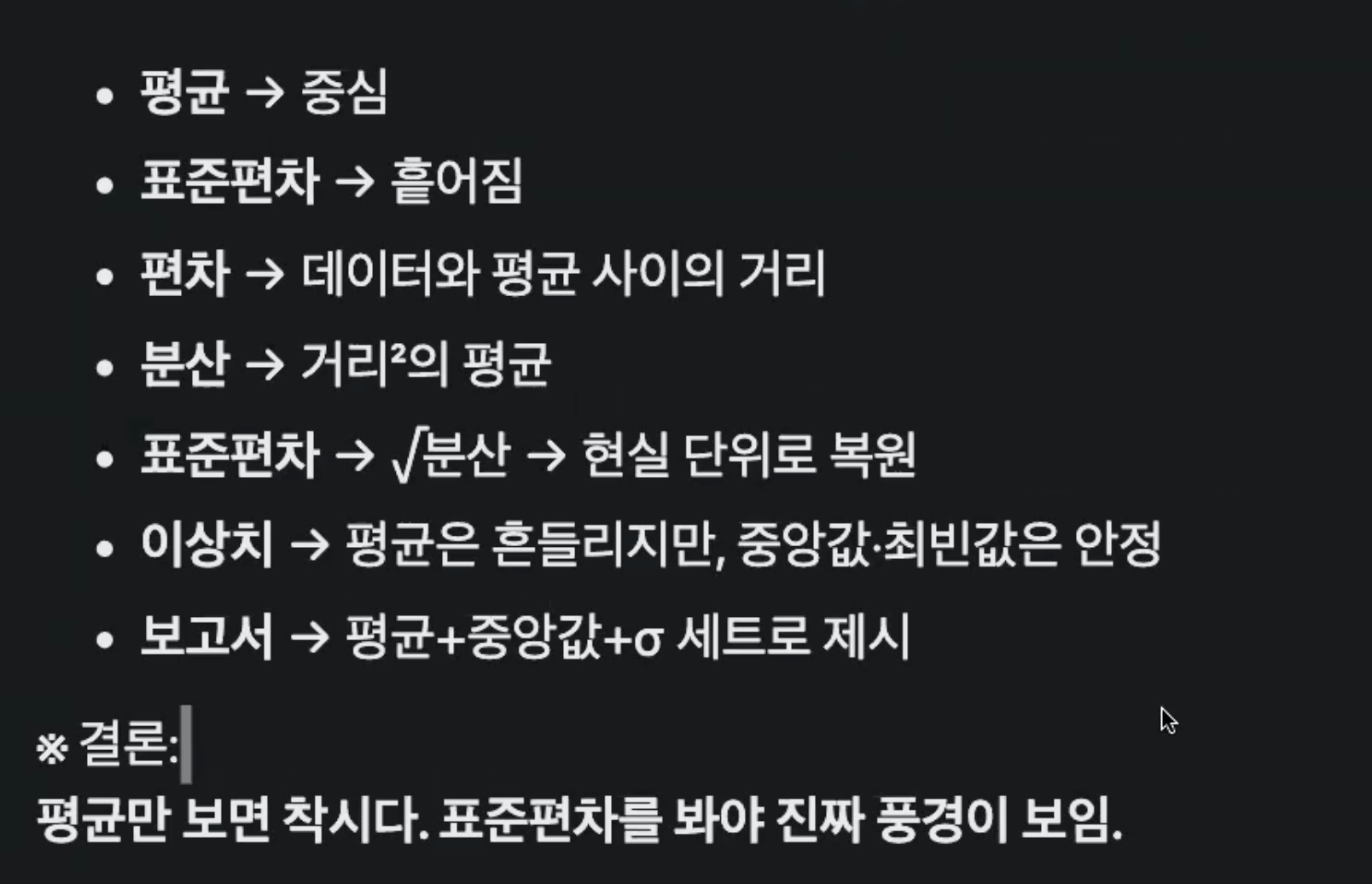

분산과 표준 편차

둘이 하는 일은 같다:데이터의 흩어짐을 보는 방법을 알아보자

대푯값이 존재하는 이유가 대푯값이 3개가 있는 이유가 데이터의 흩어짐때문에 그렇다

데이터의 흩어짐 있다.~에 의해 평균으로 봤을 때 분산과 표준 편차를 알 수 있다.

예시)

평균을 기준으로 봤을 때 흩어짐이 있음(중앙값 최빈값, 표준 편차를 보고 알 수 있음)

→ 이것을 보고 두 반 모두 평균은 똑같을지라도 흩어짐 정도에 따라 어떤 반이 더 안정적일까요?라는 질문을 던질 수 있게 됨

분석가의 역할

"데이터 분석가는 이 차이를 눈으로만 보는 게 아니라 숫자로 정확히 표현해야함"

분산과 표준 편차가 필요해진 이유

요약해서 본다=원시데이터 일부를 상실(삭제)했다는 의미, 각각 하나의 요소를 생략하여 하나의 값으로 요약함

삭제된 부분에서도 인사이트를 얻어야함→ 어떻게 분포가 되어있는지 알수 있는게 이게 분산과 표준편차라는 거!

평균은 중심을 말해줌

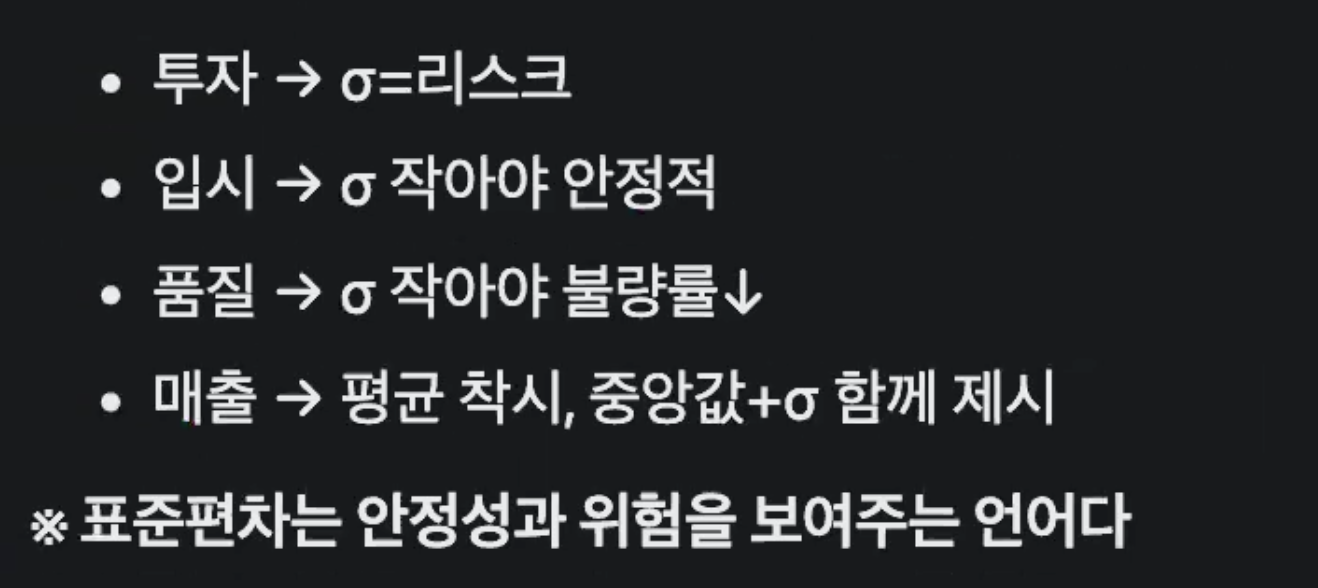

표준 편차는 데이터의 안정성과 위험을 말해줌

이상치 존재 전엔 평균, 중앙값, 최빈값이 같다 하였을 때 이상치가 존재하면 평균이 영향을 영향을 받음

편차 합=0->분산개념이 나오게 된 배경

각 데이터에서 평균을 빼면, 평균보다 큰 값은 +, 작은 값은 –가 됨

평균이 데이터의 중심(지렛대 중심)이라서, 결국 +와 –가 상쇄돼서 합이 0

평균이 지렛대 중심점이라 +,-가 상쇄됨

→ 그래서 "그냥 편차의 합"으로는 흩어짐 정도를 표현할 수 없음

왜 분산을 쓰는가?

**흩어짐을 숫자로 표현하고 싶기 때문에, “– 값”이 없어지도록 제곱을 취하기

제곱을 하면 모든 값이 양수가 되면서 상쇄 문제가 사라지고, 멀리 떨어진 값은 더 크게 반영

→ 이렇게 해서 생긴 게 분산(Variance) 개념이에요.

평균: “중심”을 알려주고,

분산/표준편차: “그 중심에서 얼마나 퍼져 있는지(안정적? 기복 있음?)”를 알려주는 도구가 된 거예요..

즉 우리는 흩어짐 정도를 보고 싶은데(그 대략적인 평균)을 구하고 싶은데 못보니까 분산이란 개념이 나오게 됨

이 0을 통해 평균을 구해 흩어짐을 숫자로 바꾸는게 목표인데 데이터 흩어짐을 숫자로 나타낼 수 없으니까 나오게 됨

분산: 편차의 제곱

값이 컸던 즉 편차가 컸던 요소의 값이 뻥튀기 된다. 하나의 요소가 차이가 크면 값이 뻥튀기 된다.

평균으로 부터 멀리 떨어진 요소는 멀리 떨어질수록 패널티를 받는거

이 개념은 머신러닝 강화학습에서 쓰임 상벌점때 쓰임

작은 실수에는 작은 벌 큰 실수에는 엄청 큰 벌 즉 큰 실수를 하면 안되겠다고 민감히 반응

통계학 기준으로 머신러니을 씀

->Q. 절댓값이 있는데 왜 제곱해서 양수를 만드나?

머신러닝(딥러닝) 이상치를 조금더 극대화하기위해

예) 알파고가 학습했던 방법이 바로 강화학습

제곱을 씌우면 변동이 컸다는 사실을 잃지 않고 표현할 수있음.

예시1 영화)

흥행 수익:

감독 A의 최근 3편 영화 흥행 성적: 10억, 100억, 200억.

평균 = 103억이라서 “항상 흥행한다”처럼 보일 수 있지만, 실제로는 들쭉날쭉

제곱을 씌워 계산하면 흥행 편차가 큰 감독이라는 게 드러남

예시2 NBA)

🏀 NBA 예시

선수 득점:

어떤 선수가 최근 3경기에서 10점, 30점, 50점을 넣었다치자.

평균은 30점이라서 “꾸준히 30점 넣는 선수네?”라고 착각할 수 있음.

하지만 실제로는 기복이 심하다는 것을 알 수 있음

제곱을 씌운 표준편차를 계산하면 이 선수는 폭발력은 있지만 불안정하다는 걸 알 수 있음

자유투 성공률:

시즌 전체 평균 자유투 성공률이 75%라고 해도,

어떤 날은 50%, 어떤 날은 100%라면 변동이 크다는 게 숨어있음.

분산/표준편차로 계산하면 클러치 상황에서 믿을 수 있는지 없는지를 더 잘 판단할 수 있음

*제곱을 씌우면 변동이 컸다는 사실을 잃지 않고 표현 할 수 있음

즉 분산은 편차를 제곱해 양수를 만들고 멀리 벗어난 값에 큰 가중치(=패널티)를 준다.

상쇄를 막지만 이상치에 민감해 질수 없음.

표준 편차-왜 루트?

평균(뮤(Mean, μ)),표준 편차(시그마(σ))

1️⃣ cm²의 의미

cm² = 제곱 센티미터

“길이(cm)”를 두 번 곱한 단위

예: 1cm × 1cm = 1cm²

보통 넓이(면적)를 나타낼 때 쓰임.

예)

정사각형 한 변이 1cm라면, 그 정사각형의 넓이가 1cm²

2️⃣ 왜 ‘제곱’이라는 말을 쓰는가?

단위 자체도 수치처럼 곱해짐.

예)

(2cm) × (2cm) = 4cm²

여기서 cm × cm = cm²

따라서 cm²는 “제곱한 길이 단위”가 아니라,

→ “길이 단위를 두 번 곱해서 얻은 면적 단위”라는 뜻이에요.

3️⃣ 혼동되는 포인트 (통계에서 분산할 때 단위²)

분산을 계산할 때도 “편차²”을 하니까 단위가 제곱됨

예: 키(cm) 데이터라면, 분산의 단위는 cm²

여기서 cm²는 실제 넓이가 아니라, 단순히 수학적으로 단위가 제곱된 것.

즉 루트씌뤄서 원래 단위를 돌려주는 거 이게 시그마(표준편차)

그래서 해석이 어렵기 때문에, 분산 대신 제곱근을 씌운 표준편차(cm 단위)를 주로 씀.

정리

분산:제곱단위->수학적 정의에는 유용, 쓰기에는 해석은 난해

→ 분산이 데이터에 흩어짐을 대표하는 수치로 바꿨는데 이 수치를 배운 이유는 무언가에 대해서 계속 써야하는데 이 단위가 난해

표준 편차:루트로 단위 복원-> 현실단위(cm)로 직관적

cm² 단위가 너무 크니까 다시 줄여준다.

| 평균 170cm, σ=5cm → 현실 단위(cm)로 직관적

예시 NBA(득점))

🏀 NBA 예시 (득점)

선수 A (꾸준형): 최근 3경기 득점 [25, 30, 35점]

평균: (25+30+35)/3 = 30점

표준편차: 작음 (±5점) → 안정적으로 평균치 근처 득점

선수 B (폭발형): 최근 3경기 득점 [0, 30, 60점]

평균: (0+30+60)/3 = 30점

표준편차: 큼 (±30점) → 경기마다 기복이 심함

👉 평균은 같아도(A와 B 모두 30점), 선수 스타일이 안정적인지 폭발적인지 표준편차가 알려줌.

✅ 결론:

평균(μ)은 “대표값”만 알려줌.

표준편차(σ)는 “얼마나 퍼져 있는가(기복이 있는가)”를 알려줌. (*데이터 분포의 “폭(너비)”**)

같은 평균이라도, 표준편차가 크면 불안정/다양, 작으면 안정/일관적.

--

데이터 변환과 표준 편차

+a(위치 이동): 평균만 이동,σ는 그대로

→ 이걸 이해할려면 편차를 이해해야하고 분산에 대해서 이해해야 되고 과정 다 더해보고 제곱해서 루트 씌운 다음에 단위 원래 되었지를 이해하고 있어야함

즉 위치만 이동하고 데이터 퍼짐은 그대로

xk(스케일 변화): 평균,σ 모두 확대/축소(줌이라 생각_

스케일 업

스케일 다운

스케일업/다운-> EDA에서 많이 쓰임

같은 수를 더하거나 곱하면 표준 편차가 어떻게 변하냐?

EDA에서 착시 없이 변동성을 해석하려면 이 감각이 필요함

EDA가 무엇인가?

EDA는 데이터 분석에서 아주 기초이자 중요한 단계

EDA = Exploratory Data Analysis (탐색적 데이터 분석)

데이터를 본격적으로 모델링하거나 결론 내리기 전에, 먼저 데이터를 눈으로 확인하고 요약 통계/시각화를 통해 “이 데이터가 어떤 특성을 가지고 있나?”를 탐색하는 과정

펀드 a: 평균 2.5%, σ=9%

펀드 B: 평균 2.5%, σ=2%

- 평균은 같아고 A는 리스크가 훨씬 큼 하이리스크 하이리턴할수 있음

평균은 같아도 B는 로우리스크 로우리턴

반 A: 평균 75, σ=3

반 B: 평균 75, σ=20

*σ 작은 반이 더 안정적, 합격률이 높다.

쉽게 말해, “데이터와 친해지는 시간”이라고 할 수 있음.

스케일 업/다운 왜 하냐?

A 영화점수 0~5에서 분포

B사이트 영화점수 0~100분포

즉 비교하는 단위/크기가 다르다 즉 비교를 하기 위해 쓰이는 거 예를들어 4.5

비교하는 단위/크기 다른 걸 맞춰주기 위해?

1) 공정 비교: 서로 다른 단위(0–5 vs 0–100, kg vs lb)를 같은 눈금으로 맞춰야 평균·순위·가중합이 의미 있어짐.

2) 결합/종합 점수: 여러 지표를 합산·가중 평균하려면 규모 차이가 큰 지표가 지배하지 않도록 크기를 맞춤.

3) 알고리즘 안정성: 거리·기울기 기반(예: KNN/K-Means/회귀) 모델은 스케일에 민감. 스케일링이 학습 안정과 속도를 개선.

해석성과 시각화: 모두 0–100(%)로 바꾸면 한눈에 이해하기 쉬움.

평균과 중앙값의 위치를 보고 유추를 할수도 있어야한다.

평균만 보고는 잘 모를 수 있다.

데이터의 흩어짐 있어야 의미있는 분석이 될 수도 아닐 수도 흩어짐 정도에 따라 데이터 분석적으로 해석할 수 있고, 인사이트를 도출도 다를 수 있다..

표준편차는 퍼짐(스케일)을 정량화한다. 같은 분포족(예: 정규분포) 안에서는 표준편차가 커질수록 곡선이 가로로 늘어나고, 작을수록 좁아진다. 다만 표준편차만으로 분포의 ‘모양’을 다 알 수는 없으므로, 여러 확률분포를 이해하려면 위치(평균/중앙값), 스케일(표준편차·IQR), 모양(왜도·첨도·꼬리)까지 함께 본다.”

최종 정리

분산 편차의 제곱의 평균

표준편차: 평균에서 전형적이 거리로 해석 데이터의 흩어짐을 표준 편차로 보자

즉 평균을 기준으로 흩어짐의 정도를 볼 수 있다.

어떤 날은 버스의 시각이 있다 어떤 날은 빠르게 어떤 날은 느리게 올 수도 있다. 이 흩어짐을 보기위해 표준 편차가 필요한가