DL Basic 1강) 딥러닝 기본 용어 설명

딥러닝의 4가지 요소

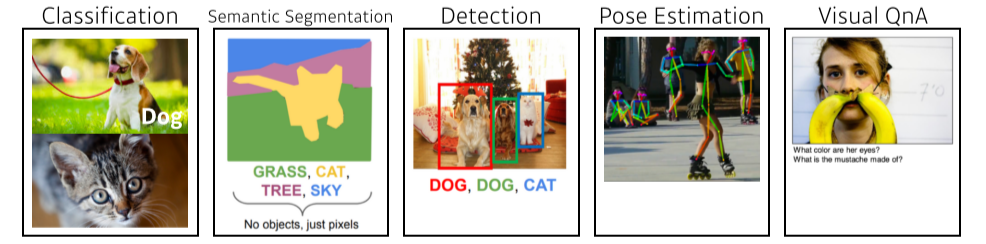

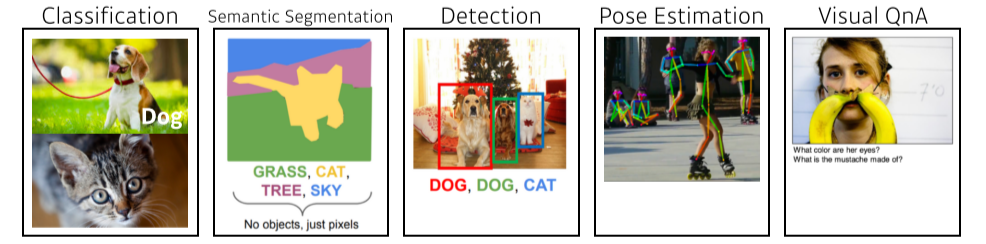

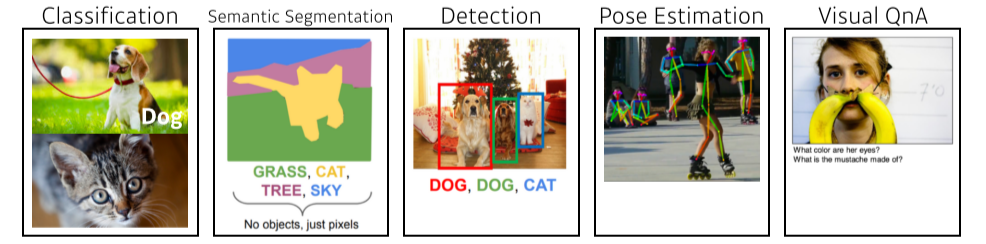

Data

- 모델을 학습시킬 자료

- 문제에 dependent

Model

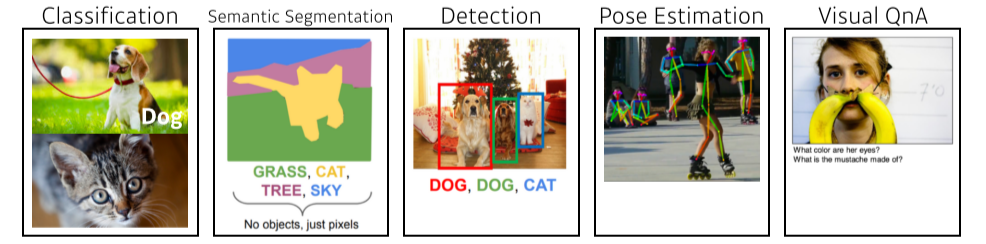

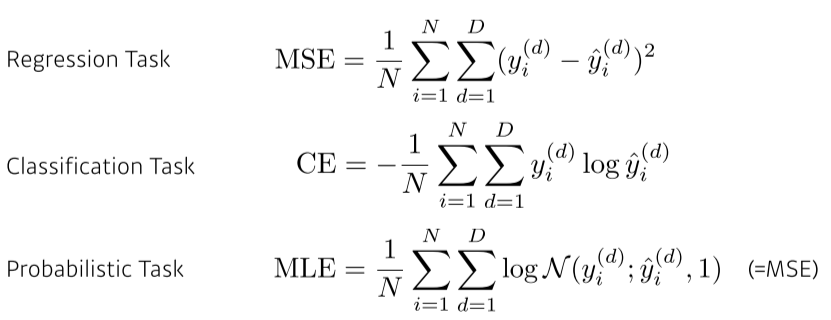

Loss

- loss (function): 모델의 badness를 측정, 이루고자 하는 것에 대한 근사치(proxy)

- data, model이 주어져있을때 model을 어떻게 학습할지를 결정

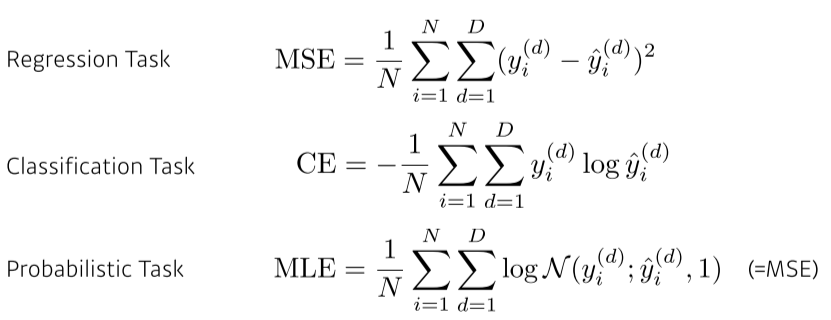

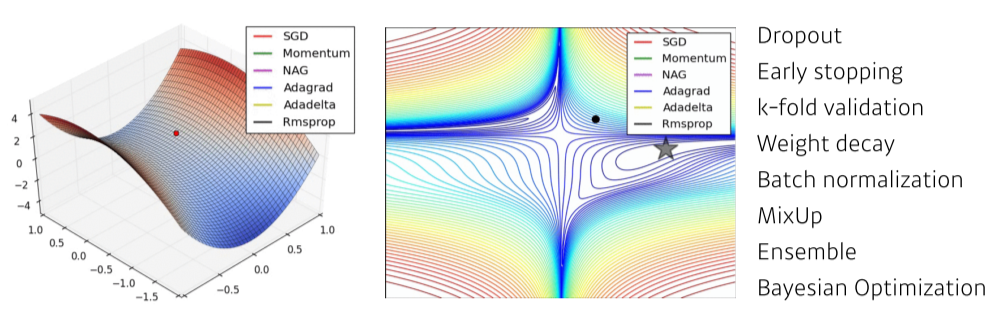

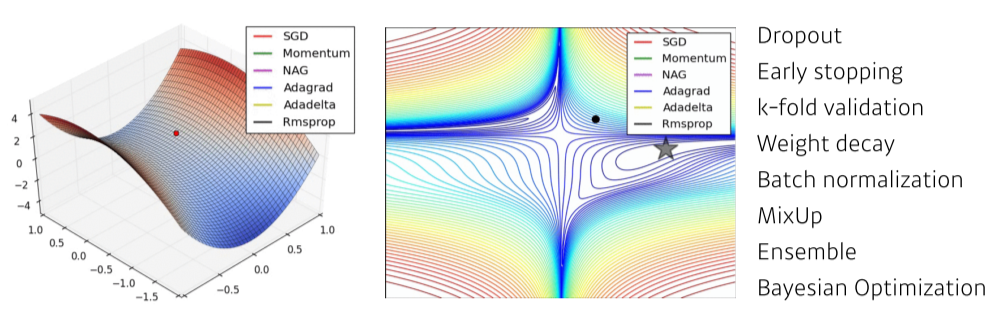

Optimization Algorithm

- algorithm: loss를 최소화하기 위해 parameter를 조정

- 네트워크가 학습데이터에서만 잘 동작하는 것이 아니라 경험해보지 못한 test data에서도 잘 동작할 수 있게 여러 테크닉을 이용

Historical Review

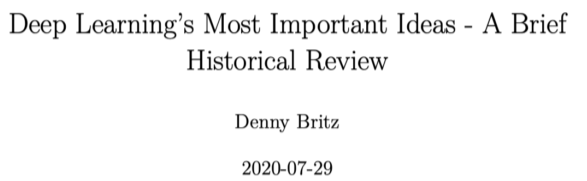

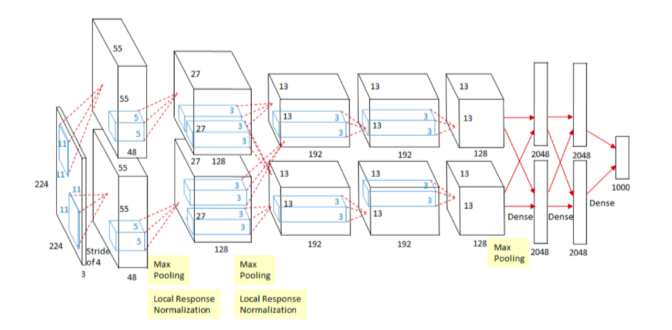

2012 - AlexNet

- ILSVRC(ImageNet Large Scale Visual Recognition Challenge, 이미지 분류 경진대회)에서 1등을 한 CNN 모델

- 막연히 잘될거라 생각했던 DL이 실제로 성과를 냈고 ML의 판도를 바꿔놓음

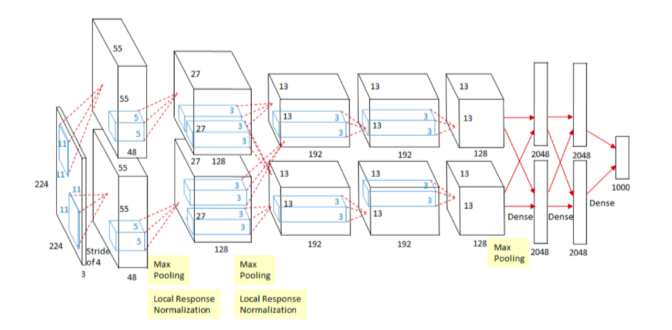

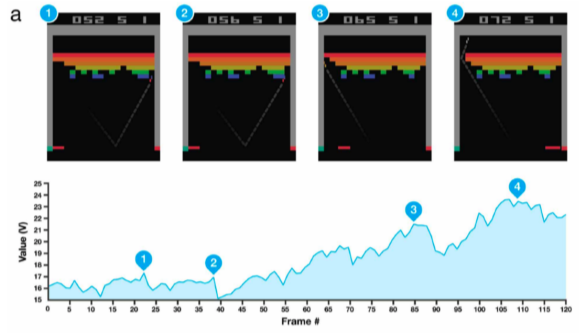

2013- DQN

- 알파고를 만든 DeepMind가 개발한 모델

- Q 함수를 이용

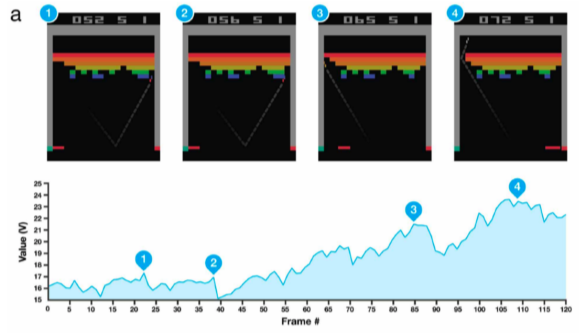

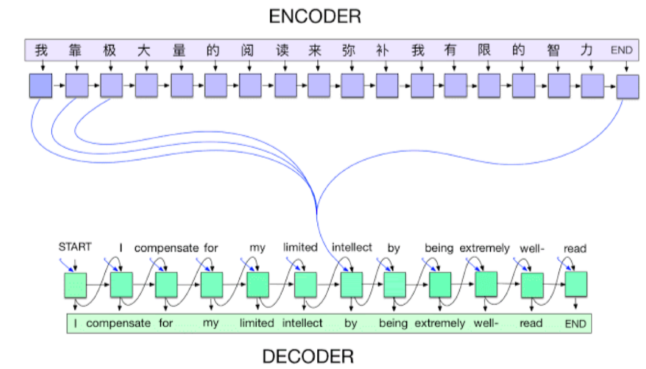

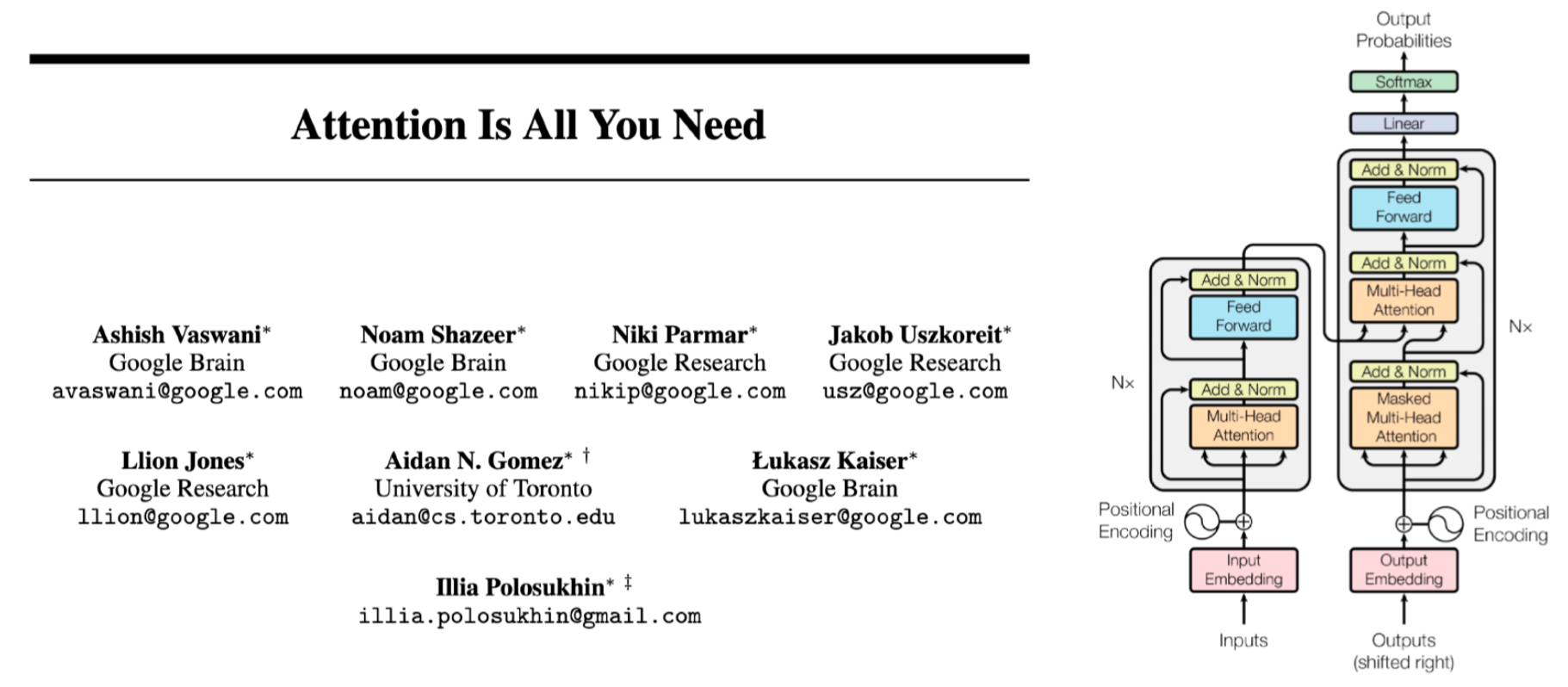

2014 - Encoder / Decoder

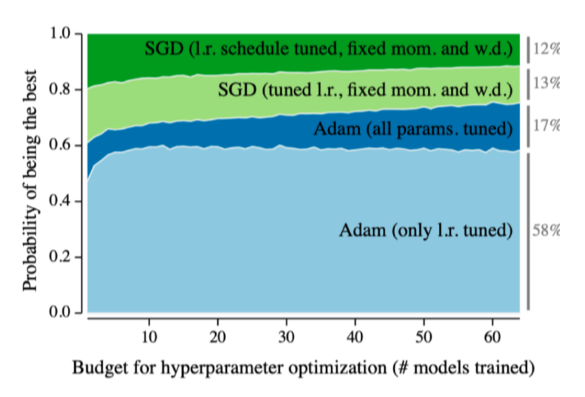

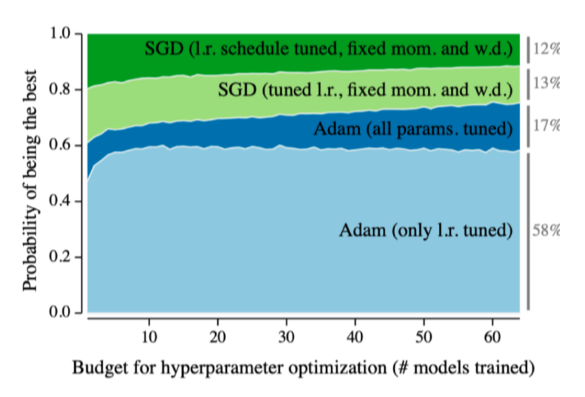

2014 - Adam Optimizer

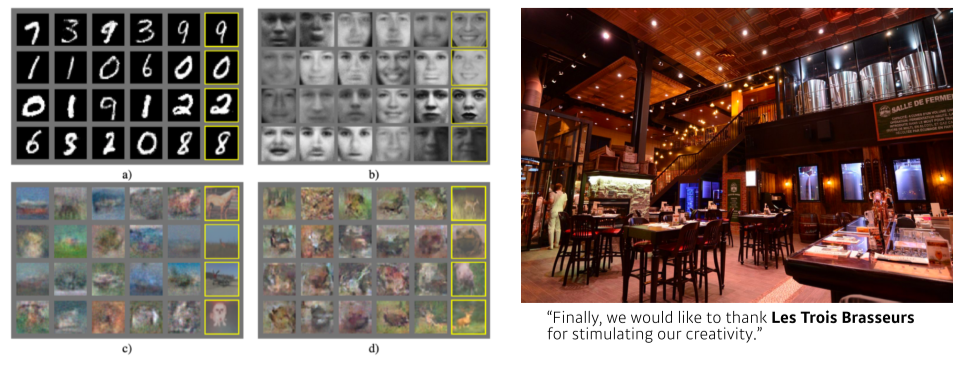

2015 - GAN, Generative Adversarial Network

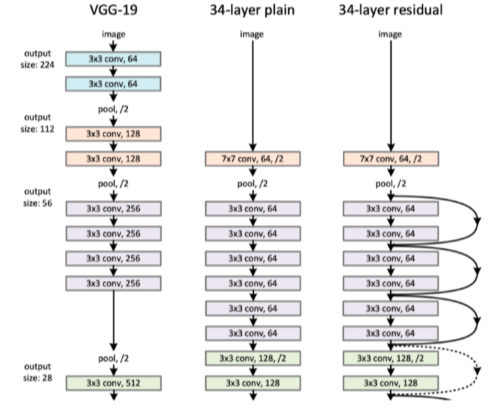

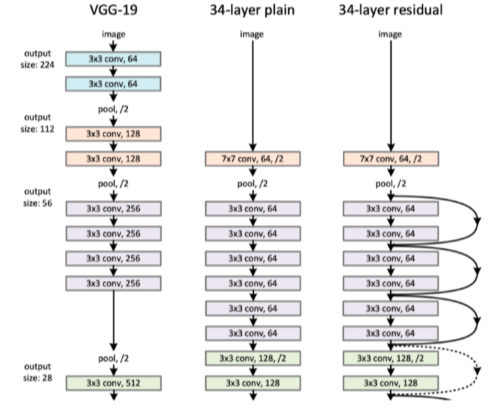

2015 - Residual Networks

- DL이 DL이 될 수 있었던 모델

- 이전까지는 deep model의 성능이 안 나와서 shallow하게만 쌓았었는데 ResNet으로 깊게 쌓을 수 있게 됐다

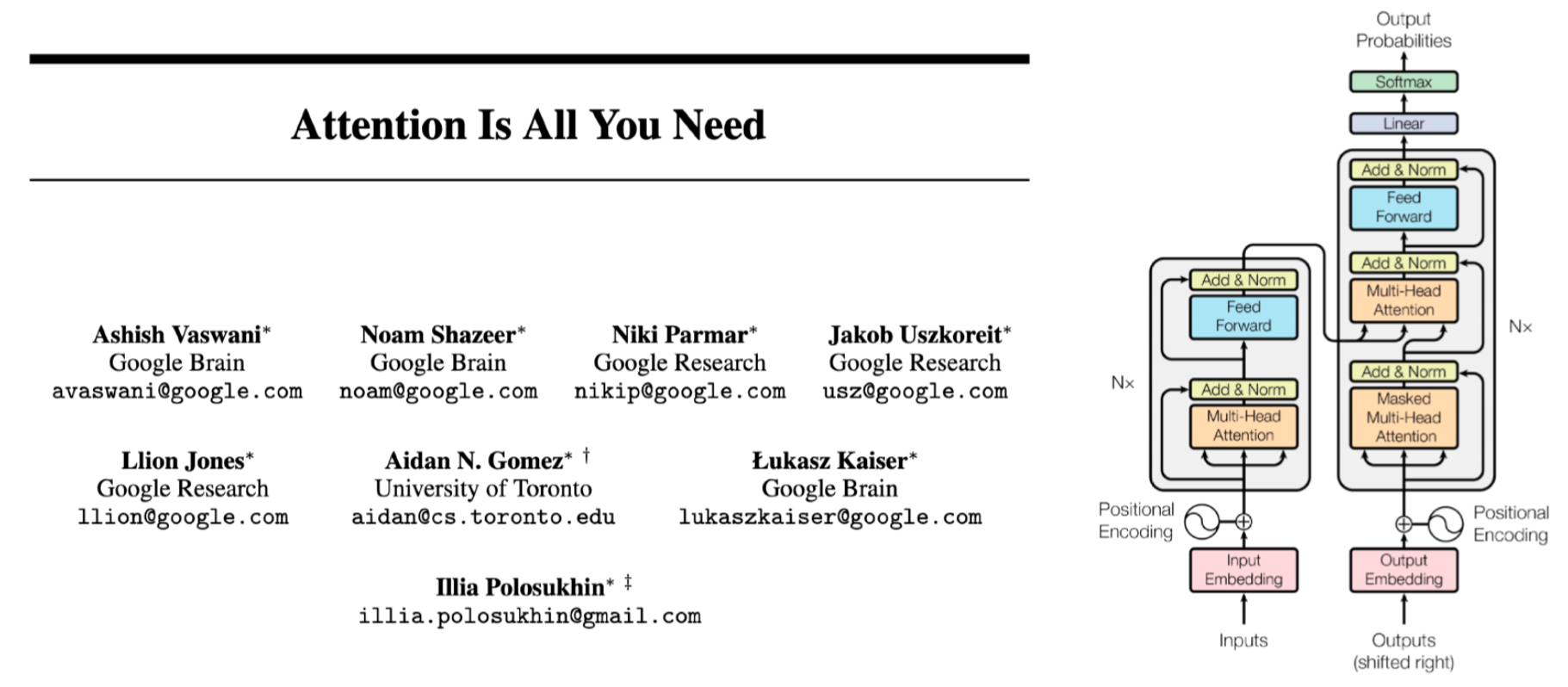

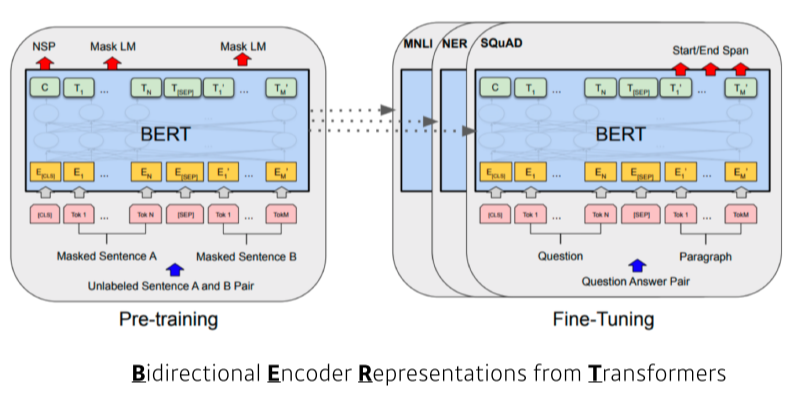

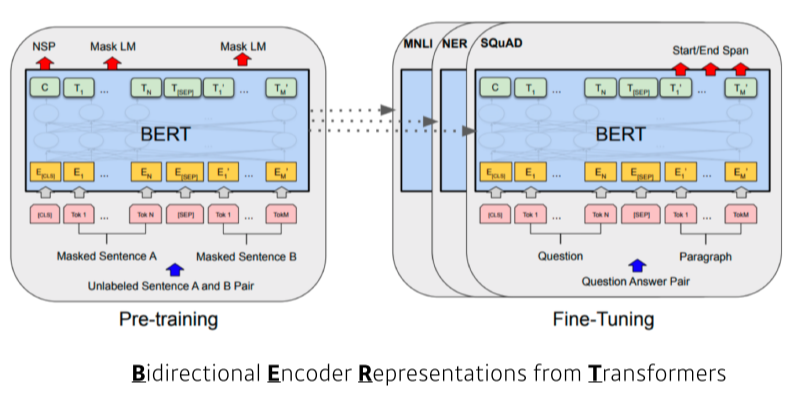

2018 - BERT(fine-tuned NLP models)

- 위키피디아 같은 큰 단어 뭉치로 pre-training 한 후, 내가 풀고자 하는 소수의 데이터에 fine-tuning한다

2019 - BIG Language Models

- 약간의 fine-tuning을 통해 여러 문장, 표 같은 sequential model을 만들 수 있다

- 굉장히 많은 parameter이 강점이자 특징

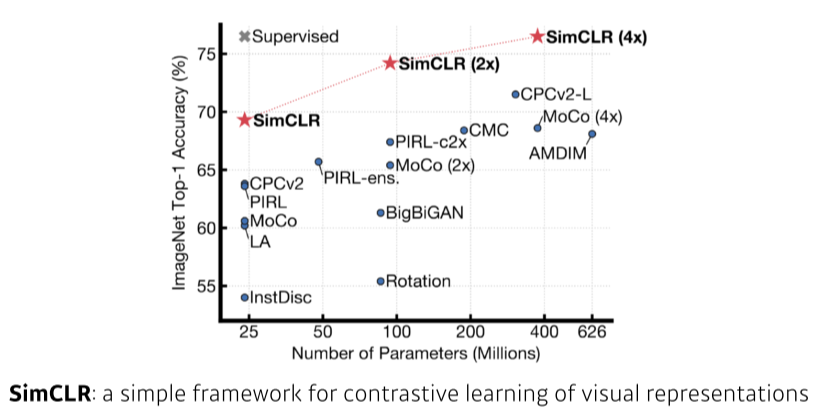

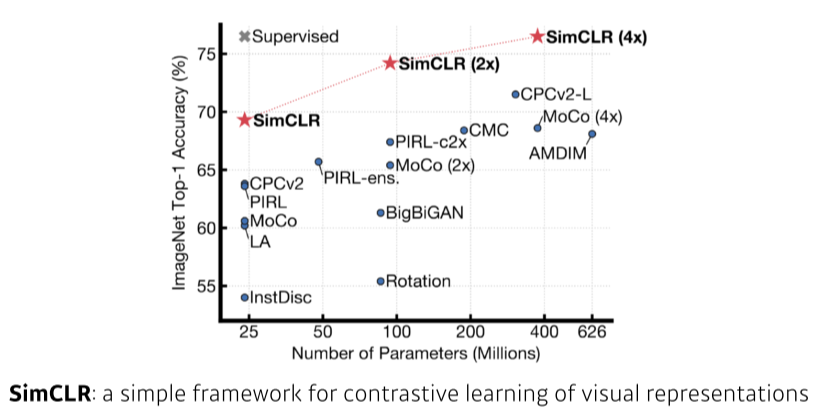

2020 - Self Supervised Learning

- 학습데이터 외에 label을 모르는 unsupervised data를 활용

- 요즘엔 필요한 학습데이터를 직접 만드는 방법도 사용