Point Transformer

Abstract

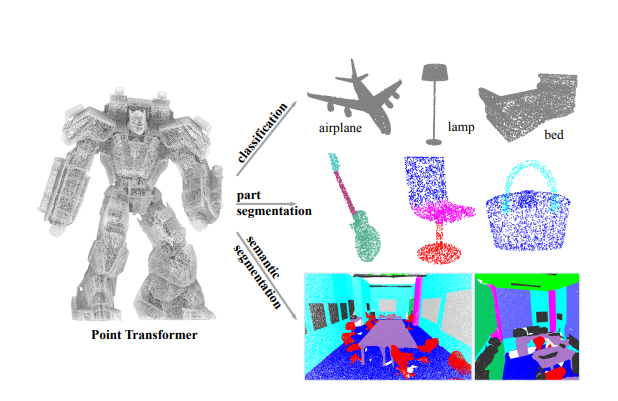

self-attention network는 자연어 처리, 이미지 분류 및 객체 탐지에 놀라운 발전을 이루고 있음. 이에 영감을 받아, 3D point cloud 처리에 self-attention network 적용을 탐구하고자 함. 3D point cloud를 위한 self-attention network를 구축하여 semantic scene segmentation, object part segmentation 및 object classification과 같은 작업을 수행함.

Introduction

point cloud는 image와 본질적으로 다르기에 컴퓨터 비전에서 많이 사용되는 discrete convolution operator를 즉각 적용하기에 어려움이 있습니다. 이러한 한계를 극복하고자 voxlization, pooling operator, continuous convolutions, graph 방법 등이 연구되었습니다. 본 연구에서는 self-attetntion의 특성에 주목하여 point cloud에 즉각 적용할 수 있는 모델을 개발하고자 합니다.

transformer 모델 계열은 특히 point cloud 처리에 적합합니다. 이는 transformer network의 핵심인 self-attention 연산자가 본질적으로 집합 연산자이기 때문에 입력 요소의 순열과 카디널리티에 불변한 특성을 지닙니다. point cloud는 3D space에 임베드되어 있는 집합이기에 이러한 연산은 자연스럽게 다가옵니다.

여러 실험을 통해 transformer가 3D 공간에서의 복잡한 구조를 효과적으로 학습하고 이해할 수 있는 능력을 가지고 있음을 입증하였습니다.

Contribution

- point cloud 처리를 위한 표현력이 뛰어난 Point Transformer 레이어를 설계함. 이 레이어는 순열과 카디널리티에 불변하므로 point cloud 처리에 본질적으로 적합합니다.

- Point Transformer 레이어를 기반으로, point clouds에서의 classification과 dense prediction을 위한 높은 성능의 Point Transformer 네트워크를 구축하였습니다. 이러한 네트워크는 3D 장면 이해를 위한 backbone으로 사용될 수 있습니다.

- 다양한 도메인과 데이터셋을 통해 광범위한 실험 결과를 보였습니다.

Related Work

Projection-based networks

불규칙한 입력인 point clouds를 처리하는 직관적인 방법은 불규칙한 표현을 규칙적인 것으로 변환하는 것임. 2D CNN의 성공을 고려하여, 일부 접근 방식은 multi-view projection을 통해 다양한 이미지 평면에 3D point clouds가 투영되고, 이후 2D CNN을 사용하여 이미지 평면에서 특성 표현을 추출한 다음, multi-view feature fusion을 통해 최종 출력 표현을 형성함. 하지만, 이 접근 방식은 tangent estimation(접선 추정)에 지극히 의존함. 투영 단계 동안 point clouds 내의 기하학적 정보가 붕괴됨.

Voxel-based networks

불규칙한 points clouds를 규칙적인 표현으로 변환하는 또 다른 접근 방법은 3D voxelization을 통한 방법임. 3D CNN을 적용할 수 있으나, 단순히 적용할 경우 복셀 수가 증가함에 따라 엄청난 계산 및 메모리 비용을 초래할 수 있음. 해결책은 대부분의 복셀이 일반적으로 비어 있기 때문에 희소성을 활용하는 것임. 복셀이 차지한 곳에서만 평가되는 sparse convolutions 기반 접근 방식은 계산 및 메모리 요구 사항을 더욱 줄일 수 있음. 이러한 방법들은 좋은 정확도를 보여주었지만, 복셀 그리드에 양자화되면서 기하학적 세부 정보를 일부 손실할 수 있습니다.

Point-based networks

2D나 3D의 규칙적인 그리드에 불규칙한 point clouds를 투영하거나 양자화하는 대신, 연구자들은 연속 공간에 내장된 집합으로서 직접 point clouds를 처리하는 딥 네트워크 구조를 설계함. PointNet은 pointwise MLPs와 풀링 레이어와 같은 순열 불변 연산자를 사용하여 집합 전체에서 특성을 집계함. PointNet++는 이러한 아이디어를 계층적 공간 구조 내에서 적용하여 로컬 기하학적 배치에 대한 민감성을 증가시켰음. 이러한 모델은 point set의 효율적인 샘플링에서 이점을 얻을 수 있으며, 다양한 샘플링 전략이 개발되었음.

이외에도 그래프의 point set으로 정보를 전달하거나, 연속(continuous) 컨볼루션을 기반한 방법들을 적용하였음.

Transformer and self-attention

이전 연구들은 point cloud 분석을 위해 attention을 활용했지만, 전체 point cloud에 global attention을 적용하여 큰 계산 부담을 초래하고 large-scale 3D scene understanding에는 적용할 수 없게 만들어 놓았습니다. 또한 서로 다른 채널에 같은 집계 가중치를 공유하는 scaler dot-product attention을 사용하였습니다.

반면, self-attention을 지역적(locally)으로 적용하여 수백만 개의 점을 포함한 large scenes에 확장할 수 있도록 하고 vector attention을 활용하여 높은 정확도를 이끌어내었습니다. 또한, 이전 연구에서는 생략된 position information에 반해, large-scale point cloud understanding에서 적절한 position encoding의 중요성에 대해 설명하였습니다.

다음 챕터에서 본격적으로 point transformer의 background와 method, experiments를 살펴보겠습니다.

Zhao, Hengshuang, et al. "Point transformer." Proceedings of the IEEE/CVF international conference on computer vision. 2021.