딥러닝 학습률의 개념부터 문제 해결 팁까지

딥러닝을 공부하다 보면 가장 많이 마주치게 되는 하이퍼파라미터 중 하나가 바로 Learning Rate(학습률)입니다.

간단한 개념부터, 너무 크거나 작을 때 생기는 문제, 그리고 실무에서 어떻게 활용하는지까지 정리해봤어요.

1. Learning Rate란?

딥러닝 모델이 파라미터를 얼마나 크게 업데이트할지 결정하는 값입니다.

경사하강법(Gradient Descent)에서는 다음과 같은 식으로 파라미터를 업데이트하죠:

여기서

- 는 모델의 파라미터

- 는 손실 함수의 기울기

- (learning rate)는 이동의 크기를 결정합니다

크게 설정하면 한 번에 멀리 이동하고, 작게 설정하면 조금씩 천천히 이동합니다.

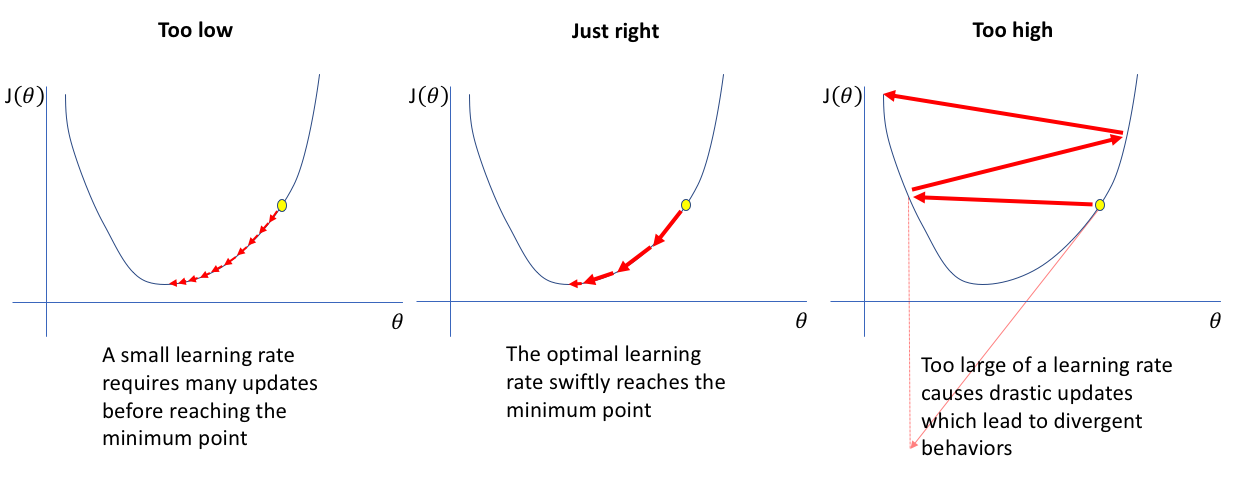

2. 적절한 Learning Rate란?

- 너무 크지도, 너무 작지도 않은 값

- 손실(loss)이 안정적으로 감소하며 수렴

- 일반적으로

1e-4 ~ 1e-2범위가 자주 사용됩니다

3. Learning Rate가 너무 크면?

- 파라미터가 한 번에 너무 많이 이동

- 최적점을 지나쳐버리거나 발산

- 손실값이 NaN으로 치솟을 수 있음

증상

- loss curve가 불안정하게 요동침

- 손실이 갑자기 증가하거나 NaN 발생

4. Learning Rate가 너무 작으면?

- 파라미터 업데이트가 너무 작아져서

- 학습 속도가 매우 느려짐

- 최적화가 오래 걸리며 효율이 떨어짐

증상

- loss가 천천히 감소

- 너무 많은 epoch이 필요함

아래 그림 출처 링크

5. 한눈에 정리

| Learning Rate | 발생 가능한 문제 |

|---|---|

| 너무 큼 | 발산, 손실 불안정, NaN 발생 |

| 너무 작음 | 학습 지연, 리소스 낭비 |

| 적절함 | 손실 안정적 감소, 효율적 학습 |

6. 실무 팁

- Learning Rate Scheduler 사용:

학습 초기에 크게 시작해서 점차 줄이는 방식으로 안정적 수렴 유도 - Warm-up 전략:

처음에는 학습률을 천천히 증가시킨 후 본격적인 학습에 들어감 - Adam / AdamW 옵티마이저:

적응형 가중치를 주지만, 여전히 적절한 초기 학습률 설정은 중요합니다

7. 마무리하며

Learning Rate는 작게 설정하면 시간이 오래 걸리고,

크게 설정하면 발산할 수 있는 양날의 검입니다.

적절한 값을 찾는 것이 매우 중요하며,

학습률 스케줄링이나 옵티마이저 선택도 학습 성능에 큰 영향을 미칩니다.