📖 케라스 창시자에게 배우는 딥러닝 (프랑소와 숄레, 박해선, 길벗) 참고

🌈 Forward Propagation

함수형 모델의 학습 원리는 이전 포스팅에서 설명한 Gradient Descent이다. Parameter Update를 하기 위해 각 파라미터들의 편미분값을 구해서 빼는 방식으로 학습을 진행하였다. 하지만 Parameter 개수가 100만개 이상으로 굉장히 많은 경우 수치미분으로 계산하는 것이 가능할까?

이전 포스팅에서도 언급했듯 실제 신경망에서는 파라미터의 개수가 수천 개보다 적은 경우가 거의 없으며 수천만 개의 파라미터를 갖는 경우도 종종 있다. Hidden Layer의 수, Node의 개수 등에 영향을 받아 개수가 증가하는 것이다. Parameter의 수는 Model Capacity에 영향을 준다. 하지만 파라미터의 개수가 증가하면 학습시간에 영향을 줄 것이다.

그렇다면 수치미분을 하지 않고 미분 값을 얻을 수는 없을까?

🌈 BackPropagation

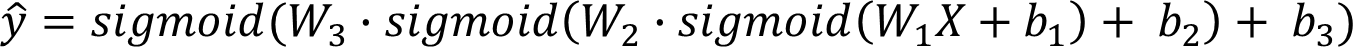

신경망 모델은 위 수식처럼 간단한 함수들의 합성 함수로 볼 수 있다. 즉, 간단한 함수들이 중첩된 형태로 구성되어 있다.

그렇기 때문에 우리는 연쇄 법칙을 적용할 수 있다.

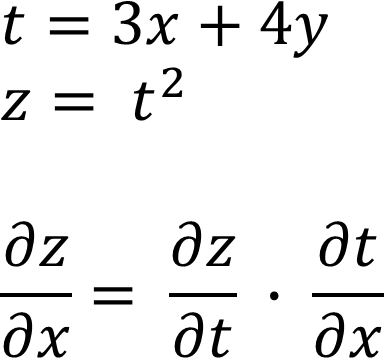

Chain Rule

Chain Rule, 미분의 연쇄 법칙이란 합성 함수의 미분은 합성 함수를 구성하는 개별 함수 미분의 곱으로 나타낼 수 있다는 것을 의미한다.

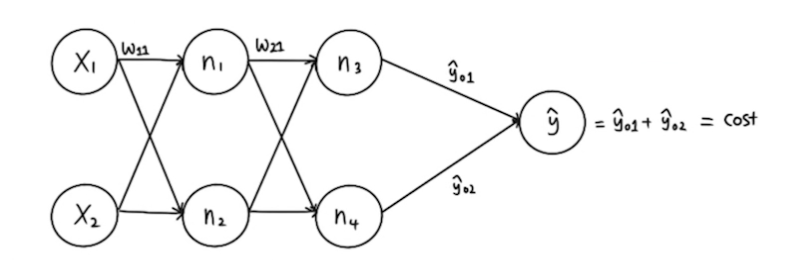

Backpropagation Algorithm

위와 같은 구조의 신경망이 있을 때 우선 왼쪽에서 오른쪽 방향으로(Forward) 연산을 하며 Cost, 오차값을 계산한다.

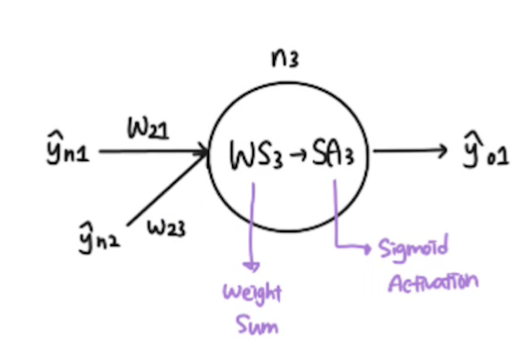

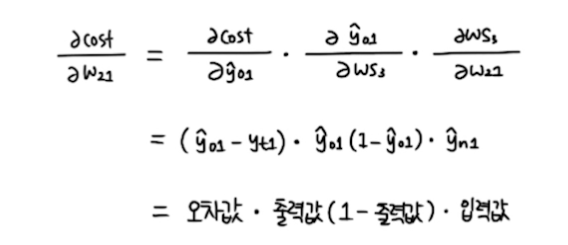

n3 노드를 확대해보면 이런 구조로 나타날 것이다. 우리는 W21을 업데이트했을 때 오차값이 얼마나 감소할지 알고 싶다. 이것을 아래와 같은 수식으로 표현할 수 있다.

이 수식을 연쇄 법칙을 활용하여 풀면 오차값 · 출력값(1-출력값) · 입력값의 형태로 나타낼 수 있다. 즉, 미분 연산을 하지 않고 Forward Propagation 결과만으로 미분 값을 얻을 수 있는 것이다.

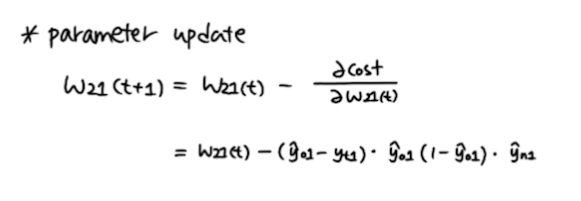

미분을 하지 않고 오차값, 출력값, 입력값을 이용해서 가중치를 위와 같은 식을 통해 업데이트 할 수 있다.

수치 미분을 계산하는 것은 많은 컴퓨팅 자원 및 시간이 소요되기 때문에 이와 같이 미분을 하지 않고 Forward Propagation의 결과를 전달하며 파라미터 업데이트를 하는 방법이 바로 Backpropagation, 역전파 알고리즘이다. 역전파 알고리즘을 통해 우리는 hidden layer나 node의 수가 증가하여도 학습 속도에 영향을 받지 않고 학습할 수 있다.