1. 시그모이드 함수 알아보기

로지스틱 회귀분석은 활성화 함수로 시그모이드 함수를 사용

시그모이드 함수가 만들어지는 과정

오즈 > 로짓 함수 > 시그모이드 함수

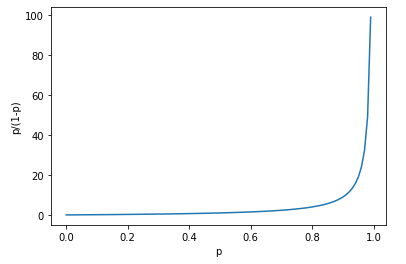

오즈

오즈 = p/(1-p) (오즈비가 아닌 오즈)

probs = np.arange(0, 1, 0.01)

odds = [p/(1-p) for p in probs]

plt.plot(probs, odds)

plt.xlabel('p')

plt.ylabel('p/(1-p)')

plt.show()

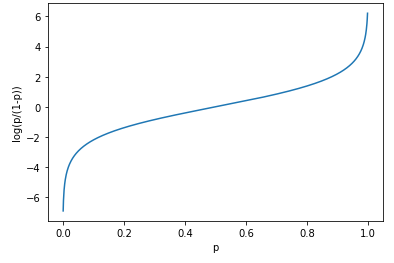

로짓 함수

로짓 함수 = log(p/(1-p))

p가 0.5일때 0이 되고 p가 0과 1일 때 각각 무한대로 음수와 양수가 됨

probs = np.arange(0.001, 0.999, 0.001)

logit = [np.log(p/(1-p)) for p in probs]

plt.plot(probs, logit)

plt.xlabel('p')

plt.ylabel('log(p/(1-p))')

plt.show()

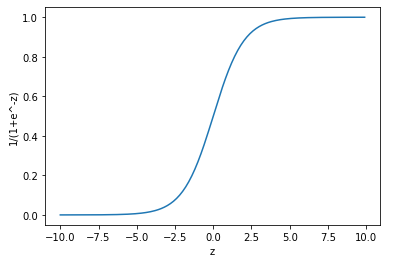

시그모이드 함수

로짓 함수의 가로와 세로 축을 반대로 뒤집어 놓은 모양

zs = np.arange(-10., 10., 0.1)

gs = [1/(1+np.exp(-z)) for z in zs]

plt.plot(zs, gs)

plt.xlabel('z')

plt.ylabel('1/(1+e^-z)')

plt.show()

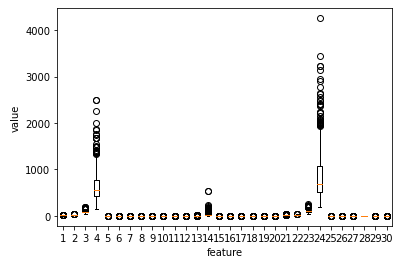

2. 분류용 데이터셋 준비

위스콘신 유방암 데이터 세트

from sklearn.datasets import load_breast_cancer

cancer = load_breast_cancer()눈에 띄는 특성 확인

plt.boxplot(cancer.data)

plt.xlabel('feature')

plt.ylabel('value')

plt.show()

4, 14, 24번째 특성이 도드라짐

cancer.feature_names[[3,13,23]]

x = cancer.data

y = cancer.target3. 로지스틱 회귀모델 뉴런 생성

from sklearn.model_selection import train_test_split

x_train, x_test, y_train, y_test = train_test_split(x, y, stratify=y,

test_size=0.2, random_state=42)

class LogisticNeuron:

def __init__(self):

self.w = None

self.b = None

def forpass(self, x):

z = np.sum(x * self.w) + self.b # 직선 방정식을 계산합니다

return z

def backprop(self, x, err):

w_grad = x * err # 가중치에 대한 그래디언트를 계산합니다

b_grad = 1 * err # 절편에 대한 그래디언트를 계산합니다

return w_grad, b_grad

def activation(self, z):

z = np.clip(z, -100, None) # 안전한 np.exp() 계산을 위해

a = 1 / (1 + np.exp(-z)) # 시그모이드 계산

return a

def fit(self, x, y, epochs=100):

self.w = np.ones(x.shape[1]) # 가중치를 초기화합니다.

self.b = 0 # 절편을 초기화합니다.

for i in range(epochs): # epochs만큼 반복합니다

for x_i, y_i in zip(x, y): # 모든 샘플에 대해 반복합니다

z = self.forpass(x_i) # 정방향 계산

a = self.activation(z) # 활성화 함수 적용

err = -(y_i - a) # 오차 계산

w_grad, b_grad = self.backprop(x_i, err) # 역방향 계산

self.w -= w_grad # 가중치 업데이트

self.b -= b_grad # 절편 업데이트

def predict(self, x):

z = [self.forpass(x_i) for x_i in x] # 정방향 계산

a = self.activation(np.array(z)) # 활성화 함수 적용

return a > 0.5모델 훈련하기

neuron = LogisticNeuron()

neuron.fit(x_train, y_train)모델 정확도 평가

np.mean(neuron.predict(x_test) == y_test)0.8245614035087719

4. 단일층 신경망 생성

class SingleLayer:

def __init__(self):

self.w = None

self.b = None

self.losses = []

def forpass(self, x):

z = np.sum(x * self.w) + self.b # 직선 방정식을 계산합니다

return z

def backprop(self, x, err):

w_grad = x * err # 가중치에 대한 그래디언트를 계산합니다

b_grad = 1 * err # 절편에 대한 그래디언트를 계산합니다

return w_grad, b_grad

def activation(self, z):

z = np.clip(z, -100, None) # 안전한 np.exp() 계산을 위해

a = 1 / (1 + np.exp(-z)) # 시그모이드 계산

return a

def fit(self, x, y, epochs=100):

self.w = np.ones(x.shape[1]) # 가중치를 초기화합니다.

self.b = 0 # 절편을 초기화합니다.

for i in range(epochs): # epochs만큼 반복합니다

loss = 0

# 인덱스를 섞습니다

indexes = np.random.permutation(np.arange(len(x)))

for i in indexes: # 모든 샘플에 대해 반복합니다

z = self.forpass(x[i]) # 정방향 계산

a = self.activation(z) # 활성화 함수 적용

err = -(y[i] - a) # 오차 계산

w_grad, b_grad = self.backprop(x[i], err) # 역방향 계산

self.w -= w_grad # 가중치 업데이트

self.b -= b_grad # 절편 업데이트

# 안전한 로그 계산을 위해 클리핑한 후 손실을 누적합니다

a = np.clip(a, 1e-10, 1-1e-10)

loss += -(y[i]*np.log(a)+(1-y[i])*np.log(1-a))

# 에포크마다 평균 손실을 저장합니다

self.losses.append(loss/len(y))

def predict(self, x):

z = [self.forpass(x_i) for x_i in x] # 정방향 계산

return np.array(z) > 0 # 스텝 함수 적용

def score(self, x, y):

return np.mean(self.predict(x) == y)단일층 신경망 훈련하기

layer = SingleLayer()

layer.fit(x_train, y_train)

layer.score(x_test, y_test)0.9298245614035088

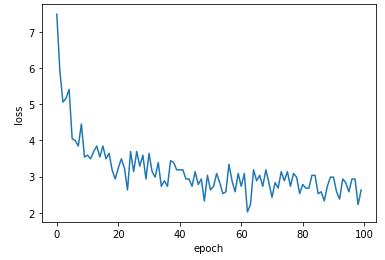

손실 함수 누적값 확인

plt.plot(layer.losses)

plt.xlabel('epoch')

plt.ylabel('loss')

plt.show()

5. 사이킷런 경사하강법

from sklearn.linear_model import SGDClassifier

sgd = SGDClassifier(loss='log', max_iter=100, tol=1e-3, random_state=42)

sgd.fit(x_train, y_train)

sgd.score(x_test, y_test)0.8333333333333334