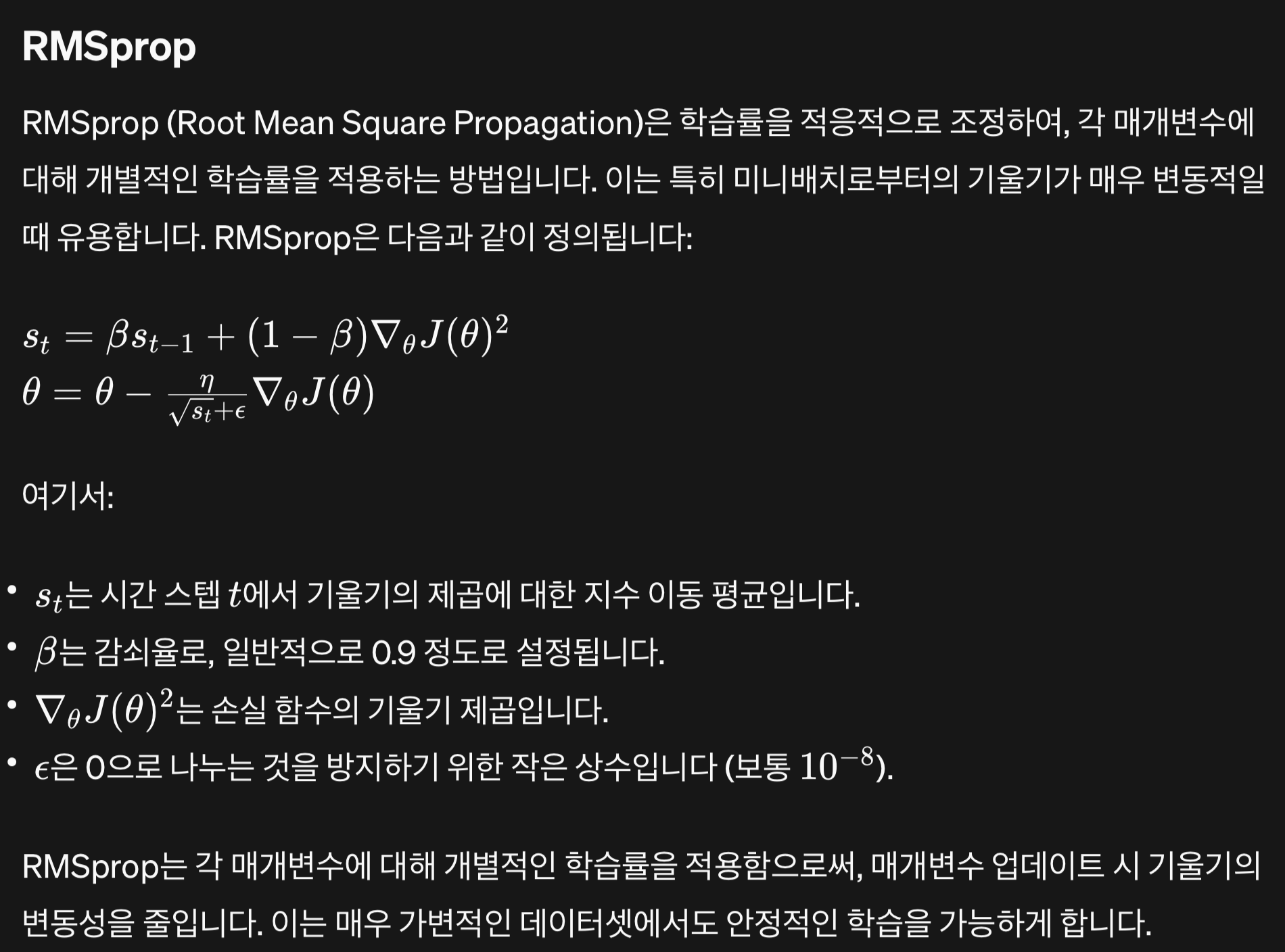

1. RMS Prop

- 기울기가 과하게 커지면, learning rate를 적응적으로 줄이는 방법

- 기울기가 과하게 커지면, 수렴을 못할 수 있음.

- 매개변수에 대해 개별적인 학습률을 적용

- 큰 그래디언트를 가진 매개변수의 학습률은 감소하고, 작은 그래디언트를 가진 매개변수의 학습률은 증가

1.1. 목적

- 더 빠르고 안정적인 수렴을 도모

- 비등방성(각 방향으로의 그래디언트 크기가 상이한 경우) 문제를 해결하는 데 유용

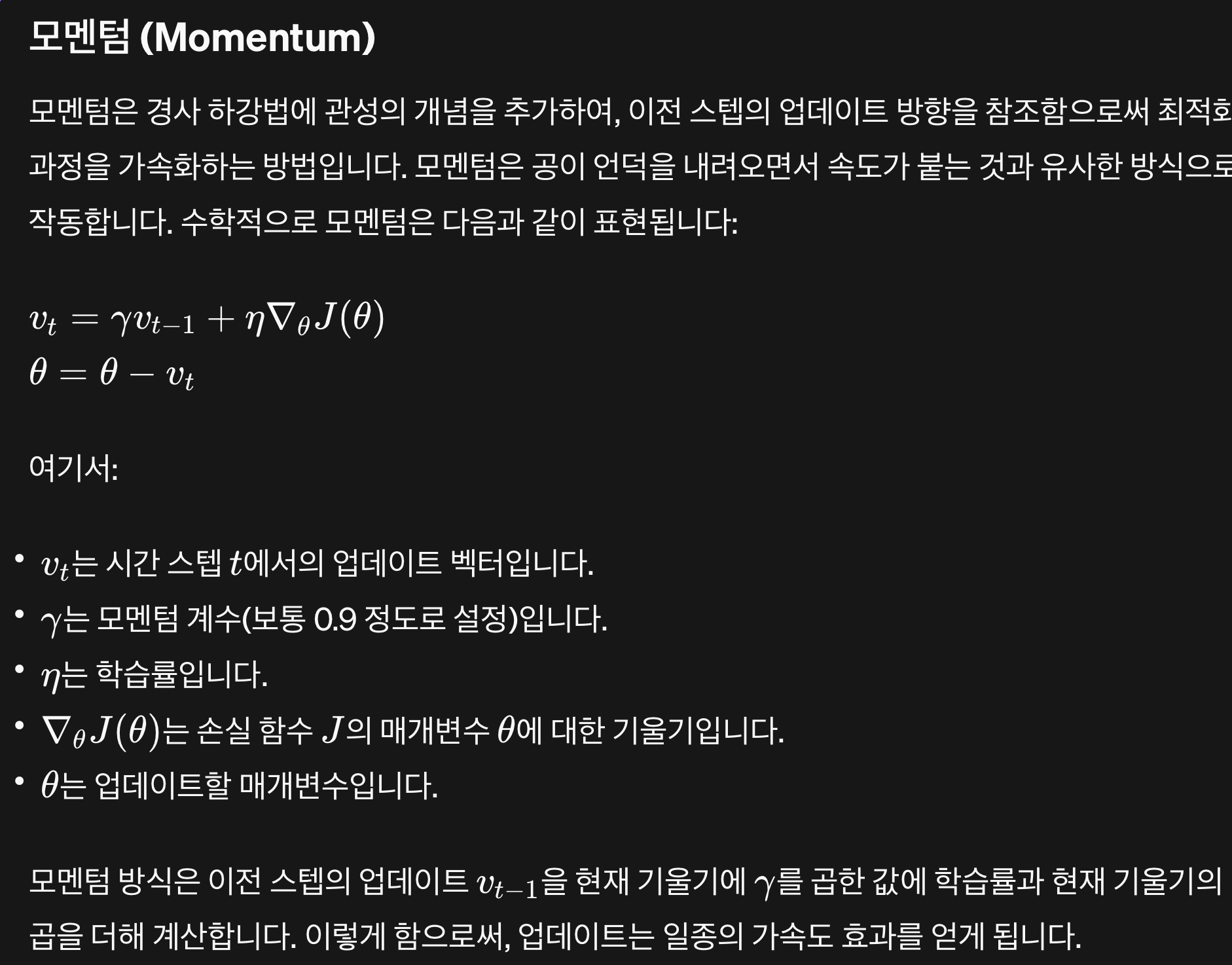

2. Momentum

- 이전 기울기들의 누적 평균을 현재 gradient descent에 반영하는 것.

2.1. 목적

- 학습 과정을 가속화하고, 불필요한 진동을 줄이며,

- 지역 최소값(local minima)에 빠지는 것을 방지하는 데 도움

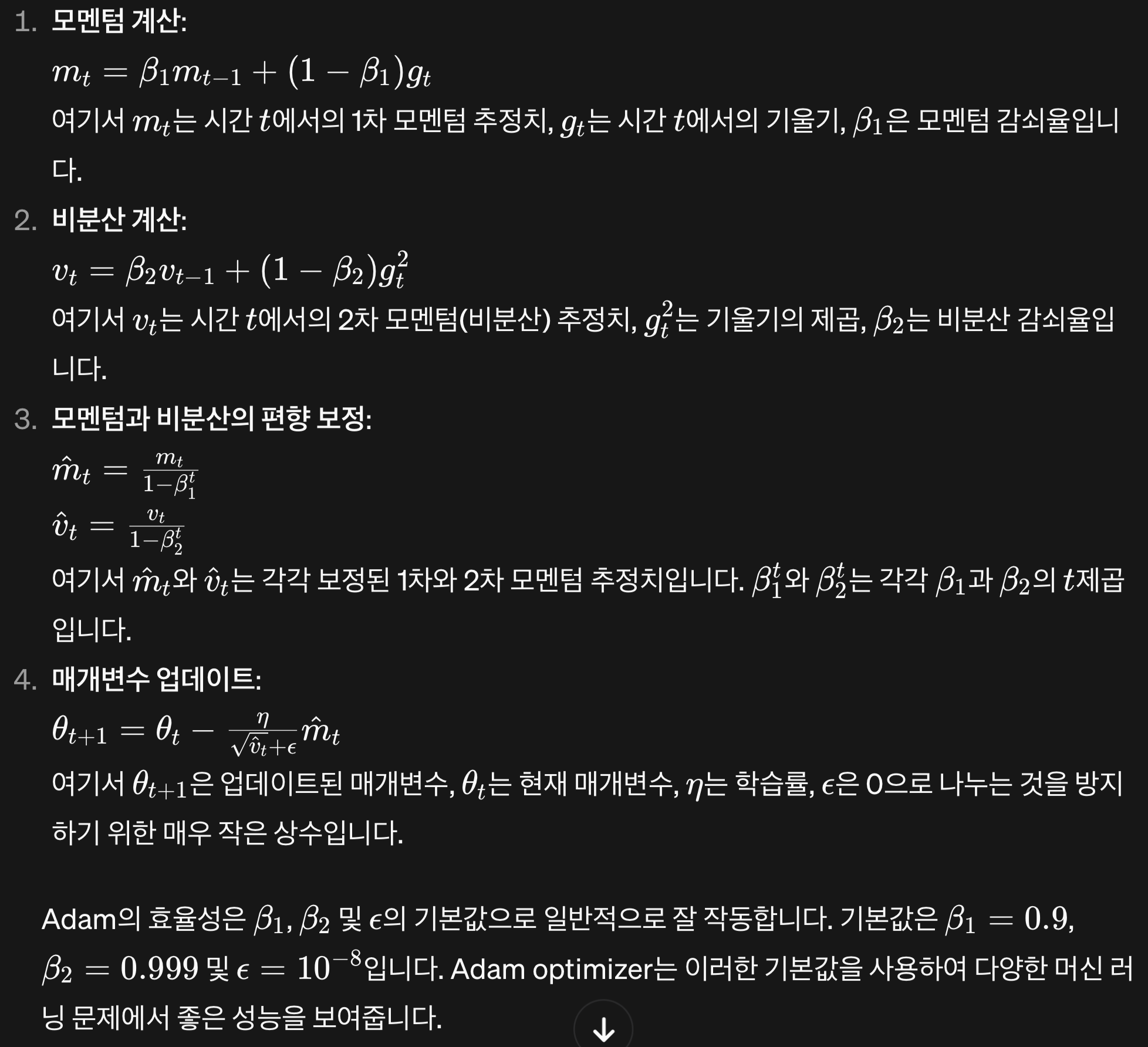

3. Adam Optimizer

- Adam optimizer는 모멘텀(momentum)과 RMSprop의 개념을 결합하여, 1차 모멘텀(평균)과 2차 모멘텀(비분산)의 추정치를 모두 사용합니다.

- Adam optimizer의 업데이트 규칙은 다음과 같습니다:

3.1. 목적

- 위 2가지 기법의 목적을 합친 것