1. Sharpness-Aware Minimization (SAM):

- SAM은 모델의 일반화 능력을 향상시키기 위한 최적화 기법

- 전통적인 훈련 방식은 데이터에 대한 모델의 예측 오차(손실)를 최소화하는 것에 중점을 둠

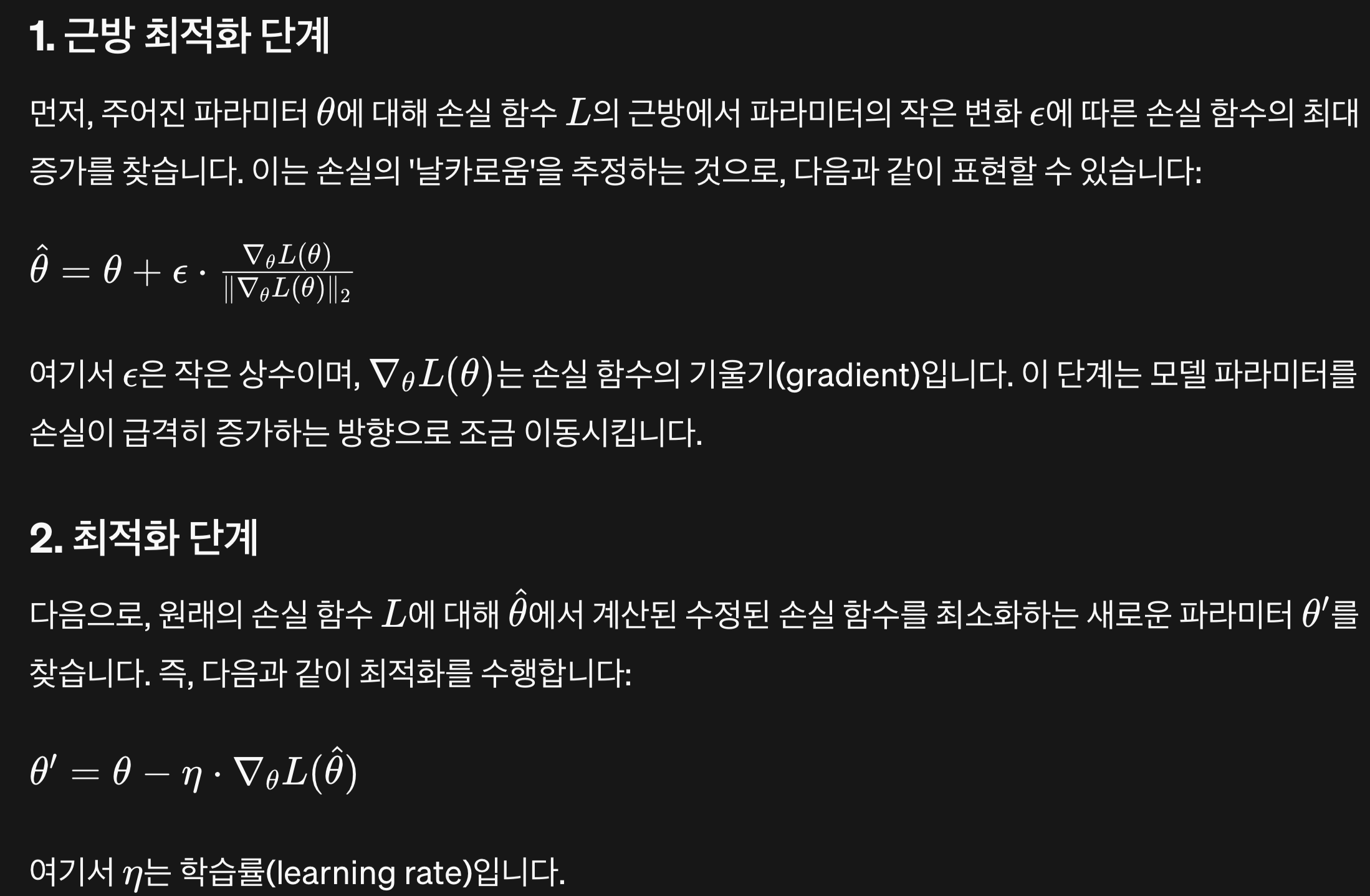

- 그러나 SAM은 손실 함수의 '날카로움'도 고려합니다.

- 손실 함수의 날카로운 최소값은 훈련 데이터에는 잘 맞지만 새로운 데이터에는 잘 작동하지 않을 수 있습니다.

- SAM은 이러한 날카로운 최소값을 피하고, 더 평평한 최소값을 찾아 모델이 새로운 데이터에도 잘 작동하도록 돕습니다.

- 근방 최적화 단계

- 깊은 골짜기에서 최대한 빠르게 빠져나올 수 있는 방향으로 빠져나오는 단계

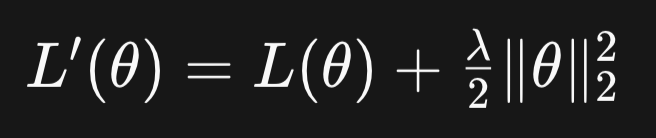

2. 가중치 감소 (Weight Decay):

- 학습 파라미터(weights)의 크기를 제한하여 과적합(overfitting)을 방지하는 방법

- 과적합은 모델이 훈련 데이터에는 매우 잘 맞지만 새로운 데이터에는 잘 작동하지 않는 상황을 의미합니다.

- 가중치 감소는 모델의 가중치가 너무 크게 변하지 않도록 제한하여, 모델이 훈련 데이터의 노이즈에 덜 민감하게 만듭니다.