0. 들어가기 전에

0.1. 논문 정보

- https://arxiv.org/pdf/2303.13874

- 90회 인용

- https://github.com/wjun0830/QD-DETR?tab=readme-ov-file

- 207 star

0.2. 읽어봄직한 글

- QD-DETR의 입출력 shape: https://velog.io/@hsbc/QD-DETR-입출력

- QD-DETR 코드 돌리기: https://velog.io/@hsbc/QD-DETR-코드-돌리기

텍스트 기반 쿼리 의존적 비디오 표현을 위한 QD-DETR 소개

- 모먼트 검색(Moment Retrieval)

영상 내에서 특정 텍스트 쿼리에 해당하는 순간을 찾아내는 작업- 주어진 텍스트 설명에 해당하는 영상을 로컬라이즈하는 작업

- 예:

- "축구 영상" + text: "goal이 들어간 장면"

- 결과: 3분 3초 ~3분 10초 / 24분 5초 ~ 24분 12초

- 하이라이트 검출(Highlight Detection)

각 비디오 클립이 주어진 쿼리에 얼마나 부합하는지를 점수로 나타내는 작업- 주어진 비디오의 각 클립의 중요도 수준을 측정하는 작업

- 예

- "축구 영상" + text: "goal이 들어간 장면"

- 결과: clip 1 -> 1점 , clip 2 -> 0.8점, ... , clip N -> 0.1점

- 여기서 clip은 전체 비디오를 n초 단위로 자른 개념을 의미

- 하지만 기존의 Transformer 기반 모델들은

텍스트 쿼리의 정보를 충분히 활용하지 못하는 한계- 예를 들어, 비디오 내용과 텍스트 쿼리 간의 연관성을 무시하고 순간이나 하이라이트를 예측하는 경우가 발생

- 이에 대한 해결책으로, 우리는 Moment Retrieval과 Highlight Detection에 특화된 쿼리 의존적 DETR(Query-Dependent DETR, QD-DETR)를 제안

잠깐! Saliency가 뭐야? (중요도)

- 좀 더 자세히 설명하자면:

- 살리에인시 점수는 비디오 내의 각 클립이 텍스트 쿼리와의 관련성을 수치화한 것

- 이 점수는 해당 클립이

쿼리에서 묘사하는 내용이나 행동, 사건등을 얼마나 잘 포함하고 있는지를 반영 - 높은 살리에인시 점수를 가진 클립은 쿼리와 매우 밀접하게 연관되어 있으며, 낮은 점수는 연관성이 적거나 없음을 의미

- 예시

- 텍스트 쿼리: "사람들이 불꽃놀이를 감상하는 장면"

- 비디오 클립들:

- 클립 A: 사람들이 밤하늘을 바라보는 장면 (살리에인시 점수 높음)

- 클립 B: 낮에 사람들이 공원을 걷는 장면 (살리에인시 점수 낮음)

- 클립 C: 불꽃놀이가 하늘에서 터지는 장면 (살리에인시 점수 매우 높음)

- 이처럼 살리에인시 점수는 각 클립이 쿼리와 얼마나 관련성이 있는지를 나타내며,

- 이를 통해 모델은 비디오 내에서 쿼리에 해당하는 중요한 순간이나 하이라이트를 찾아낼 수 있습니다.

1. 서론

모먼트 검색과 하이라이트 검출의 필요성

- 영상 내에서 사용자가 요청한 순간을 검색하는 연구 [1, 12, 13, 30]와 영상의 하이라이트를 요약하는 연구 [4, 33, 47, 57]가 활발히 진행 중

- 최근에는 Moment-DETR [23]이 제안되면서, 두 가지 작업을 동시에 수행할 수 있는 QVHighlights 데이터셋이 등장

2. 관련 연구

2.1 모먼트 검색(Moment Retrieval)과 하이라이트 검출(Highlight Detection)

- 작업이 종종 비디오만으로 구현되지만, 추가적인 데이터 모달리티를 활용하는 연구도 있습니다.

- 일반적으로, 멀티모달리티는 자연어 쿼리를 사용하여 원하는 썸네일을 찾거나 [30],

- 오디오와 같은 추가 소스를 활용하여 하이라이트를 예측하는 방식 [3, 53]

- 모먼트 검색과 하이라이트 검출 작업을 한 번에 처리하기 위해, Moment-DETR [23]은 QVHighlights 데이터셋을 제안하였는데,

- 이 데이터셋은 사람이 작성한 텍스트 쿼리와 그에 상응하는 모먼트 및 클립 수준의 살리에인시 레이블을 포함

3. 제안하는 접근법: 쿼리 의존적 DETR(QD-DETR)

중요 특징

특징 1 (위 그림의 빨간색 박스 부분)

- 쿼리의 맥락 정보를 완전히 활용하기 위해, 우리는 Transformer 인코더를 수정하여 초기 레이어에 크로스 어텐션 레이어를 장착

- 이때 비디오를 쿼리(Query)로, 텍스트를 키(Key)와 밸류(Value)로 사용하는 크로스 어텐션 레이어를 삽입함으로써,

- 인코더에서 비디오 표현을 추출할 때 텍스트 쿼리의 참여를 보장

- 이때 비디오를 쿼리(Query)로, 텍스트를 키(Key)와 밸류(Value)로 사용하는 크로스 어텐션 레이어를 삽입함으로써,

- 텍스트 쿼리의 정보를 더욱 적극적으로 활용하기 위해, 우리는 부정적(무관한) 비디오-쿼리 쌍을 생성합니다.

- 원래의 비디오-쿼리 쌍을 섞어서 무관한 쌍을 만듭니다.

- 예를 들어, 비디오 A와 쿼리 B를 조합하여 부정적 쌍을 생성

- 이러한 부정적 쌍에 대해 모델이 낮은 살리에인시 점수를 예측하도록 학습시킴

- 원래의 비디오-쿼리 쌍을 섞어서 무관한 쌍을 만듭니다.

특징 2

- 학습 데이터셋은 (비디오-연관 query text)조합으로 되어 있습니다.

- 이 데이터셋의 단점은, query가 전부 비디오와 연관된 Text라는 점입니다.

- 이게 왜 문제가 되나면, 학습된 모델을 사용자가 사용할 때, 사용자가 준 특정 query들은 해당 비디오에서 전혀 찾을 수 없는 경우들도 많을텐데

- 이 과정이 학습된 적이 없기 때문입니다.

- 이를 극복하기 위해, 비디오-쿼리 쌍을 조작하여 무관한(부정적) 쌍을 만들어냅니다.

- 이러한 부정적 쌍에 대해 낮은 점수를 예측하도록 모델을 학습시킴으로써,

쿼리-비디오 간의 정확한 일치도를 추정하도록 합니다.

- 이러한 부정적 쌍에 대해 낮은 점수를 예측하도록 모델을 학습시킴으로써,

- 이는, 부정적 쌍에 대해 낮은 살리에인시 점수를 예측하도록 모델을 학습시킴

- 부정적 쌍 학습은, 쿼리를 고려하지 않고 문제를 해결하는 것을 방지

특징 3: (위 그림의 초록색 박스 부분)

- 마지막으로, 입력에 따라 적응적으로 동작하는 살리에인시(중요도) 예측기(Saliency Predictor)를 도입하여,

- 각 비디오-쿼리 쌍에 대한

살리에인시(중요도) 점수의 기준을 유연하게 정의

- 각 비디오-쿼리 쌍에 대한

- 살리에인시 토큰을 사용하여 전체 비디오를 대표하도록 함

- 이 토큰은 비디오와 쿼리의 정보를 모두 반영하며, 각 인스턴스마다 살리에인시 점수의 기준을 유연하게 정의

- 이를 통해 다양한 비디오-쿼리 쌍에 대해 다양한 살리에인시 표현을 유지할 수 있음

Decoder and Objectives

Transformer Decoder

- 디코더의 인풋으로 Moment queries를 주는데, 이 친구들은 (N_q, 2) shape 입니다.

- N_q는 clip candidate의 개수입니다. (우리가 설정하는 Hyperparameter)

- (2,) 차원 = (하이라이트 순간의 중심 시각, 지속 길이)

- 이전 이미지 도메인에서의 방식과 유사하게,

하이라이트 순간의 중심 시각을 이용해서 중심 좌표 주변의 특징들을 풀링하고,- 순간 지속시간(moment duration)을 이용해서 cross attention map 맵을 조정

- 그런 다음, (하이라이트 순간의 중심 시각, 지속 길이)은 계층적으로(layer-wise) 수정됩니다.

Objectives Function

- 위 그림에 전부 Loss function이 소개되어 있다.

- 다만,

Rank Aware Contrastive Loss에 대한 설명이 빠져 있어, 여기서 설명하고자 한다.- Contrastive Learning? : https://velog.io/@hsbc/Contrastive-Learning

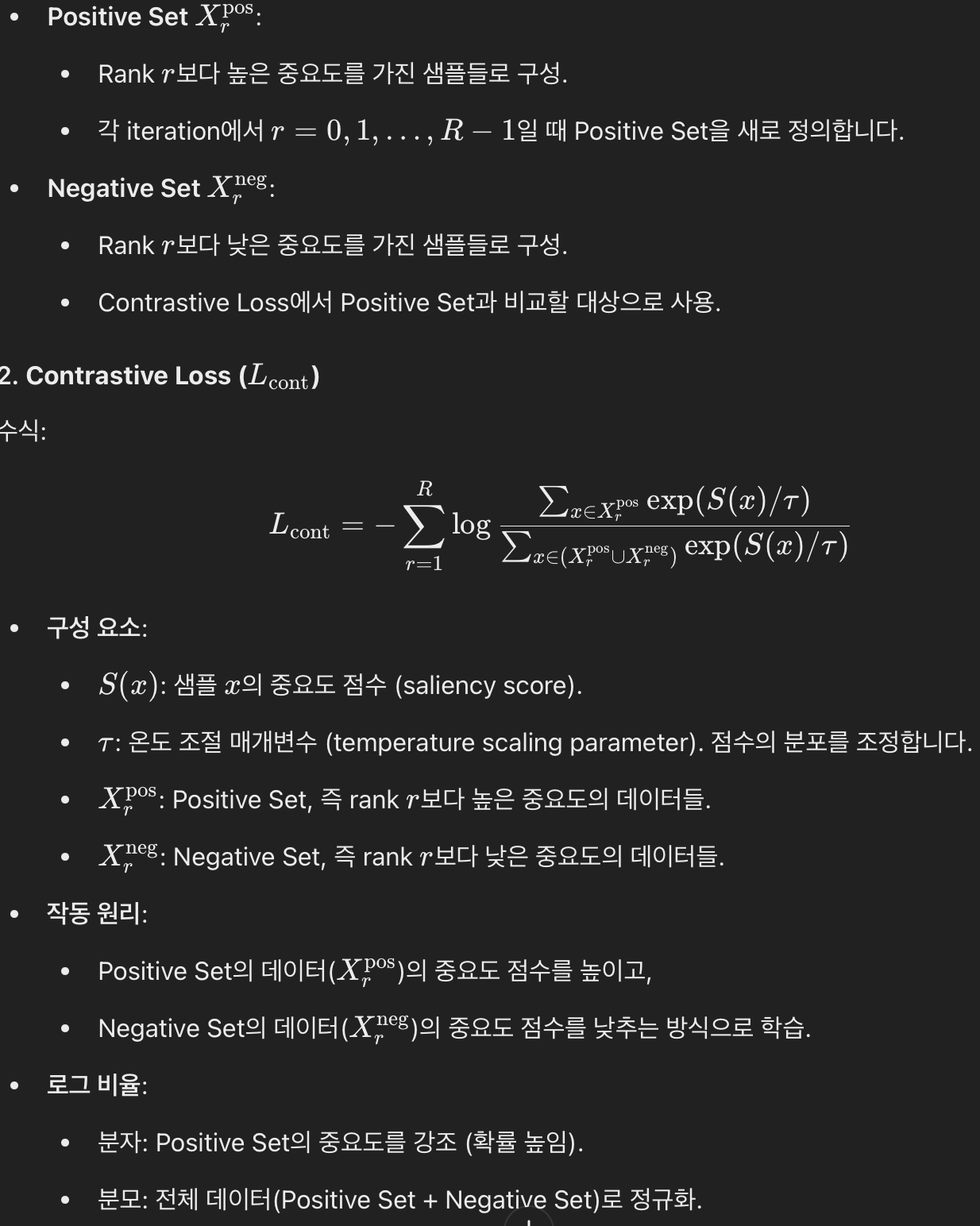

Rank Aware Contrastive Loss

- 학습시, mini-batch 단위로 학습을 할 것이다. 즉, B개의 비디오를 input으로 해서 (B,L) shape의 clip을 input으로 가져간다.

- 이 mini-batch에서, 가장 중요도 GT가 높은 값을 찾아서 R이라고 칭한다.

- 이제 r = 0 ... R-1 로 순회하면서

- 일반 Contrastive Loss는 모든 데이터를 동일하게 처리하지만, Rank-Aware 방식은 데이터의 중요도를 단계적으로 반영합니다.

- 이로 인해 모델이 더 정밀한 중요도 예측을 학습할 수 있습니다.

4. 실험

4.1 데이터셋 및 설정

- 우리는 제안하는 QD-DETR의 성능을 검증하기 위해 다음과 같은 데이터셋을 사용

- QVHighlights:

- 모먼트 검색과 하이라이트 검출을 모두 포함하는 데이터셋으로, 사람이 작성한 텍스트 쿼리와 그에 대응하는 순간 및 클립 수준의 살리에인시 레이블을 포함

- TVSum:

- 영상 요약을 위한 데이터셋으로, 각 클립의 중요도 점수가 제공

- Charades-STA:

- 행동 인식을 위한 데이터셋으로, 텍스트 쿼리와 그에 해당하는 순간이 주어짐

5. 한계점 및 결론

5.1 한계점

- 우리가 제안한 구성 요소들은 의미 있는 맥락을 가진 쿼리가 주어질 것을 기대

- 만약 그렇지 않고, 노이즈가 섞인 텍스트 쿼리(예: 잘못 매칭되거나 무관한 텍스트)가 제공된다면, 학습이 효과적이지 않을 수 있습니다.

Rank Aware Contrastive Loss

Rank-Aware Contrastive Loss에 대한 상세 설명

- GPT에서 찾아보기

https://spcfactory.blogspot.com

https://bothbestbamboo.blogspot.com

https://hssolar.blogspot.com

https://blog.libero.it/wp/bothbestbamboo

https://qualityherb.livepositively.com

https://www.hentai-foundry.com/user/bothbest/blogs/

https://www.hentai-foundry.com/user/chinabamboo/blogs/

https://zybuluo.com/bothbest/note/2623191

https://squidwardcc.org/forum/viewtopic.php?t=19219

https://www.chambers.com.au/forum/view_post.php?frm=3&pstid=108110

https://qualityherb.livepositively.com/distressed-and-hand-scraped-bamboo-flooring/

https://spcfactory.blogspot.com/2025/09/strand-woven-vs-horizontal-vs-vertical.html

https://bothbestbamboo.blogspot.com/2025/09/carbonized-bamboo-flooring-natural.html

https://blog.libero.it/wp/bothbestbamboo/2025/09/11/not-all-bamboo-flooring-is-the-same-brands-grades-and-durability/

https://www.hentai-foundry.com/user/chinabamboo/blogs/20395/Solid-Strand-Woven-Bamboo-Flooring-A-Grey-Stain-Perspective

https://arizonaadam.com/forum/topic/how-long-does-bamboo-flooring-last-maintenance-and-manufacturing-tips-that-matter/