Multi task에서 해결해야할 2가지를

- 모델을 본질적,점진적으로 만들고 이전에 학습 한 task를 잊지 않고 새로운 task의 정보를 지속적으로 통합 할 수 있어야 한다.

- Multi-task 설정에서 Single-task 성능을 현저히 저하시키는 것으로 나타 났던 task 간의 불리한 상호 작용을 제거해야 한다.

설명

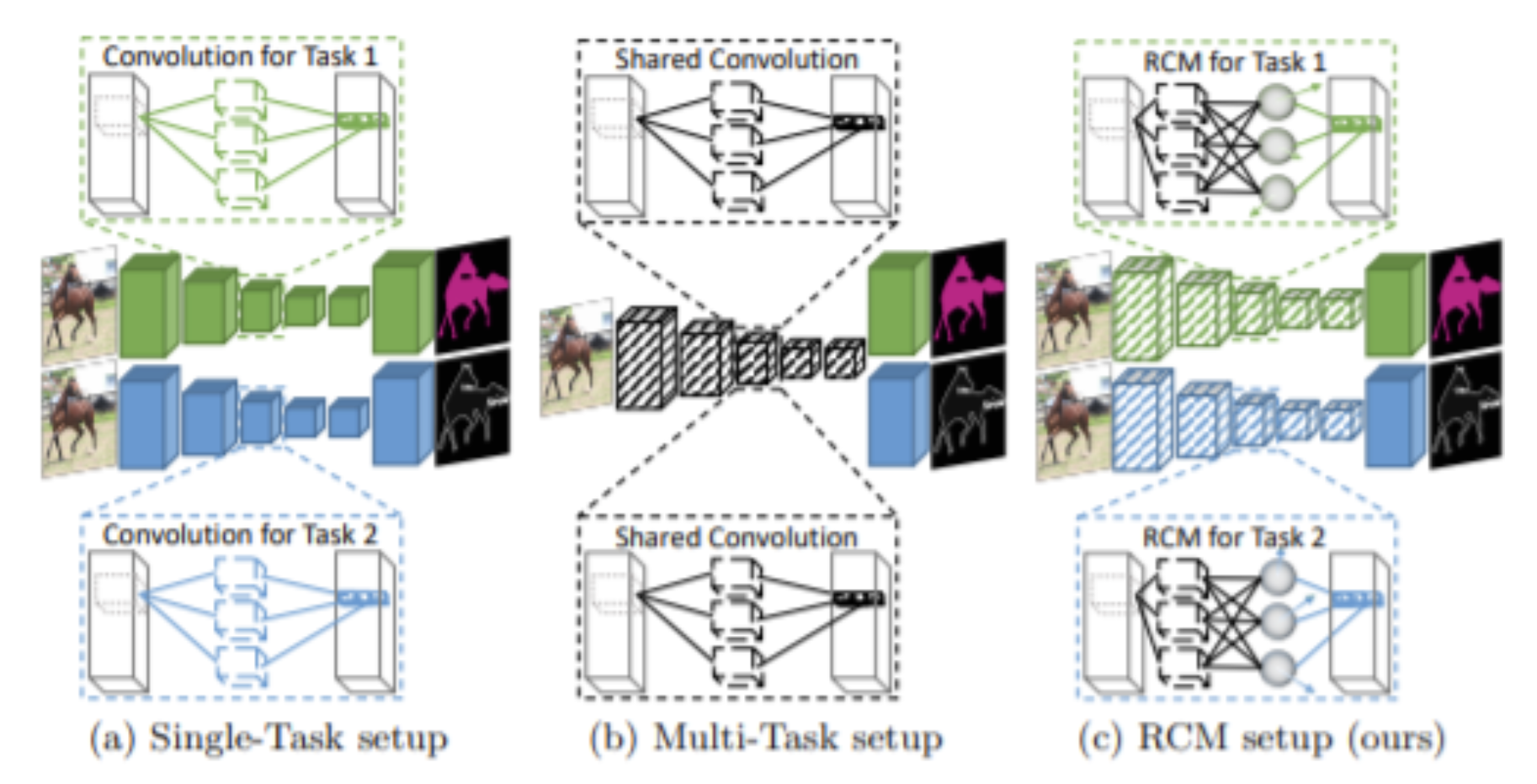

- 위의 그림1은 각각 single-task, multi-task, reparameterized convolutions for multi-task set up을 나타낸다.

- Single task는 각 task 마다 독립적이게 parameter들이 있다. 여기서 녹색과 파란색은 task specific 한 parameter를 뜻한다.

- Multi task는 모든 task가 검은색의 같은 backbone을 공유하고 이를 이용하고 있다.

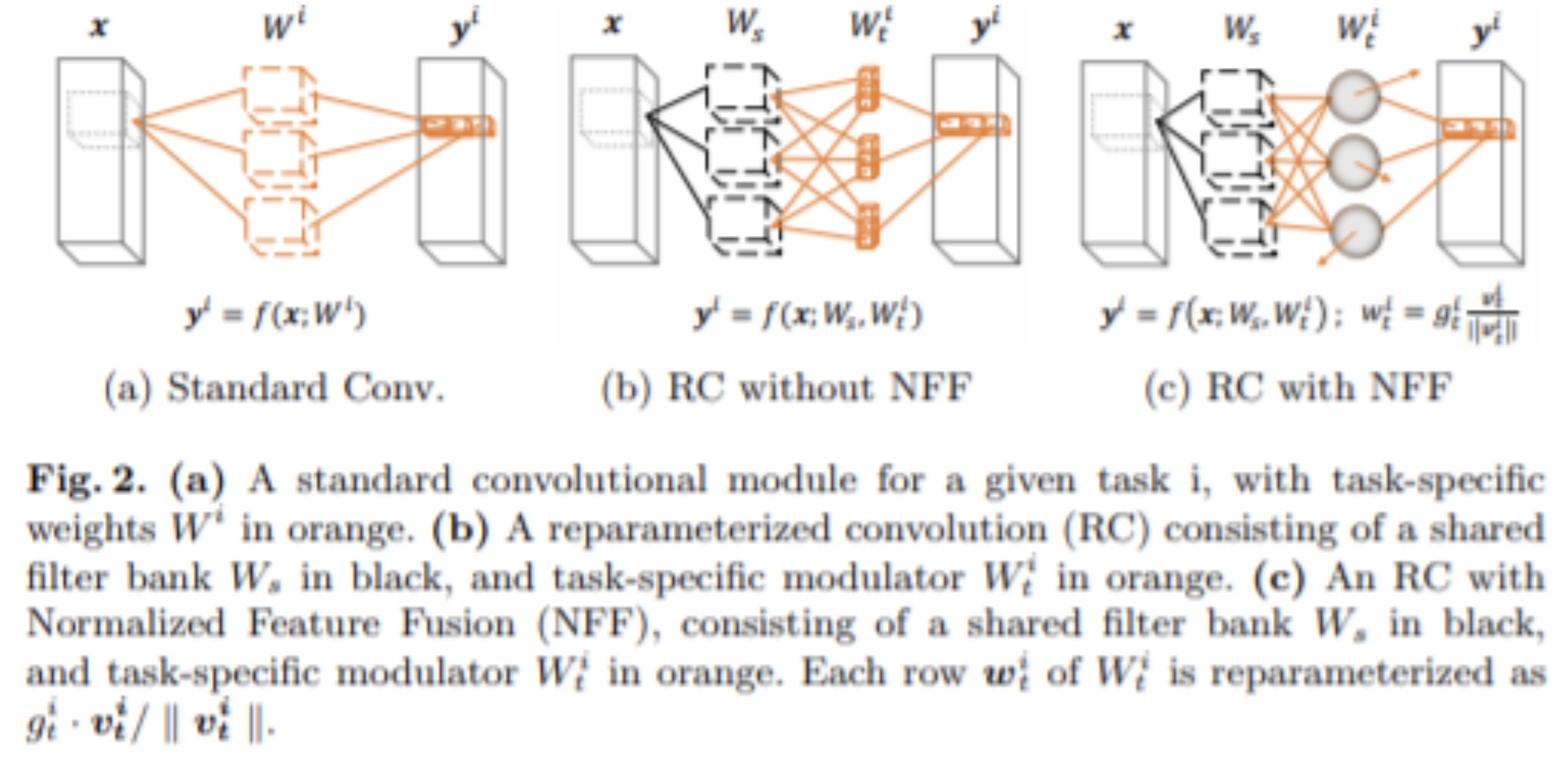

- 마지막 RCM은 pre-train 되어있는 공통된 검은색 filter bank를 사용하고, 독립적,각 task 별로 최적화 되어있는 modulator가 있으며, 이것이 각 task 별로 filter bank를 조정한다.

장점

- inference 시 성능을 향상시켜줌

단점

- 학습이 오래 걸림

- training memory가 더 많이 쓰임

- model quantization을 했을 때, error gap이 증가해서, 아래의 기법을 써줘야 함

- re-parameterizing optimizer

- quantization-aware training