- "normalization 효과"는 딥러닝 모델의 과적합(overfitting)을 방지하거나 완화

- 학습 데이터에서의 성능과, inference시 다른 데이터에서의 성능 차이가 적게 하기 위함. (generalization 성능 업)

- 물체 인식 분야에서는 대부분의 경우 Batch Normalization이 효과적입니다.

- 그러나 배치 크기가 작거나 RNN과 같은 특정 아키텍처를 사용할 때는 다른 정규화 방법을 고려해 볼 필요가 있습니다.

-

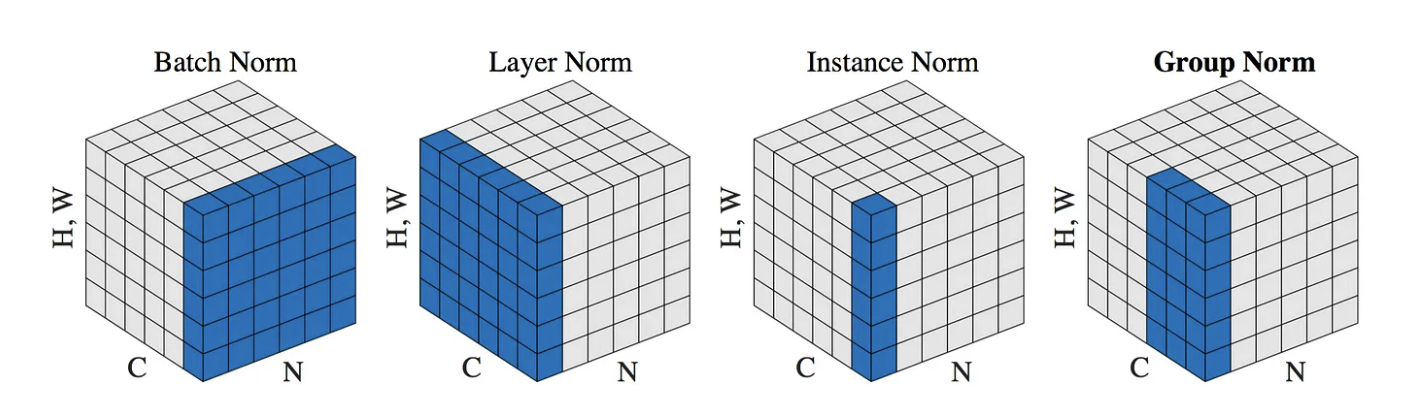

Batch Normalization (Batch Norm):

- 장점:

- 학습 속도를 개선합니다.

- 초기 가중치 선택에 덜 민감합니다.

- 어느 정도 정규화 효과를 제공하여 드롭아웃과 같은 다른 정규화 기법의 필요성을 줄입니다.

- 단점:

- 배치 크기에 의존적입니다. 작은 배치에서는 잘 동작하지 않을 수 있습니다.

- RNN에는 직접 적용하기 어렵습니다.

- 추론 시간에서 별도의 계산(평균 및 분산의 이동 평균)이 필요합니다.

- 장점:

-

Layer Normalization (Layer Norm):

- 장점:

- 배치 크기에 독립적입니다.

- RNN과 같은 반복적인 네트워크 구조에 적합합니다.

- 단점:

- 특정 데이터 분포에서는 Batch Norm보다 성능이 떨어질 수 있습니다.

- 장점:

-

Instance Normalization (Instance Norm):

- 장점:

- 스타일 전송과 같은 이미지 생성 작업에서 뛰어난 성능을 보입니다.

- 각 데이터 인스턴스를 개별적으로 정규화합니다.

- 단점:

- 물체 인식과 같은 일반적인 태스크에는 최적화되어 있지 않습니다.

- 장점:

-

Group Normalization (Group Norm):

- 장점:

- 배치 크기에 독립적입니다.

- 매우 작은 배치에서도 잘 동작하며, Batch Norm와 유사한 성능을 보입니다.

- 채널을 여러 그룹으로 나누어 각 그룹을 독립적으로 정규화합니다.

- 단점:

- 적절한 그룹 수를 선택하는 것이 중요하며, 이는 추가적인 튜닝을 필요로 합니다.

- 장점: