신경망 학습(3)

학습 알고리즘 핵심 요약

신경망에는 적응 가능한 가중치와 편향이 있고, 이 가중치와 편향을 훈련 데이터에 적응하도록 조정하는 과정을 '학습'이라 한다.

학습은 다음과 같이 4단계로 수행한다.

-

mini batch

훈련 데이터 중 일부를 무작위로 가져온다.

이렇게 선별한 데이터를 mini-batch라 하며,

mini-batch의 Loss Function값을 줄이는 것이 목표이다. -

Gradient 산출

mini-batch의 Loss Function값을 줄이기 위해

각 가중치 매개변수의 Gradient를 구한다.

Gradient는 Loss Function값을 가장 작게 하는 방향을 제시한다. -

Parameter 갱신

가중치 매개변수를 Gradient 방향으로 아주 조금 갱신한다 -

1~3 반복

➡️ 이것이 신경망 학습이 이루어지는 순서이다.

경사 하강법으로 매개변수를 갱신하는 방법이며, 데이터를 mini-batch로 무작위 선정하기 때문에 확률적 경사 하강법(Stochastic Gradient Descent)이라고 부른다.

대부분의 딥러닝 FrameWork에서는 SGD 함수로 이 기능을 구현하고 있다.

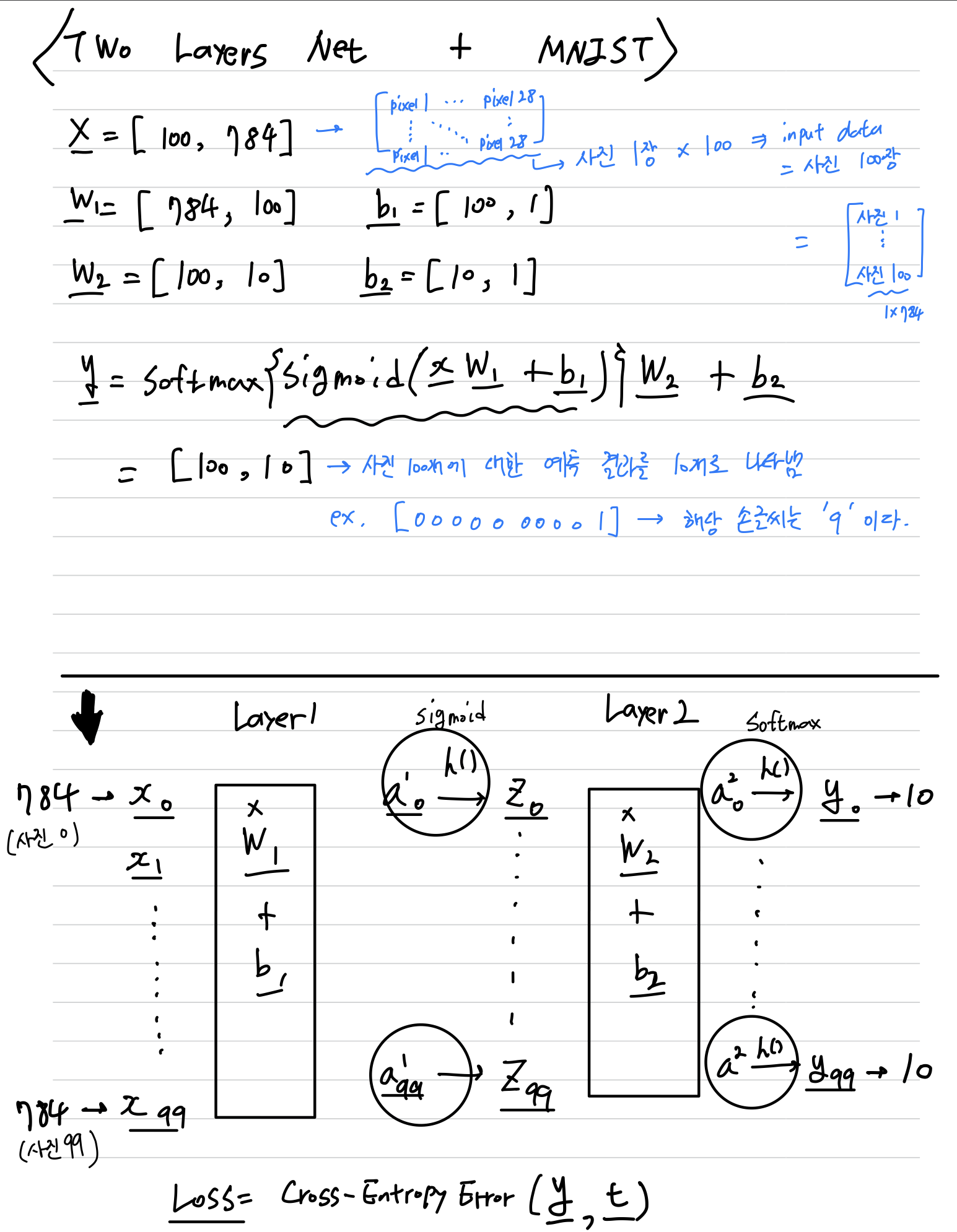

2 Layer Net 구현하기

- 2층 신경망을 대상으로 MNIST 데이터셋을 사용하여 학습을 수행