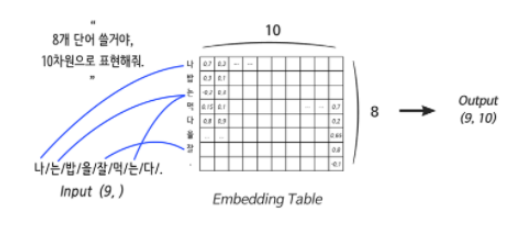

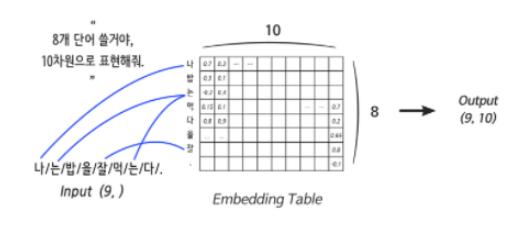

Embedding 레이어

단어를 컴퓨터가 알아볼 수 있도록 바꿔줍니다!

Embedding 레이어는 입력으로 들어온 단어를 분산 표현으로 연결해 주는 역할을 하는데 그것이 Weight에서 특정 행을 읽어오는 것과 같아 이 레이어를 룩업 테이블(Lookup Table) 이라고 부르기도 합니다.

import tensorflow as tf

vocab = { # 사용할 단어 사전 정의

"i": 0,

"need": 1,

"some": 2,

"more": 3,

"coffee": 4,

"cake": 5,

"cat": 6,

"dog": 7

}

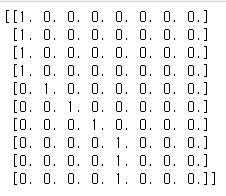

sentence = "i i i i need some more coffee coffee coffee"

# 위 sentence

_input = [vocab[w] for w in sentence.split()] # [0, 0, 0, 0, 1, 2, 3, 4, 4, 4]

vocab_size = len(vocab) # 8

one_hot = tf.one_hot(_input, vocab_size)

print(one_hot.numpy()) # 원-핫 인코딩 벡터를 출력해 봅시다.

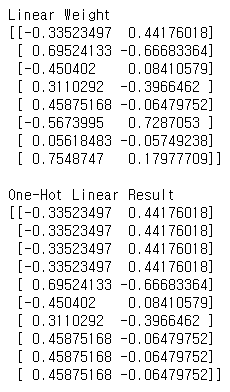

생성된 원-핫 벡터를 Linear 레이어에 넣어보겠습니다.

distribution_size = 2 # 보기 좋게 2차원으로 분산 표현하도록 하죠!

linear = tf.keras.layers.Dense(units=distribution_size, use_bias=False)

one_hot_linear = linear(one_hot)

print("Linear Weight")

print(linear.weights[0].numpy())

print("\nOne-Hot Linear Result")

print(one_hot_linear.numpy())

Tensorflow에서 Embedding 레이어를 선언하는 방법입니다.

some_words = tf.constant([[3, 57, 35]])

# 3번 단어 / 57번 단어 / 35번 단어로 이루어진 한 문장입니다.

print("Embedding을 진행할 문장:", some_words.shape)

embedding_layer = tf.keras.layers.Embedding(input_dim=64, output_dim=100)

# 총 64개의 단어를 포함한 Embedding 레이어를 선언할 것이고,

# 각 단어는 100차원으로 분산표현 할 것입니다.

print("Embedding된 문장:", embedding_layer(some_words).shape)

print("Embedding Layer의 Weight 형태:", embedding_layer.weights[0].shape)Embedding을 진행할 문장: (1, 3)

Embedding된 문장: (1, 3, 100)

Embedding Layer의 Weight 형태: (64, 100)

Embedding 레이어는 단어를 대응 시켜 줄 뿐이니 미분이 불가능합니다. 따라서 신경망 설계를 할 때, 어떤 연산 결과를 Embedding 레이어에 연결시키는 것은 불가능합니다

Recurrent 레이어

Recurrent 레이어는 시퀀스 데이터를 처리하는데 강력합니다.

- 단어 하나의 weight를 순차적으로 업데이트 합니다.

RNN의 문제점은 있습니다. 처음 단어가 학습을 하며 진행할 수록 기여도?가 점점 작아집니다. 기울기 손실이라고 하는데요 일단 RNN을 보겠습니다.

sentence = "What time is it ?"

dic = {

"is": 0,

"it": 1,

"What": 2,

"time": 3,

"?": 4

}

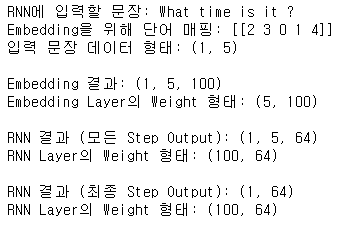

print("RNN에 입력할 문장:", sentence)

sentence_tensor = tf.constant([[dic[word] for word in sentence.split()]])

print("Embedding을 위해 단어 매핑:", sentence_tensor.numpy())

print("입력 문장 데이터 형태:", sentence_tensor.shape)

embedding_layer = tf.keras.layers.Embedding(input_dim=len(dic), output_dim=100)

emb_out = embedding_layer(sentence_tensor)

print("\nEmbedding 결과:", emb_out.shape)

print("Embedding Layer의 Weight 형태:", embedding_layer.weights[0].shape)

rnn_seq_layer = \

tf.keras.layers.SimpleRNN(units=64, return_sequences=True, use_bias=False)

rnn_seq_out = rnn_seq_layer(emb_out)

print("\nRNN 결과 (모든 Step Output):", rnn_seq_out.shape)

print("RNN Layer의 Weight 형태:", rnn_seq_layer.weights[0].shape)

rnn_fin_layer = tf.keras.layers.SimpleRNN(units=64, use_bias=False)

rnn_fin_out = rnn_fin_layer(emb_out)

print("\nRNN 결과 (최종 Step Output):", rnn_fin_out.shape)

print("RNN Layer의 Weight 형태:", rnn_fin_layer.weights[0].shape)

어떤 문장이 긍정, 부정인지 나누기 위해선 문장을 모두 학습하고 최종 step에 output만 확인하면 판단이 됩니다. 하지만 문장을 생성하려면 이전단어를 받아 다음단어를 바로 output을 해야합니다.

lstm_seq_layer = tf.keras.layers.LSTM(units=64, return_sequences=True, use_bias=False)

lstm_seq_out = lstm_seq_layer(emb_out)

print("\nLSTM 결과 (모든 Step Output):", lstm_seq_out.shape)

print("LSTM Layer의 Weight 형태:", lstm_seq_layer.weights[0].shape)

lstm_fin_layer = tf.keras.layers.LSTM(units=64, use_bias=False)

lstm_fin_out = lstm_fin_layer(emb_out)

print("\nLSTM 결과 (최종 Step Output):", lstm_fin_out.shape)

print("LSTM Layer의 Weight 형태:", lstm_fin_layer.weights[0].shape)

양방향(Bidirectional) RNN

진행 방향에 변화를 준 RNN입니다

- 문장 분석이나 생성보다는 주로 기계번역 같은 테스크에 유리합니다. 사람도 대화를 하면서 듣고 이해하는 것은 순차적으로 들으면서 충분히 예측을 동원해서 잘 해냅니다. 그러나 문장을 번역하려면 일단은 번역해야 할 문장 전체를 끝까지 분석한 후 번역을 시도하는 것이 훨씬 유리합니다.

import tensorflow as tf

sentence = "What time is it ?"

dic = {

"is": 0,

"it": 1,

"What": 2,

"time": 3,

"?": 4

}

sentence_tensor = tf.constant([[dic[word] for word in sentence.split()]])

embedding_layer = tf.keras.layers.Embedding(input_dim=len(dic), output_dim=100)

emb_out = embedding_layer(sentence_tensor)

print("입력 문장 데이터 형태:", emb_out.shape)

bi_rnn = \

tf.keras.layers.Bidirectional(

tf.keras.layers.SimpleRNN(units=64, use_bias=False, return_sequences=True)

)

bi_out = bi_rnn(emb_out)

print("Bidirectional RNN 결과 (최종 Step Output):", bi_out.shape)입력 문장 데이터 형태: (1, 5, 100)

Bidirectional RNN 결과 (최종 Step Output): (1, 5, 128)