강의복습 내용

7. Sequential models: RNN

8. Sequential models: Transformer

사전 지식: Attention Mechanism

기존 Seq2seq 모델의 문제점

1. 하나의 고정된 벡터에 모든 정보를 압축해서 정보 손실이 발생

2. Vanishing Gradient가 발생한다.

-> 입력 문장이 길면 기계 번역 품질이 떨어진다. 그 대안으로 나온 것이 Attention 기법

- Attention 아이디어

디코더에서 출력 단어를 예측하는 매 시점마다 인코더에서의 전체 문장을 다시 한번 참고함. 전체 입력 문장을 동일한 비율로 참고하는 것이 아닌 해당시점에서 예측해야할 단어와 연관이 있는 입력 단어 부분을 집중해서 참고한다.

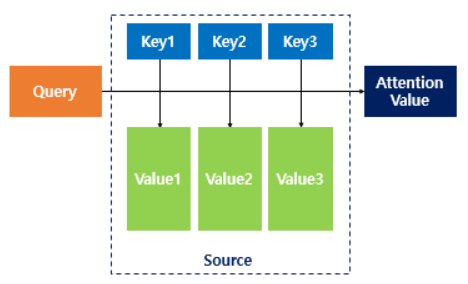

Attention(Q,K,V) = Attention Value

Attention function은 주어진 Query에 대해서 모든 Key와의 유사도를 구한다. 여기서 구한 유사도를 키와 mapping되어 있는 Value값에 반영한다. 그리고 유사도가 반영된 Value들을 합쳐셔 Attention Value라고 한다.

과제 수행내용/ 결과물 정리

LSTM Assignment

Multi-headed Attention Assignment

피어세션 정리

8월 12일 목요일 피어세션 정리

준수

농기구, 농약 object detection + OCR로 물체 인식 후 물체 위치 정보와 상품 이름 음성으로 출력

음성은 직접 녹음해서 출력, Jetson Xavier를 사용해서 메모리 사용이 널널했다.

1달 전 3명이서 프로젝트 실시, 프로젝트 내년까지 진행 예정, 경량화 작업으로 석사생 논문 작성 예정 test를 1~2시 비닐 하우스에서 진행해서 어려움을 겪었다. test 과정에서 높은 정확도를 보였음

요한

야외 주차장 차량 트래킹, 주차 공간 확인

2019년 말~2020년 초 진행 프로젝트

yolov3 tiny model 활용, annotation

학교 CCTV 영상을 frame 별로 잘라서 data 입력

소논문 작성

창한

도서관 재고 정리 시스템이 CV로 구축하는 것이 기술적으로 어려운가?

대웅 - 변화 감지 시스템을 써보는 건 어떤지 (한진 - 변화가 많은 도서관 환경에는 사용이 어려울 것 같음)

호영 - QR 코드를 사용, OCR 사용해서 재고 확인

요한 - RFID 칩을 통해서 위치 확인

진행하려던 프로젝트를 서울대생이 논문을 먼저 내서 아쉬웠다

프로젝트 진행과 개인정보 문제에 대하여

한준

백준 나이트의 이동 문제 유의사항

"try, exception 코드 왜 작성하노? 에러 안 나게 코드 짜면 되지"

학습 회고

Transformer를 이해하기 위해서는 Attention에 대한 이해가 필요해서 따로 더 공부해야했다. 음성 인식에서 많이 쓰이는 Transformer이기에 이번 기회에 기초를 탄탄히 닦아야겠다.