Hypothesis와 Cost

이해를 돕기 위해 b를 없앤 가설 H(x) = Hx에서 cost를 최소화 해보자!

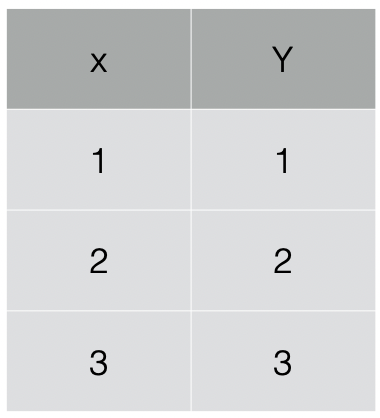

그림의 데이터셋을 가졌을때

W=1 일때,

cost(W) = 1/3*((1*1-1)^2 + (1*2-2)^2 + (1*3-3)^2) = 0

W=0 일때,

cost(W) = 1/3*((0*1-1)^2 + (0*2-2)^2 + (0*3-3)^2) = 4.67

W=2 일때,

cost(W) = 1/3*((2*1-1)^2 + (2*2-2)^2 + (2*3-3)^2) = 4.67

W=1, cost(W)=0

W=0, cost(W)=4.67

W=2, cost(W)=4.67

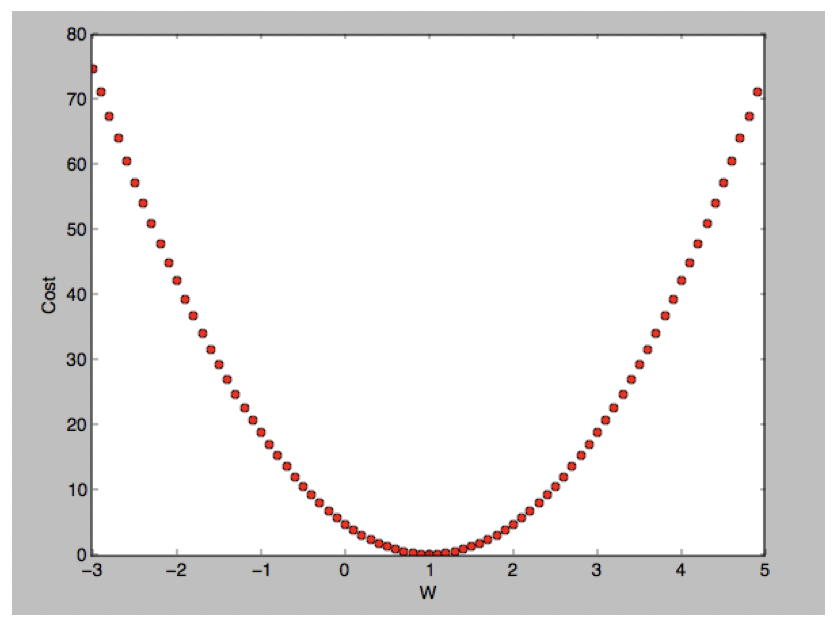

cost(W) 그래프를 그려보면 아래 그래프가나온다

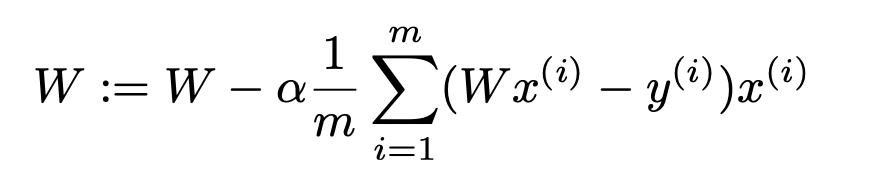

Gradient descent algorithm

cost가 가장 낮은 W값(상기 그래프에서는 0)을 찾는 알고리즘!

작동원리

cost(W)를 따라 경사도가 0인 지점을 계속해서 찾아가다보면 항상 cost가 가장 작은 곳에 도달하게 된다

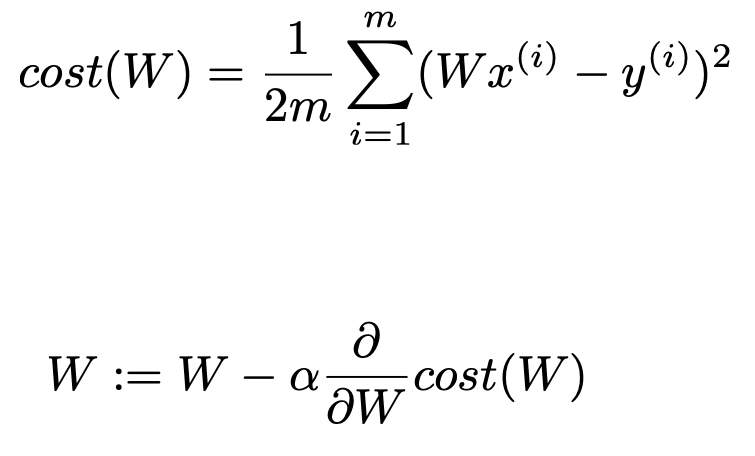

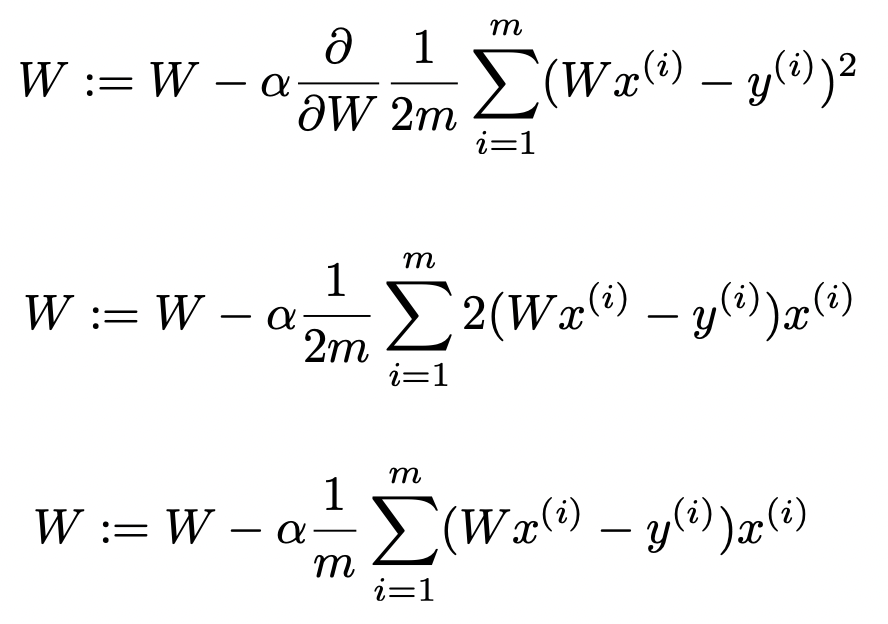

경사도 구하기

cost(W)식을 임의로 수정한 뒤(결과에 영향이 없음)

leaning rate α를 0.1로 두고 cost(W)를 미분한 값을 곱한다

미분절차

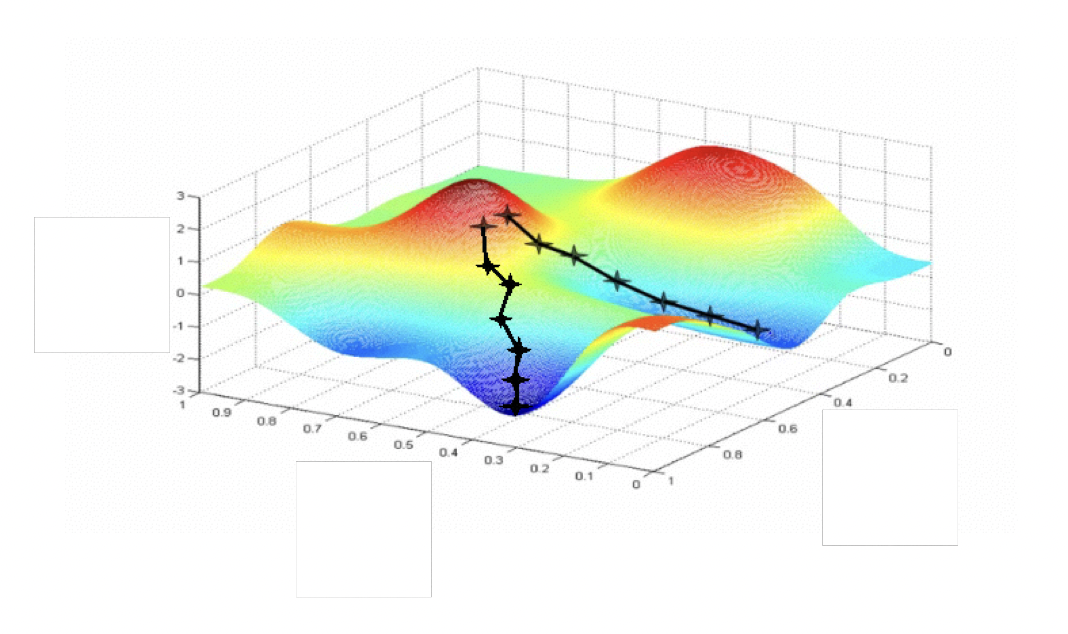

Gradient descent 최종식

이 수식을 기계적으로 적용하면 cost funtion을 최소화 하는 W를 구할 수 있고 이를 사용하여 linear regression 모델을 만들 수 있다

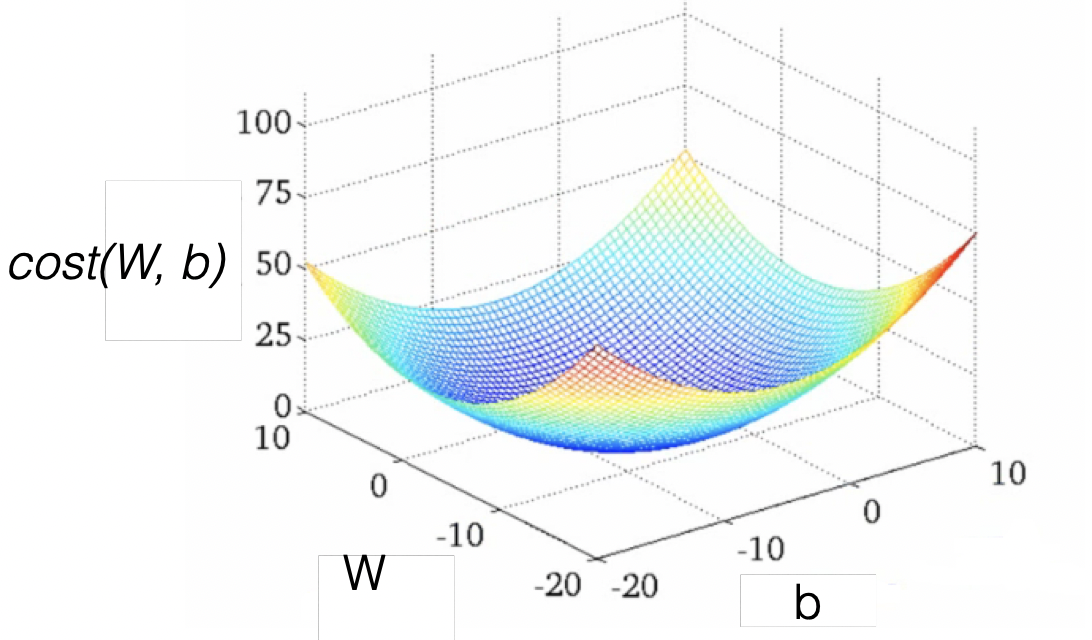

Convec funtion

cost funtion의 모양이 울퉁불퉁하다면 (W,b)값에 따라 최저의 cost를 구할 수 없는 경우가 생긴다

어떤 (W,b)에서 시작하더라도 결국 최저의 cost를 찾을 수 있도록 convec funtion이 그릇 모양을 가지는지 꼭 확인하자!