Prologue

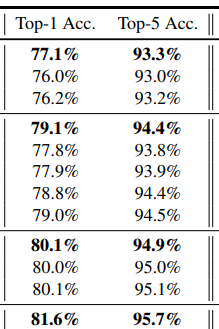

평가지표에 대한 이야기를 좀 정리해두려고 한다. 논문을 읽다보면 Top-1 Accuracy, Top-5 Accuracy를 볼 수 있다.

여느 때처럼 읽을 건 많아서 느낌만 챙겨가고 옆으로 슬쩍 밀어놨었다.

CIFAR-10 dataset

CIFAR-10을 분류하는 모델을 개발했을 때 비행기 사진에 대해서 아래와 같은 결과를 내놓았다고 해보자.

airplane: 0.2

automobile: 0.01

bird: 0.01

cat: 0.01

deer: 0.02

dog: 0.6

frog: 0.03

horse: 0.01

ship: 0.01

truck: 0.1Top-1 Accuracy

가장 높은 확률을(top-1) 기준으로 정답/오답을 매기는 지표. 이 때 모델은 개를 정답으로 내놨으므로 Top-1 Accuracy를 기준으로 하는 지표는 오답이다.

Top-5 Accuracy

상위 5개 확률을(top-5) 기준으로 정답/오답을 매기는 지표. 이 때 상위 5개 확률 중 비행기가 들어있어서 Top-5 Accuracy를 기준으로 하는 지표는 정답이다.

Epilogue

그동안 Top-1 Accuracy가 낮아서 뭔가 기준이 더 빡빡한 지표인 것 같다고 막연하게 생각하고 있었다. 지금 다시 생각해보면 Top-1 Accuracy, Top-5 Accuracy라는 말처럼 직관적인 지표가 없는 것 같다.