Abstract, Introduction

본 저자는 사람간의 대화 중에서 misunderstanding이 발생하는 이유가 서로 다른 주관을 가지고 있기 때문이며 이는 언어 모델과 사람의 대화에도 똑같은 misunderstanding이 발생할 수 있다고 한다. 이런 문제를 해결하기 위해 언어 모델의 말로 rephrase and respond(RaR) 이라는 방식을 제안한다. 본 방식은 언어모델에게 원래 question(query)를 재해석한 프롬프트를 바탕으로 답변을 생성하게 하는 방식이며 이 방식은 CoT와도 결합 가능하다고 주장한다.

Method

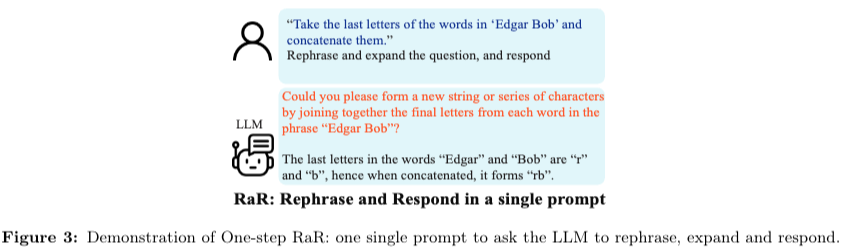

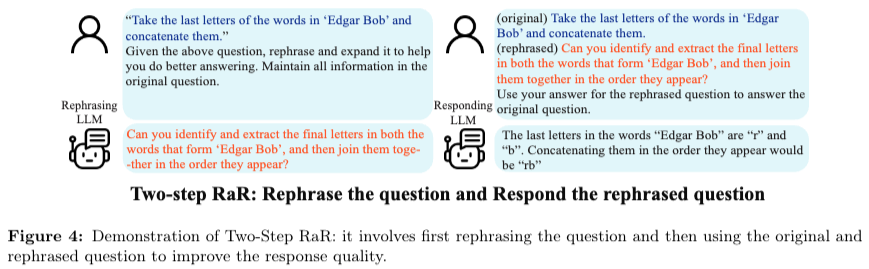

아래 figure 3 은 one-step, figure 4 는 two-step RaR 방식으로 rephrase와 동시에 답변을 생성하도록 지시하는 방식과, rephrase 한 응답을 추가해서 LLM 에게 다시 주는 방식을 제안한다.

Experiment

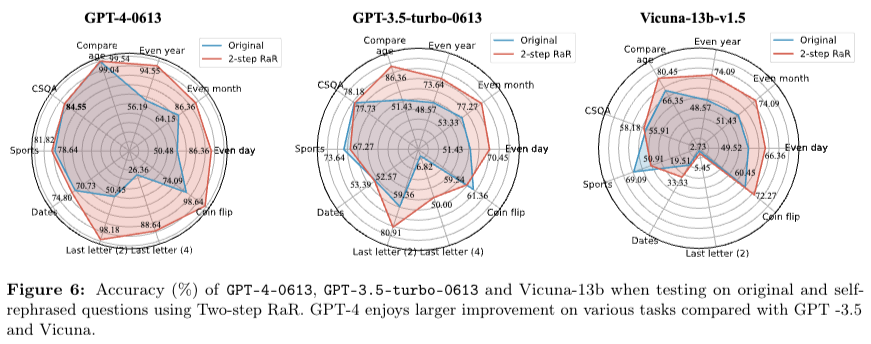

본 연구의 한계점은 CSQA, Compare age, Sports tasks에서 나타나는데 original 이 더 좋은 경우도 존재하며, 상대적으로 큰 차이가 존재하지 않는다는 점이 있다. 이에대해 저자들은 question의 품질이 충분히 좋기 때문에 쓸모없는 방법이 될 수 있다고 생각한다. 반면 Even year, Even month 등 query를 LLM이 specific 하게 스스로 재해석 해서 생성할 때는 큰 성능 향상을 보인다.

CoT와 결합했을 때 결과는 아래 표와 같으며, 결합했을 때가 기존보다 높은 성능을 보인다. 본 저자는 CoT에 도움이 도리 수 있는 방식이라고 설명한다.